参数优化方案

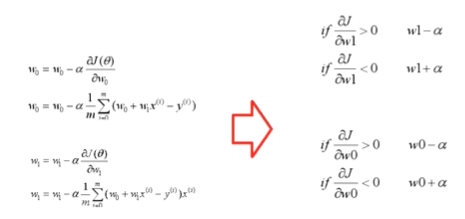

w参数的调整方向和幅度?

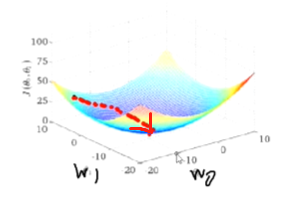

梯度下降法指导w的调参

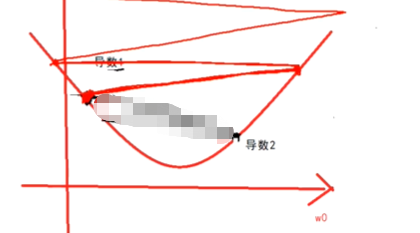

比如图中,w1往小调整,w0往大调整,才能使得误差函数向极小值方向走

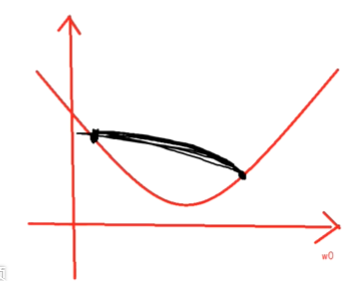

上图可以拆解为两个图,一个是w0与J的图,一个是w1与J的图。以w0与J的图举例说明

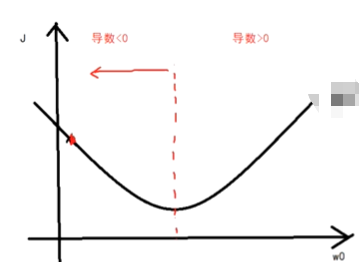

由于误差函数是凹函数,如下图,

在极小值左侧,导数小于0;

在极小值右侧,导数大于0

如果导数小于0,w点应该往大调整;

如果导数大于0,w点应该往小调整

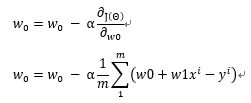

w0调整的公式为:

阿尔法是学习率

导数的正负决定了w参数的调整方向

阿尔法决定了w调整的步长

阿尔法是调参工程师需要调整的

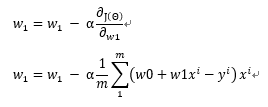

w1 调整的公式为

为什么叫梯度下降法?

梯度总是指向函数变大的方向,而w参数调整的方向是与梯度的方向相反的,所以叫梯度下降法

几个问题来更深入的理解

1、可否等价于这样?

假设阿尔法等于10 ,刚开始w偏大,往小调。调完又偏小,又往大调到原来位置,来回震荡,直到大于迭代次数终止,但是这样调整,不能满足需要调整到误差最小的位置

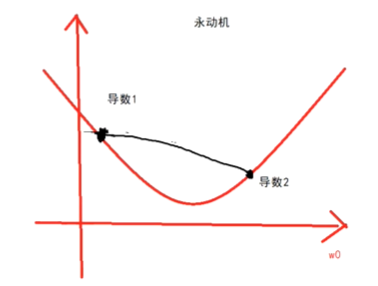

为什么调整 阿尔法乘以导数呢

导数1 的绝对值 大于 导数2 的绝对值

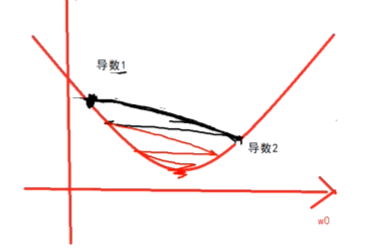

2、如果阿尔法调的很大好不好?

不好,盘旋上升

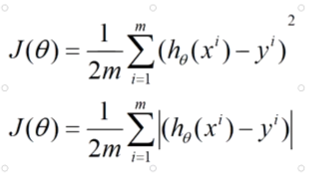

3、误差函数能不能不平方而取绝对值?

1点45分