模式识别课分为“分类”和“回归”

分类:输出量是离散的类别表达

回归:输出量是连续的信号表达(回归值)

回归是分类的基础:离散的类别值是由回归值做判断决策的得到的

模式识别:根据已有得知识表达,针对待识别模式,决策其所属的类别或预测其对应的回归值

数学解释:模式识别可以看做一种函数映射,将待识别模式从输入空间映射到输出空间,函数是关于已有知识的表达。

特征提取,从原始输入数据提取更有效的信息。

回归器:将特征映射到回归值。

模型(广义):特征提取+回归器+判别函数

模型(狭义):特征提取+回归器

分类器:回归器+判别函数

鲁棒性:针对不同的观测条件,仍能够有效的表达类别之间的差异。

特征向量:多个特征构成的(列)向量

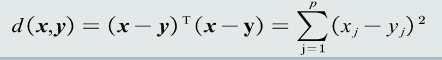

特征向量的欧式距离:表征两个向量之间的相似程度

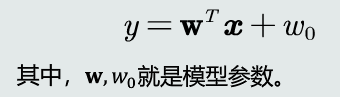

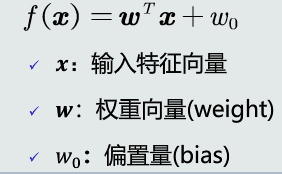

线性模型:

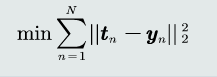

Over-determined:训练样本个数>>模型参数个数,额外添加一个标准,通过优化该标准俩确定一个近似解,该标准称作目标还是或者代价函数又或者损失函数。

目标函数以待学习的模型参数作为自变量,以训练样本作为给定量

监督式学习:训练样本及输出真值都给定情况下的机器学习算法

通常用最小化训练误差作为目标函数进行优化

无监督式学习:只给定训练样本,没有给定输出真值情况下的机器学习算法。

根据样本间的相似程度来进行决策

典型应用:聚类,图像分割

半监督式学习:既有标注的样本,也有未标注的样本

典型应用:网络流数据

强化学习:机器自行探索决策、真值滞后反馈的过程

定义从输入状态到动作决策为一个策略

使用该策略进行决策时,给予每次决策一个奖励

累积多次奖励获得回报值

回报的期望值作为该策略的价值函数

通过最大值回报的期望值,解出该策略的参数

测试集和训练集是互斥的,但假设同分布

测试误差,模型在测试集上的误差,反映了模型的泛化能力,,也称泛化误差

泛化能力:训练得到得模型不仅要对训练样本具有决策能力,也要对新的模式具有决策能力

过拟合:模型过于拟合训练数据

提高泛化能力:选择复杂度适合的模型;正则化,在目标函数中加入正则项

多项式拟合:

超参数M多项式的阶数,决定了模型的复杂度

超参数N训练样本的个数

超参数调节:从训练集中划分出一个验证集,基于验证集调节超参数

留出法:

1、 随机划分:将数据集分为两组:训练集和测试集。利用训练集训练模型,然后利用测试集评估模型的量化指标。

2、 取统计值:为了可分单次随机划分代理的偏差,将上述随机划分进行若干次,取量化指标的平均值(以及方差、最大值等)最为最终的性能量化评估结果。

K折交叉验证:

将数据集分割成k个子集,从中选取当个子集作为测试集,其余的作为训练集。

交叉验证重复k次,使得每个子集都被测试一次,将k次的评估值取平均,作为最终的量化评估结果。

留一验证:

每次只取一个样本作为测试集,其余作为训练集。

等同于k为样本个数的k折交叉验证

真阳性TP:真值为正,预测为正

假阳性FP:真值为负,预测为正

真阴性TN:真值为负,预测为负

假阴性FN:真值为正,预测为负

准确度:(TP+TN)/(TP+FP+TN+FN) 阳性和阴性样本比例失衡难度量性能

精度precision:TP/(TP+FP)

召回率recall:TP/(TP+FN)

F-Score: F=[(a^2+1)pr]/(a^2pr)

混淆矩阵:列代表预测值,行代表真值。对角线元素值越大代表模型性能越好。

PR曲线:横轴:召回率;纵轴:精度 曲线越右上凸,性能越好

ROC曲线:横轴FPR=FP/(FP+TN);纵轴召回率

曲线下方面积AUC,AUC=1完美分类器,AUC=0.5随机猜测

MED分类器:

最近邻:取与测试样本最近的一个训练样本作为测试的原型。

缺点:对类的表达误差较大,对噪声和异常样本比较敏感

距离度量的标准:同一性,非负性,对称性,三角不等式

常用的几种距离度量

MED分类器:最小欧式距离分类器,距离度量:欧式距离,类原型:均值

没有考虑特征变化的不同及特征之间的相关性

协方差矩阵:对角元素不相等:每维特征的变化不同;非对角元素不为0:特征之间存在相关性

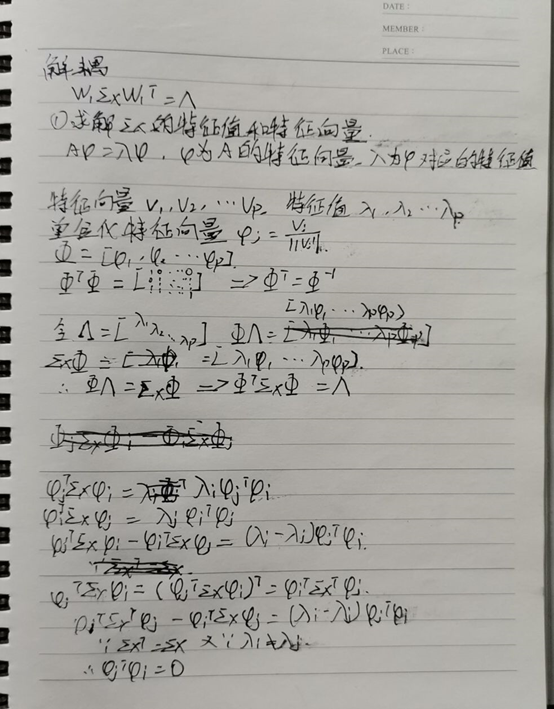

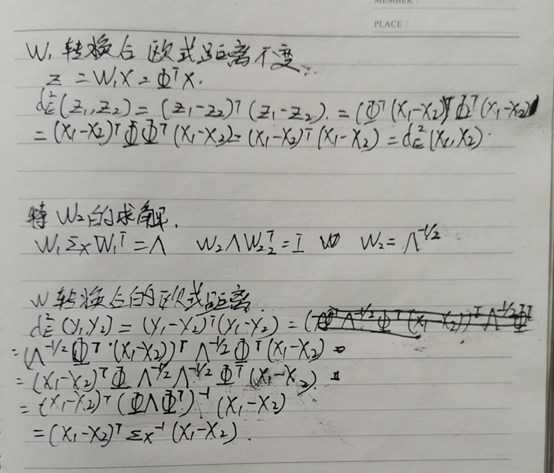

特征白化:将原始特征映射到一个新的特征空间,使得在新空间中特征的协方差矩阵为单位矩阵,从而去除特征变化的不同及特征之间的相关性

解耦:实现协方差矩阵对角化,去除特征的相关性

白化:进行尺度变化,实现所有特征具有相同方差

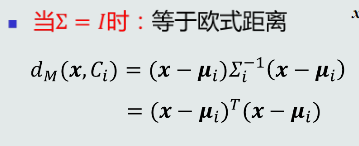

马氏距离:距离度量:马氏距离;类原型:均值

缺点:均值一样时会选择方差较大的类

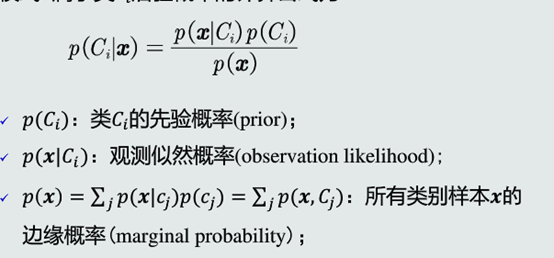

贝叶斯分类:

后验概率:

MAP分类器:将测试样本决策分类给后验概率大的那个类

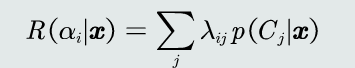

损失:错误决策所对应的惩罚量,可以手动设定也可以训练得到

贝叶斯分类器:在MAP的基础上,加上决策风险因素

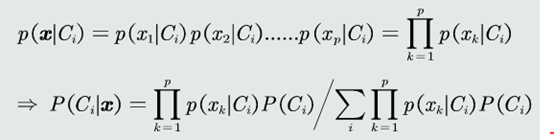

朴素贝叶斯分类器:假设特征之间相互独立

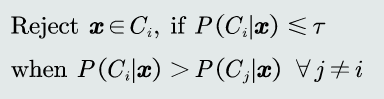

拒绝选项:当后验概率小于阈值时,分类器可以拒绝

阈值等于1,所有样本都拒绝,阈值小于1/k,所有样本都不会被拒绝

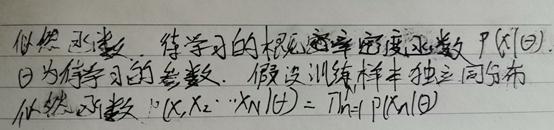

似然函数:

先验概率的似然函数:

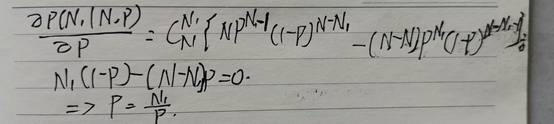

先验概率的最大似然估计即该类训练样本出现的概率

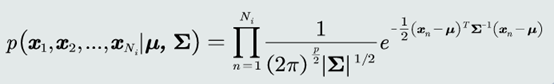

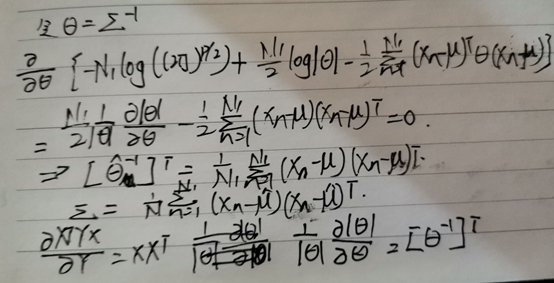

观测似然概率的似然函数(高斯分布的情况):

高斯分布均值的最大似然估计即样本的均值

高斯分布协方差的最大似然估计等于所有训练模式的协方差

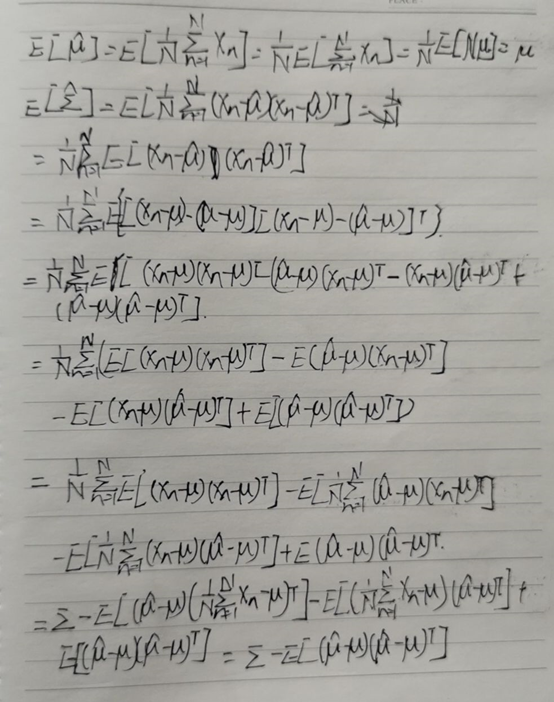

均值最大似然估计是无偏估计,协方差的最大似然估计是有偏估计

协方差的修正:

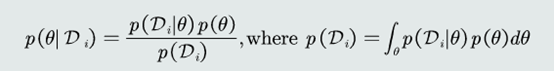

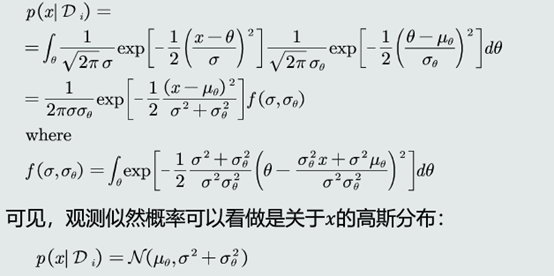

贝叶斯估计:给定参数分布的先验概率及样本,估计参数分布的后验概率

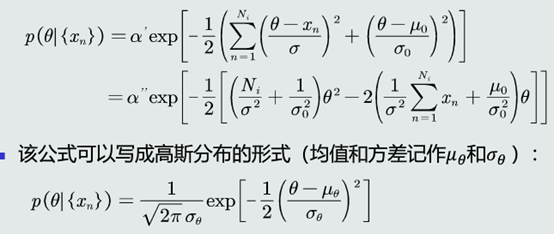

参数的后验概率:

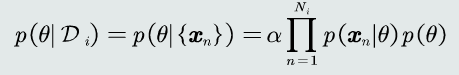

高斯观测似然:

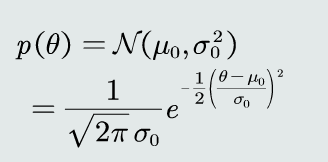

先验概率:

后验概率

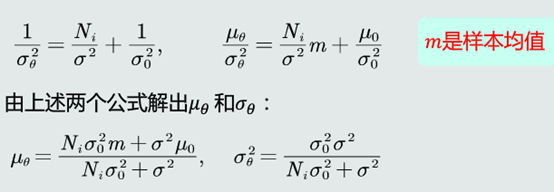

参数的后验概率是高斯分布

样本数足够大时,样本均值就是参数的无偏估计

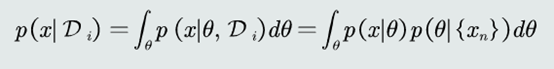

贝叶斯估计:把参数看作是参数空间的一个概率分布,依赖训练样本来估计参数的后验概率,从而得到观测似然关于参数的边缘概率。

最大似然估计:把参数看做是确定值

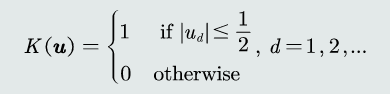

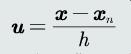

KNN估计:

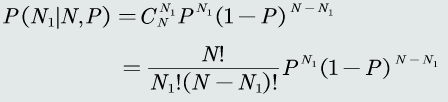

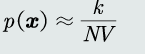

K个样本落在区域R内的概率密度可用二项分布表达:

当N很大时,二项分布的均值约等于k

所以

K邻近:给定x找到其对应的区域,使得包含k个训练样本

优点:可以自适应确定x相关的区域R的范围

缺点:不是连续函数;不是真正的概率表达,概率密度函数的积分不为1;易受噪音影响

;推理测试阶段仍需存储所有样本

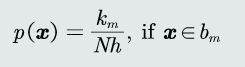

直方图估计:

区域R的确定:直接将特征空间分为m个格子,每个格子即为一个区域R,即区域的位置固定;平均分格子大小,所以每个格子体积V=h,即区域的大小固定;相邻格子不重叠;落到格子里的训练样本个数不定。

概率密度估计:先判断落到哪个格子,概率密度即为该格子的统计值

优点:固定区域,减少噪声影响;不需要存储训练样本

缺点:固定区域R的位置,若x落在两格子交界区域,意味着当前格子不是以x为中心,导致估计不准确;固定区域R的大小,缺乏自适应能力

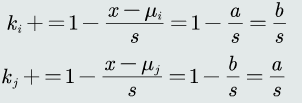

双线性插值:针对自适应不强的问题

a,b代表x到两均值的距离

带宽h过小,概率密度函数过于尖锐,反之,过于平滑

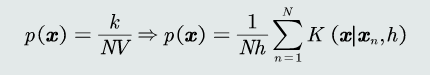

核密度估计:

区域R的确定:以x为中心,固定带宽h

核函数需满足以下条件:

核函数必须是对称的函数

优点:自适应确定R的位置;使用所有训练样本,克服噪声影响;若核函数连续,概率密度函数也连续

缺点:需要存储所有训练样本

生成模型:给定训练样本,直接在输入空间内学习其概率密度函数

优势:可以根据概率密度函数采样新的样本;可以检测出较低概率的数据,实现离群点检测

劣势:高维的x需要大量训练样本

判别模型:给定训练样本,直接在输入空间内估计后验概率

优势:快速直接,省去了耗时的高维观测似然概率估计

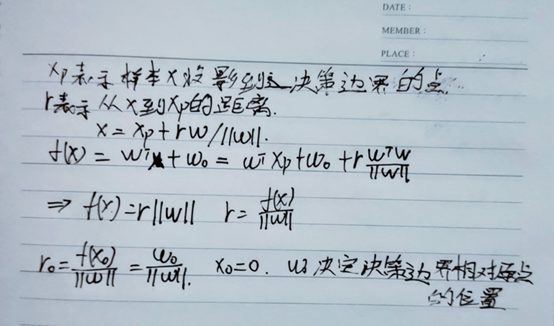

线性判据:

w决定决策边界的方向

w0决定决策边界的偏移量,是两类输出值分别为正负

训练样本远远大于参数个数,所以解不唯一

解域:在参数空间内,参数的所有可能解所处的范围

目标函数:

加入约束条件,提高泛化能力

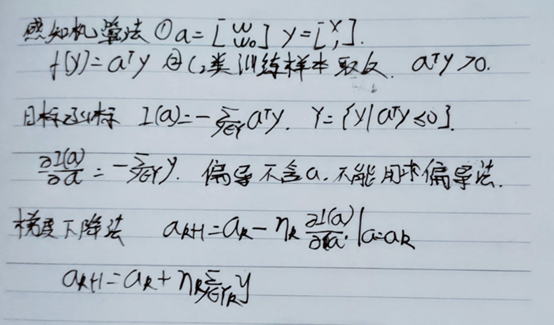

并行感知机:

串行感知机:

如果样本线性可分,感知机算法收敛于一个解

步长决定收敛速度及是否收敛到全局最优

提高泛化能力:加入margin约束条件

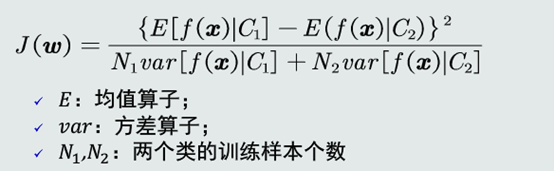

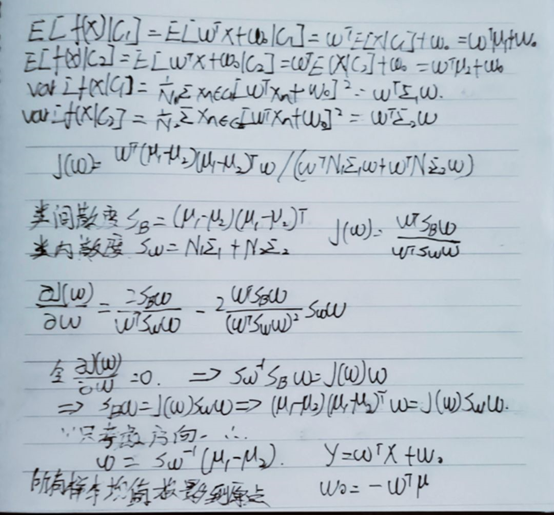

Fisher线性判据:

线性判据模型可以看作将原空间上的点x投影到新的空间y

不同样本类别差异尽量大,类内样本分布离散程度尽量小

类间样本差异程度:用两类样本分布的均值之差度量

类内样本离散程度:用每类样本分布的协方差矩表征

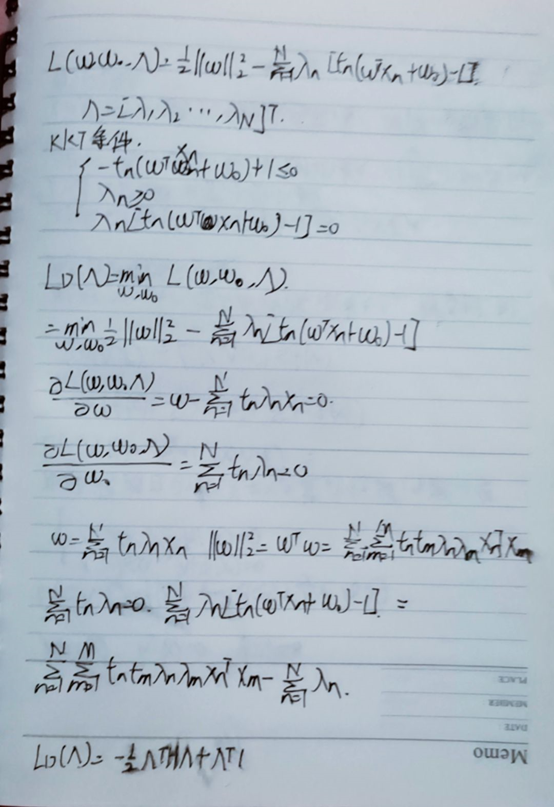

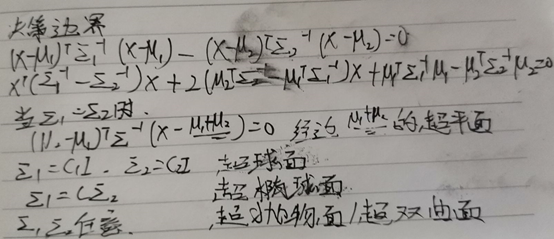

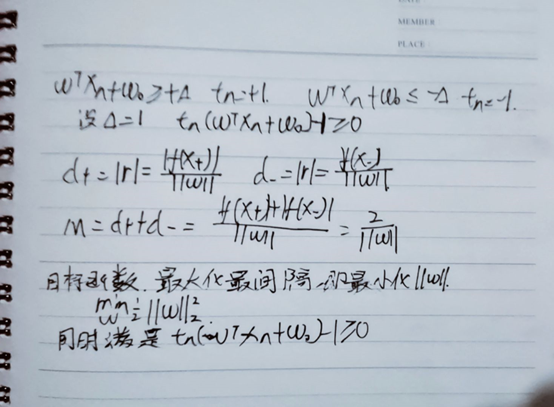

支持向量机:

间隔:两个类的训练样本中找到距离决策边界最近的训练样本,记作x+和x-

x+和x-到决策边界的垂直距离叫做间隔,记为d+和d-

平行决策边界且经过x+和x-的两个超平面称为间隔边界

位于间隔边界的两个样本称为支持向量

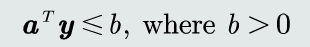

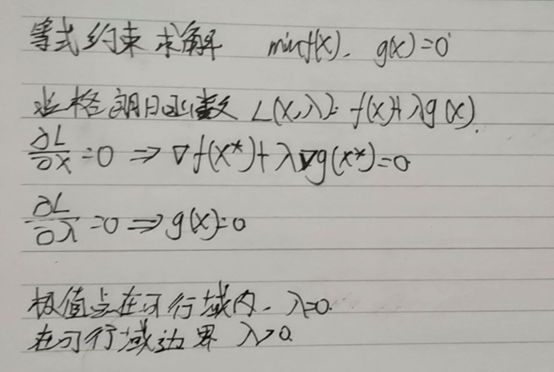

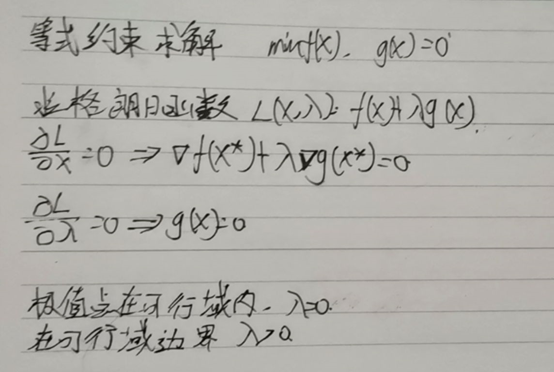

对偶问题:

支持向量机算法: