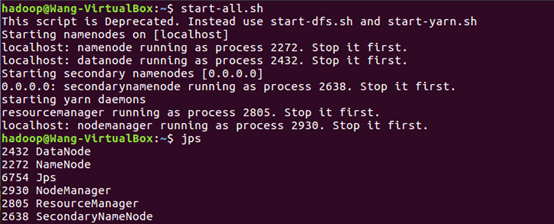

一:先将服务都启动

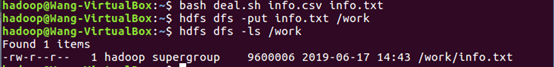

二:将爬虫大作业获取的数据上传到HDFS中

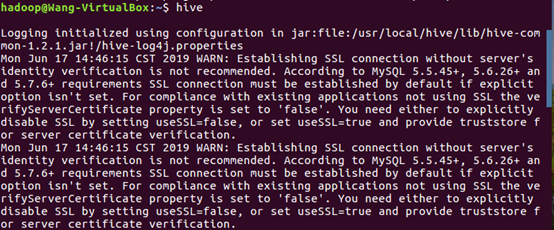

三.把hdfs中的文本文件最终导入到数据仓库Hive中

启动hive

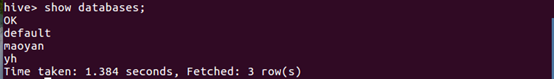

创建数据仓库maoyan

查看是否建立成功

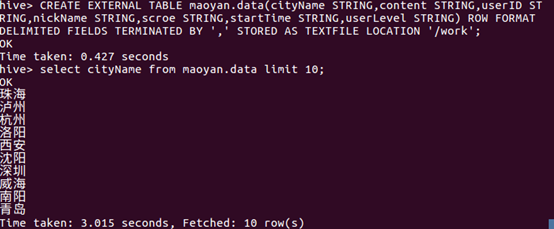

用上传到HDFS中的数据,在数据库中建表,并且查看时否建立成功

四:在Hive中查看并分析数据

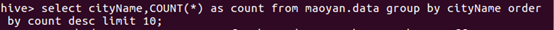

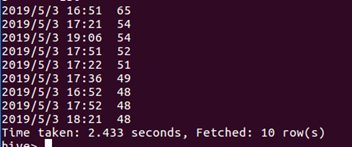

统计出观众所在城市数量最多的10个城市

北上广深等一线城市,观众粉丝多,消费水平可以。观影数量非常多。

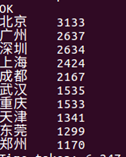

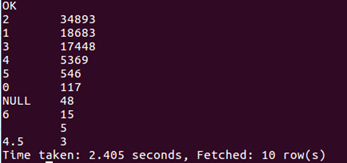

统计出观众评分的情况,大部分为5分,

可以看到评分满分的用户几乎超过总人数的70%,可见观众看完电影之后很满足,也说明了电影的可看性很高

24号上映到现在已经三天,其中观影人数最多的是25号,可能大家觉得首映有点小贵吧,哈哈。

可见用户等级为0,5,6的用户基本没有,而且随着等级的提升,人数急剧变少。

新用户可能是以年轻人为主,对科幻电影感兴趣,因而评论数量较多,而老用户主要偏向于现实剧情类的电影,评论数量较少

五:出现的问题解决:

在HIVE中进行查询时,一开始会出现“无法分配内存”的情况,后来把虚拟机的内存调为4G就解决了。