视图

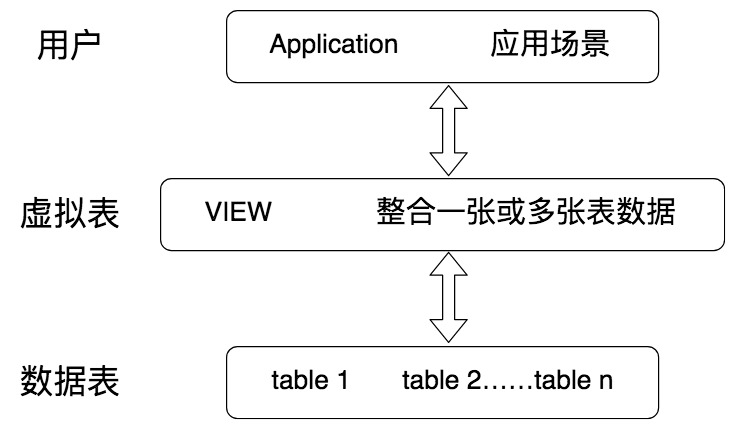

视图,也就是我们今天要讲的虚拟表,本身是不具有数据的,它是 SQL 中的一个重要概念。

从下面这张图中,你能看到,虚拟表的创建连接了一个或多个数据表,不同的查询应用都可以建立在虚拟表之上。

视图一方面可以帮我们使用表的一部分而不是所有的表,

另一方面也可以针对不同的用户制定不同的查询视图。

比如,针对一个公司的销售人员,我们只想给他看部分数据,而某些特殊的数据,比如采购的价格,则不会提供给他。

刚才讲的只是视图的一个使用场景,实际上视图还有很多作用。

如何创建,更新和删除视图

视图作为一张虚拟表,帮我们封装了底层与数据表的接口。它相当于是一张表或多张表的数据结果集。视图的这一特点,可以帮我们简化复杂的 SQL 查询,

比如在编写视图后,我们就可以直接重用它,而不需要考虑视图中包含的基础查询的细节。同样,我们也可以根据需要更改数据格式,返回与底层数据表格式不同的数据。

通常情况下,小型项目的数据库可以不使用视图,但是在大型项目中,以及数据表比较复杂的情况下,视图的价值就凸显出来了,它可以帮助我们把经常查询的结果集放到虚拟表中,提升使用效率。理解和使用起来都非常方便。

创建视图:CREATE VIEW

那么该如何创建视图呢?创建视图的语法是:

CREATE VIEW view_name AS

SELECT column1, column2

FROM table

WHERE condition

实际上就是我们在 SQL 查询语句的基础上封装了视图 VIEW,这样就会基于 SQL 语句的结果集形成一张虚拟表。其中 view_name 为视图名称,column1、column2 代表列名,condition 代表查询过滤条件。

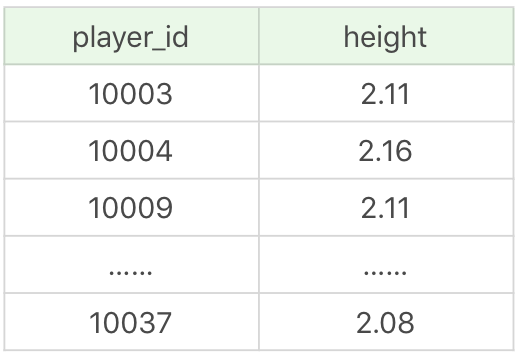

我们以 NBA 球员数据表为例。我们想要查询比 NBA 球员平均身高高的球员都有哪些,显示他们的球员 ID 和身高。假设我们给这个视图起个名字 player_above_avg_height,那么创建视图可以写成:

CREATE VIEW player_above_avg_height AS

SELECT player_id, height

FROM player

WHERE height > (SELECT AVG(height) from player)

视图查询结果(18 条记录):

当视图创建之后,它就相当于一个虚拟表,可以直接使用:

SELECT * FROM player_above_avg_height

运行结果和上面一样。

嵌套视图

当我们创建好一张视图之后,还可以在它的基础上继续创建视图,比如我们想在虚拟表 player_above_avg_height 的基础上,找到比这个表中的球员平均身高高的球员,作为新的视图 player_above_above_avg_height,那么可以写成:

CREATE VIEW player_above_above_avg_height AS

SELECT player_id, height

FROM player

WHERE height > (SELECT AVG(height) from player_above_avg_height)

视图查询结果(11 条记录):

你能看到这个视图的数据记录数为 11 个,比之前的记录少了 7 个。

修改视图:ALTER VIEW

修改视图的语法是:

ALTER VIEW view_name AS

SELECT column1, column2

FROM table

WHERE condition

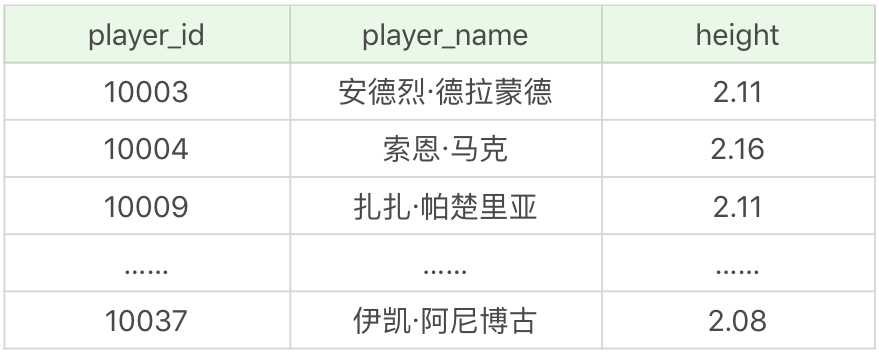

你能看出来它的语法和创建视图一样,只是对原有视图的更新。比如我们想更新视图 player_above_avg_height,增加一个 player_name 字段,可以写成:

ALTER VIEW player_above_avg_height AS

SELECT player_id, player_name, height

FROM player

WHERE height > (SELECT AVG(height) from player)

这样的话,下次再对视图进行查询的时候,视图结果就进行了更新。

SELECT * FROM player_above_avg_height

运行结果(18 条记录):

删除视图:DROP VIEW

删除视图的语法是:

DROP VIEW view_name

比如我们想把刚才创建的视图删除,可以使用:

DROP VIEW player_above_avg_height

需要说明的是,SQLite 不支持视图的修改,仅支持只读视图,也就是说你只能使用 CREATE VIEW 和 DROP VIEW,如果想要修改视图,就需要先 DROP 然后再 CREATE。

如何使用视图简化 SQL 操作

从上面这个例子中,你能看出视图就是对 SELECT 语句进行了封装,方便我们重用它们。下面我们再来看几个视图使用的例子。

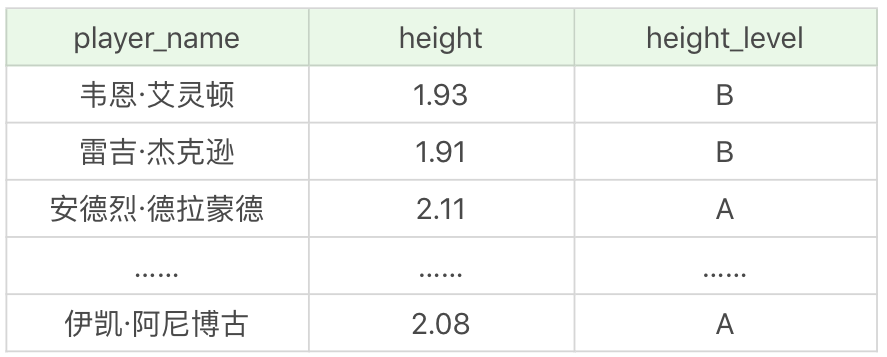

利用视图完成复杂的连接

我在讲解 SQL99 标准连接操作的时候,举了一个 NBA 球员和身高等级连接的例子,有两张表,分别为 player 和 height_grades。其中 height_grades 记录了不同身高对应的身高等级。这里我们可以通过创建视图,来完成球员以及对应身高等级的查询。

首先我们对 player 表和 height_grades 表进行连接,关联条件是球员的身高 height(在身高等级表规定的最低身高和最高身高之间),这样就可以得到这个球员对应的身高等级,对应的字段为 height_level。然后我们通过 SELECT 得到我们想要查询的字段,分别为球员姓名 player_name、球员身高 height,还有对应的身高等级 height_level。然后把取得的查询结果集放到视图 player_height_grades 中,即:

CREATE VIEW player_height_grades AS

SELECT p.player_name, p.height, h.height_level

FROM player as p JOIN height_grades as h

ON height BETWEEN h.height_lowest AND h.height_highest

运行结果(37 条记录):

以后我们进行查询的时候,可以直接通过视图查询,比如我想查询身高介于 1.90m 和 2.08m 之间的球员及他们对应的身高:

SELECT * FROM player_height_grades WHERE height >= 1.90 AND height <= 2.08

运行结果(26 条记录):

这样就把一个相对复杂的连接查询转化成了视图查询。

利用视图对数据进行格式化

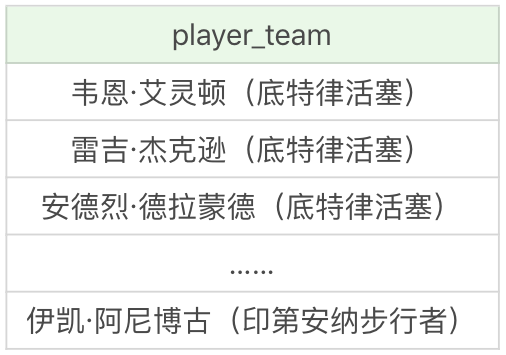

我们经常需要输出某个格式的内容,比如我们想输出球员姓名和对应的球队,对应格式为 player_name(team_name),就可以使用视图来完成数据格式化的操作:

CREATE VIEW player_team AS

SELECT CONCAT(player_name, '(' , team.team_name , ')') AS player_team FROM player JOIN team WHERE player.team_id = team.team_id

首先我们将 player 表和 team 表进行连接,关联条件是相同的 team_id。我们想要的格式是player_name(team_name),因此我们使用 CONCAT 函数,即CONCAT(player_name, '(' , team.team_name , ')'),将 player_name 字段和 team_name 字段进行拼接,得到了拼接值被命名为 player_team 的字段名,将它放到视图 player_team 中。

这样的话,我们直接查询视图,就可以得到格式化后的结果:

SELECT * FROM player_team

运行结果(37 条记录):

使用视图与计算字段

我们在数据查询中,有很多统计的需求可以通过视图来完成。正确地使用视图可以帮我们简化复杂的数据处理。

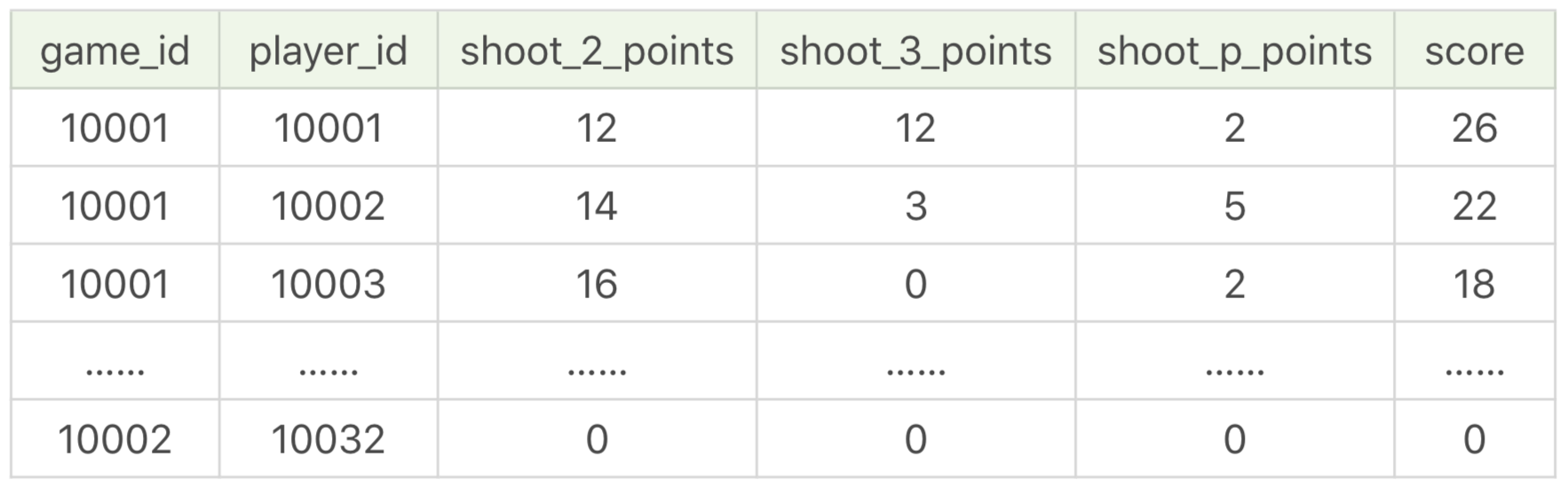

我以球员比赛成绩表为例,对应的是 player_score 表。这张表中一共有 19 个字段,它们代表的含义如下:

如果我想要统计每位球员在每场比赛中的二分球、三分球和罚球的得分,可以通过创建视图完成:

CREATE VIEW game_player_score AS

SELECT game_id, player_id, (shoot_hits-shoot_3_hits)*2 AS shoot_2_points, shoot_3_hits*3 AS shoot_3_points, shoot_p_hits AS shoot_p_points, score FROM player_score

然后通过查询视图就可以完成。

SELECT * FROM game_player_score

运行结果(19 条记录):

你能看出正确使用视图可以简化复杂的 SQL 查询,让 SQL 更加清爽易用。不过有一点需要注意,视图是虚拟表,它只是封装了底层的数据表查询接口,因此有些 RDBMS 不支持对视图创建索引(有些 RDBMS 则支持,比如新版本的 SQL Server)。

总结

讲解了视图的使用,包括创建,修改和删除视图。使用视图有很多好处,比如安全、简单清晰。

- 安全性:虚拟表是基于底层数据表的,我们在使用视图时,一般不会轻易通过视图对底层数据进行修改,即使是使用单表的视图,也会受到限制,比如计算字段,类型转换等是无法通过视图来对底层数据进行修改的,这也在一定程度上保证了数据表的数据安全性。同时,我们还可以针对不同用户开放不同的数据查询权限,比如人员薪酬是个敏感的字段,那么只给某个级别以上的人员开放,其他人的查询视图中则不提供这个字段。

- 简单清晰:视图是对 SQL 查询的封装,它可以将原本复杂的 SQL 查询简化,在编写好查询之后,我们就可以直接重用它而不必要知道基本的查询细节。同时我们还可以在视图之上再嵌套视图。这样就好比我们在进行模块化编程一样,不仅结构清晰,还提升了代码的复用率。

另外,我们也需要了解到视图是虚拟表,本身不存储数据,如果想要通过视图对底层数据表的数据进行修改也会受到很多限制,通常我们是把视图用于查询,也就是对 SQL 查询的一种封装。那么它和临时表又有什么区别呢?

在实际工作中,我们可能会见到各种临时数据。

比如你可能会问,如果在做一个电商的系统,中间会有个购物车的功能,需要临时统计购物车中的商品和金额,那该怎么办呢?

这里就需要用到临时表了,临时表是真实存在的数据表,不过它不用于长期存放数据,只为当前连接存在,关闭连接后,临时表就会自动释放。

存储过程

存储过程是 SQL 中另一个重要应用,和视图一样,都是对 SQL 代码进行封装,可以反复利用。它和视图有着同样的优点,清晰、安全,还可以减少网络传输量。

不过它和视图不同,视图是虚拟表,通常不对底层数据表直接操作,而存储过程是程序化的 SQL,可以直接操作底层数据表,相比于面向集合的操作方式,能够实现一些更复杂的数据处理。

存储过程可以说是由 SQL 语句和流控制语句构成的语句集合,它和我们之前学到的函数一样,可以接收输入参数,也可以返回输出参数给调用者,返回计算结果。

什么是存储过程,如何创建一个存储过程

存储过程的英文是 Stored Procedure。它的思想很简单,就是 SQL 语句的封装。一旦存储过程被创建出来,使用它就像使用函数一样简单,我们直接通过调用存储过程名即可。

我们先来看下如何定义一个存储过程:

CREATE PROCEDURE 存储过程名称 ([参数列表])

BEGIN

需要执行的语句

END

在这里,我们使用 CREATE PROCEDURE 创建一个存储过程,后面是存储过程的名称,以及过程所带的参数,可以包括输入参数和输出参数。最后由 BEGIN 和 END 来定义我们所要执行的语句块。

和视图一样,我们可以删除已经创建的存储过程,使用的是 DROP PROCEDURE。如果要更新存储过程,我们需要使用 ALTER PROCEDURE。

讲完了如何创建,更新和删除一个存储过程,下面我们来看下如何实现一个简单的存储过程。比如我想做一个累加运算,计算 1+2+…+n 等于多少,我们可以通过参数 n 来表示想要累加的个数,那么如何用存储过程实现这一目的呢?这里我做一个 add_num 的存储过程,具体的代码如下:

CREATE PROCEDURE `add_num`(IN n INT)

BEGIN

DECLARE i INT;

DECLARE sum INT;

SET i = 1;

SET sum = 0;

WHILE i <= n DO

SET sum = sum + i;

SET i = i +1;

END WHILE;

SELECT sum;

END

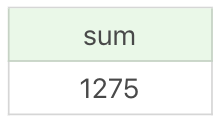

当我们需要再次使用这个存储过程的时候,直接使用 CALL add_num(50);即可。这里我传入的参数为 50,也就是统计 1+2+…+50 的积累之和,查询结果为:

这就是一个简单的存储过程,除了理解 1+2+…+n 的实现过程,还有两点你需要理解,一个是 DELIMITER 定义语句的结束符,另一个是存储过程的三种参数类型。

我们先来看下 DELIMITER 的作用。如果你使用 Navicat 这个工具来管理 MySQL 执行存储过程,那么直接执行上面这段代码就可以了。如果用的是 MySQL,你还需要用 DELIMITER 来临时定义新的结束符。因为默认情况下 SQL 采用(;)作为结束符,这样当存储过程中的每一句 SQL 结束之后,采用(;)作为结束符,就相当于告诉 SQL 可以执行这一句了。但是存储过程是一个整体,我们不希望 SQL 逐条执行,而是采用存储过程整段执行的方式,因此我们就需要临时定义新的 DELIMITER,新的结束符可以用(//)或者($$)。如果你用的是 MySQL,那么上面这段代码,应该写成下面这样:

DELIMITER //

CREATE PROCEDURE `add_num`(IN n INT)

BEGIN

DECLARE i INT;

DECLARE sum INT;

SET i = 1;

SET sum = 0;

WHILE i <= n DO

SET sum = sum + i;

SET i = i +1;

END WHILE;

SELECT sum;

END //

DELIMITER ;

首先我用(//)作为结束符,又在整个存储过程结束后采用了(//)作为结束符号,告诉 SQL 可以执行了,然后再将结束符还原成默认的(;)。

需要注意的是,如果你用的是 Navicat 工具,那么在编写存储过程的时候,Navicat 会自动设置 DELIMITER 为其他符号,我们不需要再进行 DELIMITER 的操作。

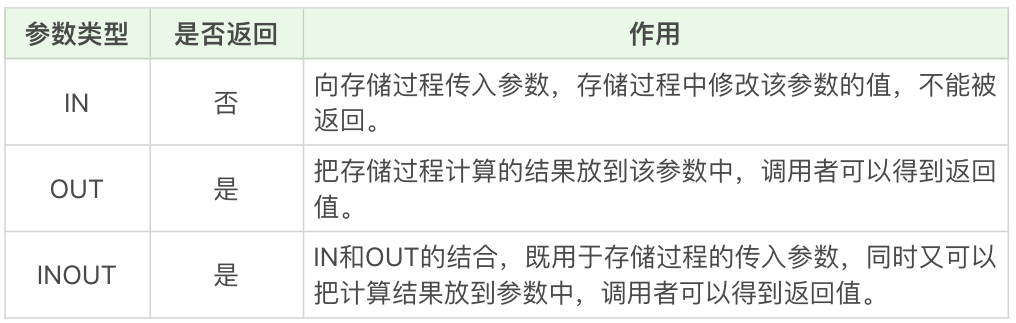

我们再来看下存储过程的 3 种参数类型。在刚才的存储过程中,我们使用了 IN 类型的参数,另外还有 OUT 类型和 INOUT 类型,作用如下:

IN 和 OUT 的结合,既用于存储过程的传入参数,同时又可以把计算结果放到参数中,调用者可以得到返回值。

你能看到,IN 参数必须在调用存储过程时指定,而在存储过程中修改该参数的值不能被返回。而 OUT 参数和 INOUT 参数可以在存储过程中被改变,并可返回。

举个例子,这里会用到我们之前讲过的王者荣耀的英雄数据表 heros。假设我想创建一个存储类型 get_hero_scores,用来查询某一类型英雄中的最大的最大生命值,最小的最大魔法值,以及平均最大攻击值,那么该怎么写呢?

CREATE PROCEDURE `get_hero_scores`(

OUT max_max_hp FLOAT,

OUT min_max_mp FLOAT,

OUT avg_max_attack FLOAT,

s VARCHAR(255)

)

BEGIN

SELECT MAX(hp_max), MIN(mp_max), AVG(attack_max) FROM heros WHERE role_main = s INTO max_max_hp, min_max_mp, avg_max_attack;

END

你能看到我定义了 4 个参数类型,其中 3 个为 OUT 类型,分别为 max_max_hp、min_max_mp 和 avg_max_attack,另一个参数 s 为 IN 类型。

这里我们从 heros 数据表中筛选主要英雄定位为 s 的英雄数据,即筛选条件为 role_main=s,提取这些数据中的最大的最大生命值,最小的最大魔法值,以及平均最大攻击值,分别赋值给变量 max_max_hp、min_max_mp 和 avg_max_attack。

然后我们就可以调用存储过程,使用下面这段代码即可:

CALL get_hero_scores(@max_max_hp, @min_max_mp, @avg_max_attack, '战士');

SELECT @max_max_hp, @min_max_mp, @avg_max_attack;

运行结果:

流控制语句

流控制语句是用来做流程控制的,我刚才讲了两个简单的存储过程的例子,一个是 1+2+…+n 的结果计算,一个是王者荣耀的数据查询,你能看到这两个例子中,我用到了下面的流控制语句:

- BEGIN…END:BEGIN…END 中间包含了多个语句,每个语句都以(;)号为结束符。

- DECLARE:DECLARE 用来声明变量,使用的位置在于 BEGIN…END 语句中间,而且需要在其他语句使用之前进行变量的声明。

- SET:赋值语句,用于对变量进行赋值。

- SELECT…INTO:把从数据表中查询的结果存放到变量中,也就是为变量赋值。

除了上面这些用到的流控制语句以外,还有一些常用的流控制语句:

- IF…THEN…ENDIF:条件判断语句,我们还可以在 IF…THEN…ENDIF 中使用 ELSE 和 ELSEIF 来进行条件判断。

- CASE:CASE 语句用于多条件的分支判断,使用的语法是下面这样的。

CASE

WHEN expression1 THEN ...

WHEN expression2 THEN ...

...

ELSE

--ELSE 语句可以加,也可以不加。加的话代表的所有条件都不满足时采用的方式。

END

- LOOP、LEAVE 和 ITERATE:LOOP 是循环语句,使用 LEAVE 可以跳出循环,使用 ITERATE 则可以进入下一次循环。如果你有面向过程的编程语言的使用经验,你可以把 LEAVE 理解为 BREAK,把 ITERATE 理解为 CONTINUE。

- REPEAT…UNTIL…END REPEAT:这是一个循环语句,首先会执行一次循环,然后在 UNTIL 中进行表达式的判断,如果满足条件就退出,即 END REPEAT;如果条件不满足,则会就继续执行循环,直到满足退出条件为止。

- WHILE…DO…END WHILE:这也是循环语句,和 REPEAT 循环不同的是,这个语句需要先进行条件判断,如果满足条件就进行循环,如果不满足条件就退出循环。

我们之前说过 SQL 是声明型语言,使用 SQL 就像在使用英语,简单直接。今天讲的存储过程,尤其是在存储过程中使用到的流控制语句,属于过程性语言,类似于 C++ 语言中函数,这些语句可以帮我们解决复杂的业务逻辑。

关于存储过程使用的争议

尽管存储过程有诸多优点,但是对于存储过程的使用,一直都存在着很多争议,比如有些公司对于大型项目要求使用存储过程,而有些公司在手册中明确禁止使用存储过程,为什么这些公司对存储过程的使用需求差别这么大呢?

存储过程的好处。

-

存储过程可以一次编译多次使用。存储过程只在创造时进行编译,之后的使用都不需要重新编译,这就提升了 SQL 的执行效率。其次它可以减少开发工作量。将代码封装成模块,实际上是编程的核心思想之一,这样可以把复杂的问题拆解成不同的模块,然后模块之间可以重复使用,在减少开发工作量的同时,还能保证代码的结构清晰。

-

存储过程的安全性强,我们在设定存储过程的时候可以设置对用户的使用权限,这样就和视图一样具有较强的安全性。最后它可以减少网络传输量,因为代码封装到存储过程中,每次使用只需要调用存储过程即可,这样就减少了网络传输量。同时在进行相对复杂的数据库操作时,原本需要使用一条一条的 SQL 语句,可能要连接多次数据库才能完成的操作,现在变成了一次存储过程,只需要连接一次即可。

基于上面这些优点,不少大公司都要求大型项目使用存储过程,比如微软、IBM 等公司。但是国内的阿里并不推荐开发人员使用存储过程,这是为什么呢?

存储过程的缺点

它的可移植性差,存储过程不能跨数据库移植,比如在 MySQL、Oracle 和 SQL Server 里编写的存储过程,在换成其他数据库时都需要重新编写。

其次调试困难,只有少数 DBMS 支持存储过程的调试。对于复杂的存储过程来说,开发和维护都不容易。

此外,存储过程的版本管理也很困难,比如数据表索引发生变化了,可能会导致存储过程失效。我们在开发软件的时候往往需要进行版本管理,但是存储过程本身没有版本控制,版本迭代更新的时候很麻烦。

最后它不适合高并发的场景,高并发的场景需要减少数据库的压力,有时数据库会采用分库分表的方式,而且对可扩展性要求很高,在这种情况下,存储过程会变得难以维护,增加数据库的压力,显然就不适用了。

了解了存储过程的优缺点之后,我想说的是,存储过程既方便,又有局限性。尽管不同的公司对存储过程的态度不一,但是对于我们开发人员来说,不论怎样,掌握存储过程都是必备的技能之一。

事务处理

我们知道在 MySQL 5.5 版本之前,默认的存储引擎是 MyISAM,在 5.5 版本之后默认存储引擎是 InnoDB。InnoDB 和 MyISAM 区别之一就是 InnoDB 支持事务,也可以说这是 InnoDB 取代 MyISAM 的重要原因。事务的英文是 transaction,从英文中你也能看出来它是进行一次处理的基本单元,要么完全执行,要么都不执行。

换一种方式讲

不知道你是否遇到过这样的情况,你去家门口的小卖铺买东西,已经交了钱,但是老板比较忙接了个电话,忘记你是否交过钱,然后让你重新付款,这时你还要找之前的付款记录证明你已经完成了付款。

实际上如果我们线下的交易也能支持事务(满足事务的特性),就不会出现交了钱却拿不到商品的烦恼了,同样,对于小卖铺的老板来说,也不存在给出了商品但没有收到款的风险。

总之,事务保证了一次处理的完整性,也保证了数据库中的数据一致性。它是一种高级的数据处理方式,如果我们在增加、删除、修改的时候某一个环节出了错,它允许我们回滚还原。正是因为这个特点,事务非常适合应用在安全性高的场景里,比如金融行业等。

事务的特性:ACID

事务的特性:要么完全执行,要么都不执行。不过要对事务进行更深一步的理解,还要从事务的 4 个特性说起,这 4 个特性用英文字母来表达就是 ACID。

- A,也就是原子性(Atomicity)。原子的概念就是不可分割,你可以把它理解为组成物质的基本单位,也是我们进行数据处理操作的基本单位。

- C,就是一致性(Consistency)。一致性指的就是数据库在进行事务操作后,会由原来的一致状态,变成另一种一致的状态。也就是说当事务提交后,或者当事务发生回滚后,数据库的完整性约束不能被破坏。

- I,就是隔离性(Isolation)。它指的是每个事务都是彼此独立的,不会受到其他事务的执行影响。也就是说一个事务在提交之前,对其他事务都是不可见的。

- 最后一个 D,指的是持久性(Durability)。事务提交之后对数据的修改是持久性的,即使在系统出故障的情况下,比如系统崩溃或者存储介质发生故障,数据的修改依然是有效的。因为当事务完成,数据库的日志就会被更新,这时可以通过日志,让系统恢复到最后一次成功的更新状态。

ACID 可以说是事务的四大特性,在这四个特性中,原子性是基础,隔离性是手段,一致性是约束条件,而持久性是我们的目的。原子性和隔离性比较好理解,下面讲下对一致性的理解(国内很多网站上对一致性的阐述有误,具体你可以参考 Wikipedia 对Consistency的阐述)。

之前讲到过数据表的 7 种常见约束。这里指的一致性本身是由具体的业务定义的,也就是说,任何写入数据库中的数据都需要满足我们事先定义的约束规则。

比如说,在数据表中我们将姓名字段设置为唯一性约束,这时当事务进行提交或者事务发生回滚的时候,如果数据表中的姓名非唯一,就破坏了事务的一致性要求。所以说,事务操作会让数据表的状态变成另一种一致的状态,如果事务中的某个操作失败了,系统就会自动撤销当前正在执行的事务,返回到事务操作之前的状态。

事务的另一个特点就是持久性,持久性是通过事务日志来保证的。日志包括了回滚日志和重做日志。当我们通过事务对数据进行修改的时候,首先会将数据库的变化信息记录到重做日志中,然后再对数据库中对应的行进行修改。这样做的好处是,即使数据库系统崩溃,数据库重启后也能找到没有更新到数据库系统中的重做日志,重新执行,从而使事务具有持久性。

事务的控制

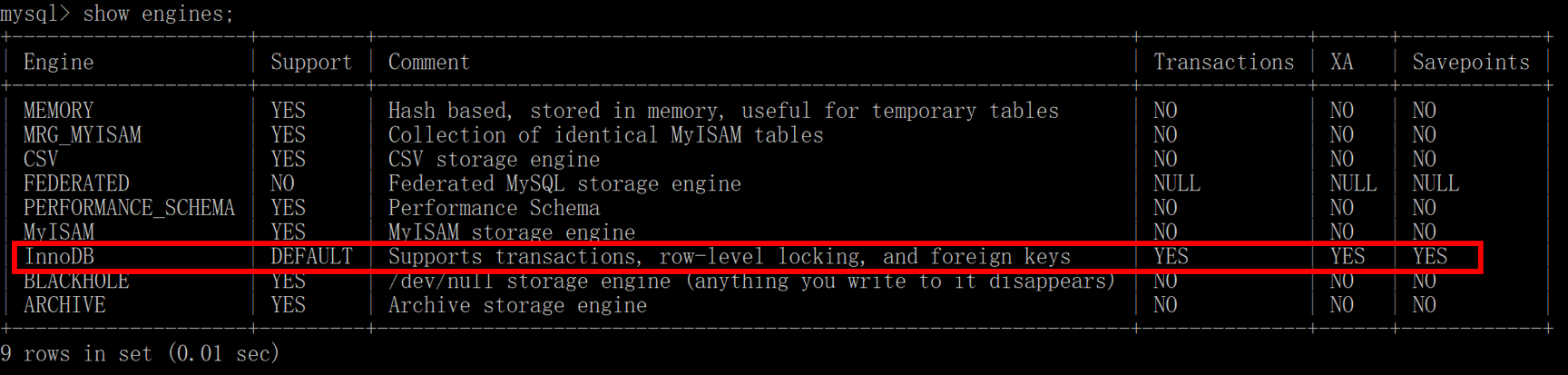

当我们了解了事务的特性后,再来看下如何使用事务。我们知道 Oracle 是支持事务的,而在 MySQL 中,则需要选择适合的存储引擎才可以支持事务。如果你使用的是 MySQL,可以通过 SHOW ENGINES 命令来查看当前 MySQL 支持的存储引擎都有哪些,以及这些存储引擎是否支持事务。

你能看出在 MySQL 中,InnoDB 是支持事务的,而 MyISAM 存储引擎不支持事务。

看到这里,我们已经对事务有了一定的了解,现在我们再来看下事务的常用控制语句都有哪些。

- START TRANSACTION 或者 BEGIN,作用是显式开启一个事务。

- COMMIT:提交事务。当提交事务后,对数据库的修改是永久性的。

- ROLLBACK 或者 ROLLBACK TO [SAVEPOINT],意为回滚事务。意思是撤销正在进行的所有没有提交的修改,或者将事务回滚到某个保存点。

- SAVEPOINT:在事务中创建保存点,方便后续针对保存点进行回滚。一个事务中可以存在多个保存点。

- RELEASE SAVEPOINT:删除某个保存点。

- SET TRANSACTION,设置事务的隔离级别。

需要说明的是,使用事务有两种方式,分别为隐式事务和显式事务。隐式事务实际上就是自动提交,Oracle 默认不自动提交,需要手写 COMMIT 命令,而 MySQL 默认自动提交,当然我们可以配置 MySQL 的参数:

mysql> set autocommit =0; // 关闭自动提交

mysql> set autocommit =1; // 开启自动提交

我们看下在 MySQL 的默认状态下,下面这个事务最后的处理结果是什么:

CREATE TABLE test(name varchar(255), PRIMARY KEY (name)) ENGINE=InnoDB;

BEGIN;

INSERT INTO test SELECT '关羽';

COMMIT;

BEGIN;

INSERT INTO test SELECT '张飞';

INSERT INTO test SELECT '张飞';

ROLLBACK;

SELECT * FROM test;

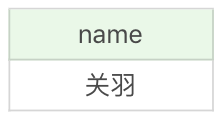

运行结果(1 行数据):

在这个事务中,整个 SQL 一共执行了 2 个事务,

第一个是插入“关羽”,提交后执行成功,

第二个是插入两次“张飞”,这里需要注意的是,我们将 name 设置为了主键,也就是说主键的值是唯一的,那么第二次插入“张飞”时就会产生错误,然后执行 ROLLBACK 相当于对事务进行了回滚,

所以我们看到最终结果只有一行数据,也就是第一个事务执行之后的结果,即“关羽”。

那么如果我们进行下面的操作又会怎样呢?

CREATE TABLE test(name varchar(255), PRIMARY KEY (name)) ENGINE=InnoDB;

BEGIN;

INSERT INTO test SELECT '关羽';

COMMIT;

INSERT INTO test SELECT '张飞';

INSERT INTO test SELECT '张飞';

ROLLBACK;

SELECT * FROM test;

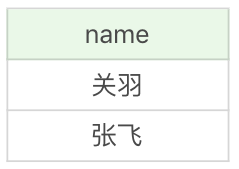

运行结果(2 行数据):

你能看到这次数据是 2 行,

上一次操作我把两次插入“张飞”放到一个事务里,

而这次操作它们不在同一个事务里,

那么对于 MySQL 来说,默认情况下这实际上就是两个事务,因为在 autocommit=1 的情况下,MySQL 会进行隐式事务,也就是自动提交,因此在进行第一次插入“张飞”后,数据表里就存在了两行数据,而第二次插入“张飞”就会报错:1062 - Duplicate entry '张飞' for key 'PRIMARY'。

最后我们在执行 ROLLBACK 的时候,实际上事务已经自动提交了,就没法进行回滚了。

同样的我们再来看下这段代码,你又能发现什么不同呢?

CREATE TABLE test(name varchar(255), PRIMARY KEY (name)) ENGINE=InnoDB;

SET @@completion_type = 1;

BEGIN;

INSERT INTO test SELECT '关羽';

COMMIT;

INSERT INTO test SELECT '张飞';

INSERT INTO test SELECT '张飞';

ROLLBACK;

SELECT * FROM test;

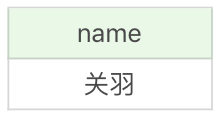

运行结果(1 行数据):

你能看到还是相同的 SQL 代码,只是我在事务开始之前设置了SET @@completion_type = 1;,结果就和我们第一次处理的一样,只有一个“关羽”。这是为什么呢?

这里我讲解下 MySQL 中 completion_type 参数的作用,实际上这个参数有 3 种可能:

- completion=0,这是默认情况。也就是说当我们执行 COMMIT 的时候会提交事务,在执行下一个事务时,还需要我们使用 START TRANSACTION 或者 BEGIN 来开启。

- completion=1,这种情况下,当我们提交事务后,相当于执行了 COMMIT AND CHAIN,也就是开启一个链式事务,即当我们提交事务之后会开启一个相同隔离级别的事务。

- completion=2,这种情况下 COMMIT=COMMIT AND RELEASE,也就是当我们提交后,会自动与服务器断开连接。

在上面这段代码里,我使用了 completion=1,也就是说当我提交之后,相当于在下一行写了一个 START TRANSACTION 或 BEGIN。这时两次插入“张飞”会被认为是在同一个事务之内的操作,那么第二次插入“张飞”就会导致事务失败,而回滚也将这次事务进行了撤销,所以你能看到的结果就只有一个“关羽”。

通过这样简单的练习,你应该能体会到事务提交和回滚的操作。

当我们设置 autocommit=0 时,不论是否采用 START TRANSACTION 或者 BEGIN 的方式来开启事务,都需要用 COMMIT 进行提交,让事务生效,使用 ROLLBACK 对事务进行回滚。

当我们设置 autocommit=1 时,每条 SQL 语句都会自动进行提交。

不过这时,如果你采用 START TRANSACTION 或者 BEGIN 的方式来显式地开启事务,那么这个事务只有在 COMMIT 时才会生效,在 ROLLBACK 时才会回滚。

总结

我们对事务的概念进行了理解,并进行了简单的事务操作。我们在做数据库操作的时候,可能会失败,但正是因为有事务的存在,即使在数据库操作失败的情况下,也能保证数据的一致性。同样,多个应用程序访问数据库的时候,事务可以提供隔离,保证事务之间不被干扰。最后,事务一旦提交,结果就会是永久性的,这就意味着,即使系统崩溃了,数据库也可以对数据进行恢复。

在使用事务的过程中,我们会采用控制流语句对事务进行操作,不过在实际操作中,不一定每次使用 COMMIT 或 ROLLBACK 都会成功,你还需要知道当前系统的事务执行方式,也就是一些常用的参数情况,比如 MySQL 中的 autocommit 和 completion_type 等。

事务是数据库区别于文件系统的重要特性之一,当我们有了事务就会让数据库始终保持一致性,同时我们还能通过事务的机制恢复到某个时间点,这样可以保证已提交到数据库的修改不会因为系统崩溃而丢失。

事务隔离

事务的四大特性 ACID,分别是原子性、一致性、隔离性和持久性,其中隔离性是事务的基本特性之一,它可以防止数据库在并发处理时出现数据不一致的情况。

最严格的情况下,我们可以采用串行化的方式来执行每一个事务,这就意味着事务之间是相互独立的,不存在并发的情况。然而在实际生产环境下,考虑到随着用户量的增多,会存在大规模并发访问的情况,这就要求数据库有更高的吞吐能力,这个时候串行化的方式就无法满足数据库高并发访问的需求,我们还需要降低数据库的隔离标准,来换取事务之间的并发能力。

有时候我们需要牺牲一定的正确性来换取效率的提升,也就是说,我们需要通过设置不同的隔离等级,以便在正确性和效率之间进行平衡。同时,随着 RDBMS 种类和应用场景的增多,数据库的设计者需要统一对数据库隔离级别进行定义,说明这些隔离标准都解决了哪些问题。

事务并发处理可能存在的异常都有哪些?

在了解数据库隔离级别之前,我们需要了解设定事务的隔离级别都要解决哪些可能存在的问题,也就是事务并发处理时会存在哪些异常情况。实际上,SQL-92 标准中已经对 3 种异常情况进行了定义,这些异常情况级别分别为脏读(Dirty Read)、不可重复读(Nnrepeatable Read)和幻读(Phantom Read)。

脏读

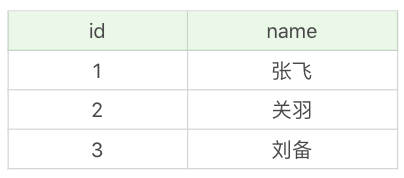

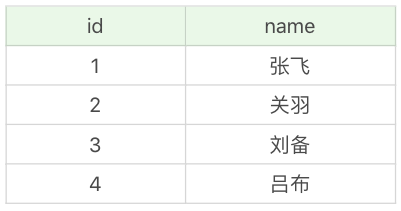

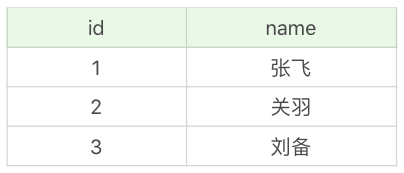

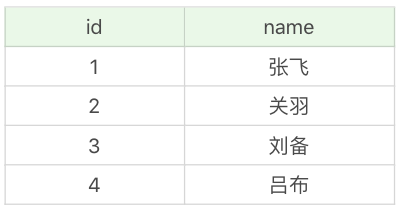

我们有个英雄表 heros_temp,如下所示:

这张英雄表,我们会记录很多英雄的姓名,假设我们不对事务进行隔离操作,那么数据库在进行事务的并发处理时会出现怎样的情况?

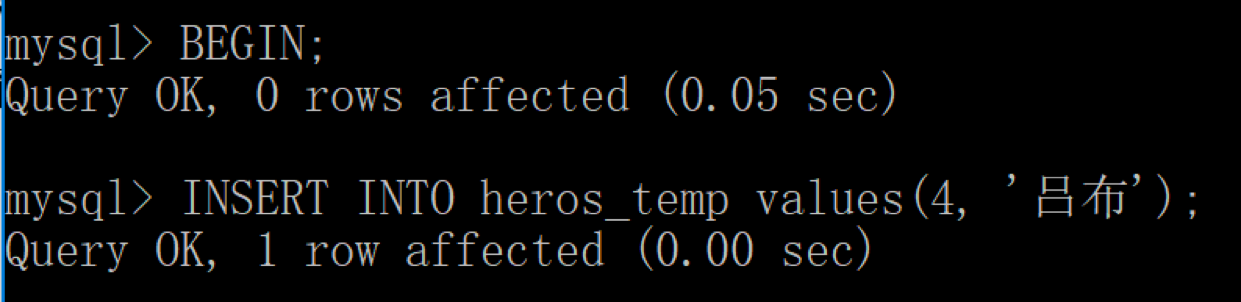

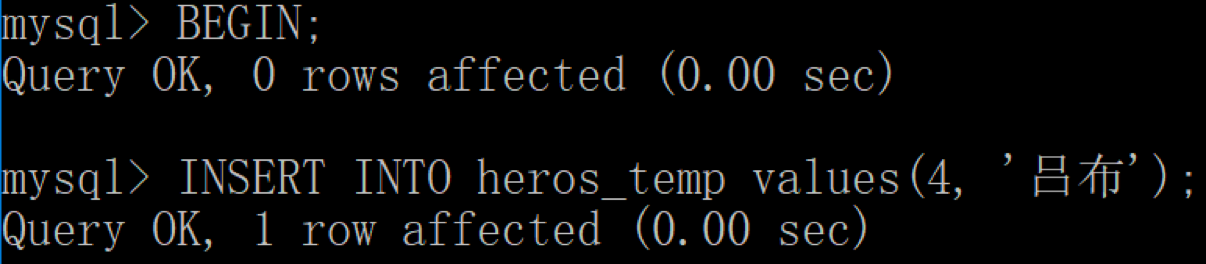

第一天,小张访问数据库,正在进行事务操作,往里面写入一个新的英雄“吕布”:

SQL> BEGIN;

SQL> INSERT INTO heros_temp values(4, '吕布');

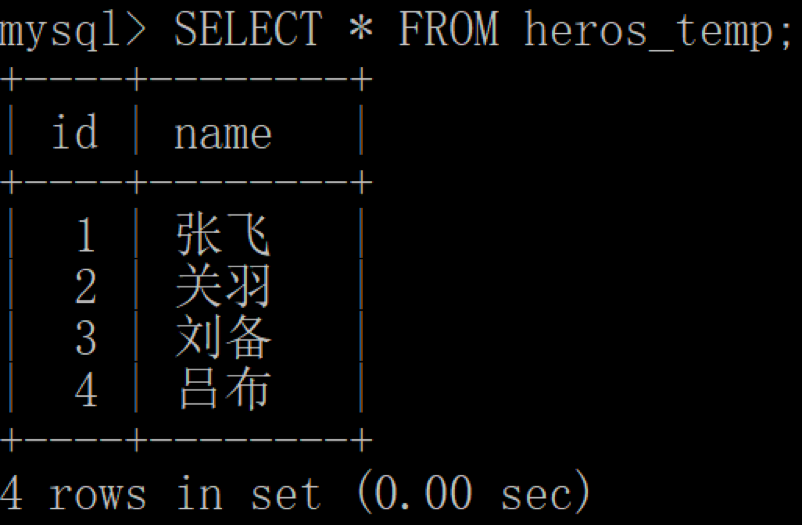

当小张还没有提交该事务的时候,小李又对数据表进行了访问,他想看下这张英雄表里都有哪些英雄:

SQL> SELECT * FROM heros_temp;

这时,小李看到的结果如下:

你有没有发现什么异常?

这个时候小张还没有提交事务,但是小李却读到了小张还没有提交的数据,这种现象我们称之为“脏读”。

什么是不可重复读呢?

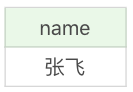

第二天,小张想查看 id=1 的英雄是谁,于是他进行了 SQL 查询:

SQL> SELECT name FROM heros_temp WHERE id = 1;

运行结果:

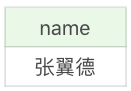

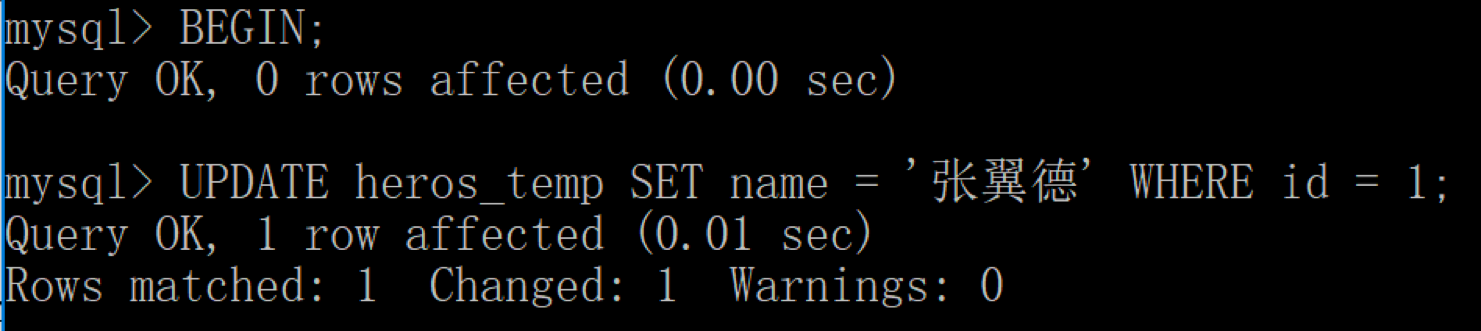

然而此时,小李开始了一个事务操作,他对 id=1 的英雄姓名进行了修改,把原来的“张飞”改成了“张翼德”:

SQL> BEGIN;

SQL> UPDATE heros_temp SET name = '张翼德' WHERE id = 1;

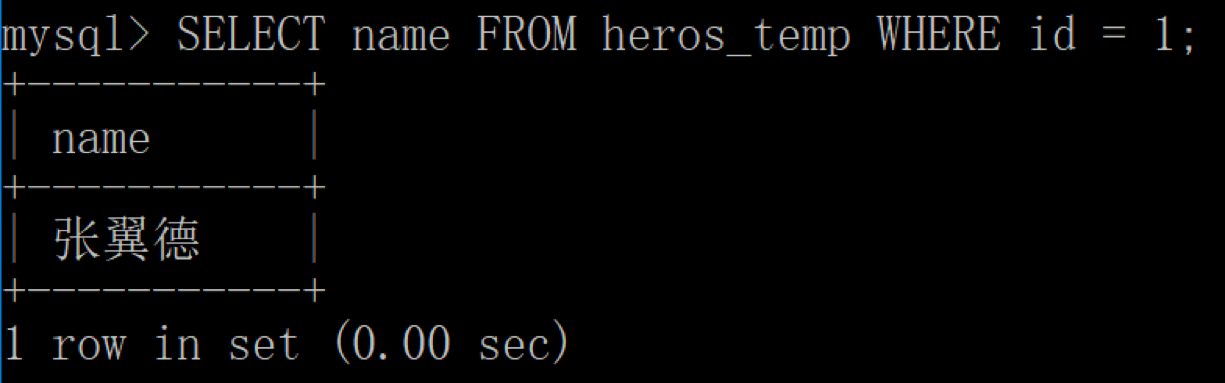

然后小张再一次进行查询,同样也是查看 id=1 的英雄是谁:

SQL> SELECT name FROM heros_temp WHERE id = 1;

运行结果:

这个时候你会发现,两次查询的结果并不一样。小张会想这是怎么回事呢?他明明刚执行了一次查询,马上又进行了一次查询,结果两次的查询结果不同。实际上小张遇到的情况我们称之为“不可重复读”,也就是同一条记录,两次读取的结果不同。

什么是幻读?

第三天,小张想要看下数据表里都有哪些英雄,他开始执行下面这条语句:

SQL> SELECT * FROM heros_temp;

这时当小张执行完之后,小李又开始了一个事务,往数据库里插入一个新的英雄“吕布”:

SQL> BEGIN;

SQL> INSERT INTO heros_temp values(4, '吕布');

不巧的是,小张这时忘记了英雄都有哪些,又重新执行了一遍查询:

SQL> SELECT * FROM heros_temp;

他发现这一次查询多了一个英雄,原来只有 3 个,现在变成了 4 个。这种异常情况我们称之为“幻读”。

我来总结下这三种异常情况的特点:

- 脏读:读到了其他事务还没有提交的数据。

- 不可重复读:对某数据进行读取,发现两次读取的结果不同,也就是说没有读到相同的内容。这是因为有其他事务对这个数据同时进行了修改或删除。

- 幻读:事务 A 根据条件查询得到了 N 条数据,但此时事务 B 更改或者增加了 M 条符合事务 A 查询条件的数据,这样当事务 A 再次进行查询的时候发现会有 N+M 条数据,产生了幻读。

事务隔离的级别有哪些?

脏读、不可重复读和幻读这三种异常情况,是在 SQL-92 标准中定义的,同时 SQL-92 标准还定义了 4 种隔离级别来解决这些异常情况。

解决异常数量从少到多的顺序(比如读未提交可能存在 3 种异常,可串行化则不会存在这些异常)决定了隔离级别的高低,这四种隔离级别从低到高分别是:

读未提交(READ UNCOMMITTED )、读已提交(READ COMMITTED)、可重复读(REPEATABLE READ)和可串行化(SERIALIZABLE)。

这些隔离级别能解决的异常情况如下表所示:

你能看到可串行化能避免所有的异常情况,而读未提交则允许异常情况发生。

关于这四种级别,我来简单讲解下。

读未提交,也就是允许读到未提交的数据,这种情况下查询是不会使用锁的,可能会产生脏读、不可重复读、幻读等情况。

读已提交就是只能读到已经提交的内容,可以避免脏读的产生,属于 RDBMS 中常见的默认隔离级别(比如说 Oracle 和 SQL Server),但如果想要避免不可重复读或者幻读,就需要我们在 SQL 查询的时候编写带加锁的 SQL 语句(我会在进阶篇里讲加锁)。

可重复读,保证一个事务在相同查询条件下两次查询得到的数据结果是一致的,可以避免不可重复读和脏读,但无法避免幻读。MySQL 默认的隔离级别就是可重复读。

可串行化,将事务进行串行化,也就是在一个队列中按照顺序执行,可串行化是最高级别的隔离等级,可以解决事务读取中所有可能出现的异常情况,但是它牺牲了系统的并发性。

使用 MySQL 客户端来模拟三种异常

我在讲解这三种异常的时候举了一个英雄数据表查询的例子,你还可以自己写 SQL 来模拟一下这三种异常。

首先我们需要一个英雄数据表 heros_temp,之前网盘有。

你也可以执行下面的 SQL 文件,来完成 heros_temp 数据表的创建。

-- ----------------------------

-- Table structure for heros_temp

-- ----------------------------

DROP TABLE IF EXISTS `heros_temp`;

CREATE TABLE `heros_temp` (

`id` int(11) NOT NULL,

`name` varchar(255) CHARACTER SET utf8 COLLATE utf8_general_ci NOT NULL,

PRIMARY KEY (`id`) USING BTREE

) ENGINE = InnoDB CHARACTER SET = utf8 COLLATE = utf8_general_ci ROW_FORMAT = Dynamic;

-- ----------------------------

-- Records of heros_temp

-- ----------------------------

INSERT INTO `heros_temp` VALUES (1, '张飞');

INSERT INTO `heros_temp` VALUES (2, '关羽');

INSERT INTO `heros_temp` VALUES (3, '刘备');

模拟的时候我们需要开两个 MySQL 客户端,分别是客户端 1 和客户端 2。

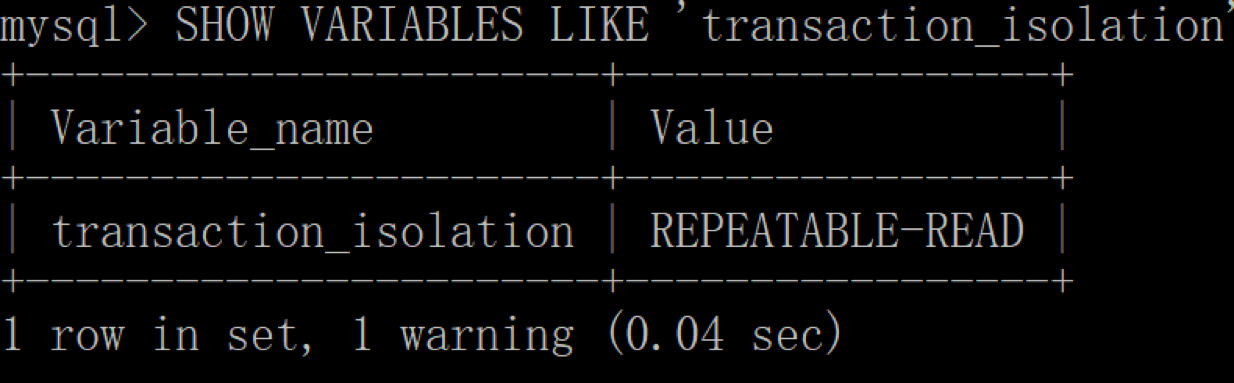

在客户端 1 中,我们先来查看下当前会话的隔离级别,使用命令:

mysql> SHOW VARIABLES LIKE 'transaction_isolation';

然后你能看到当前的隔离级别是 REPEATABLE-READ,也就是可重复读。

现在我们把隔离级别降到最低,设置为 READ UNCOMMITTED(读未提交)。

mysql> SET SESSION TRANSACTION ISOLATION LEVEL READ UNCOMMITTED;

然后再查看下当前会话(SESSION)下的隔离级别,结果如下:

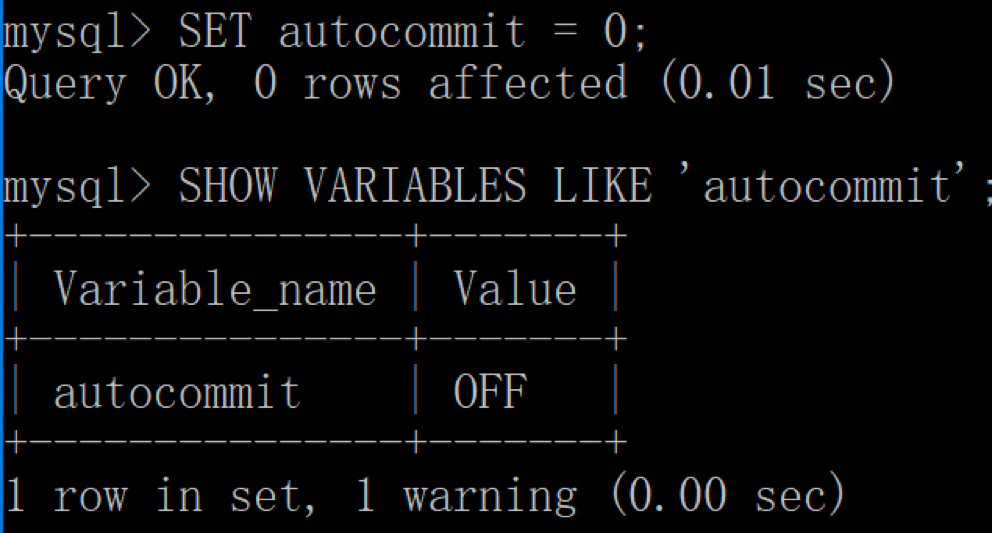

因为 MySQL 默认是事务自动提交,这里我们还需要将 autocommit 参数设置为 0,命令如下:

mysql> SET autocommit = 0;

然后我们再来查看 SESSION 中的 autocommit 取值,结果如下:

接着我们以同样的操作启动客户端 2,也就是将隔离级别设置为 READ UNCOMMITTED(读未提交),autocommit 设置为 0。

模拟“脏读”

我们在客户端 2 中开启一个事务,在 heros_temp 表中写入一个新的英雄“吕布”,注意这个时候不要提交。

然后我们在客户端 1 中,查看当前的英雄表:

你能发现客户端 1 中读取了客户端 2 未提交的新英雄“吕布”,实际上客户端 2 可能马上回滚,从而造成了“脏读”。

模拟“不可重复读”

我们用客户端 1 来查看 id=1 的英雄:

然后用客户端 2 对 id=1 的英雄姓名进行修改:

这时用客户端 1 再次进行查询:

你能发现对于客户端 1 来说,同一条查询语句出现了“不可重复读”。

模拟“幻读”

我们先用客户端 1 查询数据表中的所有英雄:

然后用客户端 2,开始插入新的英雄“吕布”:

这时,我们再用客户端 1 重新进行查看:

你会发现数据表多出一条数据。

如果你是初学者,那么你可以采用 heros_temp 数据表简单模拟一下以上的过程,加深对脏读、不可重复读以及幻读的理解。对应的,你也会更了解不同的隔离级别解决的异常问题。

总结

我们今天只是简单讲解了 4 种隔离级别,以及对应的要解决的三种异常问题。

你能看到,标准的价值在于,即使是不同的 RDBMS 都需要达成对异常问题和隔离级别定义的共识。这就意味着一个隔离级别的实现满足了下面的两个条件:

- 正确性:只要能满足某一个隔离级别,一定能解决这个隔离级别对应的异常问题。

- 与实现无关:实际上 RDBMS 种类很多,这就意味着有多少种 RDBMS,就有多少种锁的实现方式,因此它们实现隔离级别的原理可能不同,然而一个好的标准不应该限制其实现的方式。

隔离级别越低,意味着系统吞吐量(并发程度)越大,但同时也意味着出现异常问题的可能性会更大。在实际使用过程中我们往往需要在性能和正确性上进行权衡和取舍,没有完美的解决方案,只有适合与否。

游标

我们在编写 SQL 语句的时候通常是面向集合进行思考,这种思考方式更让我们关注结果集的特征,而不是具体的实现过程。面向集合的思考方式与面向过程的思考方式各有特点,我们该如何理解它们呢?

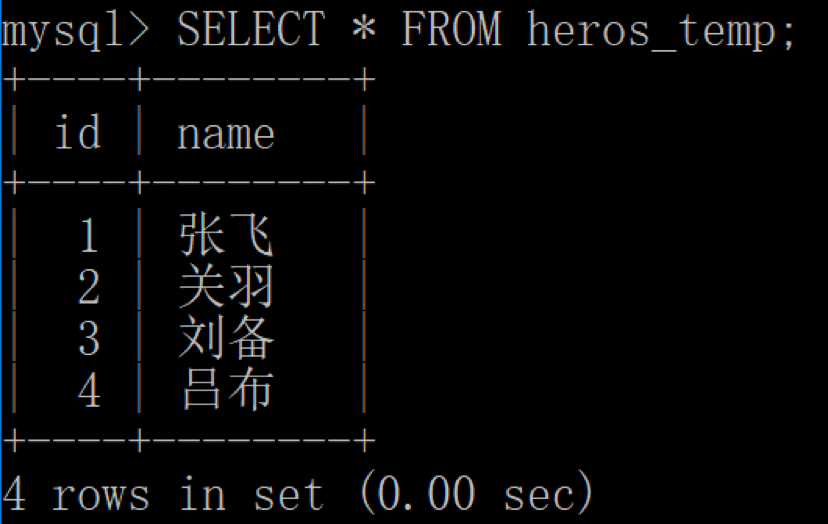

这张图中一共有 9 个图形,每个图形有不同的特征,包括形状、纹理、颜色和个数等。

当我们看到这张图时,有时候会不由自主地按照某个属性进行分类,比如说按照红色分类,那么 1、4、9 就是一类。这实际上就是属于同一个条件下的查询结果集。或者我们也可以按照物体的个数来划分,比如都有 3 个物体的,那么对应的就是 2、5、6、8,这就是对应着“都包括 3 个物体”的查询结果集。

你能看出来集合思维更像是从整体的角度来考虑,然后把整个数据集按照不同的属性进行划分,形成不同的子集合。面向集合的思考方式,让我们关注“获取什么”,而不是“如何获取”,这也可以说是 SQL 与传统编程最大的区别之一,因为 SQL 本身是以关系模型和集合论为基础的。

然而也有一些情况,我们不需要对查询结果集中的所有数据行都采用相同的处理方式,需要每次处理一行或者一部分行,这时就需要面向过程的编程方法了。游标就是这种编程方式的体现。如果你之前已经有了一些面向过程的编程经验,那么对于游标的理解也会比较容易。

什么是游标?

在数据库中,游标是个重要的概念,它提供了一种灵活的操作方式,可以让我们从数据结果集中每次提取一条数据记录进行操作。游标让 SQL 这种面向集合的语言有了面向过程开发的能力。可以说,游标是面向过程的编程方式,这与面向集合的编程方式有所不同。

在 SQL 中,游标是一种临时的数据库对象,可以指向存储在数据库表中的数据行指针。这里游标充当了指针的作用,我们可以通过操作游标来对数据行进行操作。

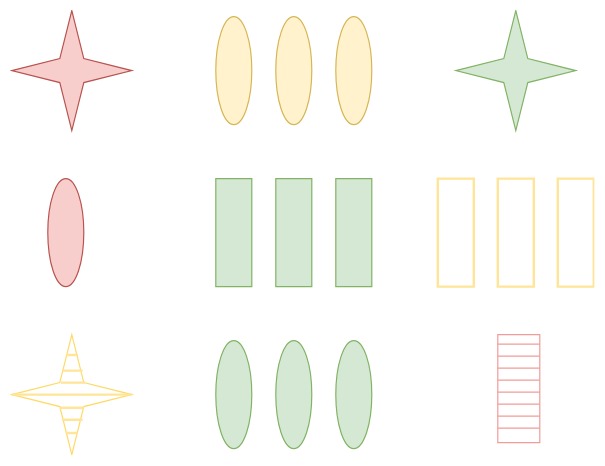

比如我们查询了 heros 数据表中最大生命值大于 8500 的英雄都有哪些:

SELECT id, name, hp_max FROM heros WHERE hp_max > 8500

查询结果(4 条数据):

这里我们就可以通过游标来操作数据行,如图所示此时游标所在的行是“白起”的记录,我们也可以在结果集上滚动游标,指向结果集中的任意一行。

如何使用游标?

游标实际上是一种控制数据集的更加灵活的处理方式。

如果我们想要使用游标,一般需要经历五个步骤。不同 DBMS 中,使用游标的语法可能略有不同。

第一步,定义游标。

DECLARE cursor_name CURSOR FOR select_statement

这个语法适用于 MySQL,SQL Server,DB2 和 MariaDB。如果是用 Oracle 或者 PostgreSQL,需要写成:

DECLARE cursor_name CURSOR IS select_statement

要使用 SELECT 语句来获取数据结果集,而此时还没有开始遍历数据,这里 select_statement 代表的是 SELECT 语句。

下面我用 MySQL 举例讲解游标的使用,如果你使用的是其他的 RDBMS,具体的游标语法可能略有差异。我们定义一个能够存储 heros 数据表中的最大生命值的游标,可以写为:

DECLARE cur_hero CURSOR FOR

SELECT hp_max FROM heros;

第二步,打开游标。

OPEN cursor_name

当我们定义好游标之后,如果想要使用游标,必须先打开游标。打开游标的时候 SELECT 语句的查询结果集就会送到游标工作区。

第三步,从游标中取得数据。

FETCH cursor_name INTO var_name ...

这句的作用是使用 cursor_name 这个游标来读取当前行,并且将数据保存到 var_name 这个变量中,游标指针指到下一行。如果游标读取的数据行有多个列名,则在 INTO 关键字后面赋值给多个变量名即可。

第四步,关闭游标。

CLOSE cursor_name

有 OPEN 就会有 CLOSE,也就是打开和关闭游标。当我们使用完游标后需要关闭掉该游标。关闭游标之后,我们就不能再检索查询结果中的数据行,如果需要检索只能再次打开游标。

最后一步,释放游标。

DEALLOCATE PREPARE

有 DECLARE 就需要有 DEALLOCATE,DEALLOCATE 的作用是释放游标。我们一定要养成释放游标的习惯,否则游标会一直存在于内存中,直到进程结束后才会自动释放。当你不需要使用游标的时候,释放游标可以减少资源浪费。

上面就是 5 个常用的游标步骤。举一个简单的例子,假设想用游标来扫描 heros 数据表中的数据行,然后累计最大生命值,那么该怎么做呢?

我先创建一个存储过程 calc_hp_max,然后在存储过程中定义游标 cur_hero,使用 FETCH 获取每一行的具体数值,然后赋值给变量 hp,再用变量 hp_sum 做累加求和,最后再输出 hp_sum,代码如下:

CREATE PROCEDURE `calc_hp_max`()

BEGIN

-- 创建接收游标的变量

DECLARE hp INT;

-- 创建总数变量

DECLARE hp_sum INT DEFAULT 0;

-- 创建结束标志变量

DECLARE done INT DEFAULT false;

-- 定义游标

DECLARE cur_hero CURSOR FOR SELECT hp_max FROM heros;

OPEN cur_hero;

read_loop:LOOP

FETCH cur_hero INTO hp;

SET hp_sum = hp_sum + hp;

END LOOP;

CLOSE cur_hero;

SELECT hp_sum;

DEALLOCATE PREPARE cur_hero;

END

你会发现执行call calc_hp_max()这一句的时候系统会提示 1329 错误,也就是在 LOOP 中当游标没有取到数据时会报的错误。

当游标溢出时(也就是当游标指向到最后一行数据后继续执行会报的错误),我们可以定义一个 continue 的事件,指定这个事件发生时修改变量 done 的值,以此来判断游标是否已经溢出,即:

DECLARE CONTINUE HANDLER FOR NOT FOUND SET done = true;

同时在循环中我们需要加上对 done 的判断,如果游标的循环已经结束,就需要跳出 read_loop 循环,完善的代码如下:

CREATE PROCEDURE `calc_hp_max`()

BEGIN

-- 创建接收游标的变量

DECLARE hp INT;

-- 创建总数变量

DECLARE hp_sum INT DEFAULT 0;

-- 创建结束标志变量

DECLARE done INT DEFAULT false;

-- 定义游标

DECLARE cur_hero CURSOR FOR SELECT hp_max FROM heros;

-- 指定游标循环结束时的返回值

DECLARE CONTINUE HANDLER FOR NOT FOUND SET done = true;

OPEN cur_hero;

read_loop:LOOP

FETCH cur_hero INTO hp;

-- 判断游标的循环是否结束

IF done THEN

LEAVE read_loop;

END IF;

SET hp_sum = hp_sum + hp;

END LOOP;

CLOSE cur_hero;

SELECT hp_sum;

DEALLOCATE PREPARE cur_hero;

END

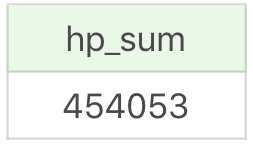

运行结果(1 行数据):

在游标中的循环中,除了使用 LOOP 循环以外,你还可以使用 REPEAT… UNTIL…以及 WHILE 循环。它们同样需要设置 CONTINUE 事件来处理游标溢出的情况。

所以你能看出,使用游标可以让我们对 SELECT 结果集中的每一行数据进行相同或者不同的操作,从而很精细化地管理结果集中的每一条数据。

使用游标来解决一些常见的问题

我刚才讲了一个简单的使用案例,实际上如果想要统计 hp_sum,完全可以通过 SQL 语句来完成,比如:

SELECT SUM(hp_max) FROM heros

运行结果(1 行数据):

那么游标都有什么用呢?

当你需要处理一些复杂的数据行计算的时候,游标就会起到作用了。我举个例子,还是针对 heros 数据表,假设我们想要对英雄的物攻成长(对应 attack_growth)进行升级,在新版本中大范围提升英雄的物攻成长数值,但是针对不同的英雄情况,提升的幅度也不同,具体提升的方式如下。

如果这个英雄原有的物攻成长小于 5,那么将在原有基础上提升 7%-10%。如果物攻成长的提升空间(即最高物攻 attack_max- 初始物攻 attack_start)大于 200,那么在原有的基础上提升 10%;如果物攻成长的提升空间在 150 到 200 之间,则提升 8%;如果物攻成长的提升空间不足 150,则提升 7%。

如果原有英雄的物攻成长在 5—10 之间,那么将在原有基础上提升 5%。

如果原有英雄的物攻成长大于 10,则保持不变。

以上所有的更新后的物攻成长数值,都需要保留小数点后 3 位。

你能看到上面这个计算的情况相对复杂,实际工作中你可能会遇到比这个更加复杂的情况,这时你可以采用面向过程的思考方式来完成这种任务,也就是说先取出每行的数值,然后针对数值的不同情况采取不同的计算方式。

针对上面这个情况,你自己可以用游标来完成转换,具体的代码如下:

CREATE PROCEDURE `alter_attack_growth`()

BEGIN

-- 创建接收游标的变量

DECLARE temp_id INT;

DECLARE temp_growth, temp_max, temp_start, temp_diff FLOAT;

-- 创建结束标志变量

DECLARE done INT DEFAULT false;

-- 定义游标

DECLARE cur_hero CURSOR FOR SELECT id, attack_growth, attack_max, attack_start FROM heros;

-- 指定游标循环结束时的返回值

DECLARE CONTINUE HANDLER FOR NOT FOUND SET done = true;

OPEN cur_hero;

FETCH cur_hero INTO temp_id, temp_growth, temp_max, temp_start;

REPEAT

IF NOT done THEN

SET temp_diff = temp_max - temp_start;

IF temp_growth < 5 THEN

IF temp_diff > 200 THEN

SET temp_growth = temp_growth * 1.1;

ELSEIF temp_diff >= 150 AND temp_diff <=200 THEN

SET temp_growth = temp_growth * 1.08;

ELSEIF temp_diff < 150 THEN

SET temp_growth = temp_growth * 1.07;

END IF;

ELSEIF temp_growth >=5 AND temp_growth <=10 THEN

SET temp_growth = temp_growth * 1.05;

END IF;

UPDATE heros SET attack_growth = ROUND(temp_growth,3) WHERE id = temp_id;

END IF;

FETCH cur_hero INTO temp_id, temp_growth, temp_max, temp_start;

UNTIL done = true END REPEAT;

CLOSE cur_hero;

DEALLOCATE PREPARE cur_hero;

END

这里我创建了 alter_attack_growth 这个存储过程,使用了 REPEAT…UNTIL…的循环方式,针对不同的情况计算了新的物攻成长 temp_growth,然后对原有的 attack_growth 进行了更新,最后调用 call alter_attack_growth(); 执行存储过程。

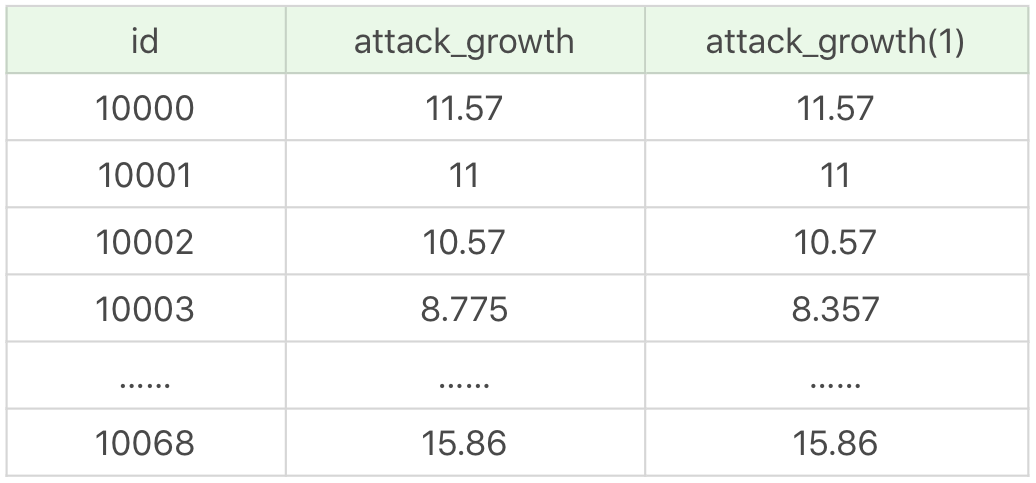

有一点需要注意的是,我们在对数据表进行更新前,需要备份之前的表,我们可以将备份后的表命名为 heros_copy1。更新完 heros 数据表之后,你可以看下两张表在 attack_growth 字段上的对比,我们使用 SQL 进行查询:

SELECT heros.id, heros.attack_growth, heros_copy1.attack_growth FROM heros JOIN heros_copy1 WHERE heros.id = heros_copy1.id

运行结果(69 条记录):

通过前后两张表的 attack_growth 对比你也能看出来,存储过程通过游标对不同的数据行进行了更新。

需要说明的是,以上代码适用于 MySQL,如果在 SQL Server 或 Oracle 中,使用方式会有些差别。

总结

讲解了如何在 SQL 中使用游标,游标实际上是面向过程的思维方式,与面向集合的思维方式不同的地方在于,游标更加关注“如何执行”。我们可以通过游标更加精细、灵活地查询和管理想要的数据行。

有的时候,我们需要找特定数据,用 SQL 查询写起来会比较困难,比如两表或多表之间的嵌套循环查找,如果用 JOIN 会非常消耗资源,效率也可能不高,而用游标则会比较高效。

虽然在处理某些复杂的数据情况下,使用游标可以更灵活,但同时也会带来一些性能问题,比如在使用游标的过程中,会对数据行进行加锁,这样在业务并发量大的时候,不仅会影响业务之间的效率,还会消耗系统资源,造成内存不足,这是因为游标是在内存中进行的处理。如果有游标的替代方案,我们可以采用替代方案。

使用Python操作MySQL

我们之前都是直接在 DBMS 里面进行 SQL 的操作,实际上我们还可以通过后端语言对 DBMS 进行访问以及进行相应的操作,这样更具有灵活性,可以实现一些较为复杂的操作。作为一个后端开发人员,掌握一些 SQL 技术是必须的;作为一个数据库管理人员,了解后端语言如何开发和管理数据库也是很有必要的。

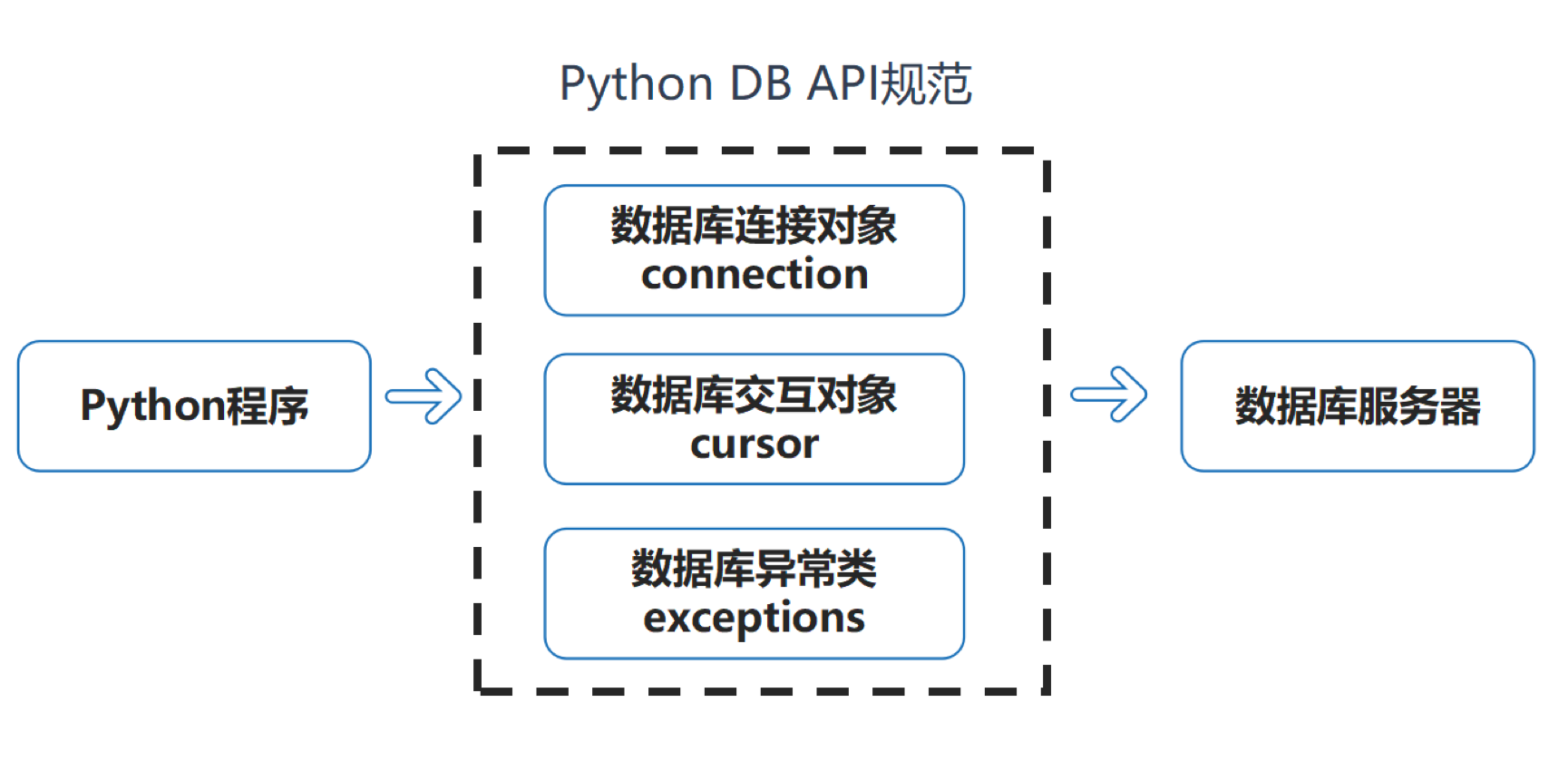

Python DB API 规范

Python 可以支持非常多的数据库管理系统,比如 MySQL、Oracle、SQL Server 和 PostgreSQL 等。为了实现对这些 DBMS 的统一访问,Python 需要遵守一个规范,这就是 DB API 规范。我在下图中列出了 DB API 规范的作用,这个规范给我们提供了数据库对象连接、对象交互和异常处理的方式,为各种 DBMS 提供了统一的访问接口。这样做的好处就是如果项目需要切换数据库,Python 层的代码移植会比较简单。

我们在使用 Python 对 DBMS 进行操作的时候,需要经过下面的几个步骤:

- 引入 API 模块;

- 与数据库建立连接;

- 执行 SQL 语句;

- 关闭数据库连接。

如何使用 mysql-connector

使用 Python 对数据库进行访问需要基于 DB API 规范,这里有不少库供我们选择,比如 MySQLdb、mysqlclient、PyMySQL、peewee 和 SQLAIchemy 等。下面讲解的是 mysql-connector,它是 MySQL 官方提供的驱动器,用来给后端语言,比如 Python 提供连接。

下面我们看下如何用 Python 使用 mysql-connector,以完成数据库的连接和使用。

首先安装 mysql-connector。在使用前,你需要先使用下面这句命令进行安装:

pip install mysql-connector

在安装之后,你可以创建数据库连接,然后查看下数据库的版本号,来验证下数据库是否连接成功。代码如下:

# -*- coding: UTF-8 -*-

import mysql.connector

# 打开数据库连接

db = mysql.connector.connect(

host="localhost",

user="root",

passwd="XXX", # 写上你的数据库密码

database='wucai',

auth_plugin='mysql_native_password'

)

# 获取操作游标

cursor = db.cursor()

# 执行 SQL 语句

cursor.execute("SELECT VERSION()")

# 获取一条数据

data = cursor.fetchone()

print("MySQL 版本: %s " % data)

# 关闭游标 & 数据库连接

cursor.close()

db.close()

运行结果:

MySQL 版本: 8.0.13

上面这段代码中有两个重要的对象你需要了解下,分别是 Connection 和 Cursor。

Connection 就是对数据库的当前连接进行管理,我们可以通过它来进行以下操作:

- 通过指定 host、user、passwd 和 port 等参数来创建数据库连接,这些参数分别对应着数据库 IP 地址、用户名、密码和端口号;

- 使用 db.close() 关闭数据库连接;

- 使用 db.cursor() 创建游标,操作数据库中的数据;

- 使用 db.begin() 开启事务;

- 使用 db.commit() 和 db.rollback(),对事务进行提交以及回滚。

当我们通过cursor = db.cursor()创建游标后,就可以通过面向过程的编程方式对数据库中的数据进行操作:

- 使用

cursor.execute(query_sql),执行数据库查询; - 使用

cursor.fetchone(),读取数据集中的一条数据; - 使用

cursor.fetchall(),取出数据集中的所有行,返回一个元组 tuples 类型; - 使用

cursor.fetchmany(n),取出数据集中的多条数据,同样返回一个元组 tuples; - 使用

cursor.rowcount,返回查询结果集中的行数。如果没有查询到数据或者还没有查询,则结果为 -1,否则会返回查询得到的数据行数; - 使用

cursor.close(),关闭游标。

对数据表进行增删改查

了解了 Connection 和 Cursor 的使用方式之后,我们来看下如何来对 heros 数据表进行 CRUD 的操作,即增加、读取、更新和删除。

增加数据

假设我们想在 player 表中增加一名新球员,姓名为“约翰·科林斯”,球队 ID 为 1003(即亚特兰大老鹰),身高为 2.08m。代码如下:

# 插入新球员

sql = "INSERT INTO player (team_id, player_name, height) VALUES (%s, %s, %s)"

val = (1003, " 约翰 - 科林斯 ", 2.08)

cursor.execute(sql, val)

db.commit()

print(cursor.rowcount, " 记录插入成功。")

我们使用 cursor.execute 来执行相应的 SQL 语句,val 为 SQL 语句中的参数,SQL 执行后使用 db.commit() 进行提交。需要说明的是,我们在使用 SQL 语句的时候,可以向 SQL 语句传递参数,这时 SQL 语句里要统一用(%s)进行占位,否则就会报错。不论插入的数值为整数类型,还是浮点类型,都需要统一用(%s)进行占位。

另外在用游标进行 SQL 操作之后,还需要使用 db.commit() 进行提交,否则数据不会被插入。

然后是读取数据。我们来看下数据是否被插入成功,这里我们查询下身高大于等于 2.08m 的球员都有哪些,代码如下:

# 查询身高大于等于 2.08 的球员

sql = 'SELECT player_id, player_name, height FROM player WHERE height>=2.08'

cursor.execute(sql)

data = cursor.fetchall()

for each_player in data:

print(each_player)

运行结果:

(10003, '安德烈 - 德拉蒙德', 2.11)

(10004, '索恩 - 马克', 2.16)

(10009, '扎扎 - 帕楚里亚', 2.11)

(10010, '乔恩 - 洛伊尔', 2.08)

(10011, '布雷克 - 格里芬', 2.08)

(10015, '亨利 - 埃伦森', 2.11)

(10023, '多曼塔斯 - 萨博尼斯', 2.11)

(10024, '迈尔斯 - 特纳', 2.11)

(10032, 'TJ- 利夫', 2.08)

(10033, '凯尔 - 奥奎因', 2.08)

(10037, '伊凯·阿尼博古', 2.08)

(10038, '约翰 - 科林斯', 2.08)

你能看到球员约翰·科林斯被正确插入。

修改数据

假如我想修改刚才插入的球员约翰·科林斯的身高,将身高修改成 2.09,代码如下:

# 修改球员约翰 - 科林斯

sql = 'UPDATE player SET height = %s WHERE player_name = %s'

val = (2.09, " 约翰 - 科林斯 ")

cursor.execute(sql, val)

db.commit()

print(cursor.rowcount, " 记录被修改。")

最后我们看下如何删除约翰·科林斯这个球员的数据,代码如下:

sql = 'DELETE FROM player WHERE player_name = %s'

val = (" 约翰 - 科林斯 ",)

cursor.execute(sql, val)

db.commit()

print(cursor.rowcount, " 记录删除成功。")

最后都执行完了,我们来关闭游标和数据库的连接,使用以下代码即可:

cursor.close()

db.close()

针对上面的操作过程,你可以模拟下数据的 CRUD 操作,但有几点你需要注意。

1. 打开数据库连接以后,如果不再使用,则需要关闭数据库连接,以免造成资源浪费。

2. 在对数据进行增加、删除和修改的时候,可能会出现异常,这时就需要用try...except捕获异常信息。比如针对插入球员约翰·科林斯这个操作,你可以写成下面这样:

import traceback

try:

sql = "INSERT INTO player (team_id, player_name, height) VALUES (%s, %s, %s)"

val = (1003, " 约翰 - 科林斯 ", 2.08)

cursor.execute(sql, val)

db.commit()

print(cursor.rowcount, " 记录插入成功。")

except Exception as e:

# 打印异常信息

traceback.print_exc()

# 回滚

db.rollback()

finally:

# 关闭数据库连接

db.close()

运行结果告诉我们记录插入成功。

3. 如果你在使用 mysql-connector 连接的时候,系统报的错误为authentication plugin caching_sha2,这时你需要下载最新的版本更新来解决,点击这里进行更新。

总结

讲解了如何使用 Python 来操作 MySQL,这里我们使用的是官方提供的 mysql-connector,当然除了它之外,还有很多库可以进行选择。

在使用基于 DB API 规范的协议时,重点需要掌握 Connection 和 Cursor 这两个对象,Connection 就是对数据库的连接进行管理,而 Cursor 是对数据库的游标进行管理,通过它们,我们可以执行具体的 SQL 语句,以及处理复杂的数据。

用 Python 操作 MySQL,还有很多种姿势,mysql-connector 只是其中一种,实际上还有另外一种方式,就是采用 ORM 框架。ORM 的英文是 Object Relational Mapping,也就是采用对象关系映射的模式,使用这种模式可以将数据库中各种数据表之间的关系映射到程序中的对象。这种模式可以屏蔽底层的数据库的细节,不需要我们与复杂的 SQL 语句打交道,直接采用操作对象的形式操作就可以。

不过如果应用数据实体少,其实没有必要使用 ORM 框架,针对少量对象的管理,自己实现起来也很简单,比如本篇文章中我讲到的采用官方提供的 mysql-connector 驱动的方式来实现 CRUD。引入一个框架的学习成本很高,代码膨胀也很厉害,所以如果是相对简单的操作,完全可以自己动手来实现。

使用Python ORM框架来操作MySQL

在项目比较小的时候,我们可以直接使用 SQL 语句,通过 mysql-connector 完成与 MySQL 的交互,但是任何事物都有两面性,随着项目规模的增加,代码会越来越复杂,维护的成本也越来越高,这时 mysql-connector 就不够用了,我们需要更好的设计模式。Python 还有另一种方式可以与 MySQL 进行交互,这种方式采用的是 ORM 框架。

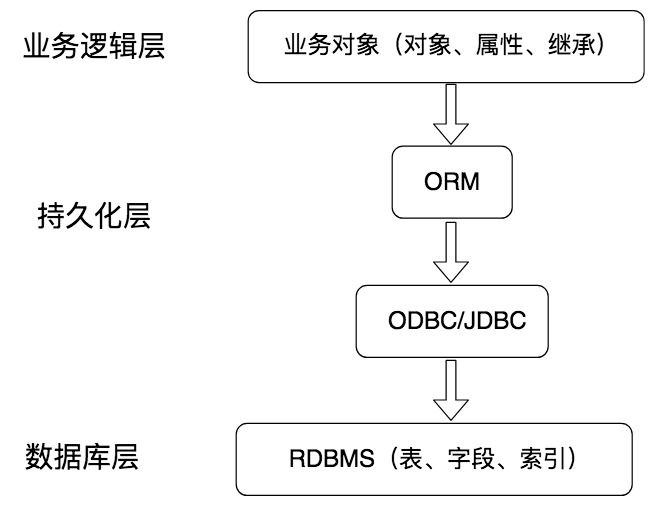

我们为什么要使用 ORM 框架?

持久化

如下图所示,持久化层在业务逻辑层和数据库层起到了衔接的作用,它可以将内存中的数据模型转化为存储模型,或者将存储模型转化为内存中的数据模型。

你可能会想到,我们在讲事务的 4 大特性 ACID 时,提到过持久性。你可以简单地理解为,持久性就是将对象数据永久存储在数据库中。通常我们将数据库的作用理解为永久存储,将内存理解为暂时存储。我们在程序的层面操作数据,其实都是把数据放到内存中进行处理,如果需要数据就会通过持久化层,从数据库中取数据;如果需要保存数据,就是将对象数据通过持久化层存储到数据库中。

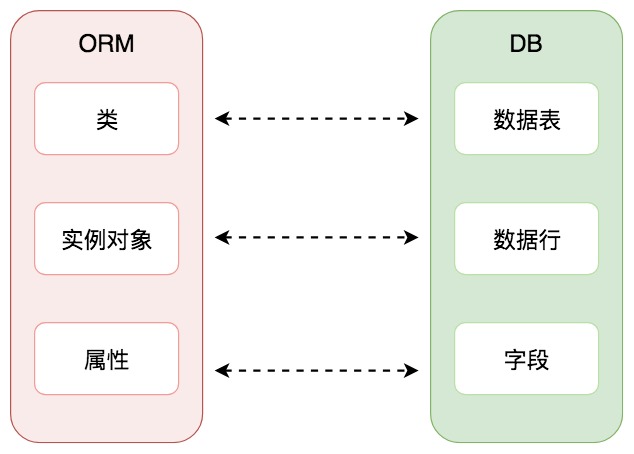

ORM 解决的是什么问题呢?

它提供了一种持久化模式,可以高效地对数据库进行访问。ORM 的英文是 Object Relation Mapping,中文叫对象关系映射。它是 RDBMS 和业务实体对象之间的一个映射,从图中你也能看到,它可以把底层的 RDBMS 封装成业务实体对象,提供给业务逻辑层使用。程序员往往关注业务逻辑层面,而不是底层数据库该如何访问,以及如何编写 SQL 语句获取数据等等。采用 ORM,就可以从数据库的设计层面转化成面向对象的思维。

随着项目规模的增大,在代码层编写 SQL 语句访问数据库会降低开发效率,也会提升维护成本,因此越来越多的开发人员会采用基于 ORM 的方式来操作数据库。这样做的好处就是一旦定义好了对象模型,就可以让它们简单可复用,从而不必关注底层的数据库访问细节,我们只要将注意力集中到业务逻辑层面就可以了。由此还可以带来另一点好处,那就是即便数据库本身进行了更换,在业务逻辑代码上也不会有大的调整。这是因为 ORM 抽象了数据的存取,同时也兼容多种 DBMS,我们不用关心底层采用的到底是哪种 DBMS,是 MySQL,SQL Server,PostgreSQL 还是 SQLite。

但没有一种模式是完美的,采用 ORM 当然也会付出一些代价,比如性能上的一些损失。面对一些复杂的数据查询,ORM 会显得力不从心。虽然可以实现功能,但相比于直接编写 SQL 查询语句来说,ORM 需要编写的代码量和花费的时间会比较多,这种情况下,直接编写 SQL 反而会更简单有效。

其实你也能看出来,没有一种方式是一劳永逸的,在实际工作中,我们需要根据需求选择适合的方式。

Python 中的 ORM 框架都有哪些

ORM 框架帮我们适配了各种 DBMS,同时我们也可以选择不同的 ORM 框架。如果你用 Python 的话,有三种主流的 ORM 框架。

第一个是 Django,它是 Python 的 WEB 应用开发框架,本身走大而全的方式。Django 采用了 MTV 的框架模式,包括了 Model(模型),View(视图)和 Template(模版)。Model 模型只是 Django 的一部分功能,我们可以通过它来实现数据库的增删改查操作。

一个 Model 映射到一个数据表,如下图所示:

从这张图上你能直观地看到,ORM 的作用就是建立了对象关系映射。模型的每个属性代表数据表中的一个字段,我们通过操作类实例对象,对数据表中的数据行进行增删改查等操作。

第二个是 SQLALchemy,它也是 Python 中常用的 ORM 框架之一。它提供了 SQL 工具包及 ORM 工具,如果你想用支持 ORM 和支持原生 SQL 两种方式的工具,那么 SQLALchemy 是很好的选择。另外 SQLALchemy 的社区更加活跃,这对项目实施会很有帮助。

第三个是 peewee,这是一个轻量级的 ORM 框架,简单易用。peewee 采用了 Model 类、Field 实例和 Model 实例来与数据库建立映射关系,从而完成面向对象的管理方式。使用起来方便,学习成本也低。

如何使用 SQLAlchemy 来操作 MySQL

下面我们来看下如何使用 SQLAlchemy 工具对 player 数据表进行增删改查,在使用前,你需要先安装相应的工具包:

pip install sqlalchemy

初始化数据库连接

from sqlalchemy import create_engine

# 初始化数据库连接,修改为你的数据库用户名和密码

engine = create_engine('mysql+mysqlconnector://root:password@localhost:3306/wucai')

create_engine 的使用方法类似我们在上篇文章中提到的 mysql.connector,都需要提供数据库 + 数据库连接框架,即对应的是mysql+mysqlconnector,后面的是用户名:密码@IP地址:端口号/数据库名称。

创建模型

我们已经创建了 player 数据表,这里需要创建相应的 player 模型。

# 定义 Player 对象:

class Player(Base):

# 表的名字:

__tablename__ = 'player'

# 表的结构:

player_id = Column(Integer, primary_key=True, autoincrement=True)

team_id = Column(Integer)

player_name = Column(String(255))

height = Column(Float(3,2))

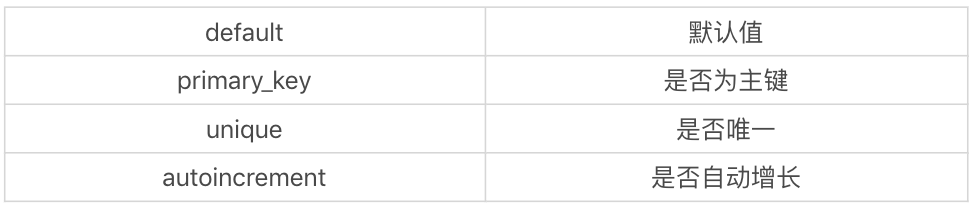

这里需要说明的是,__tablename__ 指明了模型对应的数据表名称,即 player 数据表。同时我们在 Player 模型中对采用的变量名进行定义,变量名需要和数据表中的字段名称保持一致,否则会找不到数据表中的字段。在 SQLAlchemy 中,我们采用 Column 对字段进行定义,常用的数据类型如下:

除了指定 Column 的数据类型以外,我们也可以指定 Column 的参数,这些参数可以帮我们对对象创建列约束:

这里需要说明的是,如果你使用相应的数据类型,那么需要提前在 SQLAlchemy 中进行引用,比如:

from sqlalchemy import Column, String, Integer, Float

对数据表进行增删改查

增加数据

假设我们想给 player 表增加一名新球员,姓名为“约翰·科林斯”,球队 ID 为 1003(即亚特兰大老鹰),身高为 2.08。代码如下:

# 创建 DBSession 类型:

DBSession = sessionmaker(bind=engine)

# 创建 session 对象:

session = DBSession()

# 创建 Player 对象:

new_player = Player(team_id = 1003, player_name = " 约翰 - 科林斯 ", height = 2.08)

# 添加到 session:

session.add(new_player)

# 提交即保存到数据库:

session.commit()

# 关闭 session:

session.close()

这里,我们首先需要初始化 DBSession,相当于创建一个数据库的会话实例 session。通过 session 来完成新球员的添加。对于新球员的数据,我们可以通过 Player 类来完成创建,在参数中指定相应的team_id, player_name, height即可。

然后把创建好的对象 new_player 添加到 session 中,提交到数据库即可完成添加数据的操作。

查询数据

添加完插入的新球员之后,我们可以查询下身高 ≥ 2.08m 的球员都有哪些,代码如下:

# 增加 to_dict() 方法到 Base 类中

def to_dict(self):

return {c.name: getattr(self, c.name, None)

for c in self.__table__.columns}

# 将对象可以转化为 dict 类型

Base.to_dict = to_dict

# 查询身高 >=2.08 的球员有哪些

rows = session.query(Player).filter(Player.height >= 2.08).all()

print([row.to_dict() for row in rows])

运行结果:

[{'player_id': 10003, 'team_id': 1001, 'player_name': '安德烈 - 德拉蒙德', 'height': Decimal('2.1100000000')}, {'player_id': 10004, 'team_id': 1001, 'player_name': '索恩 - 马克', 'height': Decimal('2.1600000000')}, {'player_id': 10009, 'team_id': 1001, 'player_name': '扎扎 - 帕楚里亚', 'height': Decimal('2.1100000000')}, {'player_id': 10010, 'team_id': 1001, 'player_name': '乔恩 - 洛伊尔', 'height': Decimal('2.0800000000')}, {'player_id': 10011, 'team_id': 1001, 'player_name': '布雷克 - 格里芬', 'height': Decimal('2.0800000000')}, {'player_id': 10015, 'team_id': 1001, 'player_name': '亨利 - 埃伦森', 'height': Decimal('2.1100000000')}, {'player_id': 10023, 'team_id': 1002, 'player_name': '多曼塔斯 - 萨博尼斯', 'height': Decimal('2.1100000000')}, {'player_id': 10024, 'team_id': 1002, 'player_name': '迈尔斯 - 特纳', 'height': Decimal('2.1100000000')}, {'player_id': 10032, 'team_id': 1002, 'player_name': 'TJ- 利夫', 'height': Decimal('2.0800000000')}, {'player_id': 10033, 'team_id': 1002, 'player_name': '凯尔 - 奥奎因', 'height': Decimal('2.0800000000')}, {'player_id': 10037, 'team_id': 1002, 'player_name': '伊凯·阿尼博古', 'height': Decimal('2.0800000000')}, {'player_id': 10038, 'team_id': 1003, 'player_name': '约翰 - 科林斯', 'height': Decimal('2.0800000000')}]

如果我们对整个数据行进行查询,采用的是session.query(Player),相当于使用的是 SELECT *。这时如果我们想要在 Python 中对 query 结果进行打印,可以对 Base 类增加to_dict()方法,相当于将对象转化成了 Python 的字典类型。

在进行查询的时候,我们使用的是 filter 方法,对应的是 SQL 中的 WHERE 条件查询。除此之外,filter 也支持多条件查询。

如果是 AND 的关系,比如我们想要查询身高 ≥ 2.08,同时身高 ≤ 2.10 的球员,可以写成下面这样:

rows = session.query(Player).filter(Player.height >=2.08, Player.height <=2.10).all()

如果是 OR 的关系,比如我们想要查询身高 ≥ 2.08,或者身高 ≤ 2.10 的球员,可以写成这样:

rows = session.query(Player).filter(or_(Player.height >=2.08, Player.height <=2.10)).all()

这里我们使用了 SQLAlchemy 的 or_ 操作符,在使用它之前你需要进行引入,即:from sqlalchemy import or_。

除了多条件查询,SQLAlchemy 也同样支持分组操作、排序和返回指定数量的结果。

比如我想要按照 team_id 进行分组,同时筛选分组后数据行数大于 5 的分组,并且按照分组后数据行数递增的顺序进行排序,显示 team_id 字段,以及每个分组的数据行数。那么代码如下:

from sqlalchemy import func

rows = session.query(Player.team_id, func.count(Player.player_id)).group_by(Player.team_id).having(func.count(Player.player_id)>5).order_by(func.count(Player.player_id).asc()).all()

print(rows)

运行结果:

[(1001, 20), (1002, 17)]

这里有几点需要注意:

- 我们把需要显示的字段 Player.team_id, func.count(Player.player_id) 作为 query 的参数,其中我们需要用到 sqlalchemy 的 func 类,它提供了各种聚集函数,比如 func.count 函数。

- 在 query() 后面使用了 group_by() 进行分组,参数设置为 Player.team_id 字段,再使用 having 对分组条件进行筛选,参数为

func.count(Player.player_id)>5。 - 使用 order_by 进行排序,参数为

func.count(Player.player_id).asc(),也就是按照分组后的数据行数递增的顺序进行排序,最后使用.all() 方法需要返回全部的数据。

你能看到 SQLAlchemy 使用的规则和使用 SELECT 语句的规则差不多,只是封装到了类中作为方法进行调用。

删除数据

如果我们想要删除某些数据,需要先进行查询,然后再从 session 中把这些数据删除掉。

比如我们想要删除姓名为约翰·科林斯的球员,首先我们需要进行查询,然后从 session 对象中进行删除,最后进行 commit 提交,代码如下:

row = session.query(Player).filter(Player.player_name=='约翰 - 科林斯').first()

session.delete(row)

session.commit()

session.close()

需要说明的是,判断球员姓名是否为约翰·科林斯,这里需要使用(==)。

同样,如果我们想要修改某条数据,也需要进行查询,然后再进行修改。比如我想把球员索恩·马克的身高改成 2.17,那么执行完之后直接对 session 对象进行 commit 操作,代码如下:

row = session.query(Player).filter(Player.player_name=='索恩 - 马克').first()

row.height = 2.17

session.commit()

session.close()

总结

使用 SQLAlalchemy 对 MySQL 进行了操作,你能看到这些实现并不复杂,只是需要事先掌握一些使用方法,尤其是如何创建 seesion 对象,以及如何通过 session 对象来完成对数据的增删改查等操作。

基础篇总结

关于各种 DBMS 的介绍

答疑 1

“列式数据库是将数据按照列存储到数据库中,这样做的好处是可以大量降低系统的 I/O”,可以解释一些“降低系统 I/O”是什么意思吗?

解答

行式存储是把一行的数据都串起来进行存储,然后再存储下一行。同样,列式存储是把一列的数据都串起来进行存储,然后再存储下一列。这样做的话,相邻数据的数据类型都是一样的,更容易压缩,压缩之后就自然降低了 I/O。

我们还需要从数据处理的需求出发,去理解行式存储和列式存储。数据处理可以分为 OLTP(联机事务处理)和 OLAP(联机分析处理)两大类。

OLTP 一般用于处理客户的事务和进行查询,需要随时对数据表中的记录进行增删改查,对实时性要求高。

OLAP 一般用于市场的数据分析,通常数据量大,需要进行复杂的分析操作,可以对大量历史数据进行汇总和分析,对实时性要求不高。

那么对于 OLTP 来说,由于随时需要对数据记录进行增删改查,更适合采用行式存储,因为一行数据的写入会同时修改多个列。传统的 RDBMS 都属于行式存储,比如 Oracle、SQL Server 和 MySQL 等。

对于 OLAP 来说,由于需要对大量历史数据进行汇总和分析,则适合采用列式存储,这样的话汇总数据会非常快,但是对于插入(INSERT)和更新(UPDATE)会比较麻烦,相比于行式存储性能会差不少。

所以说列式存储适合大批量数据查询,可以降低 I/O,但如果对实时性要求高,则更适合行式存储。

关于查询优化

答疑 1

在 MySQL 中统计数据表的行数,可以使用三种方式:SELECT COUNT(*)、SELECT COUNT(1)和SELECT COUNT(具体字段),使用这三者之间的查询效率是怎样的?之前看到说是:SELECT COUNT(*)> SELECT COUNT(1)> SELECT COUNT(具体字段)。

解答

在 MySQL InnoDB 存储引擎中,COUNT(*)和COUNT(1)都是对所有结果进行COUNT。如果有 WHERE 子句,则是对所有符合筛选条件的数据行进行统计;如果没有 WHERE 子句,则是对数据表的数据行数进行统计。

因此COUNT(*)和COUNT(1)本质上并没有区别,执行的复杂度都是O(N),也就是采用全表扫描,进行循环 + 计数的方式进行统计。

如果是 MySQL MyISAM 存储引擎,统计数据表的行数只需要O(1)的复杂度,这是因为每张 MyISAM 的数据表都有一个 meta 信息存储了row_count值,而一致性则由表级锁来保证。因为 InnoDB 支持事务,采用行级锁和 MVCC 机制,所以无法像 MyISAM 一样,只维护一个row_count变量,因此需要采用扫描全表,进行循环 + 计数的方式来完成统计。

需要注意的是,在实际执行中,COUNT(*)和COUNT(1)的执行时间可能略有差别,不过你还是可以把它俩的执行效率看成是相等的。

另外在 InnoDB 引擎中,如果采用COUNT(*)和COUNT(1)来统计数据行数,要尽量采用二级索引。因为主键采用的索引是聚簇索引,聚簇索引包含的信息多,明显会大于二级索引(非聚簇索引)。对于COUNT(*)和COUNT(1)来说,它们不需要查找具体的行,只是统计行数,系统会自动采用占用空间更小的二级索引来进行统计。

然而如果想要查找具体的行,那么采用主键索引的效率更高。如果有多个二级索引,会使用 key_len 小的二级索引进行扫描。当没有二级索引的时候,才会采用主键索引来进行统计。

这里总结一下:

- 一般情况下,三者执行的效率为

COUNT(*)=COUNT(1)>COUNT(字段)。我们尽量使用COUNT(*),当然如果你要统计的是某个字段的非空数据行数,则另当别论,毕竟比较执行效率的前提是结果一样才可以。 - 如果要统计

COUNT(*),尽量在数据表上建立二级索引,系统会自动采用key_len小的二级索引进行扫描,这样当我们使用SELECT COUNT(*)的时候效率就会提升,有时候可以提升几倍甚至更高。

答疑 2

在 MySQL 中,LIMIT关键词是最后执行的,如果可以确定只有一条结果,那么就起不到查询优化的效果了吧,因为LIMIT是对最后的结果集过滤,如果结果集本来就只有一条,那就没有什么用了。

解答

如果你可以确定结果集只有一条,那么加上LIMIT 1的时候,当找到一条结果的时候就不会继续扫描了,这样会加快查询速度。这里指的查询优化针对的是会扫描全表的 SQL 语句,如果数据表已经对字段建立了唯一索引,那么可以通过索引进行查询,不会全表扫描的话,就不需要加上LIMIT 1了。

关于通配符的解释

关于查询语句中通配符的使用理解,我举了一个查询英雄名除了第一个字以外,包含“太”字的英雄都有谁的例子,使用的 SQL 语句是:

SQL> SELECT name FROM heros WHERE name LIKE '_% 太 %'

(_)匹配任意一个字符,(%) 匹配大于等于 0 个任意字符。

所以通配符'_%太%'说明在第一个字符之后需要有“太”字,这里就不能匹配上“太乙真人”,但是可以匹配上“东皇太一”。如果数据表中有“太乙真人太太”,那么结果集中也可以匹配到。

另外,单独的LIKE '%'无法查出 NULL 值,比如:SELECT * FROM heros WHERE role_assist LIKE '%'。

答疑 4

可以理解在 WHERE 条件字段上加索引,但是为什么在 ORDER BY 字段上还要加索引呢?这个时候已经通过 WHERE 条件过滤得到了数据,已经不需要再筛选过滤数据了,只需要根据字段排序就好了。

解答

在 MySQL 中,支持两种排序方式,分别是 FileSort 和 Index 排序。在 Index 排序中,索引可以保证数据的有序性,不需要再进行排序,效率更高。而 FileSort 排序则一般在内存中进行排序,占用 CPU 较多。如果待排结果较大,会产生临时文件 I/O 到磁盘进行排序的情况,效率较低。

所以使用 ORDER BY 子句时,应该尽量使用 Index 排序,避免使用 FileSort 排序。当然你可以使用 explain 来查看执行计划,看下优化器是否采用索引进行排序。

优化建议:

- SQL 中,可以在 WHERE 子句和 ORDER BY 子句中使用索引,目的是在 WHERE 子句中避免全表扫描,在 ORDER BY 子句避免使用 FileSort 排序。当然,某些情况下全表扫描,或者 FileSort 排序不一定比索引慢。但总的来说,我们还是要避免,以提高查询效率。一般情况下,优化器会帮我们进行更好的选择,当然我们也需要建立合理的索引。

- 尽量使用 Index 完成 ORDER BY 排序。如果 WHERE 和 ORDER BY 后面是相同的列就使用单索引列;如果不同就使用联合索引。

- 无法使用 Index 时,需要对 FileSort 方式进行调优。

答疑 5

ORDER BY 是对分的组排序还是对分组中的记录排序呢?

解答

ORDER BY 就是对记录进行排序。如果你在 ORDER BY 前面用到了 GROUP BY,实际上这是一种分组的聚合方式,已经把一组的数据聚合成为了一条记录,再进行排序的时候,相当于对分的组进行了排序。

答疑 6

请问下关于 SELECT 语句内部的执行步骤。

解答

一条完整的 SELECT 语句内部的执行顺序是这样的:

- FROM 子句组装数据(包括通过 ON 进行连接);

- WHERE 子句进行条件筛选;

- GROUP BY 分组 ;

- 使用聚集函数进行计算;

- HAVING 筛选分组;

- 计算所有的表达式;

- SELECT 的字段;

- ORDER BY 排序;

- LIMIT 筛选。

答疑 7

不太理解哪种情况下应该使用 EXISTS,哪种情况应该用 IN。选择的标准是看能否使用表的索引吗?

解答

索引是个前提,其实选择与否还是要看表的大小。你可以将选择的标准理解为小表驱动大表。在这种方式下效率是最高的。

比如下面这样:

SELECT * FROM A WHERE cc IN (SELECT cc FROM B)

SELECT * FROM A WHERE EXISTS (SELECT cc FROM B WHERE B.cc=A.cc)

当 A 小于 B 时,用 EXISTS。因为 EXISTS 的实现,相当于外表循环,实现的逻辑类似于:

for i in A

for j in B

if j.cc == i.cc then ...

当 B 小于 A 时用 IN,因为实现的逻辑类似于:

for i in B

for j in A

if j.cc == i.cc then ...

哪个表小就用哪个表来驱动,A 表小就用 EXISTS,B 表小就用 IN。

关于存储过程

答疑 1

在使用存储过程声明变量时,都支持哪些数据类型呢?

解答

不同的 DBMS 对数据类型的定义不同,你需要查询相关的 DBMS 文档。以 MySQL 为例,常见的数据类型可以分成三类,分别是数值类型、字符串类型和日期/时间类型。

答疑 2

“IN 参数必须在调用存储过程时指定”的含义是什么?我查询了 MySQL 的存储过程定义,可以不包含 IN 参数。当存储过程的定义语句里有 IN 参数时,存储过程的语句中必须用到这个参数吗?

解答

如果存储过程定义了 IN 参数,就需要在调用的时候传入。当然在定义存储过程的时候,如果不指定参数类型,就默认是 IN 类型的参数。因为 IN 参数在存储过程中是默认值,可以省略不写。比如下面两种定义方式都是一样的:

CREATE PROCEDURE `add_num`(IN n INT)

CREATE PROCEDURE `add_num`(n INT)

在存储过程中的语句里,不一定要用到 IN 参数,只是在调用的时候需要传入这个。另外 IN 参数在存储过程中进行了修改,也不会进行返回的。如果想要返回参数,需要使用 OUT,或者 INOUT 参数类型。

关于事务处理

答疑 1

如果INSERT INTO test SELECT '关羽';之后没有执行 COMMIT,结果应该是空。但是我执行出来的结果是'关羽',为什么 ROLLBACK 没有全部回滚?

代码如下:

CREATE TABLE test(name varchar(255), PRIMARY KEY (name)) ENGINE=InnoDB;

BEGIN;

INSERT INTO test SELECT '关羽';

BEGIN;

INSERT INTO test SELECT '张飞';

INSERT INTO test SELECT '张飞';

ROLLBACK;

SELECT * FROM test;

解答

先解释下连续 BEGIN 的情况。

在 MySQL 中 BEGIN 用于开启事务,如果是连续 BEGIN,当开启了第一个事务,还没有进行 COMMIT 提交时,会直接进行第二个事务的 BEGIN,这时数据库会隐式地 COMMIT 第一个事务,然后再进入到第二个事务。

为什么 ROLLBACK 没有全部回滚呢?

因为 ROLLBACK 是针对当前事务的,在 BEGIN 之后已经开启了第二个事务,当遇到 ROLLBACK 的时候,第二个事务都进行了回滚,也就得到了第一个事务执行之后的结果即“关羽”。

关于事务的 ACID,以及我们使用 COMMIT 和 ROLLBACK 来控制事务的时候,有一个容易出错的地方。

在一个事务的执行过程中可能会失败。遇到失败的时候是进行回滚,还是将事务执行过程中已经成功操作的来进行提交,这个逻辑是需要开发者自己来控制的。

这里开发者可以决定,如果遇到了小错误是直接忽略,提交事务,还是遇到任何错误都进行回滚。如果我们强行进行 COMMIT,数据库会将这个事务中成功的操作进行提交,它会认为你觉得已经是 ACID 了(就是你认为可以做 COMMIT 了,即使遇到了一些小问题也是可以忽略的)。