什么是负载均衡:

当一台服务器的单位时间内的访问量越大时,服务器压力就越大,大到超过自身承受能力时,服务器就会崩溃。为了避免服务器崩溃,让用户有更好的体验,通过负载均衡的方式来分担服务器压力。

我们可以建立很多很多服务器,组成一个服务器集群,当用户访问网站时,先访问一个中间服务器,在让这个中间服务器在服务器集群中选择一个压力较小的服务器,然后就该访问请求引入该服务器。如此以来,用户的每次访问,都会保证服务器集群中的每个服务器压力趋于平衡,分担于服务器压力,避免服务器崩溃情况。

案例

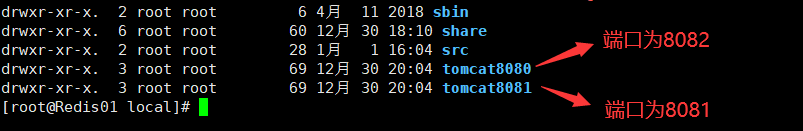

步骤一:准备两个Tomcat 一个端口为8081,另一个端口为8082;

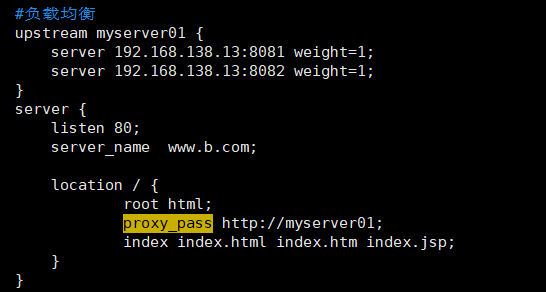

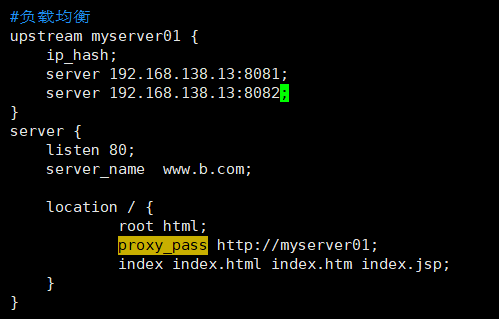

步骤二:配置nginx.conf文件

步骤三:启动Tomcat和nginx

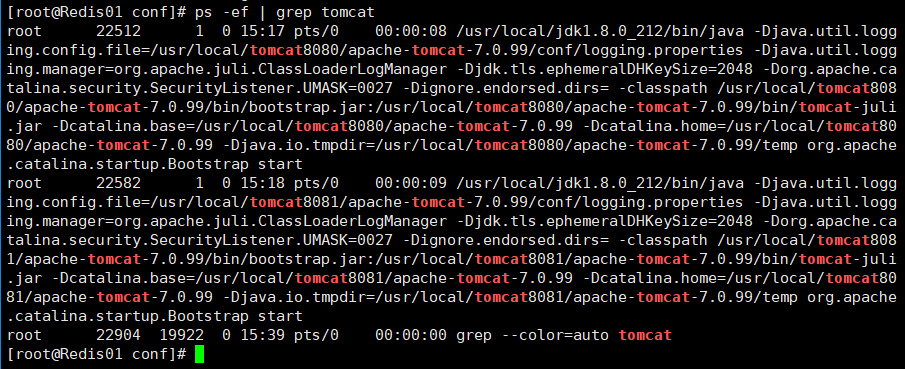

启动Tomcat:这里需要启动两次Tomcat,一次端口为8082,一次端口为8081

进入Tomcat文件下的bin目录

使用【./startup.sh】 命令启动

启动后可使用【ps -ef | grep tomcat 】命令查看当前Tomcat的进程

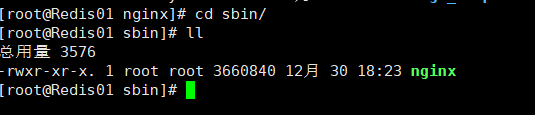

启动nginx:

进入nginx文件下的sbin目录

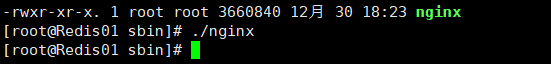

使用【./nginx】命令启动nginx

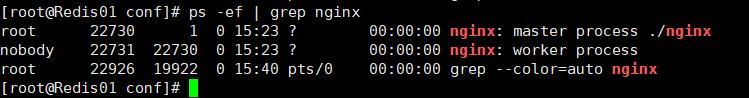

使用【ps -ef | grep nginx】命令查看当前nginx进程

实现效果:默认的负载均衡采用轮询机制的,每个请求按时间顺序逐一分配到不同的后端服务器上,如果后端服务器down掉,能自动剔除;按照http://www.b.com访问页面。

nginx实现负载均衡的方式

1.轮询

每个请求按时间顺序逐一分配到不同的后端服务器上,如果后端服务器down掉,能自动剔除;

2.权重(weight)

weight代表权,重默认为1,权重越高被分配的客户端越多;

指定轮询几率,权重和访问比率成正比,用于后端服务性能不均的请求下。

3.ip_hash

每个请求按访问IP的hash结果分配,这样每个访客固定访问一个后端服务器,可以解决session的问题;

4.第三方(fair)

按后端服务器的响应时间来分配请求,响应时间短的优先分配;