GitHub:https://github.com/ApolloAuto/apollo

1. 关于Apollo的数据:Apollo的数据会如何开放?

自动驾驶数据将包括具有高分辨率图像和像素级别标注的 RGB 视频,具有场景级语义分割的密集三维点云、基于双目立体视觉的视频和全景图像。数据集中提供的图像为通过采集系统每米采集一帧的方式采集,分辨率为 3384 x 2710。

百度数据采集车是配备了高分辨率相机和 Riegl 采集系统的中型 SUV。采集场景包括不同城市的不同交通状况的道路行驶数据,平均每张图中移动障碍物的数量从几十到上百不等。(例如,单张图像中多达 162 辆交通工具或 80 名行人)

除了采集数据之外,百度还会用自己的视觉感知算法给每一帧画面中的像素做相应的语义分割。当前支持的语义分割种类已经达到了 25 项,包括车辆、行人、自行车、摩托车、道路、交通标识等等。这样的分割有助于开发者可以在这个数据集中直接训练以及验证自己的自动驾驶算法。换言之这套数据集是可以让开发者直接拿来就用的,而不用再做初始的数据解析。

2.百度释放出无人驾驶资料集ApolloScape.

4.Apollo多传感器融合定位模块

多传感器融合定位

定位技术横跨好几个专业,包括测绘、导航、计算机视觉知识、以及点云处理的知识。

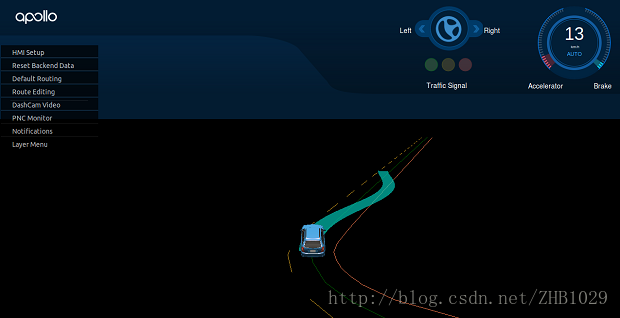

Apollo2.0的多传感器融合定位模块的框架如下图所示:

-

左边列出了定位模块依赖的硬件以及数据,包括惯性测量单元IMU、车端天线、基站、激光雷达、以及定位地图;

-

中间是GNSS定位以及激光点云定位模块,GNSS定位输出位置及速度信息,点云定位输出位置及航向角信息;

-

右边是融合框架,融合框架包括两部分:惯性导航解算、Kalman滤波;

-

融合定位的结果会反过来用于GNSS定位和点云定位的预测;

-

融合定位的输出是一个6-dof的位置和姿态,以及协方差矩阵。

4. 百度Apollo一站式部署-GitHub

代码地址:

git clone https://github.com/ApolloAuto/apollo.git使用ubuntu、ROS

5. 使用TX2搞定Apollo平台。

6.论文:Robust and Precise Vehicle Localization based on Multi-sensor Fusion in Diverse City Scenes。

7.浅析/深度解析Apollo技术框架,配图精美,可以看看。

终于把火狐标签页全部给消灭了