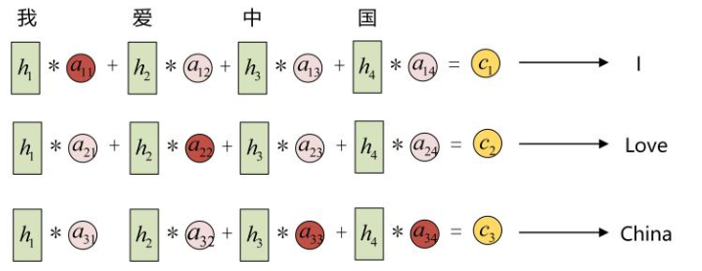

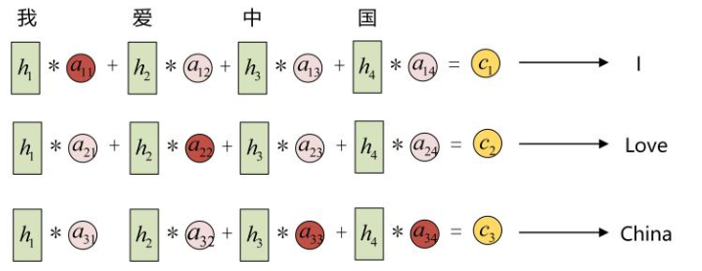

Attention机制:

人看东西的启发

所谓注意力,就是计算相似度

a是权重,即相似度

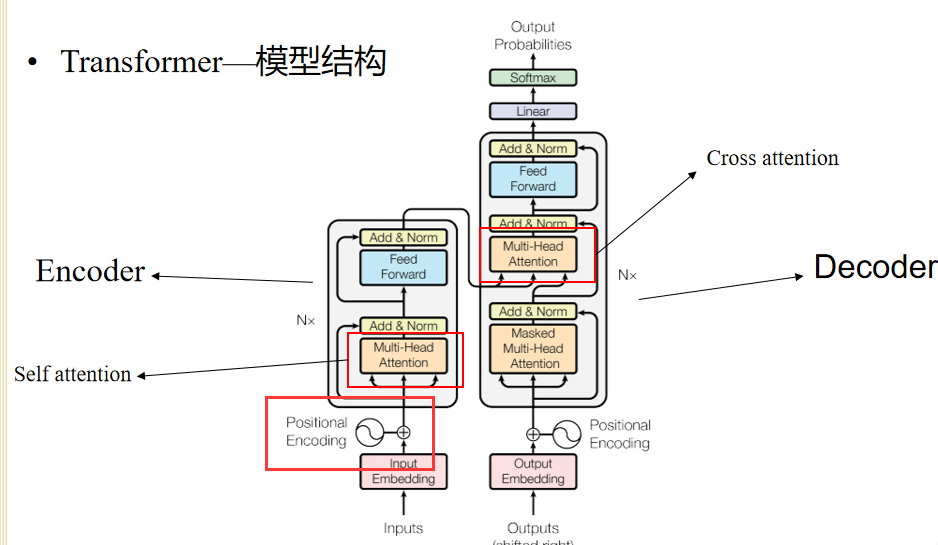

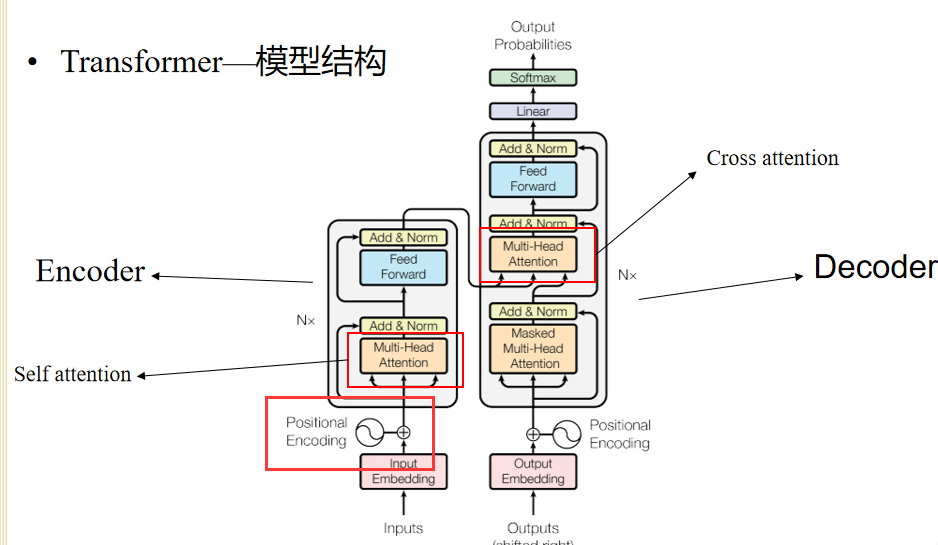

The Transformer

位置是有相对关系的

残差,梯度消失

多重注意力是自己和自己计算的

https://www.jianshu.com/p/ef41302edeef

自注意力怎么计算

Qn和Kn+1做点积

遮盖预测

BERT

初始化

微调:在不太大的训练集上进行

预训练,再进行微调的

Attention机制:

人看东西的启发

所谓注意力,就是计算相似度

a是权重,即相似度

The Transformer

位置是有相对关系的

残差,梯度消失

多重注意力是自己和自己计算的

https://www.jianshu.com/p/ef41302edeef

自注意力怎么计算

Qn和Kn+1做点积

遮盖预测

BERT

初始化

微调:在不太大的训练集上进行

预训练,再进行微调的