1.学习链接

https://www.bilibili.com/video/BV1yD4y1U73C?p=10

2.简介

Spark集群的高可用机制用于解决master出现单点失败的情况。解决方法:配置两个master主机,当一个挂掉的时候将所有任务提交给另一个主机。

3.配置过程

3.1停止整个集群

进入spark文件下的sbin目录中,使用stop-all.sh命令停止整个集群

3.2修改配置文件

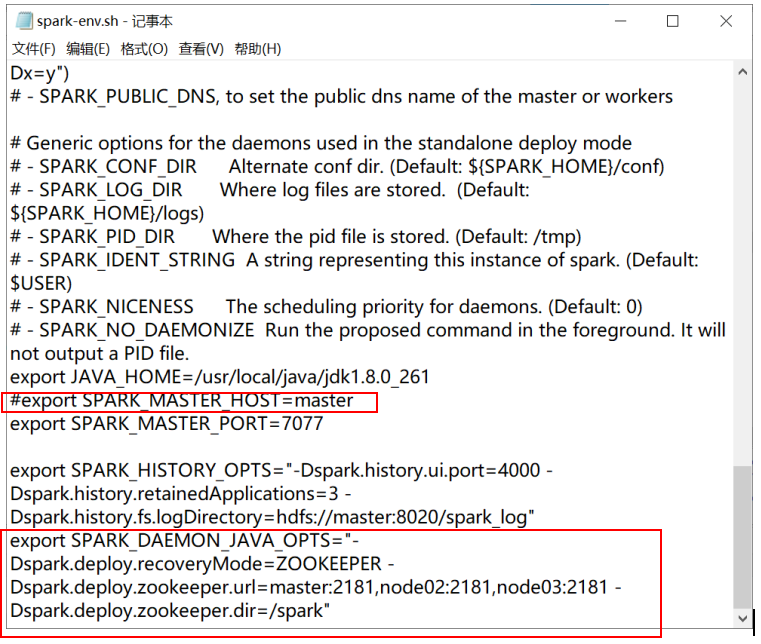

修改spark/conf/spark-env.sh

将第一个红色的框中的内容注释掉,再添加第二个框中的内容

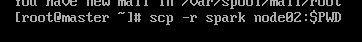

3.3分发到整个集群

进入到spark安装目录的上一级,执行以下两个操作

![]()

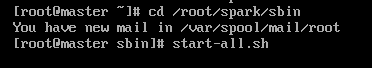

3.4启动整个集群

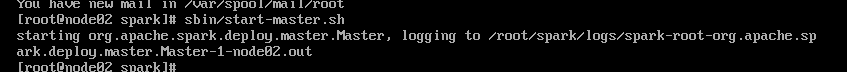

在master上启动一个集群,在node02上在启动集群,两个主机的状态一个为ALIVE另一个为STANDBY

master:

node02:

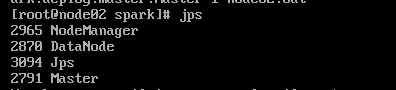

3.5查看启动状态