Transformer Tracking

2021-04-08 21:45:41

Paper: https://arxiv.org/pdf/2103.15436.pdf

Code: https://github.com/chenxin-dlut/TransT

如图所示,本文提出了一种新的 matching 方式,也可以说是一种特征融合模式,即:利用 Transformer 模型对 template feature 和 search region 进行特征融合。然后再将融合后的特征进行多分枝任务的预测,即:在 Siamese 框架下进行 Regression 和 Classification。核心部分包含三个主要模块:特征提取模块,特征融合模块,以及预测模块。

特征提取模块:利用修改后的 ResNet50 作为骨干网络提取 target template 和 search region 的特征;

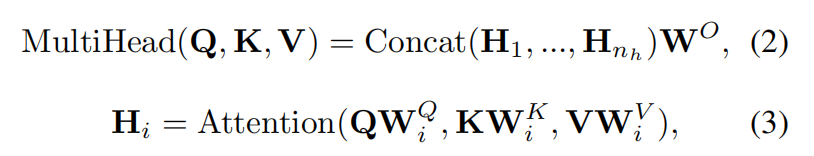

特征融合模块:作者先用两个 1*1 的卷积层进行降维操作,将 1024-D 的特征图降维成 256-D。然后沿着空间维度进行 reshape,得到 d*HW 的特征向量的集合。这两组特征分别输入到特征融合模块,即:ECA 和 CFA 模块中。

预测头网络(Prediction Head Network):这里采用的是 anchor-free 的跟踪分支,即:一个是 classification branch,一个是 regression branch,每一个分支均是 3层维度为 d 的感知层,以及ReLU 激活函数。

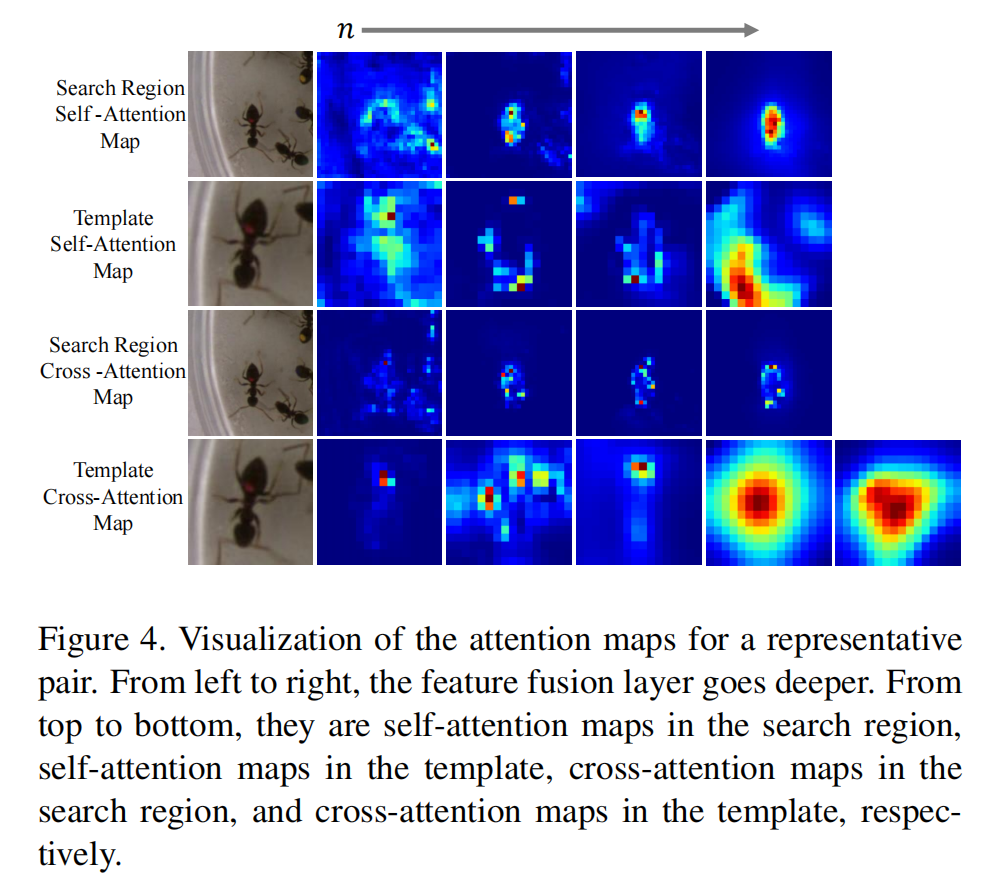

接下来,核心就是特征融合模块的具体操作:

1. ECA(Ego-Context Augmentation) 和 CFA(Cross-Feature Augmentation Modules):

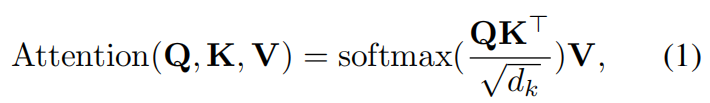

Multi-head Attention:

这里简单介绍了 self-attention 的机制

其中,dk 是 key 的维度。

Ego-Context Augment (ECA):

如上图所示,给定输入 X,作者对这个 feature map 采用了 sine function 来产生位置编码。然后将其和输入 X 进行相加,最终 ECA 模块可以总结为:

![]()

其中,Px 是空间位置编码,XEC 是 ECA 的输出。

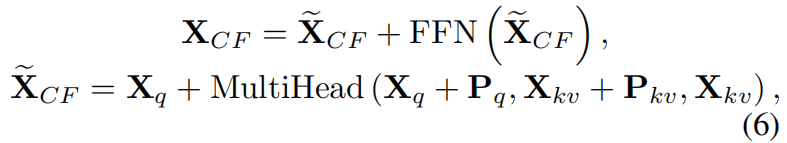

Cross-Feature Augmentation (CFA) :

上述 ECA 是对单独的 feature map 进行 attention 处理。作者这里也考虑了 template 和 search region 之间信息的融合,提出了 Cross-Feature Augmentation 模块。类似 ECA,CFA中也引入了空间位置编码。此外,FFN 模块被用于增强模型的拟合能力。

![]()

因此,CFA机制可以总结为

Differences with the original Transformer:

作者引入的 cross-attention 操作使得 Transformer 模型更加适用于跟踪的任务。

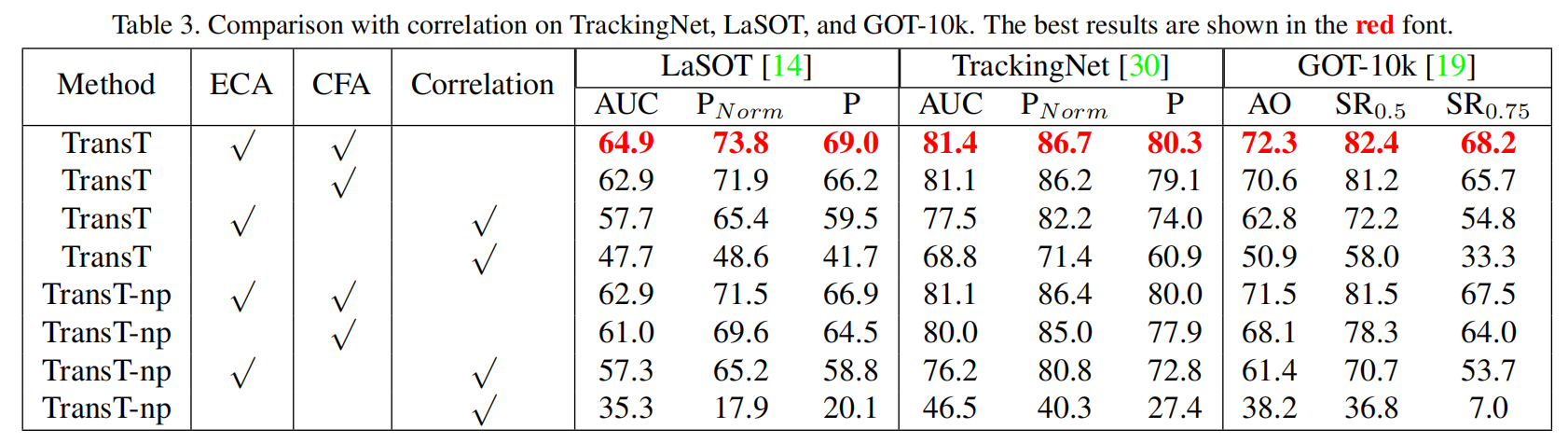

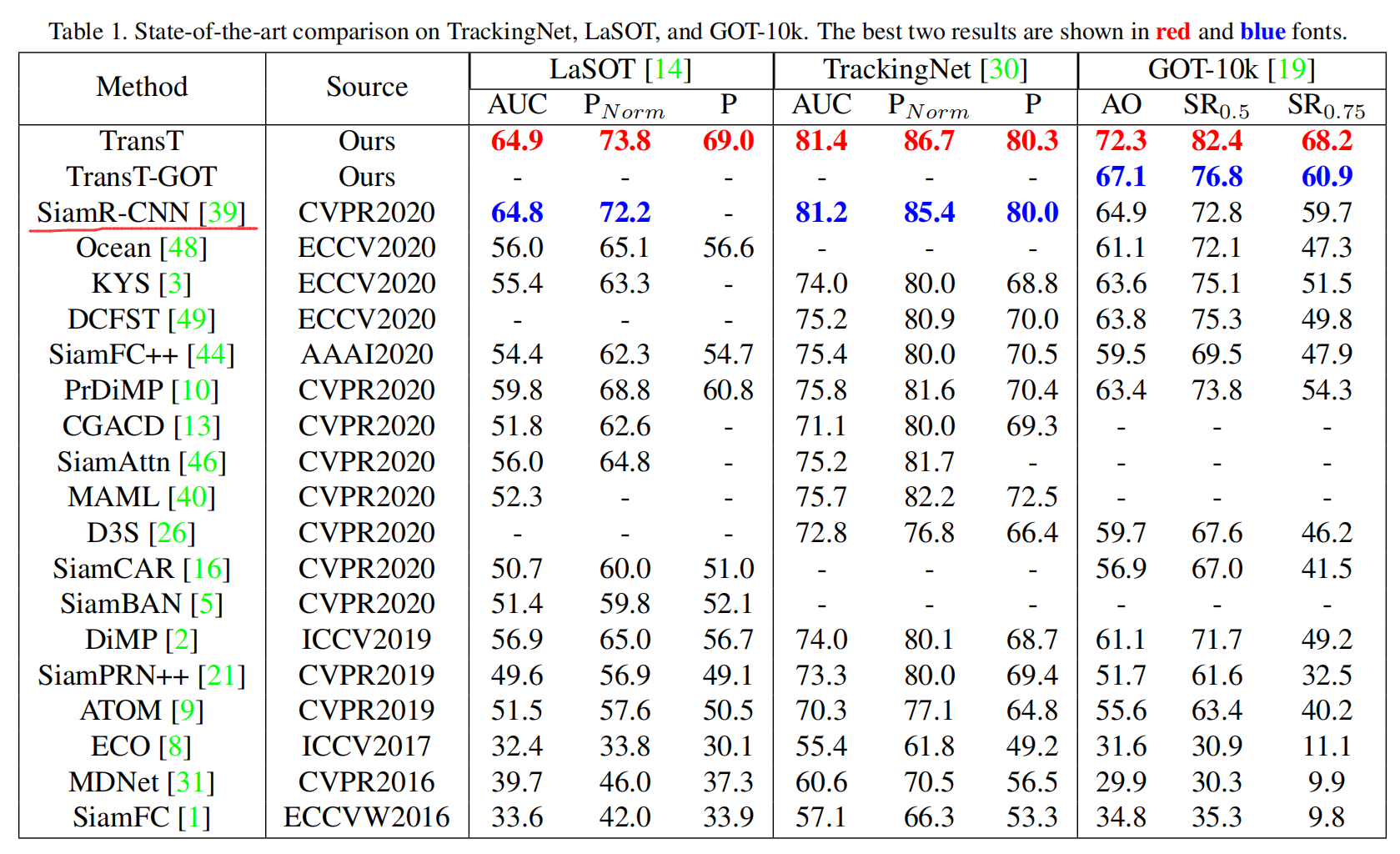

2. Experimental Results:

==