Adversarial Self-Defense for Cycle-Consistent GANs

2020-04-28 17:11:38

Project page: http://ai.bu.edu/selfadv/

1. Background and Motivation:

2. Self-Adversarial Attack in Cyclic Models:

在 unpaired 图像转换领域,给定图像 x 和 y,有两个判别器 Da 和 Db,那么循环一致性损失可以构造为:

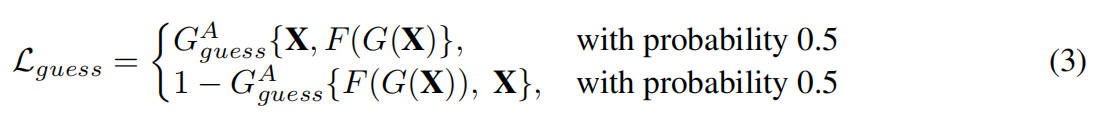

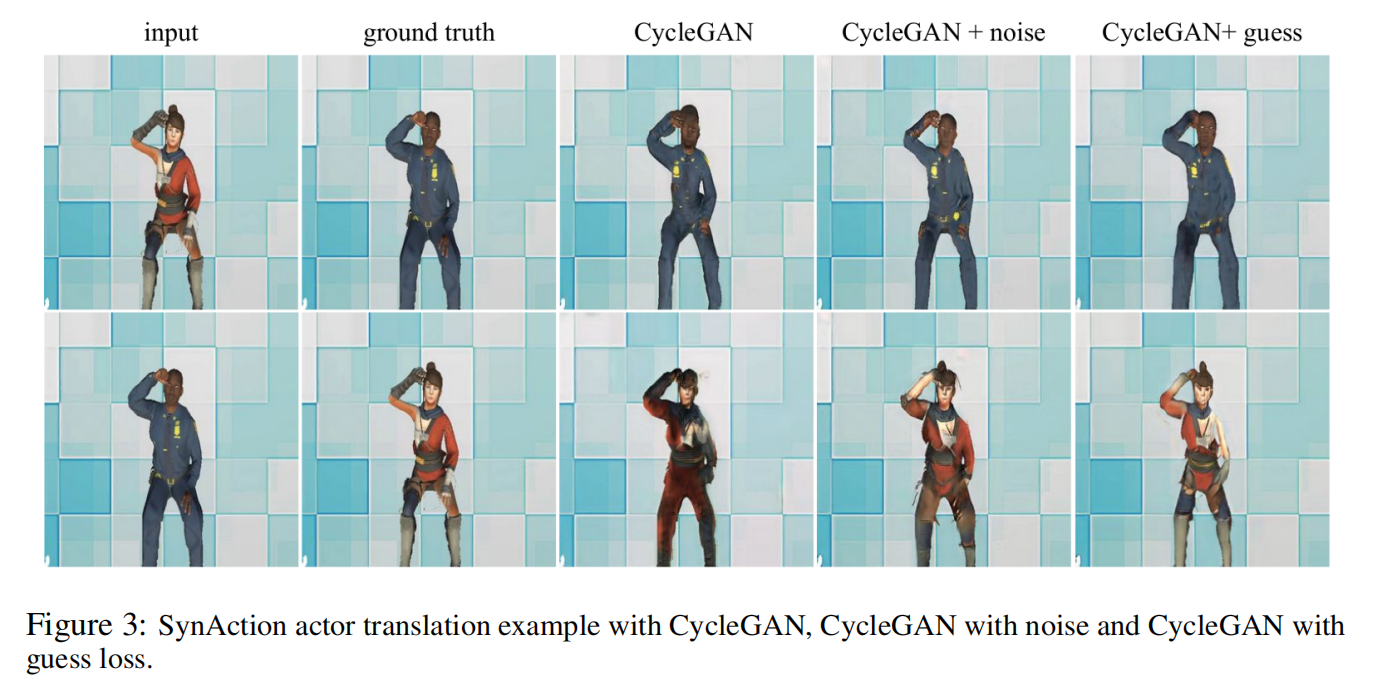

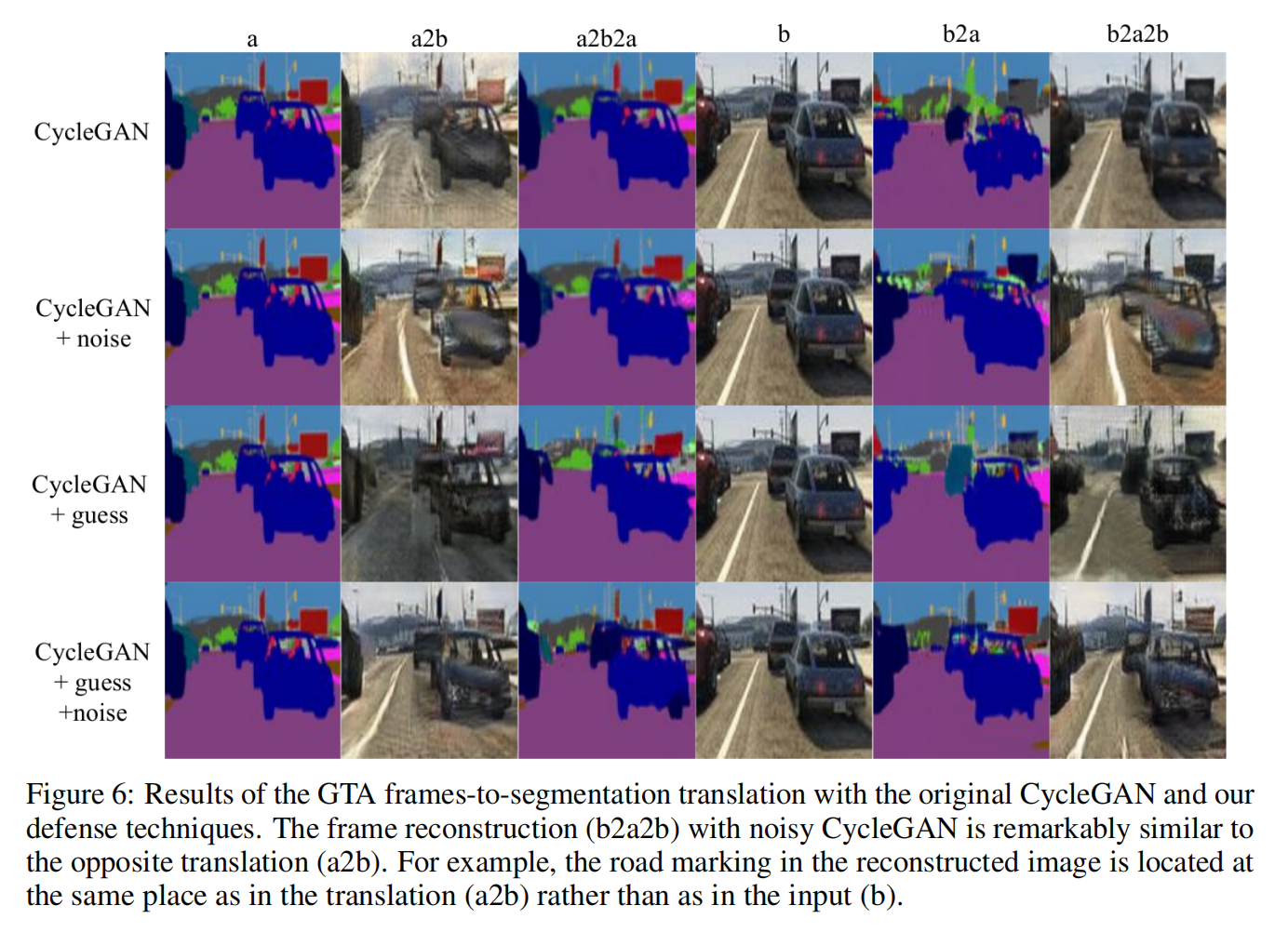

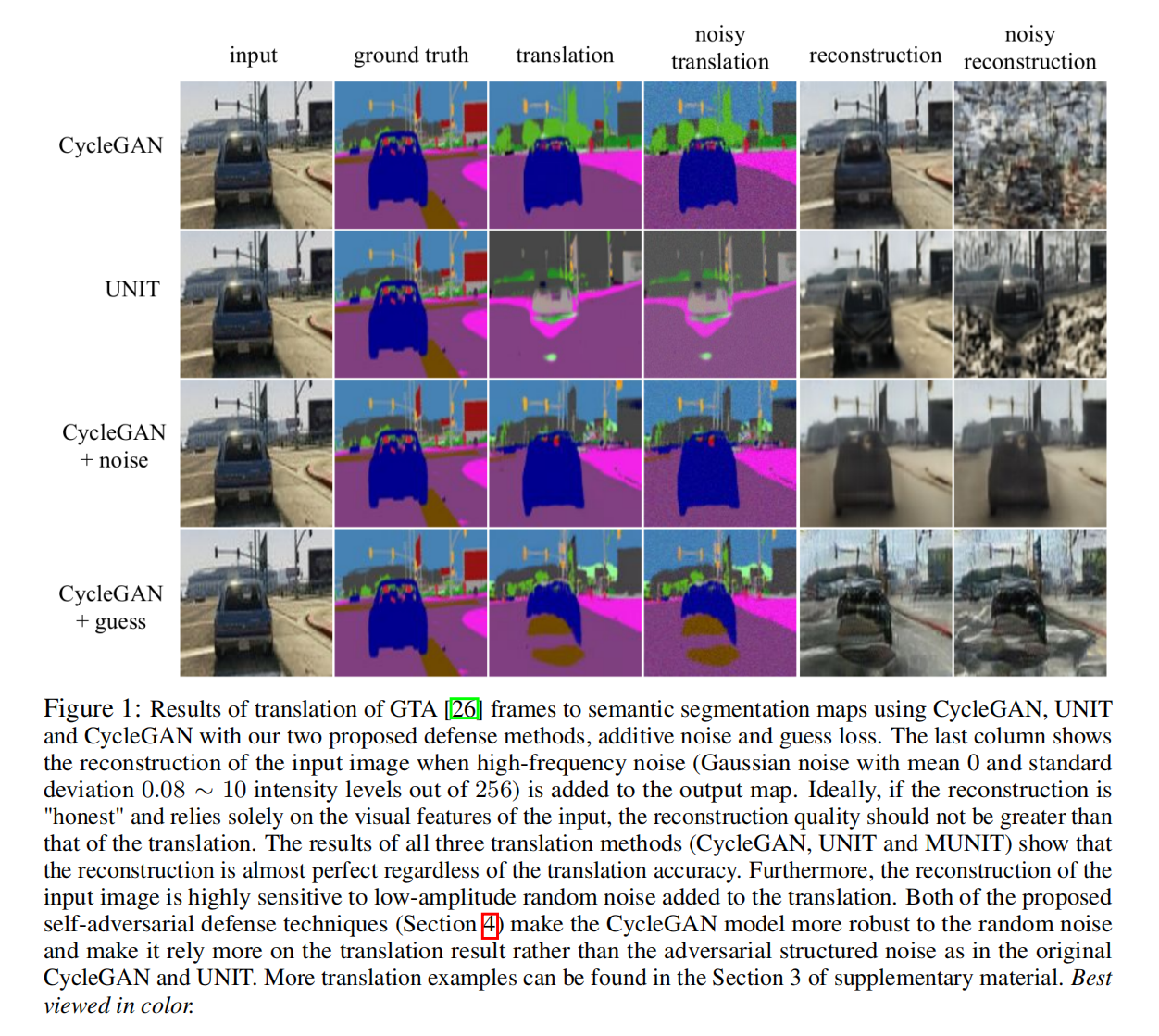

但是,当 domain A 中的数据远远超过 B 的时候,这个转换的性质就变了,不再是 1-1 了,而是 many-to-one 了。那么,产生器 G 仍然会强迫完美的执行输入的重构,即使输入图像的一些信息已经丢失了。这种现象被描述为 一种 adversarial attack,实际上,任何给定的图像,都是可以产生这样结构化的噪声,使其可以重构出目标图像。实际上, CycleGAN 和其他模型,利用 cycle-consistency loss 添加了一个非常 low-amplitude signal 到 translation $hat{y}$ 上,而人眼几乎看不到。添加这么一个特定的信号足够重构出 图像 x 不应该出现在 $hat{y}$ 上面的信息。这使得结合 cycle-consistency loss 的方法对 low-amplitude high-frequency noise 非常敏感。因为 noise 可以破坏 hidden signal。此外,这种行为也使得 model 收敛到一个 non-optimal solution 或者不收敛。通过添加结构化的噪声,该模型欺骗,以使得最小化重构误差,而不是学习正确的映射。

3. Defence techniques:

3.1. Adversarial training with noise:

相比较于公式 1 来说,其实就是加了个 noise,

其中,红色部分是 high-frequency perturbation function。

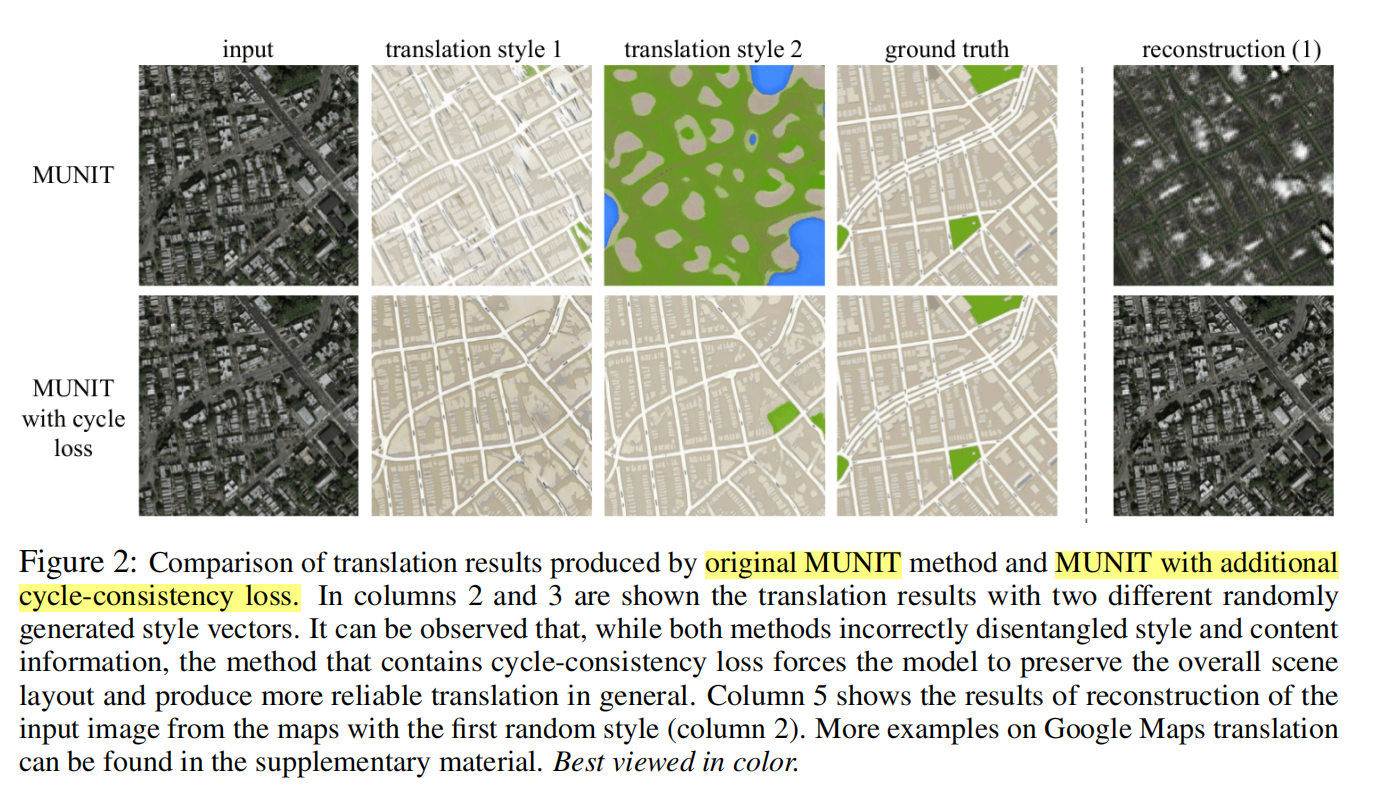

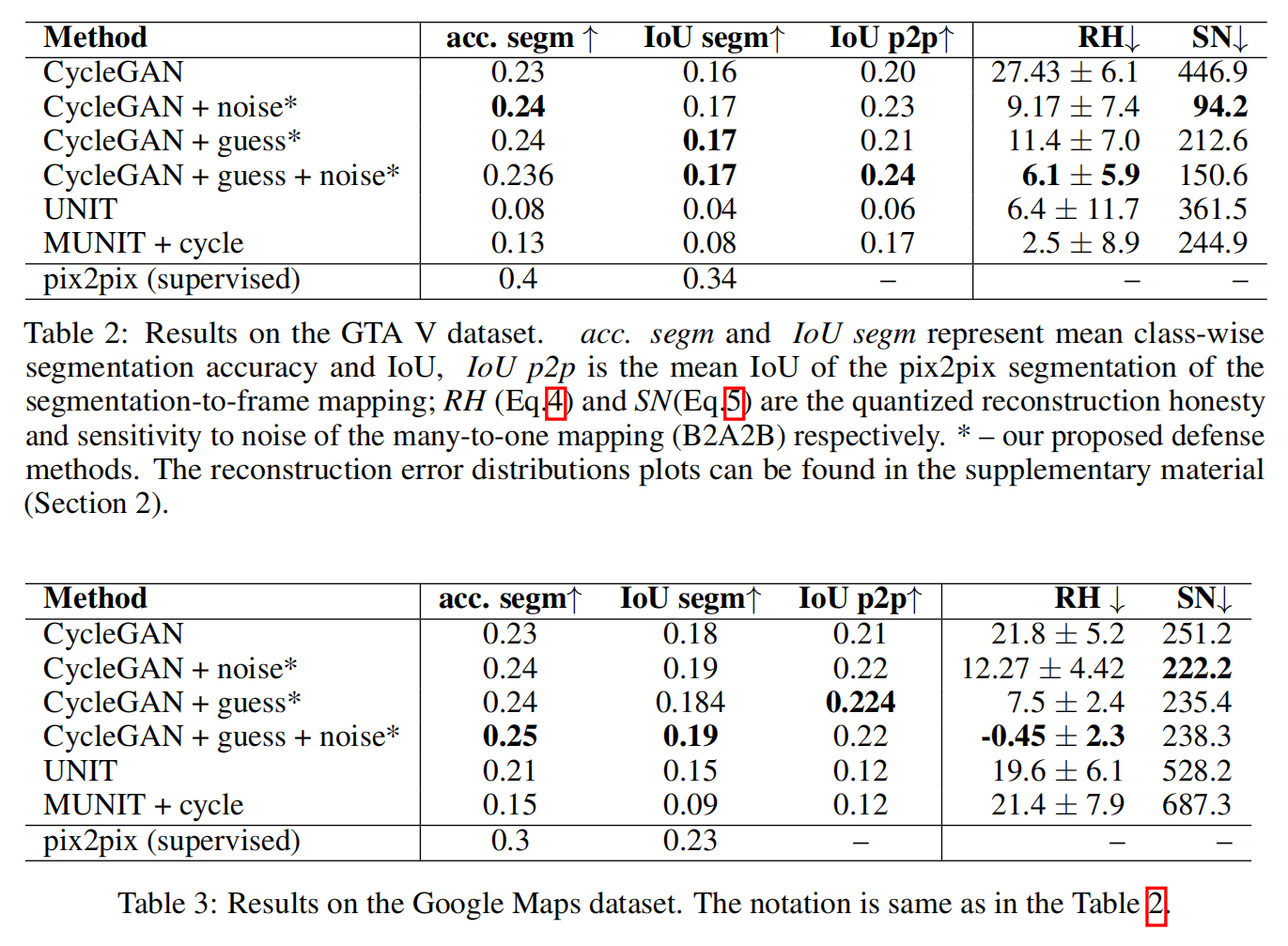

3.2. Guess Discriminator: