Attention-based Dropout Layer for Weakly Supervised Object Localization

2019-12-24 21:21:44

Code: https://github.com/junsukchoe/ADL

1. Background and Motivation:

弱监督物体的定位(Weakly Supervised Object Localization, WSOL)的目标是仅仅使用 image-level labels,而不用 location annotations。现有的方法挖掘并且跟踪每一个类别的判别特征,进行物体检测和分割。由于不同物体的 part 具有的判别能力,这些技术倾向于仅仅定位最具有区分性的区域,无法实现覆盖到物体的整个内容。例如,行人,当外形出现骤变的时候,人脸可能是具有更好的判别能力。在这种情况下,现有的 WSOL 基础仅能定位到 face,而不是整个 region。这种问题对于物体定位来说,是非常关键的。特别的,Class Activation Mapping 利用 CNN 分类器来学习判别性的特征。关键的想法是:the classifier with a reasonable accuracy should observe the object region to decide the class label。换句话说,判别性的特征应该和物体区域同时出现(co-occur with the object regions)。按照这个思路,他们通过跟踪特征响应的空间分布来执行定位。不幸的是,classifier 倾向于聚焦最具有判别性的特征,以增加其分类的精度。所以,特征响应的空间空间分布也倾向于覆盖最有判别性的物体区域,从而导致物体定位精度的降低。

最近,有很多工作都尝试从【特征擦除】的角度,来遮挡具有强判别能力的特征区域,来改善最终的特征表达能力。从这些方法我们可以发现:the idea of erasing only the most discriminative part is effective to capture the full extent of object. 然而,这些方法总需要额外的计算资源来准确的去除这些判别性的区域。本文的目标是有效,并且高效的擦除这些区域。所以,本文提出了 Attention-based Dropout Layer,一种轻量级,但是强大的方法,使用 self-attention 机制来移除最有判别能力的区域。

2. The Proposed Methods:

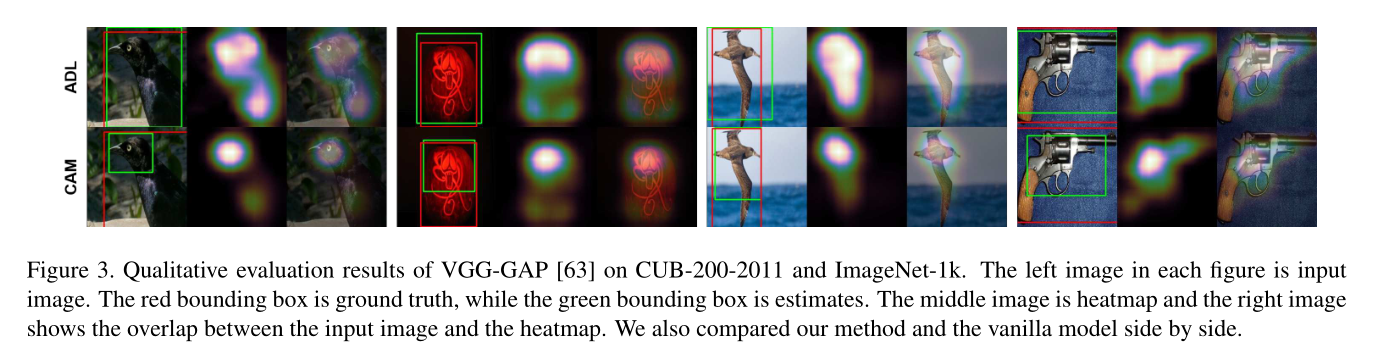

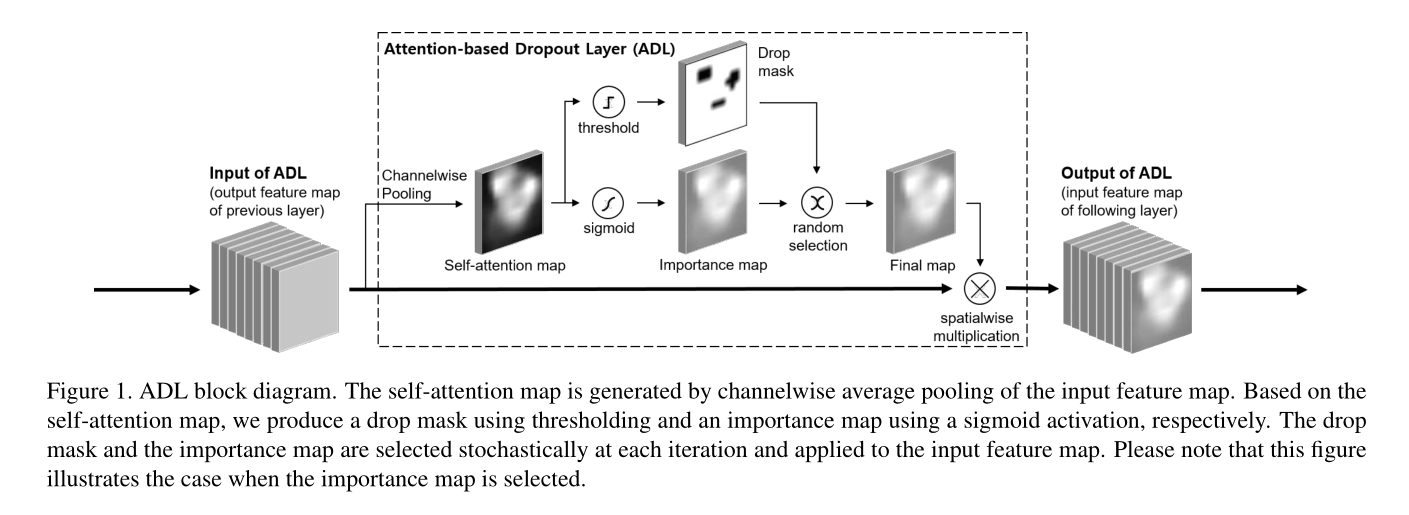

上图是本文所提出的对抗学习机制的流程图,作者引入了 self-attention module 来定位最具有判别性的区域,然后分别进行 sigmoid 和 threshold 操作,得到 importance map 和 drop mask。然后对这两个 map 随机的进行选择,然后将其与 原始的 feature map 进行空间上的相乘,得到处理后的 feature,再进行输入到后续的网络中。

这里,本文方法其实是将 adversarial learning 和 attention mechanism 都结合过来,进行鲁棒特征的学习。

需要注意的是:本文所提出的 ADL 模块仅仅在 training phase 使用,而不在 test phase 使用,所以,不会增加 test 的时间消耗。

为什么本文方法会 work 呢?去掉对抗模块不谈,其实就是 CNN + Attention 机制;去掉 注意力模块,其实就是 CNN + Adversarial Learning。而 attention 和 adversarial learning 均已被大量的工作验证了其有效性,那么,将这两种方法随机的进行选择和组合,按说,的确是可以提升模型的效果。至于创新么,要啥自行车!

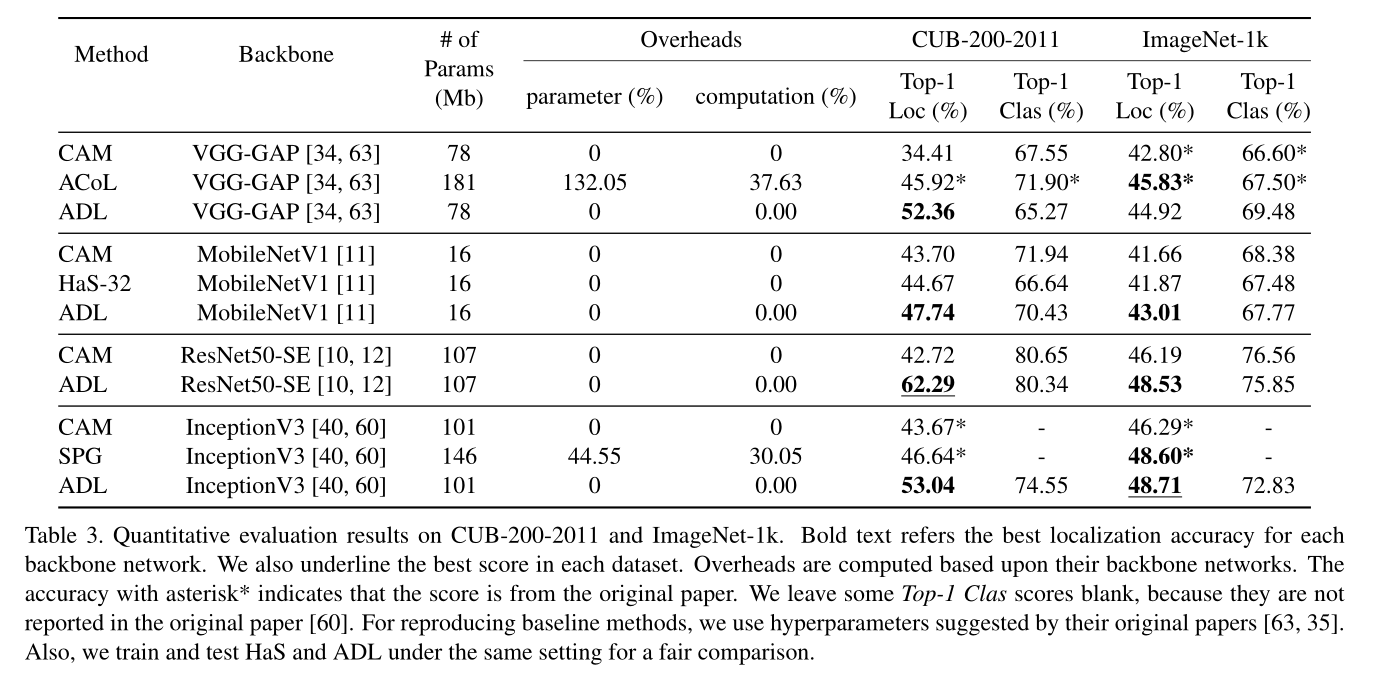

3. Experiments: