采集不可聚合的离散的。日志信息的e

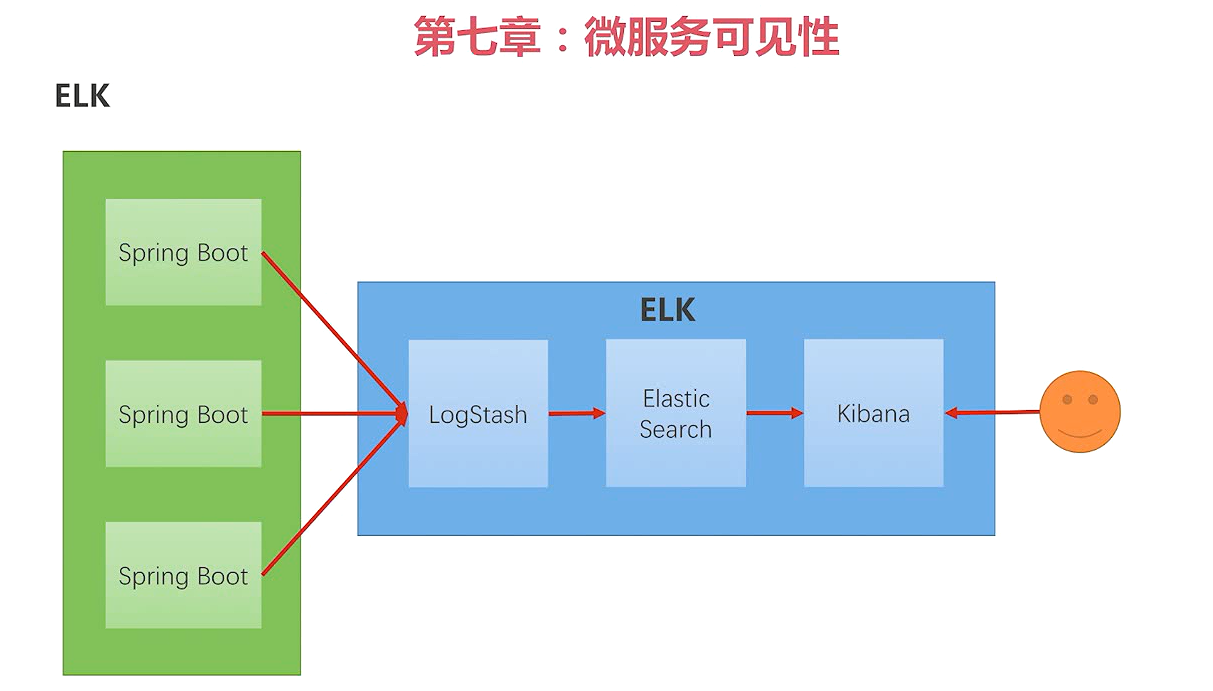

ELK是三个系统的简称

LogStash:用来做日志的收集、过滤、格式转换

Kibana:和普罗米修斯的grafana一个意思。主要用来展示数据。

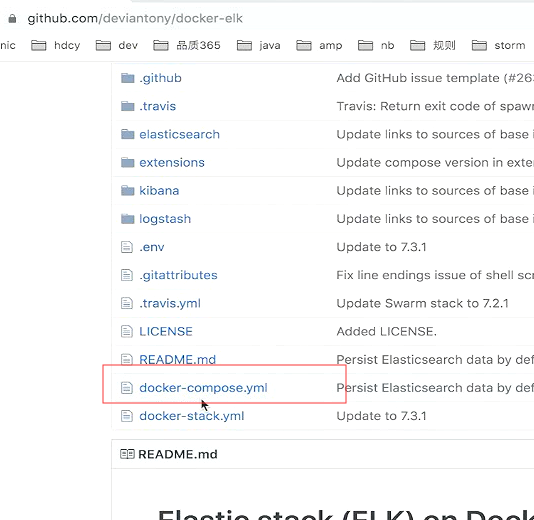

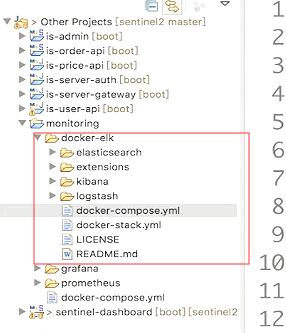

用docker来装ELK的环境

把这个项目克隆到本地

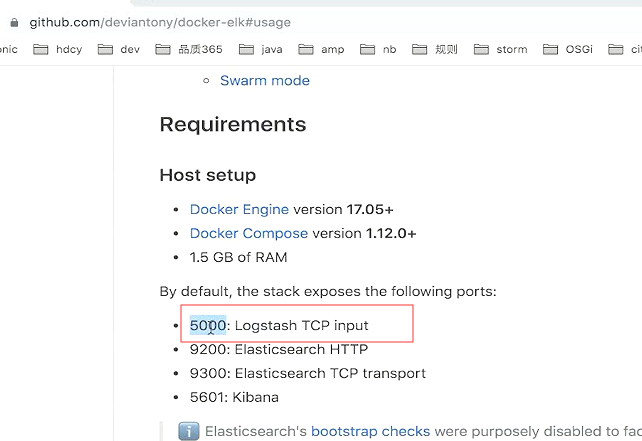

说明里面 告诉你怎么使用。

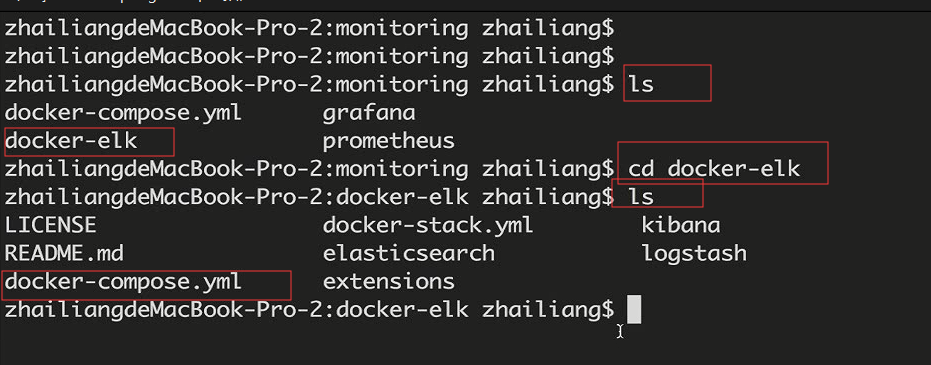

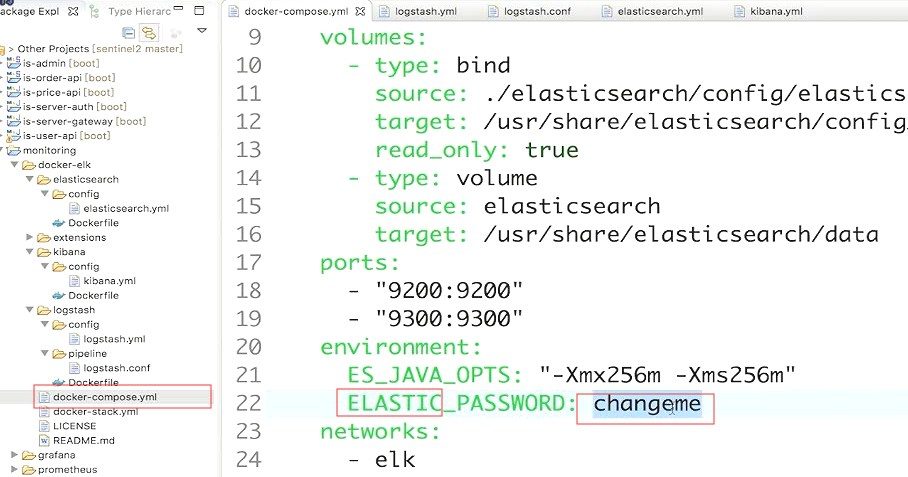

进入到docker-elk的文件夹下。然后保证当前目录有这个docker-compose.yml这个文件。

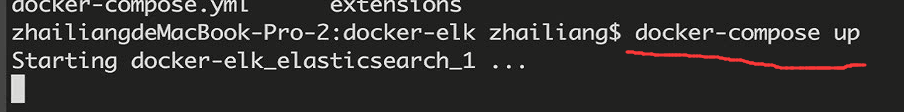

第一次安装会下载很多东西。

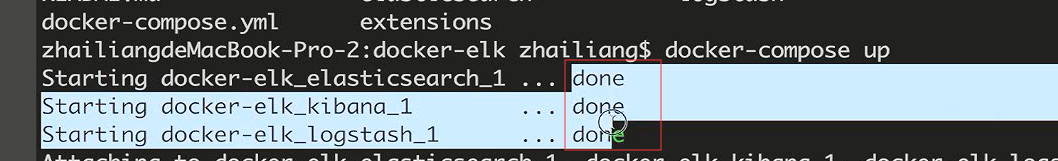

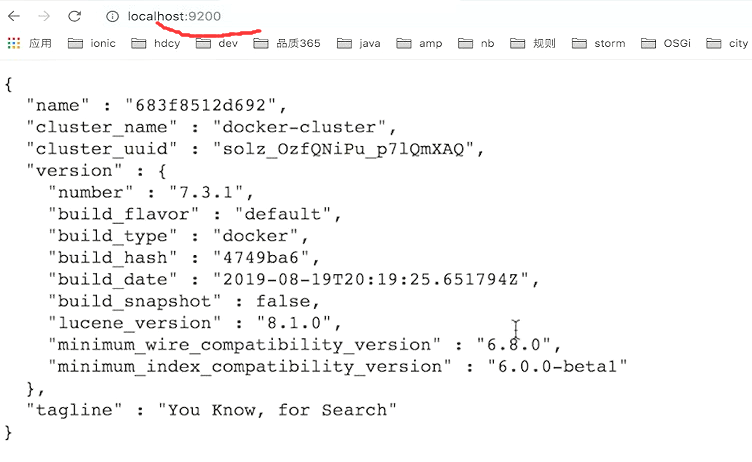

这样就说明elk的环境就启动起来了。

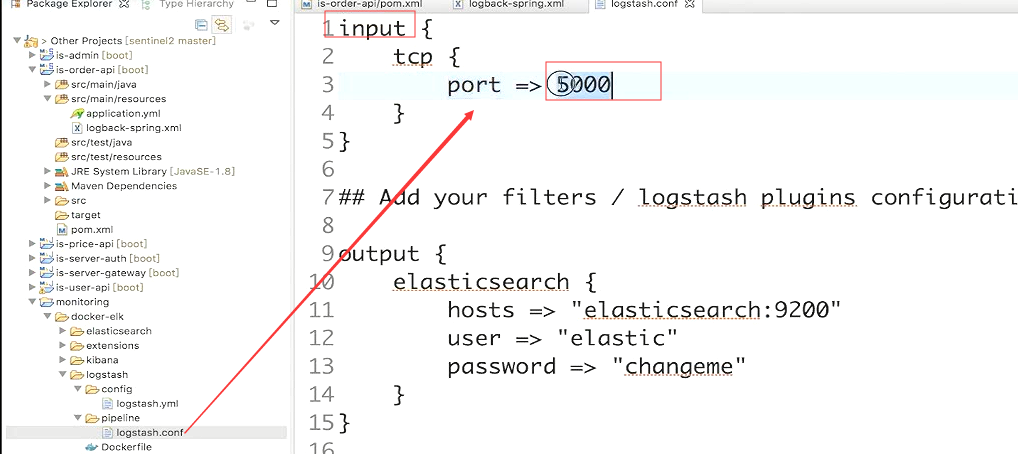

收集日志的是5000端口

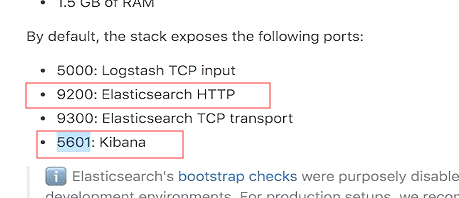

tcp的端口是看不到页面的。我们可以来看下 9200和5601

elastic是账号,changeme是密码。

因为博主之前已经进来过了。如果是第一次进来是需要输入账号和密码的。本身是没有界面的,只是提供restful的服务,让你去采集数据。建索引。

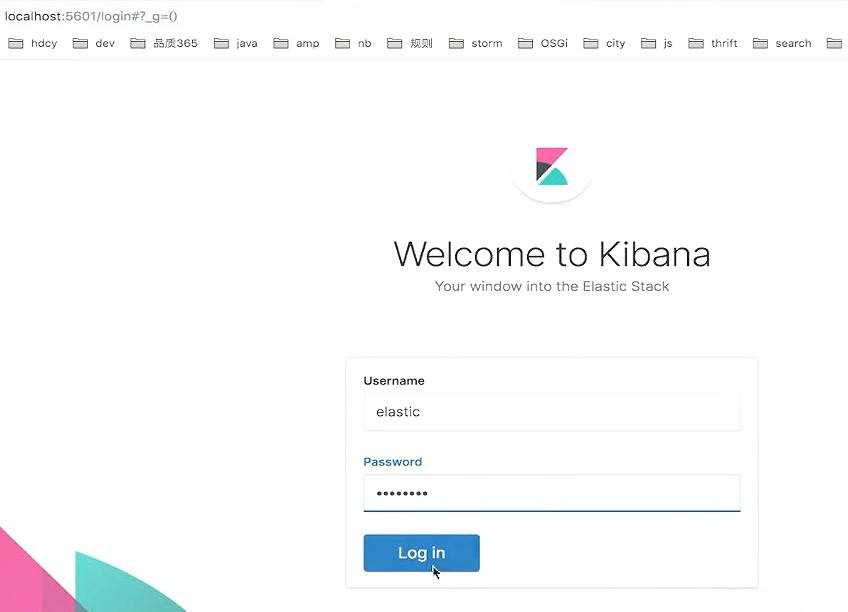

5601的端口

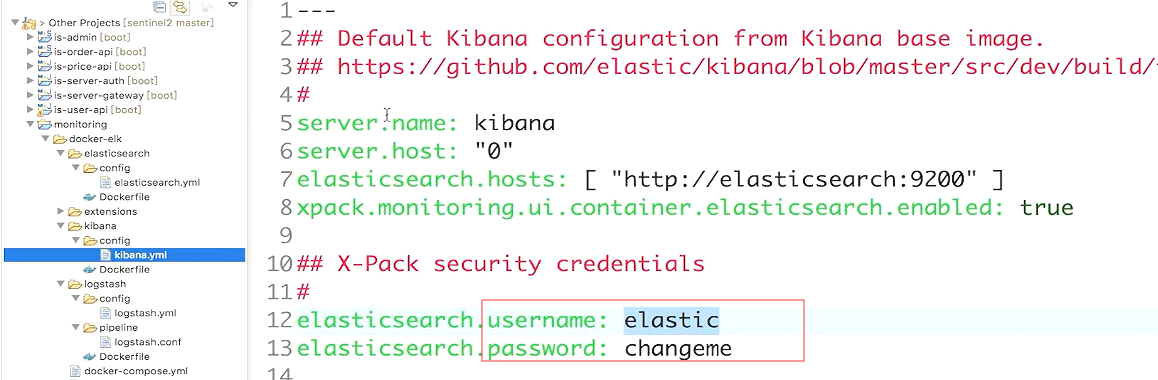

kibana配置的账号和密码在这里

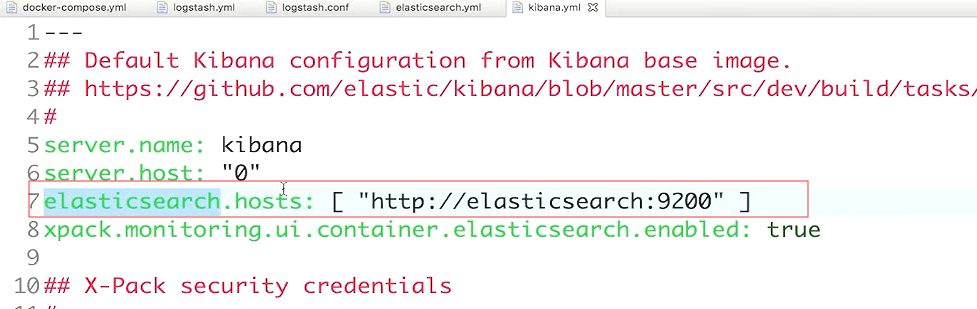

kibana是给elasticSearch做展示的 所以下就需要知道elasticSearcg在哪

接入springboot

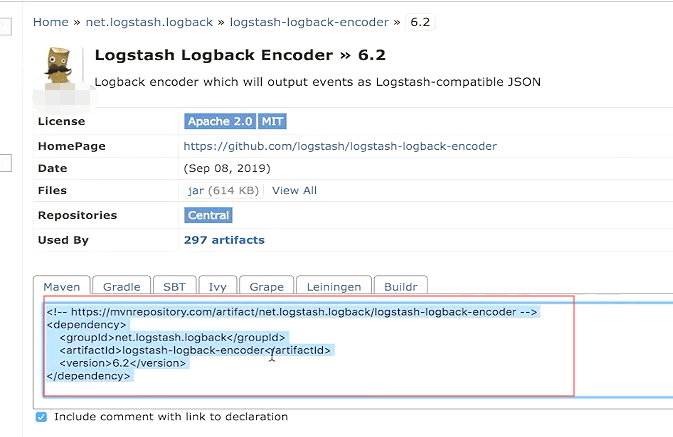

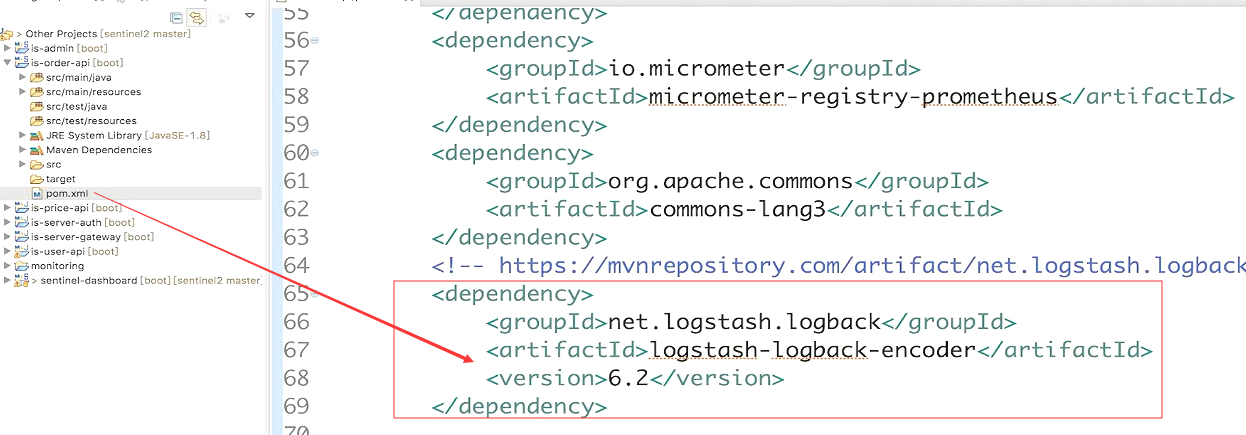

springboot默认用logback做的日志,需要一个依赖。让日志输出到logtash里面去。

搜索logstash logback

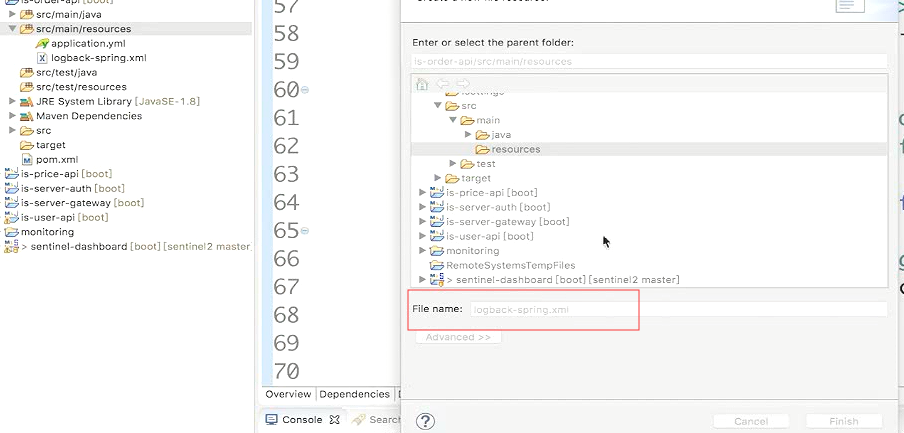

创建日志的配置文件

文件的内容不再敲了,直接复制过来的

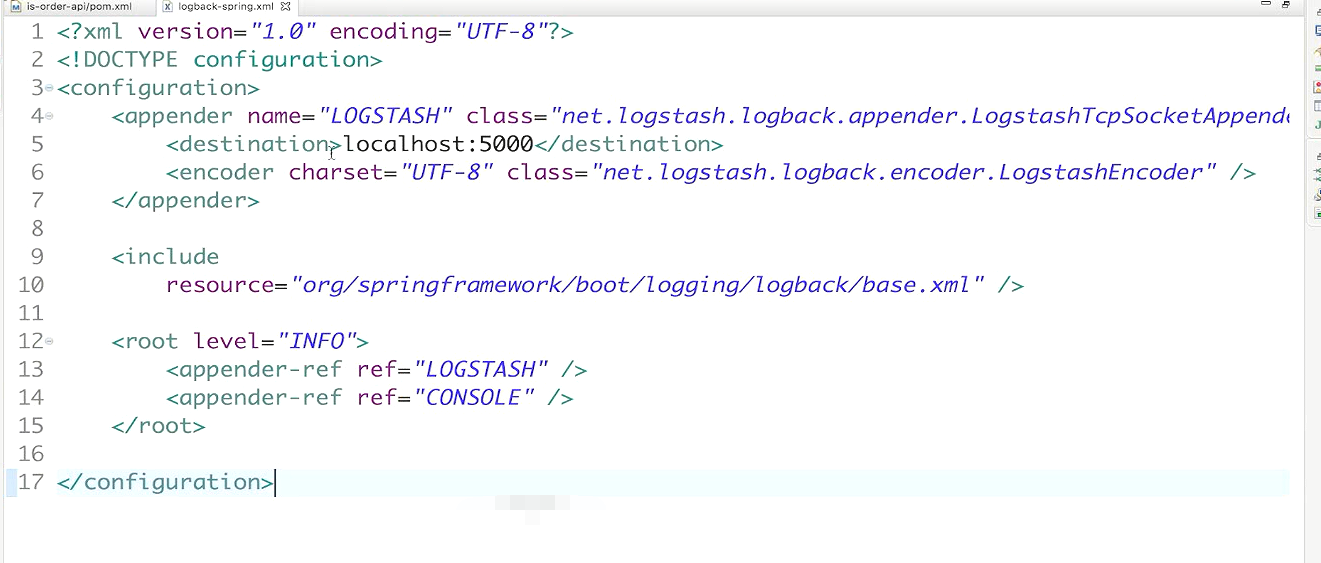

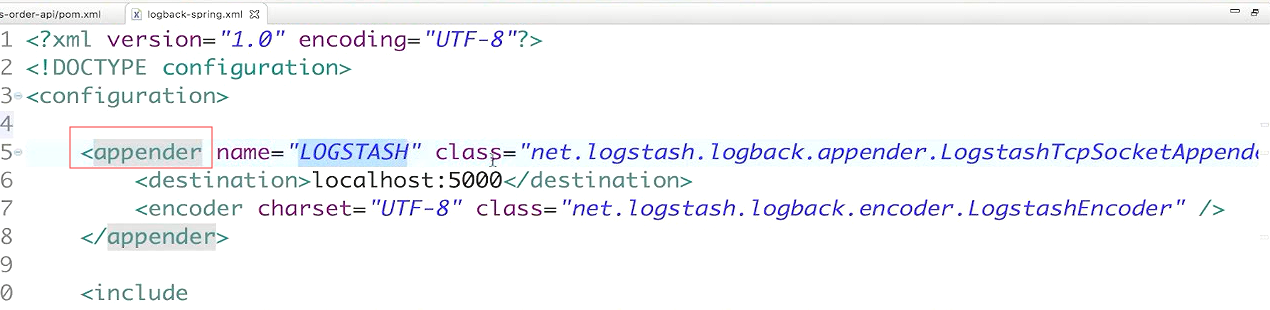

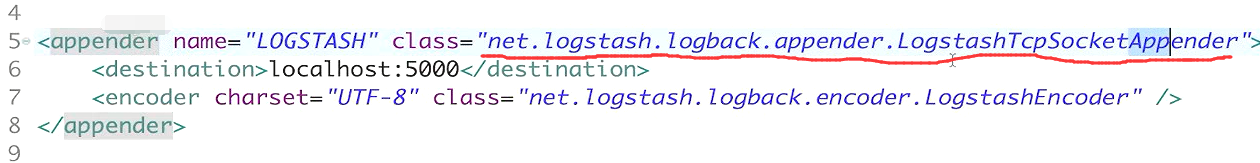

首先声明了一个appender 日志的关联器

class配置的就是jar包里面引用的一个类。作用就是把我们springboot产生的日志。输出给LogStash,

这里面要配置一个属性destination。就是告诉springboot。logstash在哪里。

logstash的配置文件配置的端口。

logstash接到日志以后,就会装给elaticsearch

它会把我们的日志的信息转换成json格式传出去,方便我们后面来解析。

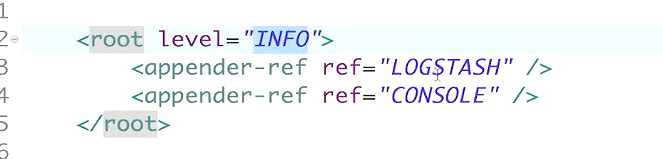

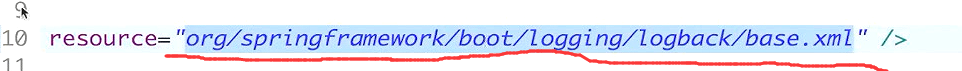

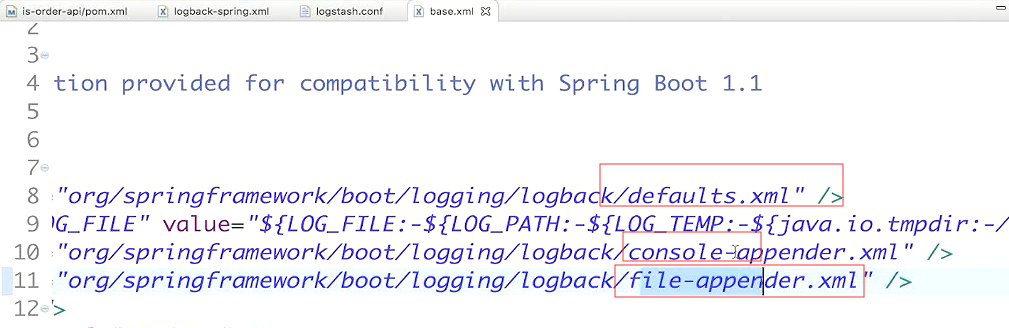

把默认的springboot的日志配置。把它再包进来。这样springboot默认的日志机制依然是生效的。自己又定义了一个appender叫做LogStash

最后写一下Info级别的日志。同时输出到LogStash和Console

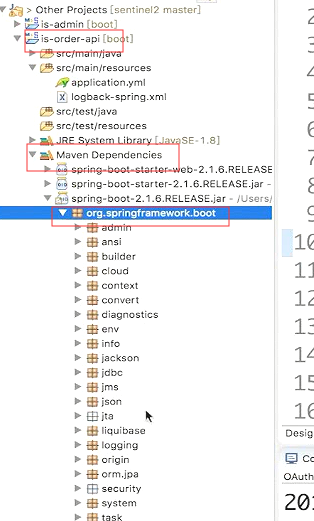

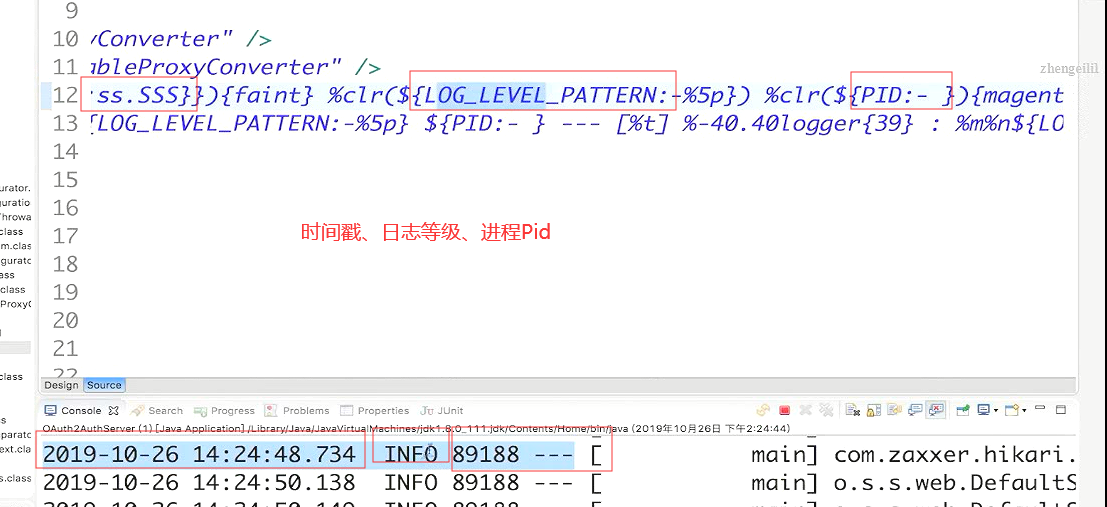

springboot默认的日志配置文件

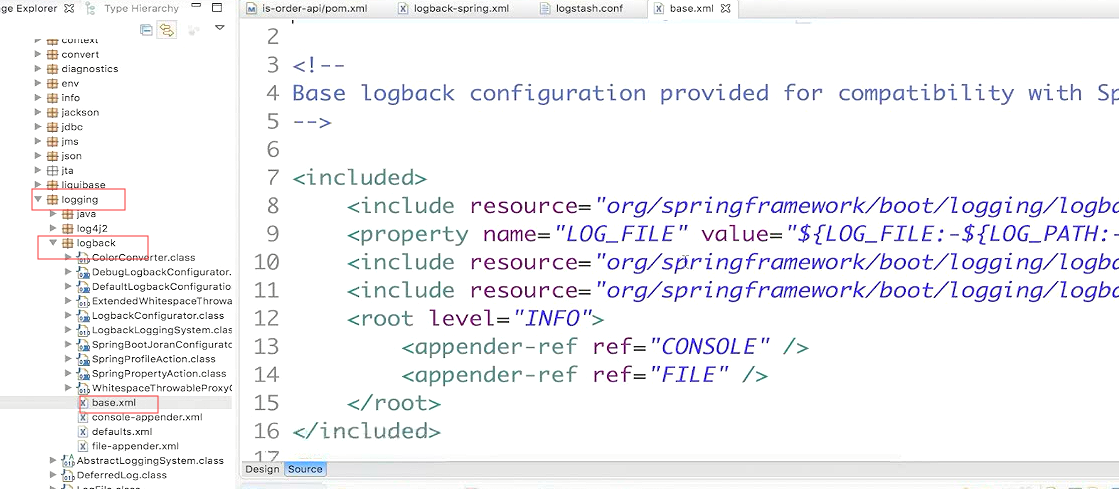

base.xml里面又引用了其他的xml文件。

console_log_pattern:就是配置的打印到控制台的日志的格式。

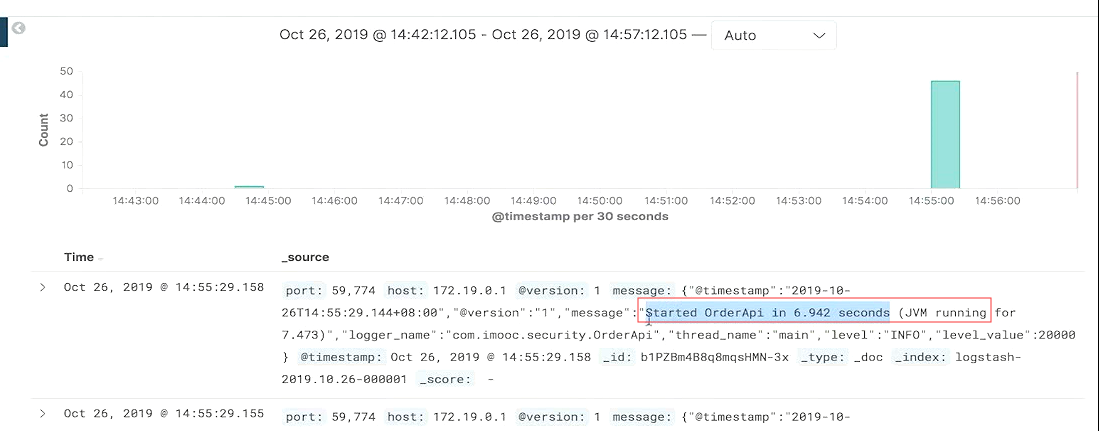

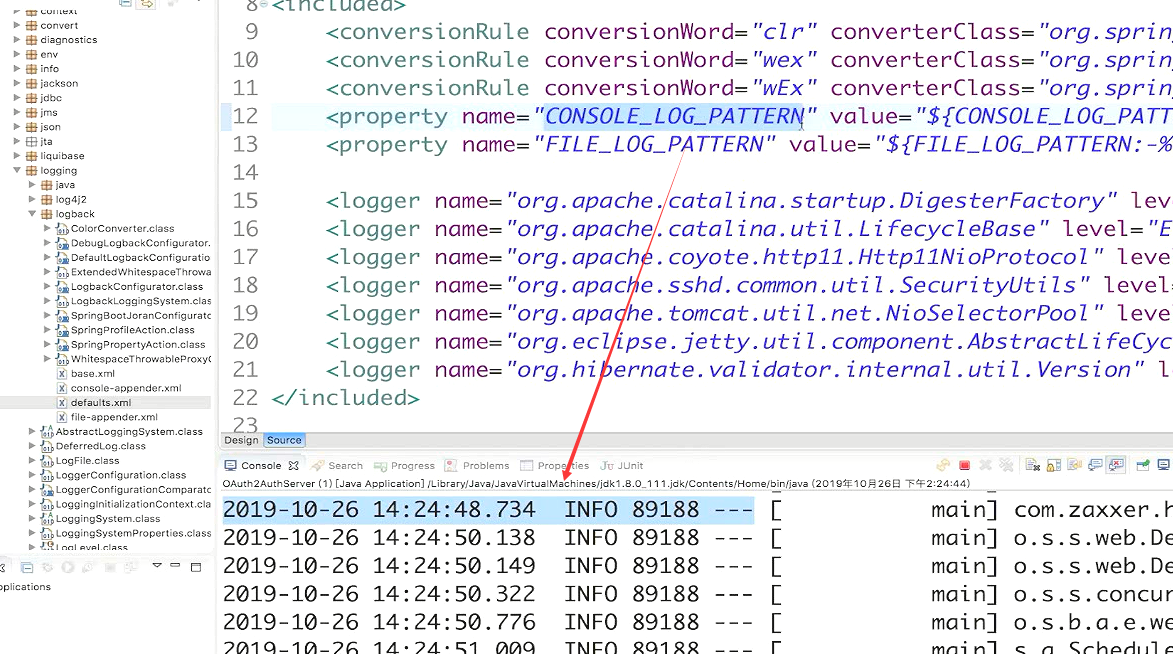

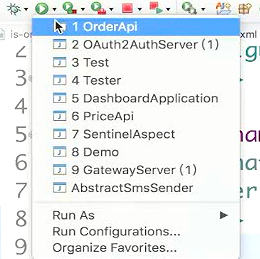

启动测试

把orderAPi启动起来,它就会往logstash的5000端口,传日志了。

启动后日志就应该进入到es里面 。

登陆Kibana看一下。密码是changeme

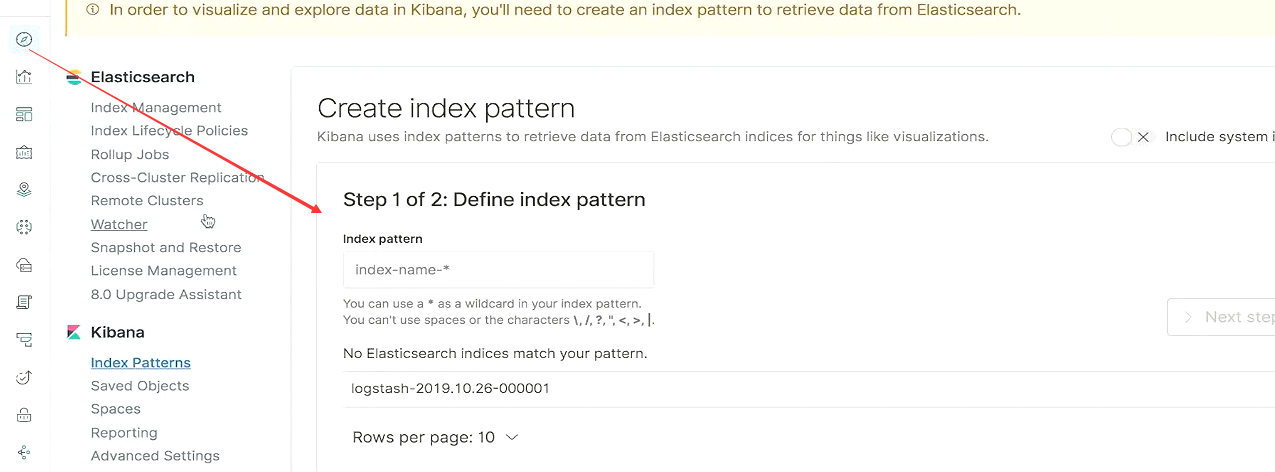

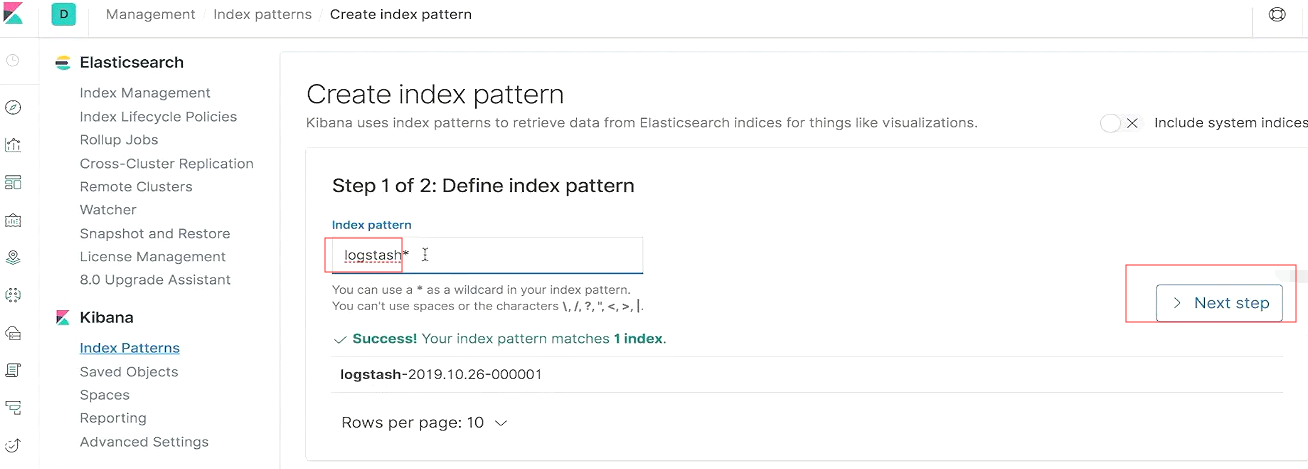

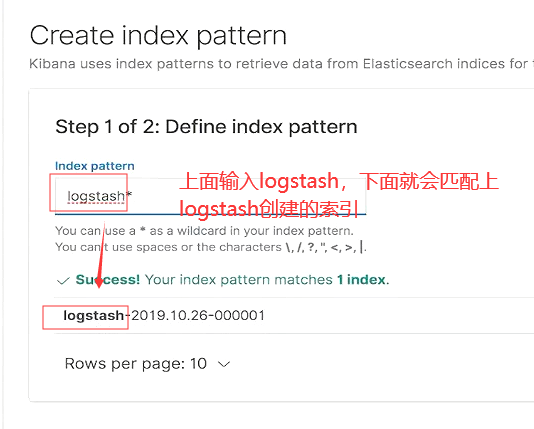

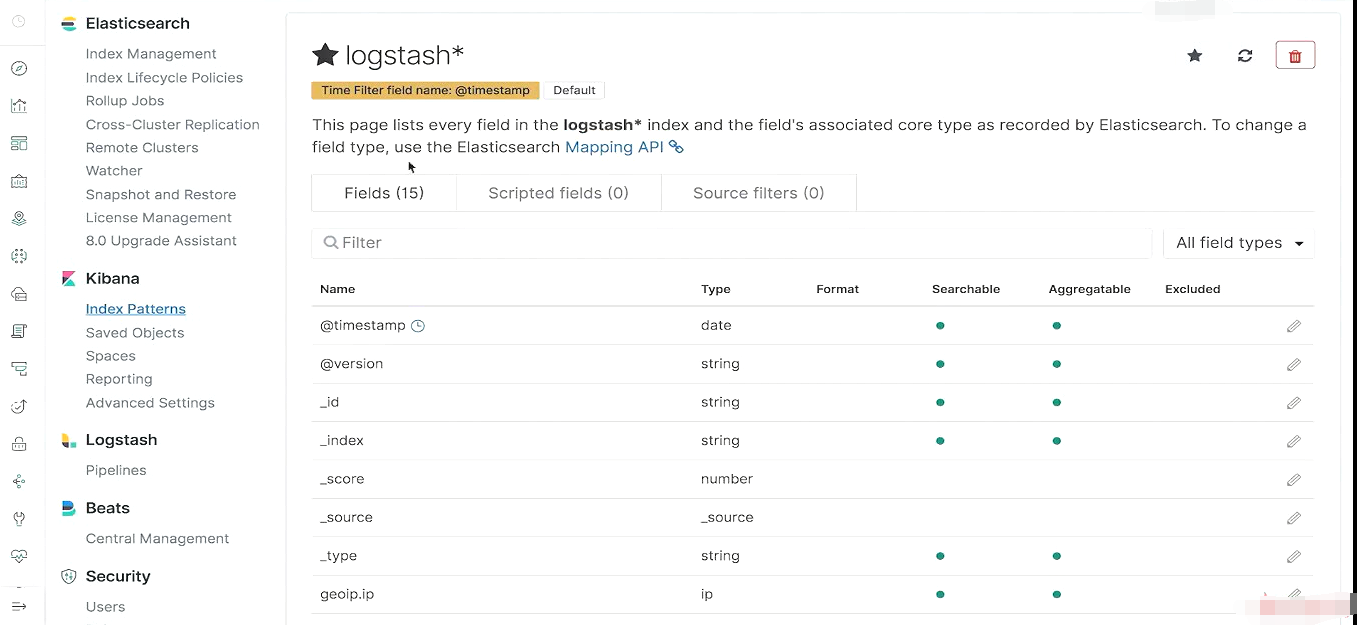

logstash作为es的数据源连上去以后创建的默认索引。

选择时间戳来过滤日志

这样就创建出来一个新的索引

可以看到日志

按照时间倒序排列的。