本讲主要剖析SecondaryNameNode。

“云计算分布式大数据Hadoop实战高手之路”之完整发布目录

云计算分布式大数据实战技术Hadoop交流群:312494188,每天都会在群中发布云计算实战性资料,欢迎大家加入!

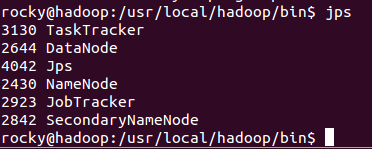

Hadoop在启动的时候,会启动SecondaryNameNode,我们使用JPS命令查看一下查看一下Hadoop启动时启动了那些进程:

在我们讲解SecondaryNameNode的具体作用之前,我们先看一看NameNode的工作特点和具体作用:

1,在Hadoop的集群中,有NameNode和DataNode之分,在运行时DataNode可以有很多个,但NameNode只有一个;

2,NameNode保存的是Hadoop集群的metadata,即文件系统的元数据,包含整个文件系统的目录结构,每一个目录有哪些文件,每个文件有哪些分块,每个分块保存在哪一个DataNode上面;

3,NameNode在内存中保存metadata,这样可以快速的处理客户端对数据的“读请求”;

4,但是内存中的数据是容易丢失的,例如掉电时,所以我们必须在磁盘上有metadata的副本;

5,当有“写请求”到来时,即要改变Hadoop的文件系统时,NameNode会首先写editlog并主动同步到磁盘,成功后才会修改内存中的metadata,并且返回给客户端,客户端在收到成功返回的信息后才会写数据到具体的DataNode上去;

6,Hadoop会在磁盘上维护一个fsimage的文件,该文件是NameNode中metedata的镜像;

7,fsimage不会随时与NameNode中的metedata保持一致,而是每隔一段时间通过合并editlog中的内容来更新;

8,合并的过程是比较消耗内存和CPU的操作,所以Hadoop就是用SecondaryNameNode专门用于更新fsimage文件;

下面我们看看SecondaryNameNode的工作流程:

1,SecondaryNameNode通知PrimaryNameNode切换editlog;

2,SecondaryNameNode通过HTTP协议从PrimaryNameNode获得fsimage和editlog;

3,SecondaryNameNode将fsimage载入内存,然后开始合并editlog的操作;

4,SecondaryNameNode将合并后的新的fsimage发给PrimaryNameNode;

5,PrimaryNameNode收到SecondaryNameNode发过来的新的fsimage后会用新的fsimage替换旧的fsimage;

SecondaryNameNode合适触发上述的工作流程呢?或者说checkpoint是什么呢?满足以下的任何条件都会触发SecondaryNameNode的工作流程:

1,fs.checkpoint.period 指定两次checkpoint之间最大时间间隔,默认时间为3600秒,即一个小时;

2,fs.checkpoint.size规定editlog文件的最大值,该文件的默认大小是64M,一旦超过这个值则强制触发SecondaryNameNode的工作流程;

从Hadoop 2.X开始推出了Active-Backup NameNode的模式,即同时具有两个NameNode:Active NameNode和Backup NameNode,当Acitive NameNode不能够正常提供服务是时候,Backup NameNode就可以接替Acitive NameNode继续为客户端提供服务,这样就会更有力的保证Hadoop服务不会中断。

大家可以看出在Hadoop 1.X的版本时,整个Hadoop的正常工作极端的依赖于单一的Primary NameNode,当Primary NameNode出现问题的时候,整个Hadoop的文件系统就无法给客户端提供服务了,这对一些非常关键的应用是难以接受的,所以运行NameNode节点的机器的硬件需要非常好,例如磁盘的IO速度要非常快;