一.首先我们需要一个 hadoop-2.8.5.tar.gz

这里就省略了什么解压,指定路径什么的步骤啦

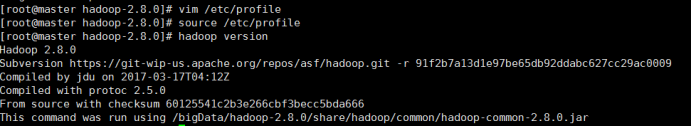

1.配置hadoop环境变量

vim /etc/profile

export HADOOP_HOME=/usr/java/hadoop-2.8.5 (按自己的路径来)

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

记得 source /etc/profile

2.修改hadoop的配置文件

cd /usr/java/hadoop-2.8.5/etc/hadoop

2.1.hadoop-env.sh

01.vim hadoop-env.sh

02.在文件中加入:export JAVA_HOME=/usr/java/jdk1.8.0_151 (按自己的路径来)

2.2.yarn-env.sh

01.vim yarn-env.sh

02.在文件中加入: export JAVA_HOME=/usr/java/jdk1.8.0_151 (按自己的路径来)

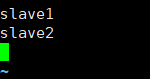

2.3.slaves

01.vim slaves

02.删除原有的localhost

2.4.core-site.xml

01.vim core-site.xml

02.在文件中的configuration节点里加入

<property> <name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/usr/java/hadoop-2.8.5/tmp</value> </property>

这里没有tmp文件,需要我们手动建一个

2.5.hdfs-site.xml

<property> <name>dfs.namenode.secondary.http-address</name> <value>master:50090</value> </property> <property> <name>dfs.replication</name> <value>2</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/usr/java/hadoop-2.8.5/hdfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/usr/java/hadoop-2.8.5/hdfs/data</value> </property>

2.6.yarn-site.xml

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.resourcemanager.address</name> <value>master:8032</value> </property> <property> <name>yarn.resourcemanager.scheduler.address</name> <value>master:8030</value> </property> <property> <name>yarn.log-aggregation-enable</name> <value>true</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>master:8031</value> </property> <property> <name>yarn.resourcemanager.admin.address</name> <value>master:8033</value> </property> <property> <name>yarn.resourcemanager.webapp.address</name> <value>master:8088</value> </property>

2.7.mapred-site.xml

mapred-site.xml.template 是存在的

mapred-site.xml不存在

注意:先要copy一份

cp mapred-site.xml.template mapred-site.xml

然后编辑

vim mapred-site.xml

新增以下内容

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

2.8.把配置好的hadoop文件复制到其他的子机器中

scp -r /usr/java/hadoop-2.8.5 root@slave1:/usr/java/hadoop-2.8.5

scp -r /usr/java/hadoop-2.8.5 root@slave2:/usr/java/hadoop-2.8.5

2.9.把配置好的/etc/profile复制到其他两个子机器中

scp /etc/profile root@slave1:/etc/profile

scp /etc/profile root@slave2:/etc/profile

之后在每个子机器中使用 source /etc/profile 使文件生效

2.10在master 主机器中运行

hdfs namenode -format

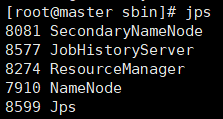

2.11.在master 主机器中启动hadoop环境

进入/usr/java/hadoop-2.8.5/sbin ./start-all.sh 启动hadoop集群 ./stop-all.sh 关闭hadoop集群

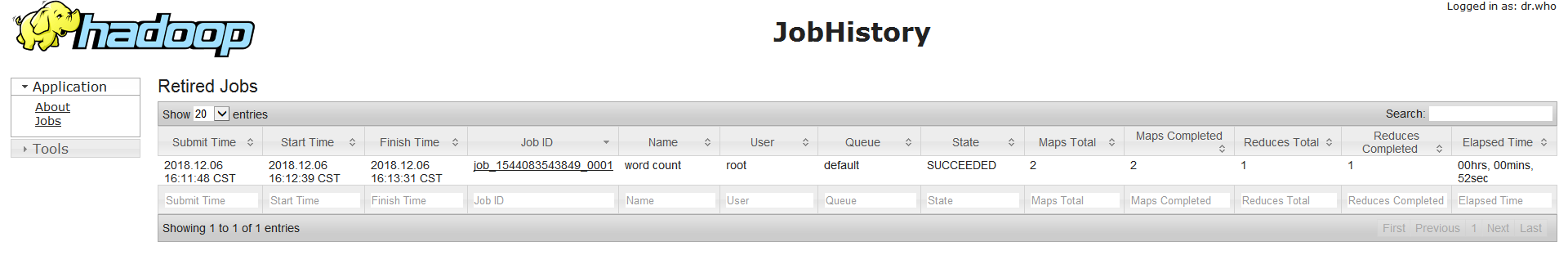

2.12.启动jobhistoryserver(日志)

./mr-jobhistory-daemon.sh start historyserver

之后主机输入jps

子机输入jps

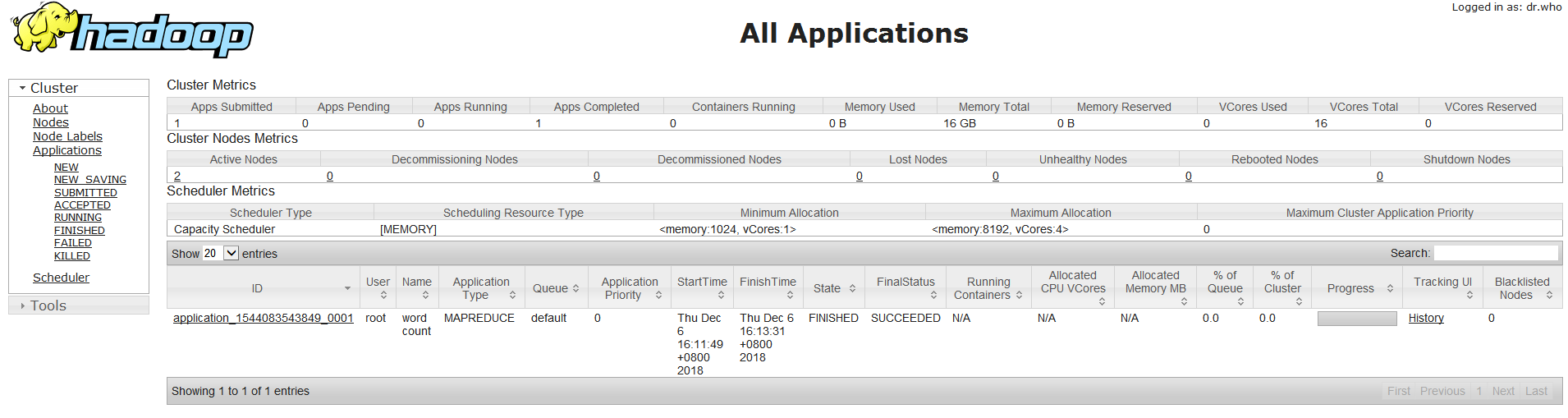

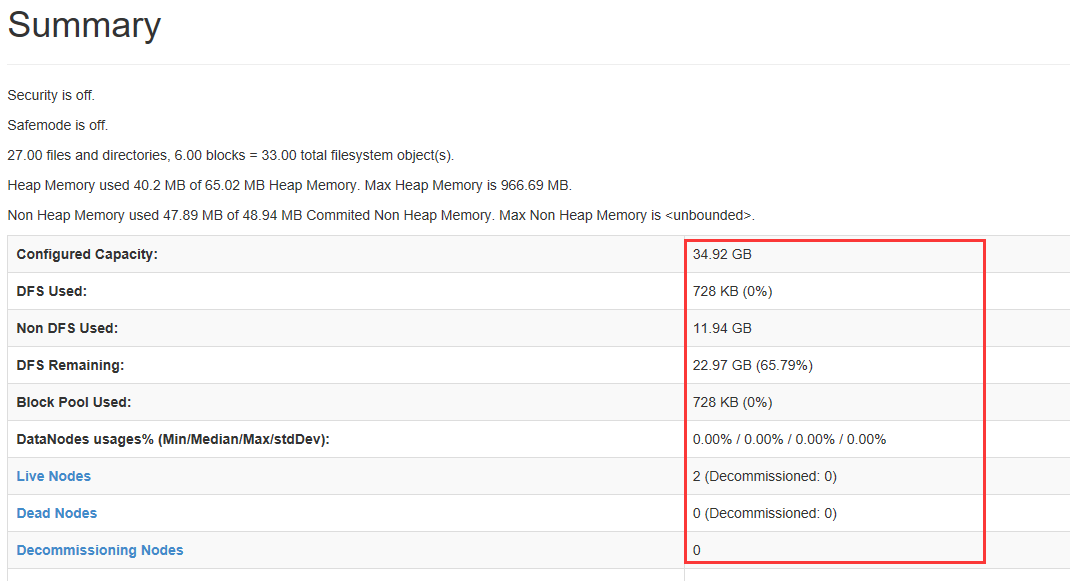

然后去浏览器访问主机ip:

例如我的是192.168.100.2:8088

50070

注意这里的参数,如果都是0,就代表配置失败了

50090

19888