s3a对接存储

需要分布式存储服务器方提供如下参数信息

fs.s3a.access.key; fs.s3a.secret.key; fs.s3a.endpoint; fs.s3a.impl

公钥 私钥 sa3IP和端口 固定jar包

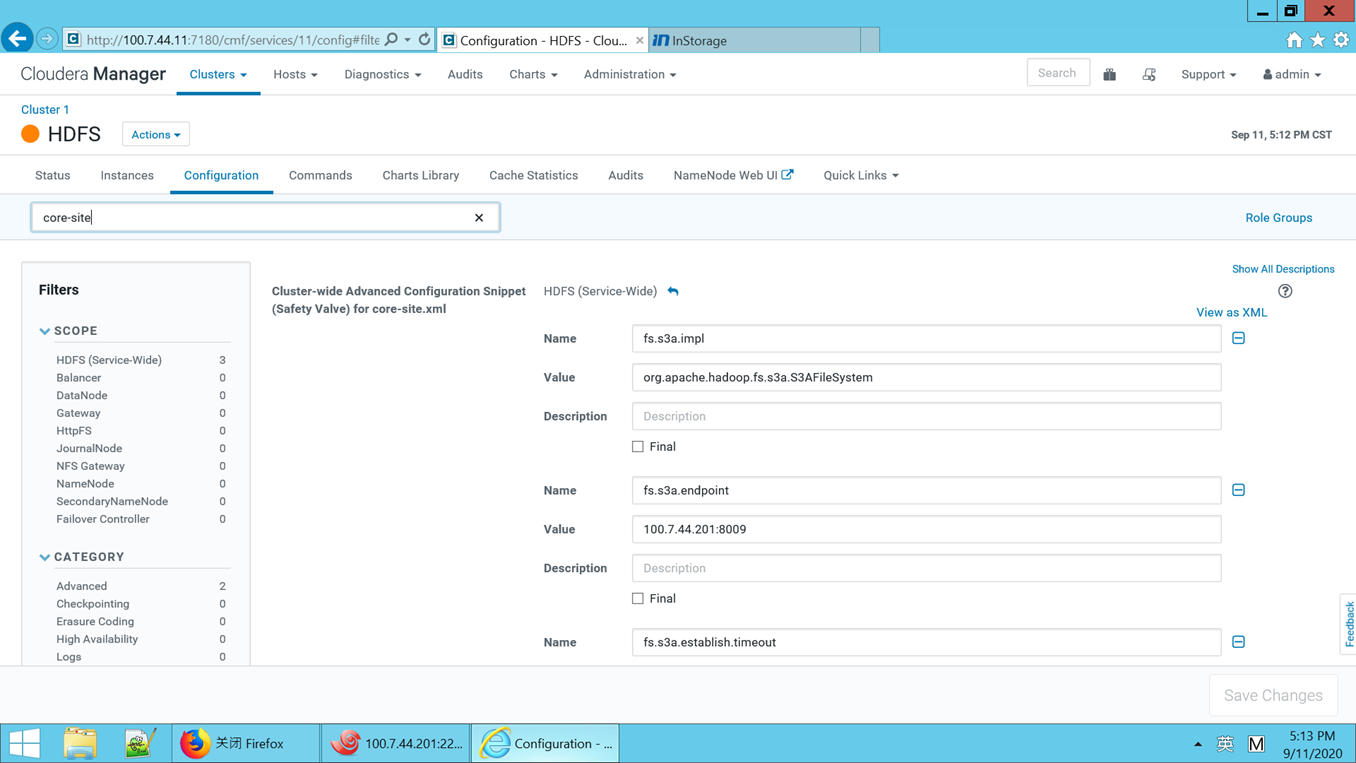

hdfs对接对象存储

登录CDH管理界面,选择hdfs,然后点击配置,

<property> <name>fs.s3a.impl</name> <value>org.apache.hadoop.fs.s3a.S3AFileSystem</value> </property> <property> <name>fs.s3a.endpoint</name> <value>100.7.44.201:8009</value> </property> <property> <name>fs.s3a.establish.timeout</name> <value>5000000</value> </property> <property> <name>fs.s3a.connection.timeout</name> <value>5000000</value> </property> <property> <name>fs.s3a.access.key</name> <value>key11</value> </property> <property> <name>fs.s3a.secret.key</name> <value>sec11</value> </property> <property> <name>fs.s3a.buffer.dir</name> <value>/mnt/icfs/s3a</value> </property> <property> <name>fs.s3a.connection.ssl.enabled</name> <value>false</value> </property> |

其中fs.s3a.endpoint根据实际情况修改,建议使用域名,这里例子设置为ip

fs.s3a.access.key、fs.s3a.secret.key请根据实际情况修改

修改完配置根据CDH提示,重启HDFS服务,并推送配置到客户端

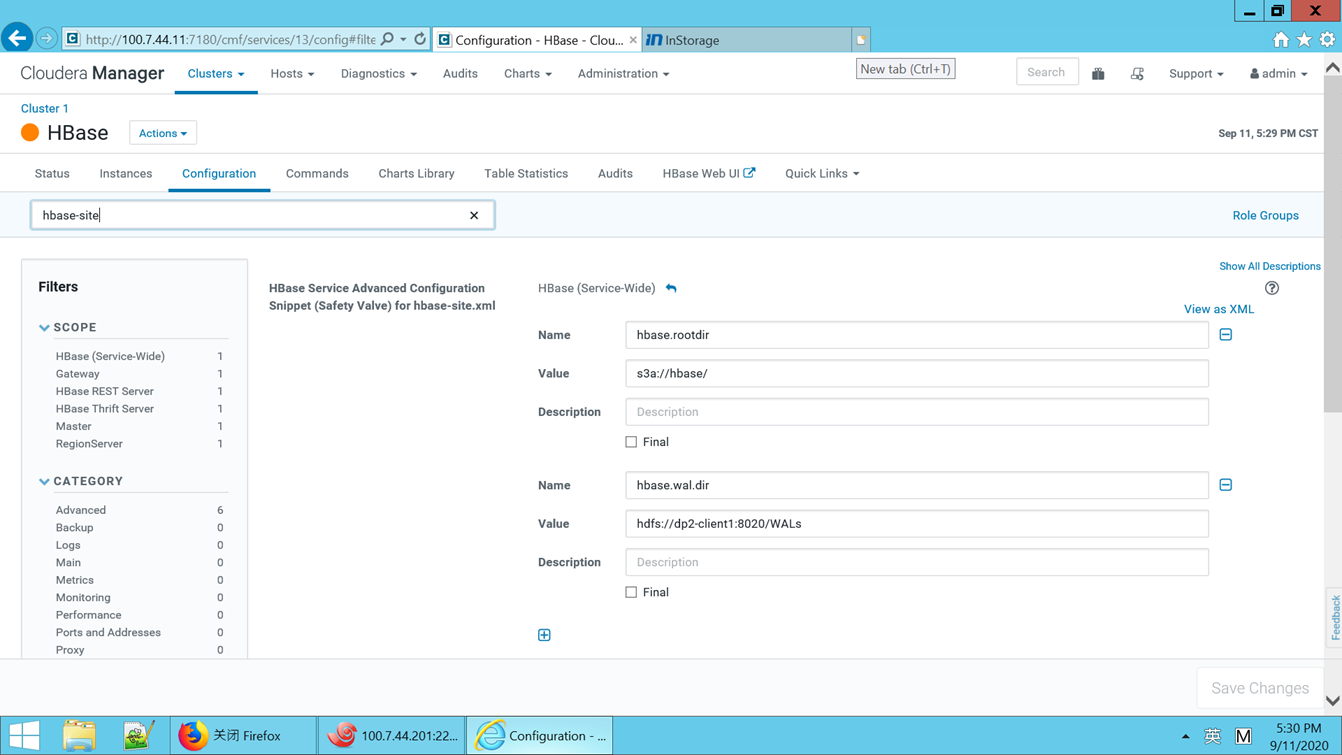

Hbase对接对象存储

登录CDH管理界面,选择hbase,然后点击配置,添加core-site.xml配置

与HDFS上面相同,详情见hdfs对接对象存储,根据管理界面提示重启hbase相关服务并推送配置文件到客户端

在存储端为hbase创建桶,这里创建的桶为hbase

修改hbase-site.xml配置

添加hbase.rootdir,设置为hbase在对象存储中的路径。

添加hbase.wal.dir,为hdfs路径。

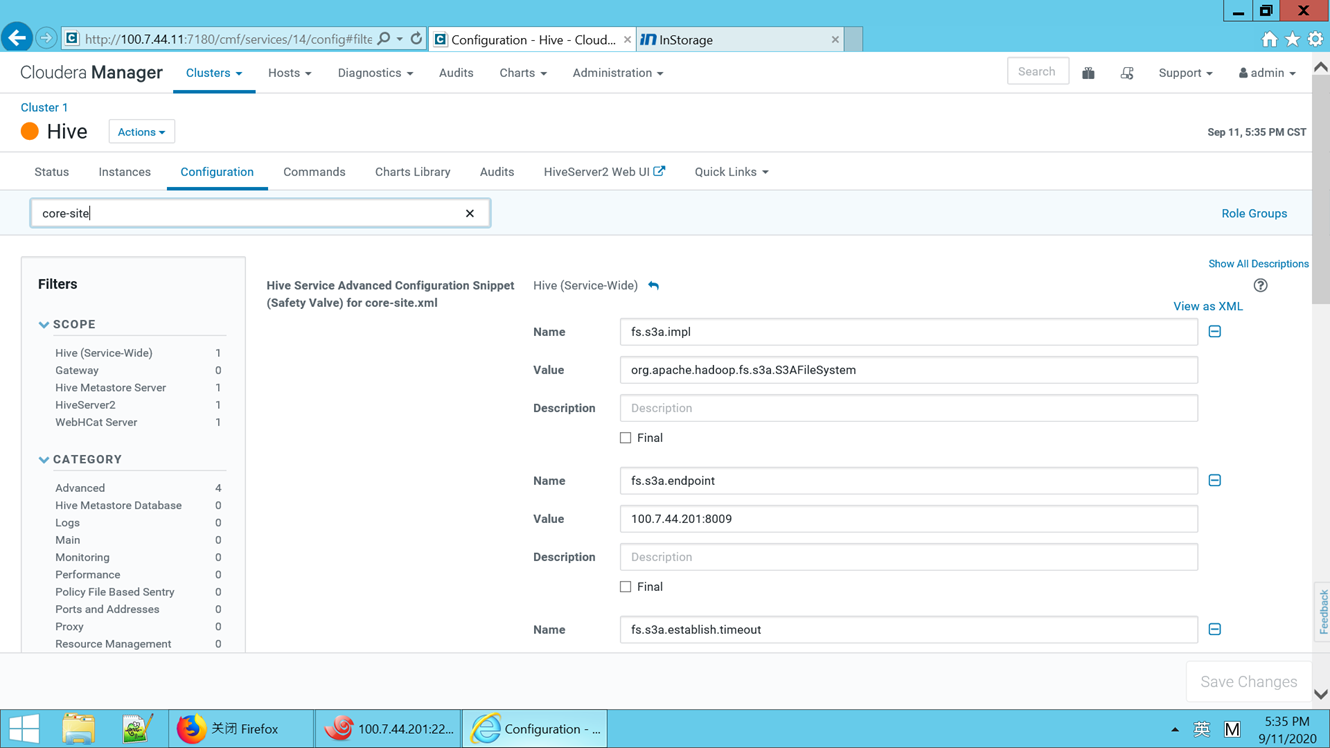

Hive对接对象存储

登录CDH管理界面,选择hive,然后点击配置,添加core-site.xml配置

与HDFS上面相同,详情见hdfs对接对象存储,根据管理界面提示重启hive相关服务并推送配置文件到客户端

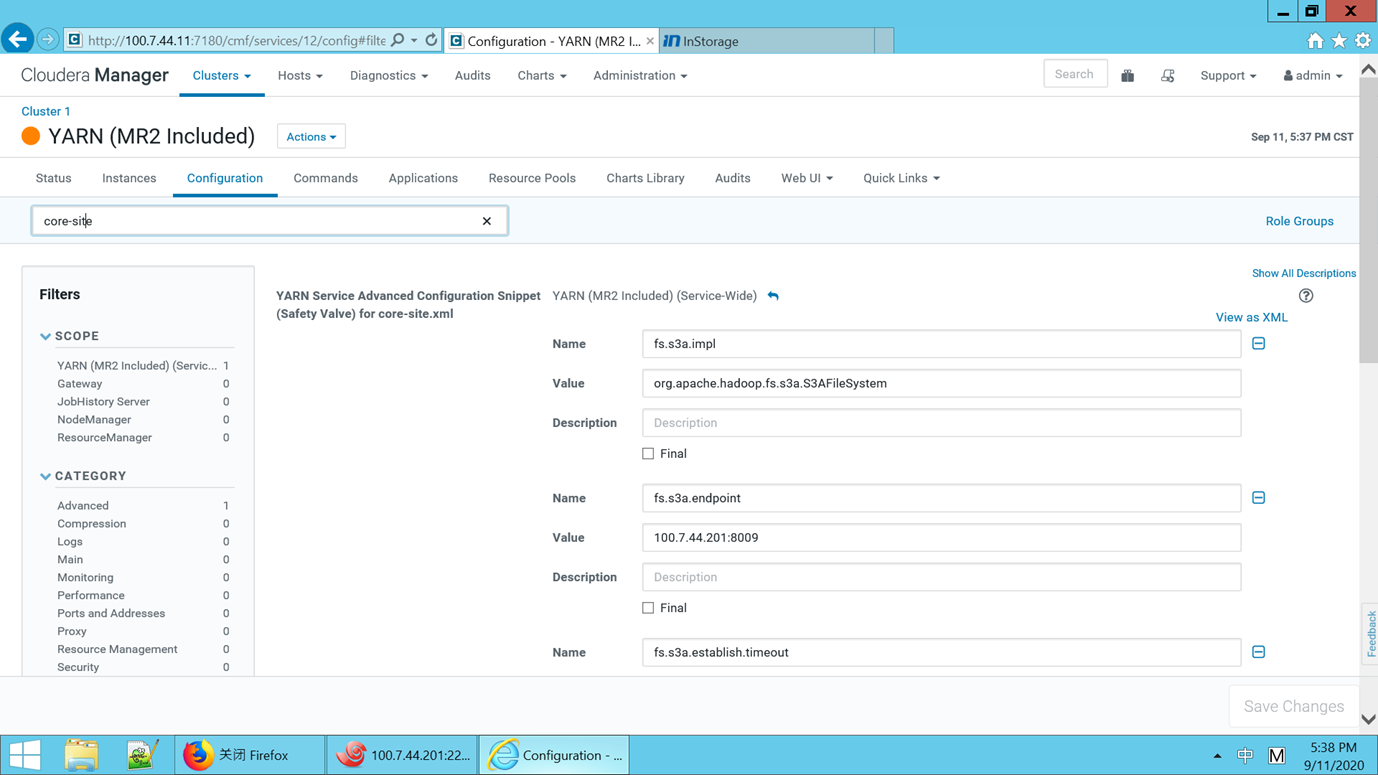

Spark对接对象存储

登录CDH管理界面,选择hive,然后点击配置,添加core-site.xml配置

与HDFS上面相同,详情见hdfs对接对象存储,根据管理界面提示重启spark相关服务并推送配置文件到客户端