记一次大批量数据的多进程同步

背景:因为公司的用户标识不完整,所以需要从集团同步一次用户标记数据,用户数据来源是微信,数量级为一百五十万,集团用户数量级为六百万

方案确定下来是集团开了一个查询接口,访问没有频率并发限制,数量级在那呢,我们遍历公司的用户,去查询这些用户的标识来更新

项目使用了laravel,就写了一个命令行脚本,开15个进程去跑

由于时间关系使用了PHP的pcntl_fork实现多进程

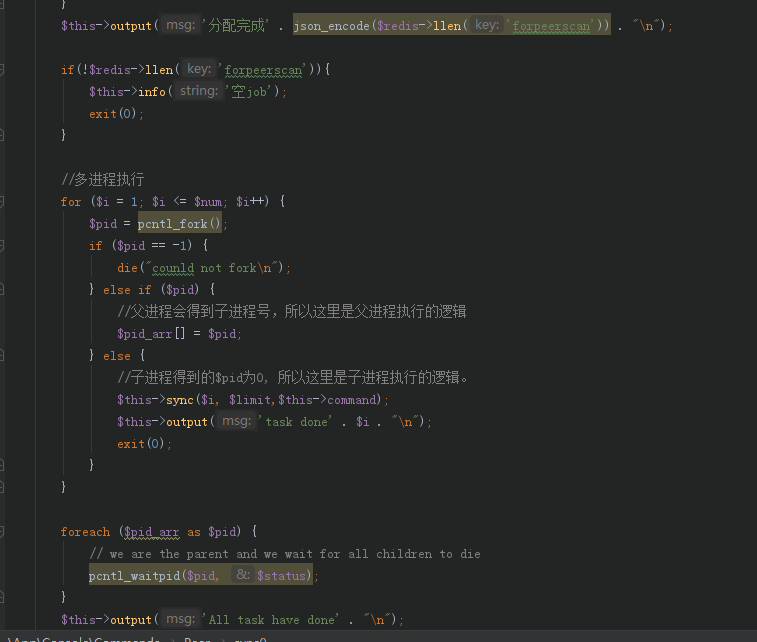

核心代码如下:

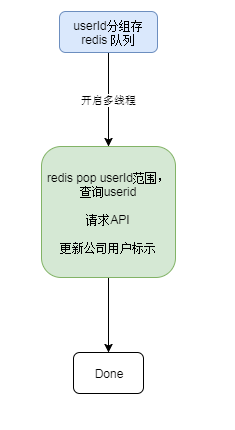

主要流程是:

首先主进程分配userid给各个子进程,这里使用了redis队列来存储,然后fork子进程,在子进程中pop队列获取分配到的userid范围,再查库组装信息请求集团API,根据返回值标示用户。

因为Laravel封装的redis和DB使用了单例,所有多个进程多钱redis和DB时均有报错:

redis:Error while reading line from the server

mysql:Packets out of order. Expected 1 received 19

嗯,都是多进程读取单例的同一个连接导致的,解决方案:

redis:使用原生PHP的redis连接:

$redis = new Redis();

$re1 = $redis->connect(env('REDIS_HOST'),env('REDIS_PORT'));

$re2 = $redis->auth(env('REDIS_PASSWORD'));

mysql:使用laravel的purge 和reconnetc重新连接

DB::purge('mysql');

DB::reconnect('mysql');

多线程大批量数据问题解决^_^