zookeeper单机(Standalones模式)和集群搭建:

前奏:

(1).zookeeper也可以在windows下使用,和linux一样可以单机也可以集群,具体就是解压zookeeper-3.4.6.tar.gz,然后进入conf目录修改配置文件zoo_sample.cfg,复制一份并改名zoo.cfg(这是默认名称)

编辑zoo.cfg里面的dataDir=/tmp/zookeeper(把这个路径换成windows带盘符的路径,单机版就改这么一点,集群版参考下面的Linux环境下集群,原理一样.)

(2).win上启动zookeeper,进入bin目录双击zkServer.cmd即可(不要关闭控制台),启动客户端连接zookeeper,双击zkCli.cmd,然后回车即可(看到[zk: localhost:2181(CONNECTED) 0]表示成功),输入ls / 查看zookeeper里面内容,具体命令下面Linux环境下搭建时讲.

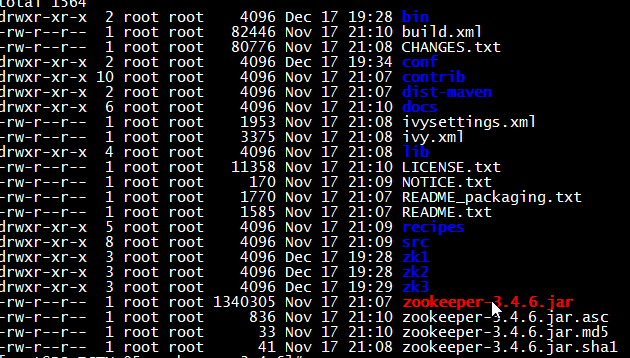

解压目录结构:

正式在Linux(centOS)上搭建zookeeper单机和集群版(伪):

1.准备软件:zookeeper-3.4.6.tar.gz,jdk-8u60-linux-i586.tar.gz(jdk6以上都可以,32/64位自己根据Linux系统决定)

2.单机安装(#之后是命令,命令后面命令含义)

$ mkdir /java/ #建目录 $ tar -zxvf jdk-8u60-linux-i586.tar.gz -C /java/ #把jdk加压到/java目录 $ tar -zxvf zookeeper-3.4.6.tar.gz -C /java/ #把zookeeper也解压到/java目录

配置java环境变量(全局的);当然你可以自己修改用户的环境变量,在自己机器上玩不讲究这些,用公司服务器就要按要求来.

$ vim /etc/profile #修改配置文件 #在文件最后添加两行: JAVA_HOME=/java/jdk1.8.0_60 export PATH=$JAVA_HOME/bin:$PATH #保存退出(vi命令不熟悉百度) $ source /etc/profile #重新加载刚修改的配置文件 $ java -version #查看java环境变量是否成功

修改zookeeper配置文件

$ cd /java/zk1/zookeeper-3.4.6/ #进入zookeeper解压目录 $ ll #查看解压目录下文件和目录结构(也可以使用ls -al命令) $ cd conf/ #进入配置文件存放目录 $ ls -al #查看配置文件有哪些 $ cp zoo_sample.cfg zoo.cfg #把这个配置文件示例复制一份并命名为zoo.cfg(默认名称,可以自己取,自己取名zk.cfg在启动时需要指定配置文件位置和名称)

现在配置文件基本不需要修改了,但是可以看看配置文件内容

#vim zoo.cfg查看或编辑配置文件(只要5个参数)

tickTime=2000

这个时间是作为 Zookeeper 服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每隔tickTime 时间就会发送一个心跳。

initLimit=10

这个配置项是用来配置 Zookeeper 接受客户端(这里所说的客户端不是用户连接 Zookeeper 服务器的客户端,而是 Zookeeper 服务器集群中连接到 Leader 的 Follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。当已经超过 10 个心跳的时间(也就是 tickTime)长度后 Zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是 5*2000=10 秒。

syncLimit=5

这个配置项标识 Leader 与 Follower 之间发送消息,请求和应答时间长度,最长不能超过多少个 tickTime 的时间长度,总的时间长度就是 2*2000=4 秒。

dataDir=/tmp/zookeeper

顾名思义就是 Zookeeper 保存数据的目录,默认情况下,Zookeeper 将写数据的日志文件也保存在这个目录里。

clientPort=2181这个端口就是客户端连接 Zookeeper 服务器的端口,Zookeeper 会监听这个端口,接受客户端的访问请求。

3.启动zookeeper服务端

#cd ..退到上级目录,可以看到(conf的同级目录bin)

#cd bin/进入bin目录

#./zkServer.sh start ../conf/zoo.cfg启动zookeeper服务端(如果配置文件名称就是zoo.cfg可以直接写./zkServer.sh start)

启动信息(sh bin/zkServer.sh restart重启)

JMX enabled by default

Using config: ../conf/zoo.cfg

Starting zookeeper ... STARTED

#jps查看java进程(zookeeper基于java平台算java进程)

进程中显示

3109 Jps

3099 QuorumPeerMain这就是zookeeper进程(启动成功)

4.连zookeeper客户端

#./zkCli.shstart启动客户端连接本机zookeeper(集群连接方式需指定server[./zkCli.sh -server 192.168.101.10:2181])

zookeeper命令

help查看zookeeper帮助

ls /查看zookeeper下有哪些东西

ls2 /查看当前节点数据并能看到更新次数等数据

create /zk "zz"创建zk节点,关联字符串"zz"

get /zk查看节点内容(数据大小,创建时间,版本之类的信息)

set /zk abc设置节点内容(如果有数据会被覆盖)

delete /zk删除节点

quit退出客户端

5.zookeeper集群搭建

1.和单机一样解压一份

2.伪集群搭建(和真集群没多大区别,只是在一台机器上启动3个zookeeper实例)

zookeeper内部有个选举机制,所以zookeeper集群需要计数台服务器(最少3台,3,5,7,9......)

3.一台机器通过该端口实现同时启动3个实例

创建3个zookeeper目录

#mkdir -p /java/zk1在java目录下创建zk1目录

#mkdir -p /java/zk2在java目录下创建zk2目录

#mkdir -p /java/zk3在java目录下创建zk3目录

把单机的zookeeper复制三份放入刚建的3个目录

#cp -r zookeeper-3.4.6/ zk1

#cp -r zookeeper-3.4.6/ zk2

#cp -r zookeeper-3.4.6/ zk3

创建3个zookeeper临时文件存放目录

#mkdir -p /java/data1在java目录下创建data1目录

#mkdir -p /java/data2在java目录下创建data2目录

#mkdir -p /java/data3在java目录下创建data3目录

echo "1">/java/data1/myid在目录新建myid文件分别写入对应id(1,2,3给zookeeper做一个标识)

echo "2">/java/data2/myid

echo "3">/java/data3/myid

4.修改zookeeper配置文件(支持集群)

#cd /java/zk1/zookeeper-3.4.6/conf/进入zk1配置文件目录

vim zoo.cfg修改配置文件

dataDir=/java/data1修改临时文件目录

clientPort=2181修改端口(3个不一样就行)

***添加几行***

server.1=192.168.101.10:2888:3888ip是本机ip,伪集群端口3台不一样(如果是3台机器,ip为每个机器ip,端口2888:3888可以都是这个),server.1和myid文件内容id一致

server.2=192.168.101.10:2889:3889

server.3=192.168.101.10:2890:3890

同理修改另两个zookeeper配置文件

dataDir分别指向我们自己建的3个data目录data1,data2,data3

clientPort三个zookeeper在一台机器上,端口必须不同,搭建在三台服务器上可以都是2181

都需要添加后面几行,指定集群其他机器ip和端口

5.集群测试

启动三台zookeeper

#cd /java/zk1/zookeeper-3.4.6/bin 进入各自的bin目录执行如下命令

#./zkServer.sh start ../conf/zoo.cfg启动服务

#jps

三台都启动后就会出现3个zookeeper进程

3188 QuorumPeerMain

3099 QuorumPeerMain

3227 Jps

3135 QuorumPeerMain

怎么知道谁是leader,谁是follower?

在各自的bin下执行如下命令

#./zkServer.sh status查看服务状态

显示信息(follower):

JMX enabled by default

Using config: ../conf/zoo.cfg

Mode: follower

显示信息(leader):

JMX enabled by default

Using config: ../conf/zoo.cfg

Mode: leader

#./zkServer.sh restart重启

#./zkServer.sh stop停止zookeeper服务

6.客户端连接集群

./zkCli.sh -server 192.168.101.10:2181在bin目录下执行(连接具体的zookeeper)

7.java接口测试zookeeper

请看测试代码zookeeper-test.rar(如果看不懂控制台信息,请System.out)

3分钟搞定

第二次搭建zookeeper集群时的思想(实现更简单):

伪集群一份zookeeper,多份配置文件:

单机和集群全在一台机器上同时运行;

configuration.xsl

log4j.properties

zoo1.cfg

zoo2.cfg 123是集群

zoo3.cfg

zoo.cfg默认单机

zoo_sample.cfg自带

cd /opt/zookeeper-3.4.6/mkdir zk1

mkdir zk2

mkdir zk3

echo "1">zk1/myid

echo "2">zk2/myid

echo "3">zk3/myid

修改配置文件夹(照葫芦画瓢):斜体部分

# The number of milliseconds of each ticktickTime=2000# The number of ticks that the initial# synchronization phase can takeinitLimit=10# The number of ticks that can pass between# sending a request and getting an acknowledgementsyncLimit=5# the directory where the snapshot is stored.# do not use /tmp for storage, /tmp here is just# example sakes.dataDir=/opt/zookeeper-3.4.6/zk1# the port at which the clients will connectclientPort=2182server.1=192.168.20.205:2888:3888server.2=192.168.20.205:2889:3889server.1=192.168.20.205:2890:3890# the maximum number of client connections.# increase this if you need to handle more clients#maxClientCnxns=60## Be sure to read the maintenance section of the# administrator guide before turning on autopurge.## http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance## The number of snapshots to retain in dataDir#autopurge.snapRetainCount=3# Purge task interval in hours# Set to "0" to disable auto purge feature#autopurge.purgeInterval=1

#启动集群,指定配置文件:

./zkServer.sh start ../conf/zoo1.cfg

./zkServer.sh start ../conf/zoo2.cfg

./zkServer.sh start ../conf/zoo3.cfg

#查看集群启动状态,指定配置文件夹:

./zkServer.sh status ../conf/zoo1.cfg

./zkServer.sh status ../conf/zoo2.cfg

./zkServer.sh status ../conf/zoo3.cfg

#客户端连接集群:

./zkCli.sh -server 192.168.20.205:2182

./zkCli.sh -server 192.168.20.205:2183

./zkCli.sh -server 192.168.20.205:2184

#启动单机版

./zkServer.sh start

./zkServer.sh status

#客户端连接单机:(默认使用zoo.cfg配置文件)

./zkCli.sh