之前深度学习中一般只在卷积中涉及到padding:

tf.nn.conv2d(x,W,strides=[1,1,1,1],padding="SAME")

现在在Tensorflow学习过程中,发现在池化过程中,大量应用到SAME填充:

tf.nn.max_pool(x,[1,2,2,1],strides=[1,2,2,1],padding="SAME")

现在我们来看看池化过程中padding到底是如何工作的?

卷积填充了解:http://www.ai-start.com/dl2017/html/lesson4-week1.html

参考:https://blog.csdn.net/sky_asher/article/details/79704262

一:池化层SAME Padding

(一)案例一:可被池化层filter整除

a = tf.get_variable('w', shape=(1,4,4,1), initializer=tf.truncated_normal_initializer(seed=1)) b = tf.nn.max_pool(a, ksize=[1,2,2,1], strides=[1,2,2,1], padding='VALID') c = tf.nn.max_pool(a, ksize=[1,2,2,1], strides=[1,2,2,1], padding='SAME') with tf.Session() as sess: sess.run(tf.global_variables_initializer()) out_b = sess.run(b) out_c = sess.run(c) print(out_b.shape, out_c.shape)

在这里刚好是4 % 2 = 0,也就是池化的模板的长度能够待处理的数据长度整除,所以两者的结果是相同的。

(二)案例二:不可被池化层filter整除

a = tf.get_variable('w', shape=(1,3,3,1), initializer=tf.truncated_normal_initializer(seed=1)) b = tf.nn.max_pool(a, ksize=[1,2,2,1], strides=[1,2,2,1], padding='VALID') c = tf.nn.max_pool(a, ksize=[1,2,2,1], strides=[1,2,2,1], padding='SAME') with tf.Session() as sess: sess.run(tf.global_variables_initializer()) out_b = sess.run(b) out_c = sess.run(c) print(out_b.shape, out_c.shape)

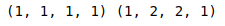

这里就不一样了,因为模板在滑动时,可能存在覆盖不完全的地方,就比如用2*2的模板,对于VALID模式和SAME模式就不一样,SAME模式会补全橙色部分,而VALID模式就不会补全了

VALID不进行填充:会有数据无法遍历

SAME会向左和下填充0(这里不同与卷积的处理):但是都会使得原矩阵中的数据被遍历到

二:实例说明

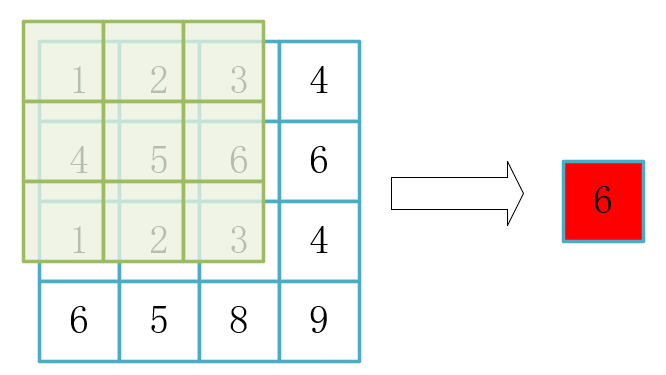

same会根据具体的步长和核大小去尽量遍历特征图,因为可以填充这个周边的范围。

(一)代码演示

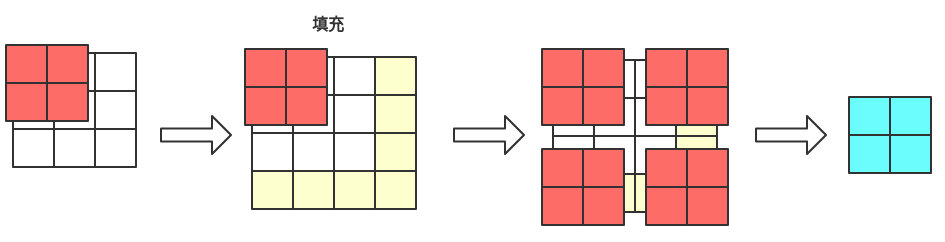

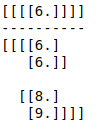

x = tf.constant([[1., 2., 3., 5.], [4., 5., 6., 6.], [1 , 2 , 3 , 4 ], [6 , 5 , 8 , 9 ]]) x = tf.reshape(x, [1, 4, 4, 1]) valid_pad = tf.nn.max_pool(x, [1, 3, 3, 1], [1, 2, 2, 1], padding='VALID') same_pad = tf.nn.max_pool(x, [1, 3, 3, 1], [1, 2, 2, 1], padding='SAME') with tf.Session() as sess: print(sess.run(valid_pad)) print("----------") print(sess.run(same_pad))

(二)Valid填充

(三)Same填充