首先,什么是scrapy?

文档地址:http://scrapy-chs.readthedocs.io/zh_CN/1.0/intro/overview.html

Scrapy 使用了Twisted['twɪstɪd]异步网络框架,可以加快我们的下载速度。

说到异步:调用在发出之后,这个调用就直接返回,不管有无结果;异步是过程。 非阻塞:关注的是程序在等待调用结果(消息,返回值)时的状态,

指在不能立刻得到结果之前,该调用不会阻塞当前线程。

下面我们了解下scrapy的工作流程:

调度器把requests-->引擎-->下载中间件--->下载器

下载器发送请求,获取响应---->下载中间件---->引擎--->爬虫中间件--->爬虫

爬虫提取url地址,组装成request对象---->爬虫中间件--->引擎--->调度器

爬虫提取数据--->引擎--->管道

管道进行数据的处理和保存

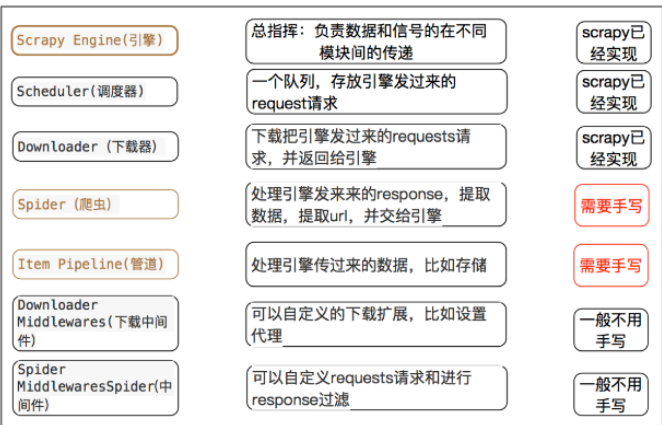

下面一张图可以帮助我们知道框架里每个模块的具体作用:

scrapy框架的作用:通过少量代码实现快速抓取

掌握scrapy中每个模块的作用: 引擎(engine):负责数据和信号在不腰痛模块间的传递 调度器(scheduler):实现一个队列,存放引擎发过来的request请求对象 下载器(downloader):发送引擎发过来的request请求,获取响应,并将响应交给引擎 爬虫(spider):处理引擎发过来的response,提取数据,提取url,并交给引擎 管道(pipeline):处理引擎传递过来的数据,比如存储 下载中间件(downloader middleware):可以自定义的下载扩展,比如设置代理ip 爬虫中间件(spider middleware):可以自定义request请求和进行response过滤

理解异步和非阻塞的区别:异步是过程,非阻塞是状态

创建scrapy的项目: scrapy startproject myspider

创建scrapy爬虫:在项目目录下执行 scrapy genspider itcast itcast.cn

运行scrapy爬虫:在项目目录下执行 scrapy crawl itcast

以下代码是一个简单的爬取博客内容:

# -*- coding: utf-8 -*-

import scrapy

class MoviesSpider(scrapy.Spider):

name = 'movies'

allowed_domains = ['zifangsky.cn']

start_urls = ['http://zifangsky.cn']

def parse(self, response):

# with open("zuoye.html","w",encoding="utf8") as f:

# f.write(response.text)

mes = response.xpath("//article[@class='well clearfix']")

for i in mes:

l_dict = {}

l_dict['title'] = i.xpath("./header/h1/a/text()").extract_first()

l_dict['text'] = i.xpath("./div[@class='entry-summary entry-content clearfix']/p/text()").extract_first()

print(dict)

yield l_dict

try:

next_pag = response.xpath("//a[text()='2']/@href")

执行时注意在settings.py设置开启

pipeline ITEM_PIPELINES = {

'myspider.pipelines.ItcastPipeline': 400

}

可以在settings中设置ROBOTS协议 # False表示忽略网站的robots.txt协议,默认为True

ROBOTSTXT_OBEY = False

爬虫就是根据你的需求爬去你想要的内容,而框架实现的是对爬虫效率的提升,用少量的代码完成你的需求

这也是scrpy受欢迎之处