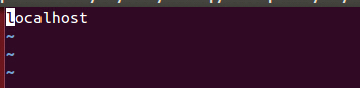

第四步修改配置文件slaves,如下所示:

我们设置Hadoop集群中的从节点为SparkWorker1和SparkWorker2,把slaves文件的内容修改为:

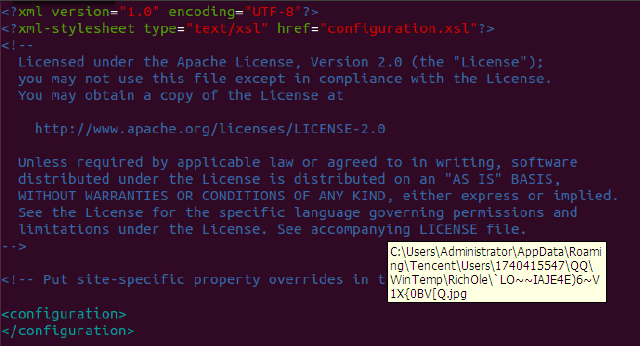

第五步修改配置文件core-site.xml,如下所示:

把core-site.xml文件的内容修改为:

上述是core-site.xml文件的最小化配置,core-site.xml各项配置可参考:

http://hadoop.apache.org/docs/r2.2.0/hadoop-project-dist/hadoop-hdfs/hdfs-default.xml

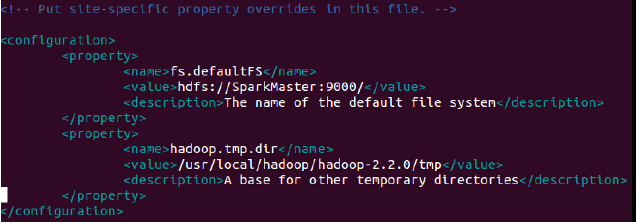

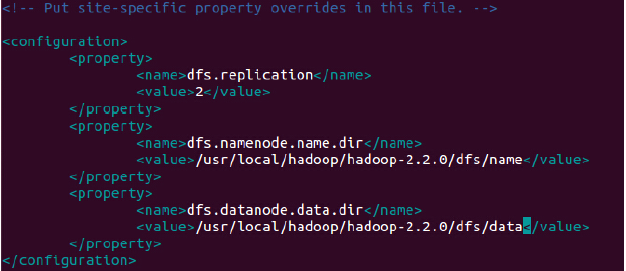

第六步修改配置文件hdfs-site.xml,如下所示:

把hdfs-site.xml文件的内容修改为:

上述是hdfs-site.xml文件的最小化配置,hdfs-site.xml各项配置课参考:

http://hadoop.apache.org/docs/r2.2.0/hadoop-project-dist/hadoop-hdfs/hdfs-default.xml

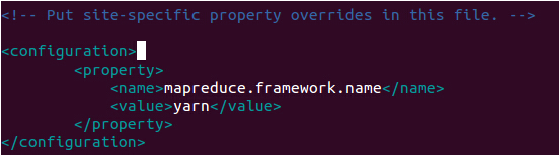

第七步修改配置文件mapred-site.xml,如下所示:

拷贝一份mapred-site.xml.template命名为mapred-site.xml,打开mapred-site.xml

把mapred-site.xml文件的内容修改为:

上述是mapred-site.xml最小化配置,mapred-site.xml各项配置可参考:

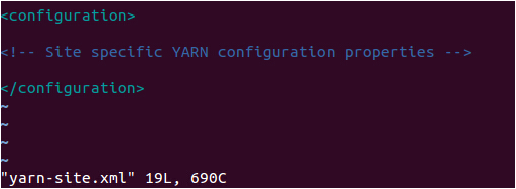

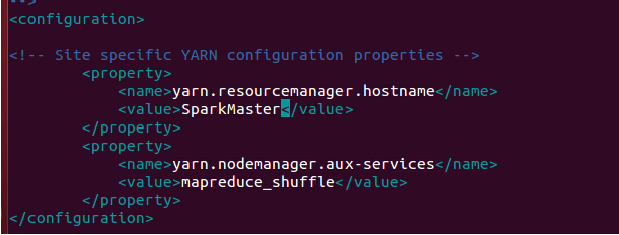

第七步修改配置文件yarn-site.xml,如下所示:

把yarn-site.xml的内容修改为:

上述内容是yarn-site.xml的最小化配置,yarn-site.xml文件配置的各项内容可以参考:

http://hadoop.apache.org/docs/r2.2.0/hadoop-yarn/hadoop-yarn-common/yarn-default.xml