对于新司机,可能看到sc与spark不知道是什么,看图知意

***************************************************************************************************************************************

DataFrame.map(_.split("::"))报错 error: value split is not a member of org.apache.spark.sql.Row

看到下图红框报错处Row,想起DataFrame里的Row对象,虽然每一行是一列数据,但是需要将Row对象转换成String对象,才可以走split方法

看下图,

spark.read.json返回类型是DataFrame

spark.read.textFile返回类型是Dataset

***************************************************************************************************************************************

由于 RDD、DataFrame、DataSets 之间是可以相互转化的,所以可通过多种方式读取数据,并进行互相进行转化

如下图:

***************************************************************************************************************************************

接下来这是另一个错,算是,恩,算是什么呢?

***************************************************************************************************************************************

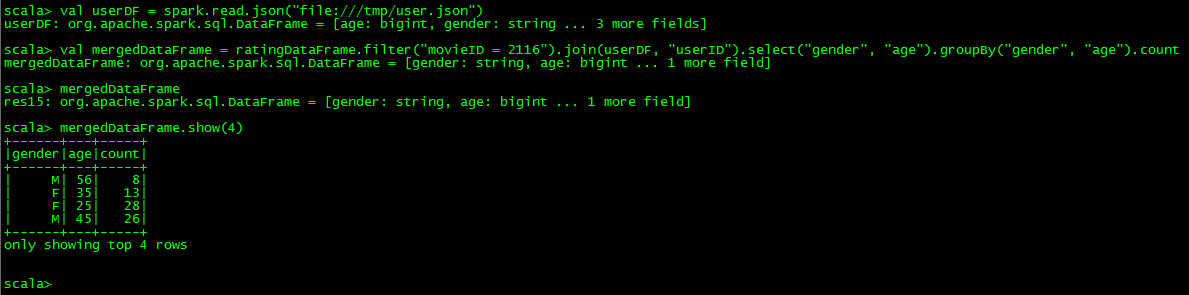

来看一个join的例子

或者使用下面的方式,如果用左联接的话,只需要将inner改为leftouter

***************************************************************************************************************************************

创建临时表

***************************************************************************************************************************************

创建全局表