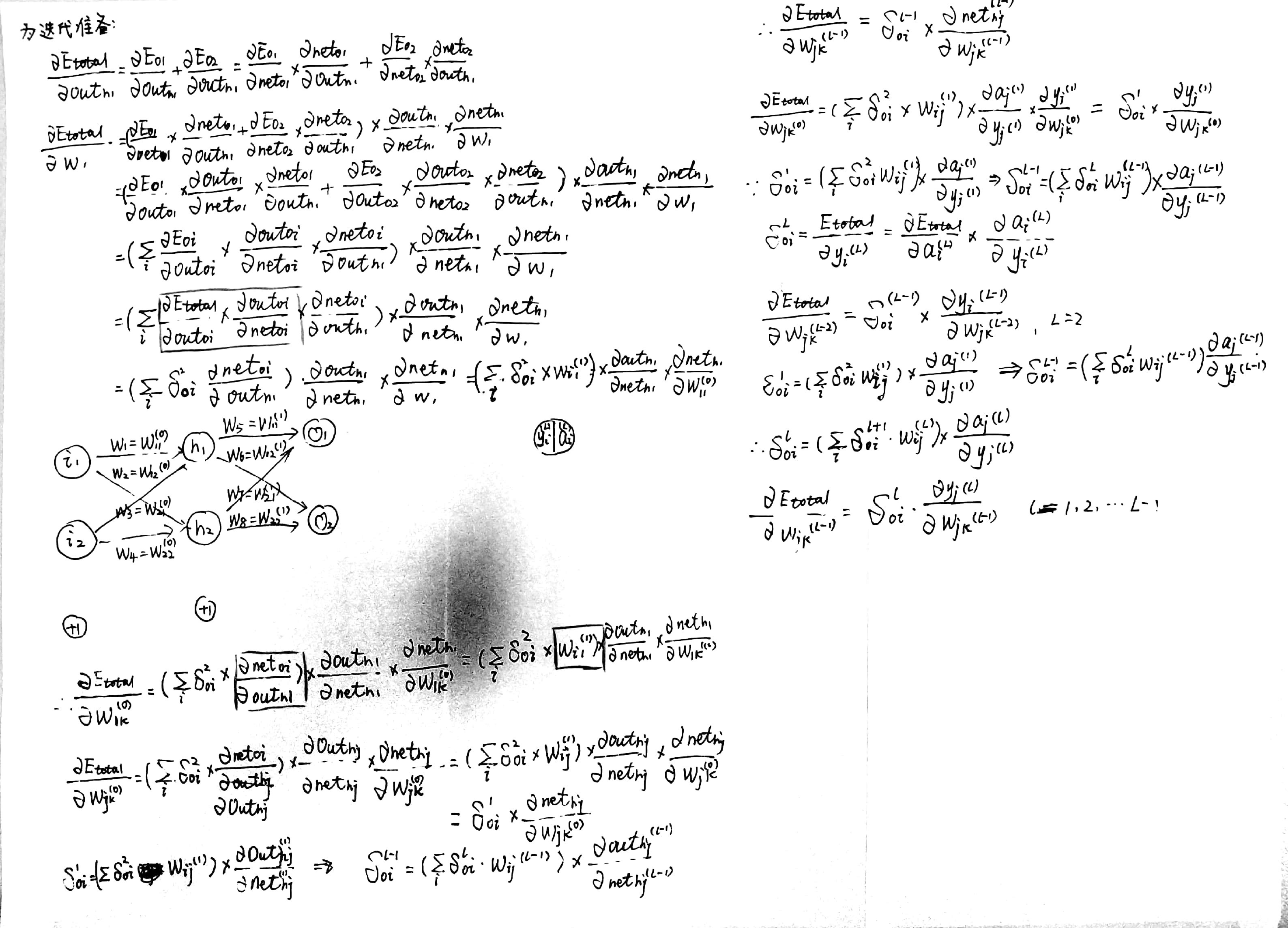

今天花了大半天的时间,把三层神经网络,自己推导了一遍。对于其基础思想有了一定的了解,特写此文记录下。

首先介绍基本概念,三层分别为输入层、隐含层和输出层。横线箭头为权重。所要最求的目的就是,在此网络下的输出与真实的输出尽可能的接近。

其中截距项的作用:拟合平面上的一些点,的普适性肯定比

好,能够是的所拟合的线平移。

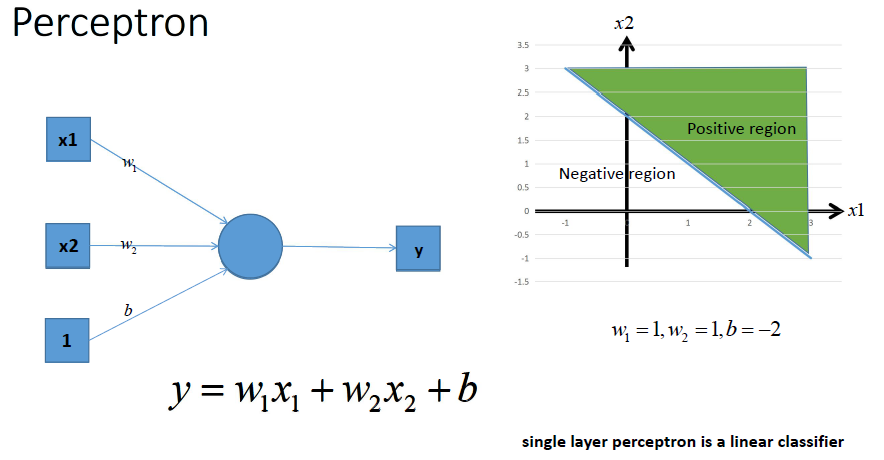

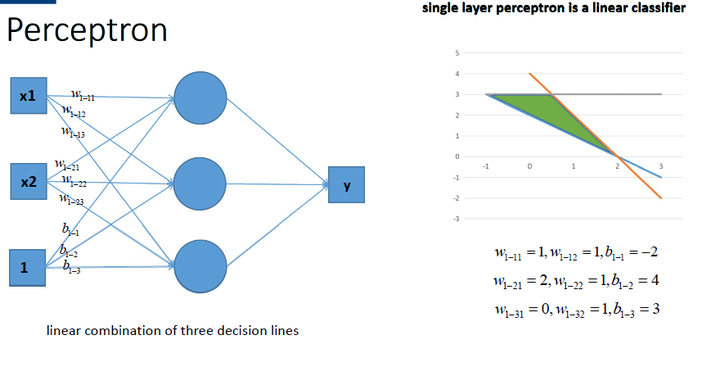

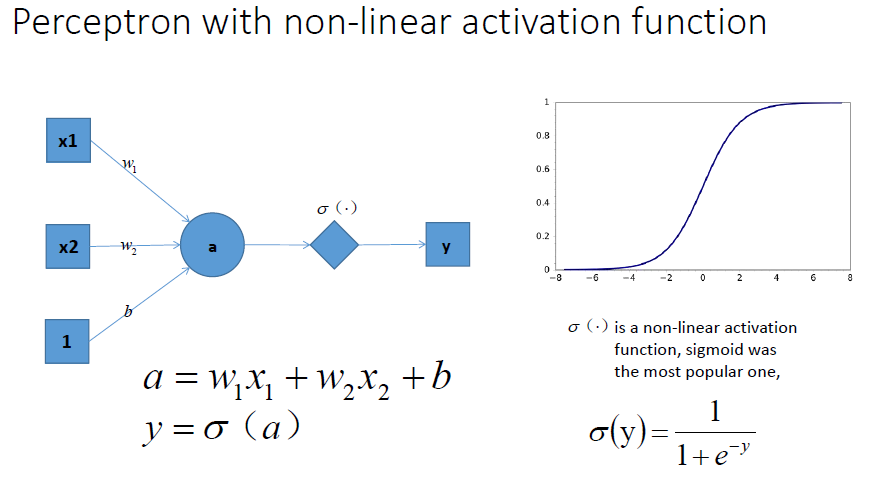

激活函数的作用(引用知乎大神解释,贼好理解https://www.zhihu.com/question/22334626):单层感知机的含义如图,即利用w1,w2,和b构成的直线,将平面分隔为两部分,绿色部分为需要部分

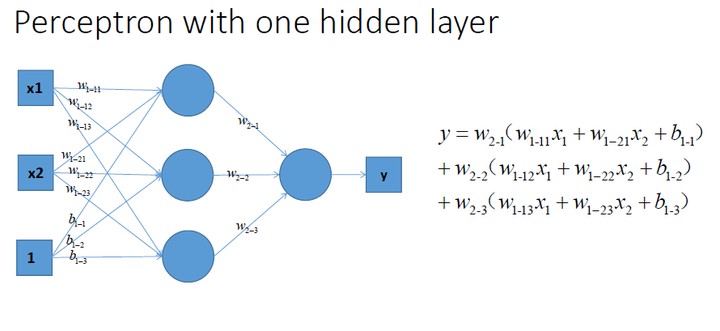

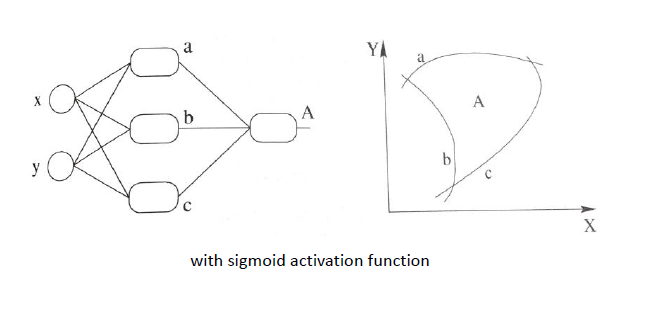

因而多层感知机可以将空间分的更精细,有更强的分类能力。但是有木有发现一个问题,前面两种情况的分类都是用直线进行分隔,无论如何都还是一个线性方程

如何得到非现行分类器呢,这就要用到激活函数,激活函数的作用就在此。

有这两图可见,由于有了激励函数的加入,线性空间变为非线性空间,此时分类器的表达能力也就更强了,当在多维空间时,想必比线性空间有更好的效果。当然激活函数有很多,我会慢慢学习记录。

交叉熵的作用(交叉熵并没有写在草稿纸上):用来衡量在给定的真实分布下,使用非真实分布所指定的策略消除系统的不确定性所需要付出的努力的大小。总的来说就是判定网络预测结果与正确结果的差距,以此来反向传播不断的来修正权值。理解不了可以看这个https://www.zhihu.com/question/41252833。

记录今天的学习内容,为了便于理解,有图文参考知乎,出处已贴,侵删