常见的代价函数

代价函数(cost fuction,也称损失函数或优化目标)是出现在监督学习模型中,在已知的标签y的情况下,根据h(x)得到的预测值计算学习算法要到达真实情况所需要付出的代价

P. S. 不熟悉常见监督学习模型可以看吴恩达机器学习系列课程笔记——监督学习常见模型

通过最小化代价函数可以得到算法的最优解,从而训练更有效的模型

其中代价函数被期望得到的是凸函数(convex function,也称单弓形函数),而不是非凸函数(non-convex),因为后者拥有众多局部最低点,导致算法可能无法获得全局最优解

非凸函数和凸函数

1. 平方误差代价函数(Square Error Cost Function)

该代价函数常在回归问题中使用

对于线性回归模型来说,为使得预测值与实际值更好的拟合,最简单的办法即求得预测与实际之间的垂直距离,并使其逐渐减小到合适的距离

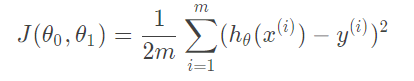

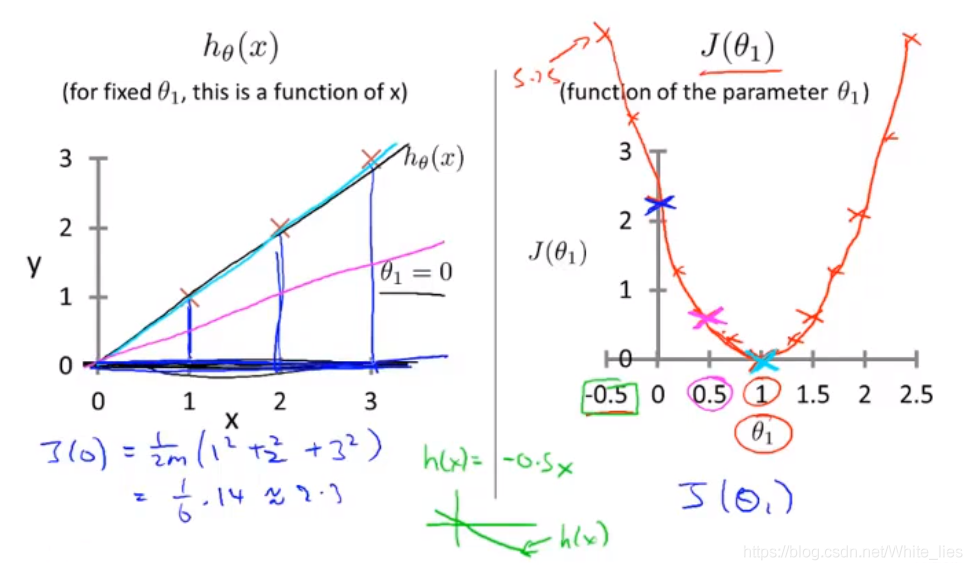

因此使用平方误差函数作为代价函数的核心,下面是只考虑特征θ0(偏差)和θ1的单变量线性回归代价函数公式

简化参数后的假设函数与代价函数示例图

多元线性回归模型的代价函数即为单变量的拓展,对于特征θ公式为

感兴趣的同学可以看多元线性回归的代价函数推导

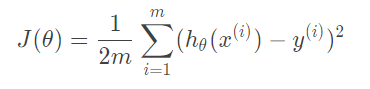

二元变量的线性回归模型的代价函数如下图所示,同样也是凸函数

二维代价函数立体图

为方便理解,可以通过绘制等高线图观察平方差代价函数,如下图所示

等高线示意图