这里聊聊统计模式识别中的基本概念。

首先,考虑字符识别的问题(图1),目标是最小化错分概率。当收集大量数据(如图像)之后,可以算出某字符图像所占的比例,且这个玩意可以表示为先验概率![]() 。 当我们猜一个图像(未看到图像)对应字符时,如果

。 当我们猜一个图像(未看到图像)对应字符时,如果![]() ,一般会将其归为类

,一般会将其归为类![]() 对应的字符。这会最小化误分概率,基本我们知道会存在错分的情况。

对应的字符。这会最小化误分概率,基本我们知道会存在错分的情况。

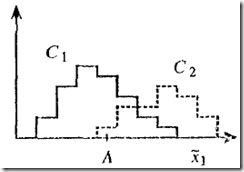

进一步,将图像转换为特征变量![]() (字符高度与宽度比值),这会给分类决策带来更多信息(如图2)。C2类字符

(字符高度与宽度比值),这会给分类决策带来更多信息(如图2)。C2类字符![]() 值大,两类概率直方图有重叠。对与A点,它更有可能属于类C1。

值大,两类概率直方图有重叠。对与A点,它更有可能属于类C1。

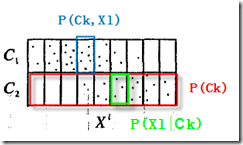

关键是如何构造一种机制,将特征变量信息同先验概率有效结合。首先将![]() 离散化为集合

离散化为集合![]() ,然后将图2信息转换为单元阵列形式(图3),其中

,然后将图2信息转换为单元阵列形式(图3),其中

1)联合概率

:图像的特征变量值为

且属于类Ck的概率。这等于一个图像掉到某个单元(蓝色框)的比例

上面图像其实也告诉了我们联合概率与先验概率和条件概率的关系。从图可见,图像掉到某单元![]() 的比例(联合概率)=它掉到某行比例(先验概率)*限定为某行下掉到某单元

的比例(联合概率)=它掉到某行比例(先验概率)*限定为某行下掉到某单元![]() 的比例(条件概率),即

的比例(条件概率),即

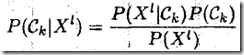

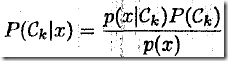

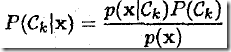

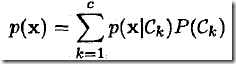

同样,有![]() 。因为前面两式相等,因此得到著名的贝叶斯定理

。因为前面两式相等,因此得到著名的贝叶斯定理

后验概率可是关键东东(月光宝盒机),有了它我们可以分析新数据隶属某类概率,进而作出合理决策。比如,将新图像归为最大后验概率类可最小化误分概率。

1.推断和决策(Inference and decision)

很多时候,训练数据中概率分布与新数据中概率分布不同。比如,考虑用X光图像识别的是“正常组织”(类C1)还是“腫瘤”(类C1)的问题。从医学统计来看P(C1)=0.99,P(C2)=0.01。当收集训练数据时,总是收集数量相等的两类图像以保障能充分反应肿瘤图像的特点,而不是去收集非常大量的图像。这时候,应该使用医学统计结果来构造先验,而不是从训练数据中计算。

因而,统计模式识别方法之一就是分别计算先验概率和类条件概率,然后用贝叶斯准则将它们结合起来构造出后验概率(这就是generative methods);另一种方法就是直接计算后验概率(即distriminative methods)

正确区分分类过程的两个阶段很重要(这里关注错分概率最小):

1)首先是推断(inference):利用数据确定后验概率

2)然后是决策(decision making):利用后验概率做决策

2.贝叶斯统计VS频率统计

关于此主题的讨论很多,请看下面资料

1)Jordan非常精彩的论述,他的建议是充分理解两者,并合理利用。(该报告本人未完全听懂,有贤人能理解的请发表见解)

2)其他

http://www.sciencenet.cn/m/Print.aspx?id=11526

3.概率密度

前面通过将连续值变量离散化为有限值集合来计算概率,但这样并不方便。对于连续值变量通过概率密度来描述。

基本的概念这里就不费口舌了。

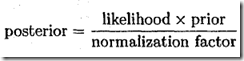

4.贝叶斯定理

一公式以蔽之

对应前面介绍的两类问题

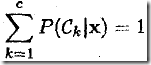

扩展到多类问题