学校的网比较特殊(本人比较菜),需要DHCP获得地址,那么有时候IP被占用了,应该如何应对呢?

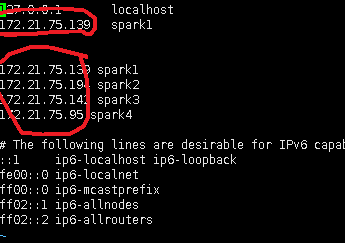

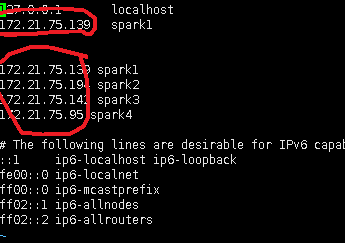

1)修改/etc/hosts

2) 修改spark-env.sh 里的 Master 地址 ,Master对应spark1 的地址 ,source使其 生效

3)hdfs启动若有问题,则删掉 tmp ,data 重新建立相应文件夹,并且格式化 namenode #hadoop namenode -format,再启动就好

按照以上步骤处理完毕,应该就没问题了

学校的网比较特殊(本人比较菜),需要DHCP获得地址,那么有时候IP被占用了,应该如何应对呢?

1)修改/etc/hosts

2) 修改spark-env.sh 里的 Master 地址 ,Master对应spark1 的地址 ,source使其 生效

3)hdfs启动若有问题,则删掉 tmp ,data 重新建立相应文件夹,并且格式化 namenode #hadoop namenode -format,再启动就好

按照以上步骤处理完毕,应该就没问题了