-

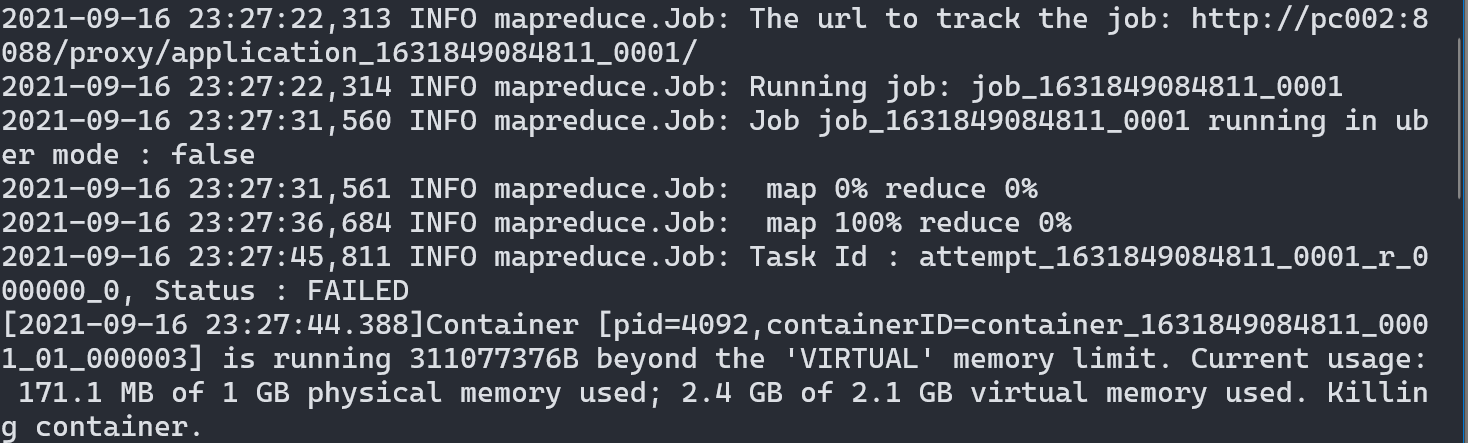

报错信息如下

-

原因分析

集群中运行的container尝试使用更多的内存 ,但是被NodeManager给中断了

-

解决措施

配置所需内存大小

在

/opt/software/hadoop-3.1.3/etc/hadoop/下的mapred-site.xml中添加如下配置:(其中的数字大小可以根据自己电脑的内存大小情况更改)<!-- 以下对标:2GB内存,2核心--> <property> <name>mapreduce.map.memory.mb</name> <value>1024</value> </property> <property> <name>mapreduce.map.java.opts</name> <value>-Xmx1024M</value> </property> <property> <name>mapreduce.reduce.memory.mb</name> <value>1024</value> </property> <property> <name>mapreduce.reduce.java.opts</name> <value>-Xmx1024M</value> </property>