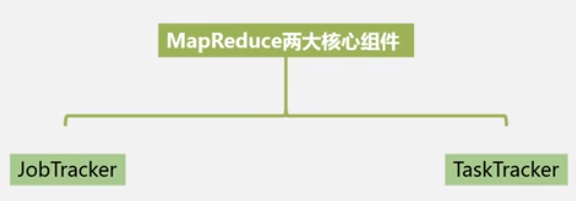

JobTracker 分配工作给若干机器.

TaskTracker: 负责监督

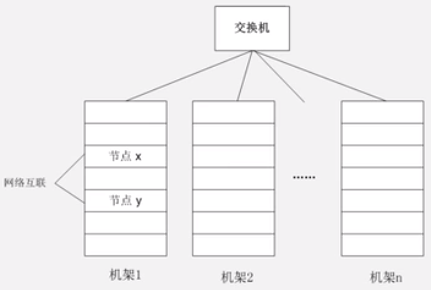

光纤交换机.

块的概念: 一个块 64M. 还可以是 128M. 大文件切割成这种小块, 然后分布存储在不同机器上. 当然也可以并行处理.

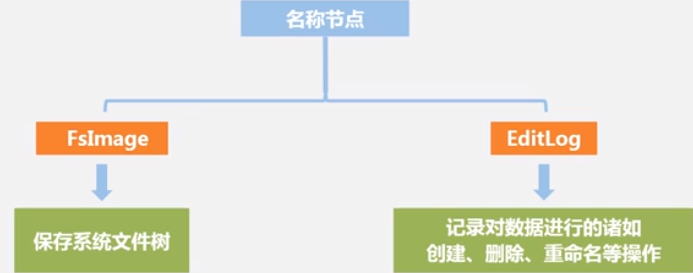

名称节点: 整个 HDFS 集群管家, 负责元数据的存储. (index 数据块),相当于数据目录

数据节点: 存储普通数据的. 保存在本地的 linux 系统中.

HDFS 启动流程

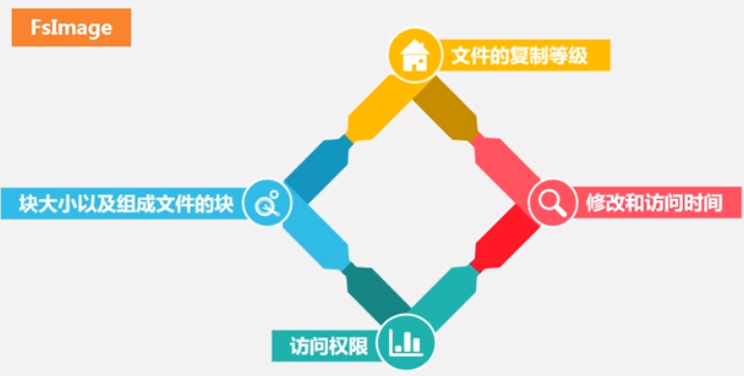

启动, 将 FsImage 和 EditLog 加载到内存进行合并, 得到最新的元数据, 然后创建新版的FsImage,创建一个空的 EditLog.

FsImage 一直不变, EditLog 不断增大, 因为在 FsImage 的修改, 都记录在 Editlog 中.

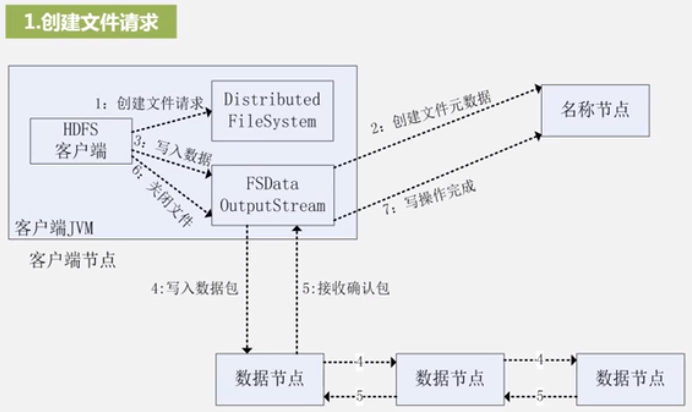

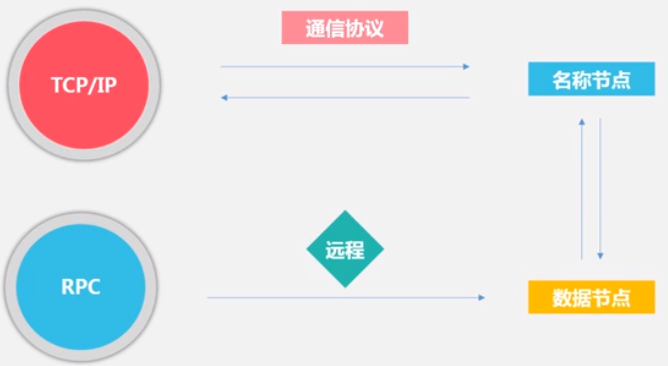

客户端 -> 名称节点: TCP/IP

客户端->数据节点取数据: RPC 远程调用.

这个客户端指的是 hadoop 的客户端, 用户需要访问这个客户端接口来做操作.

名称节点: 有热备.

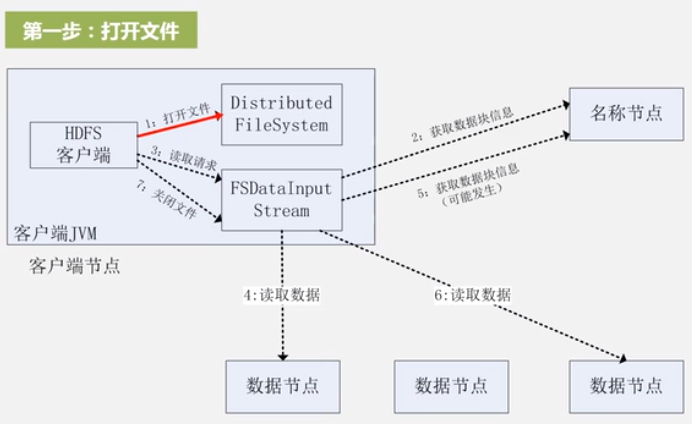

读数据

写数据