一、crawl()方法学习:

1、url:爬去是的url,可以定义单个,可以定义为url列表。

2、callback:回调函数,指定该url使用哪个方法来解析。

3、age:任务的有效时间。

4、priority:爬取任务的优先级,值越大,对应的请求越会优先被调度。

5、retries:定义重试次数,默认值是3.

6、itag:设置判定网页是否发生变化的节点值,在爬取时会啊判定当前节点是否和上次爬去的节点相同。

7、auto_recrawl:

8、method:是http请求的方式,他默认是get,如果想发起post请求,可以将method设置为post。

9、params:用params定义get方式请求的参数(为字典格式)。

10、data:用此参数传递post方式提交的表单数据。

11、files:上传文件,需要指定文件名。

12、user-agent:爬取时使用的use-agent。

13、headers:爬取时使用的headers。

14、cookies:爬取使用的cookies,为字典格式。

15、proxy:爬取时使用的代理。

16、fetch_type:会开启phantomJS渲染。

17、js_script:页面加载完毕之后的JavaScript脚本。

18、Save:用于在不同方法之间传递参数。

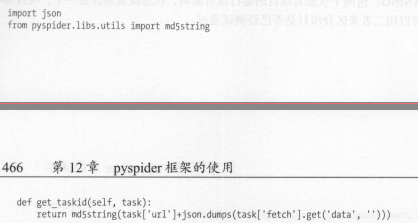

二、任务区分:

1、pyspider判断两个任务:url的MD5值对应任务的唯一id。

修改计算id的方式来实现不同的任务区分:

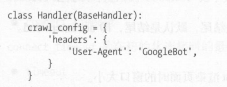

2、全局配置:

3、定时爬取: