- 集群概念

- 简单的说,集群就是指一组(若干个)相互独立的计算机,利用高速通信网络组成的一个较大的计算机服务系统,每个集群节点(即集群中的每台计算机) 都是运行各自服务的独立服务器,这些服务器之间可以彼此通信,协同向用户提供应用程序,系统资源和数据,并以单一系统的模式加以管理.当用户客户机请求集群系统时,集群给用户的感觉就是一个单一独立的服务器,而实际上用户请求的是一组集群服务器.

- 打开谷歌,百度的页面,看起来简单,也许你觉得用几分钟就可以制作出相似的网页,而实际上,这个页面的背后是由成千上万台服务器集群协同工作的结果.而这么多的服务器维护和管理,以及相互协调工作也许就是读者你未来的工作指责了.

- 若要用一句话描述集群,即一堆服务器合作做同一件事,这些机器可能需要整个技术团队架构,设计和统一协调管理,这些机器可以分布在一个机房,也可以分布在全国全球各个地区的多个机房.

- 为什么要用集群

- 高性能

- 价格有效性

- 可伸缩性

- 高可用性

- 透密性

- nginx 负载均衡

- web服务器,直接面向用户,往往要承载大量并发请求,单台服务器难以负荷,我使用多台web服务器组成集群,前端使用nginx负载均衡,将请求分散的打到我们的后端服务器集群中,实现负载的分发,那么会大大提高系统的吞吐率,请求性能。

- nginx要实现负载均衡需要用到proxy_pass代理模块配置

- nginx负载均衡与nginx代理不同地方在于nginx代理仅代理一台服务器,而nginx负载均衡则是将客户端请求代理转发至一组upstream虚拟服务池

- nginx可以配置代理多台服务器,当一台服务器宕机之后,仍能保持系统可用

- upstream配置

- 在nginx.conf >http区域中

upstream django { server 10.0.0.10:8000; server 10.0.0.11:9000; }

- 在nginx.conf > http 区域 >server区域 >location配置中

- 添加proxy_pass

location / { root html; index index.html index.htm; proxy_pass http://django; }

此时初步负载均衡已经完成, upstream默认按照轮询方式负载,每个请求按时间顺序逐一分配到后端节点.

- upstream分配策略

- weight权重

upstream django { server 10.0.0.10:8000 weight=5; server 10.0.0.11:9000 weight=10;#这个节点访问比率是大于8000的 }

- ip_hash

- 每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器

upstream django { ip_hash; server 10.0.0.10:8000; server 10.0.0.11:9000; }

- 负载均衡实验环境规划

角色 ip 主机名 lb01 192.168.119.10 lb01 web01 192.168.119.11 web01 web02 192.168.119.12 web02

- 关闭防火墙

iptables -F sed -i 's/enforcing/disabled/' /etc/selinux/config systemctl stop firewalld systemctl disable firewalld

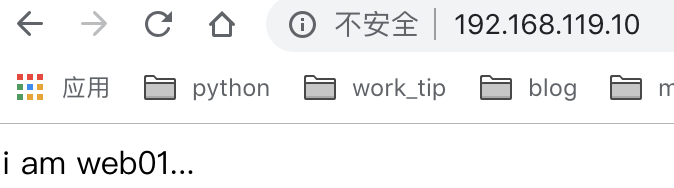

- web01服务器配置nginx,创建Index.html

server { listen 80; server_name 192.168.119.11; location / { root /node; index index.html index.htm; } } mkdir /node echo 'i am web01' > /node/index.html #启动NGINX ./sbgin/nginx

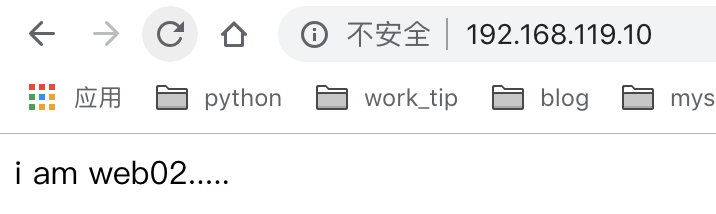

- web02服务器配置nginx,创建index.html

server { listen 80; server_name 192.168.119.12; location / { root /node; index index.html index.htm; } mkdir /node echo 'i am web02...' > /node/index.html #启动nginx ./sbing/nginx

- 配置ib01服务器的nginx负载均衡

http { include mime.types; default_type application/octet-stream; sendfile on; keepalive_timeout 65; upstream node { server 192.168.119.11:80; server 192.168.119.12:80; } server { listen 80; server_name 192.168.119.10; location / { proxy_pass http://node;

include proxy_params; #需要手动创建

} } }

- 手动创建proxy_params,文件中存放代理的请求头相关参数

[root@lb01 conf]# cat /opt/nginx/conf/proxy_params proxy_set_header Host $http_host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_connect_timeout 30; proxy_send_timeout 60; proxy_read_timeout 60; proxy_buffering on; proxy_buffer_size 32k; proxy_buffers 4 128k;

启动lb01负载均衡nginx服务

./sbin/nginx

- 访问ib01节点nginx,反复刷新

- nginx负载均衡调度算放

调度算法 概述

轮询 按时间顺序逐一分配到不同的后端服务器(默认)

weight 加权轮询,weight值越大,分配到的访问几率越高

ip_hash 每个请求按访问IP的hash结果分配,这样来自同一IP的固定访问一个后端服务器

url_hash 按照访问URL的hash结果来分配请求,是每个URL定向到同一个后端服务器

least_conn 最少链接数,那个机器链接数少就分发

1.轮询(不做配置,默认轮询)

2.weight权重(优先级)

3.ip_hash配置,根据客户端ip哈希分配,不能和weight一起用