卷积神经网络与迁移学习

目录:

卷积神经网络快速回顾

1.层级结构 2.数据处理 3.训练算法 4.优缺点

■ 典型CNN

1.AlexNet 2.GoogLeNet 3.VGG Net 4.ResNet

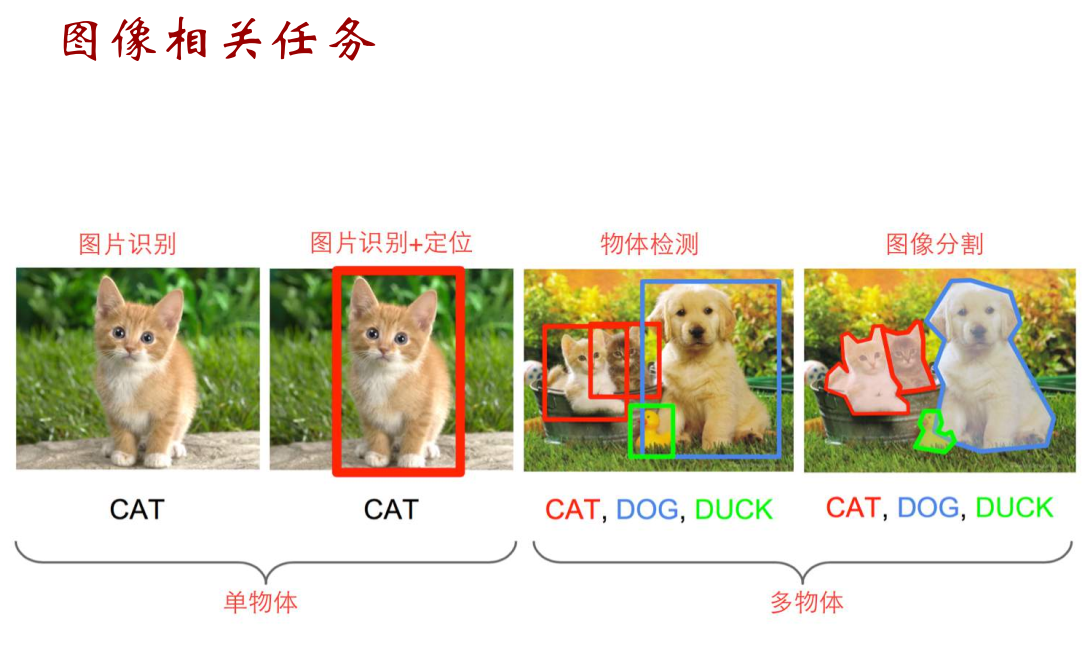

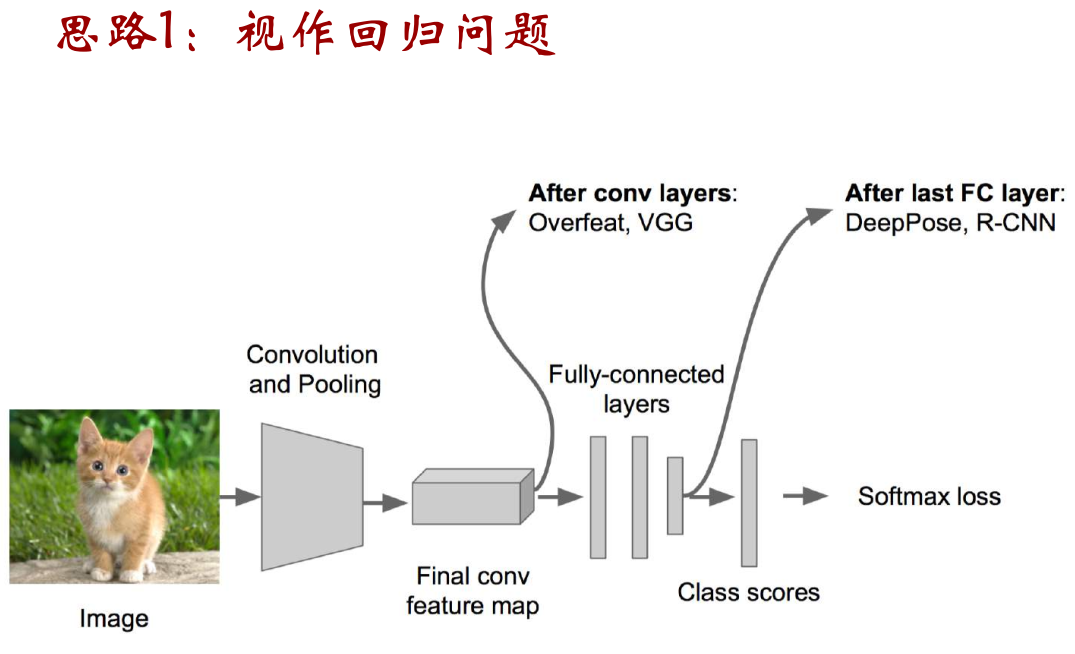

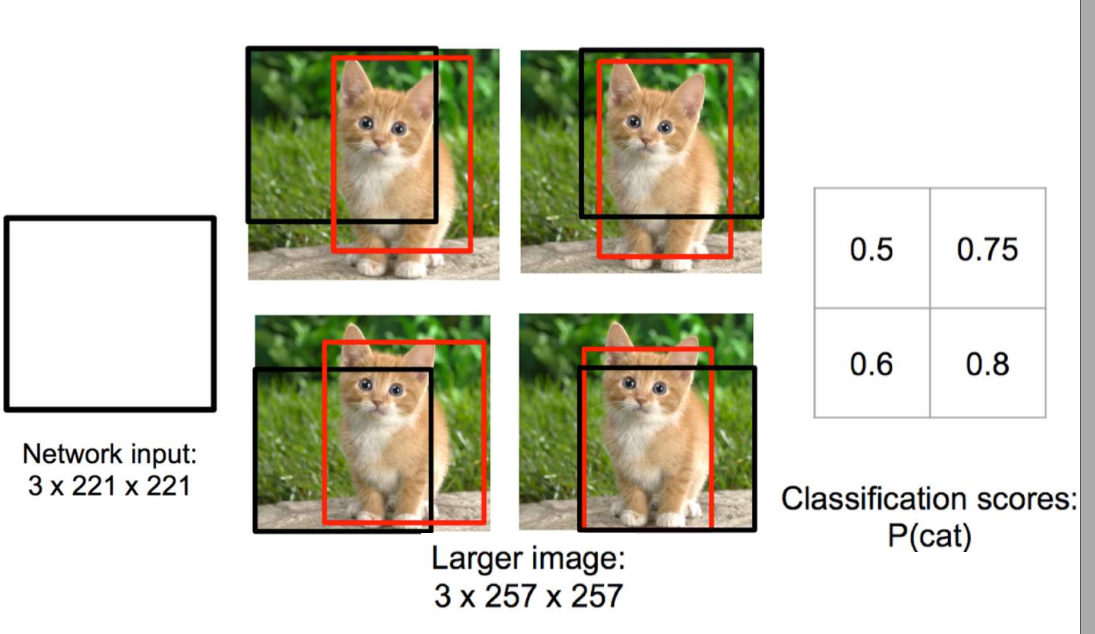

■ 物体定位

1.回归的思路

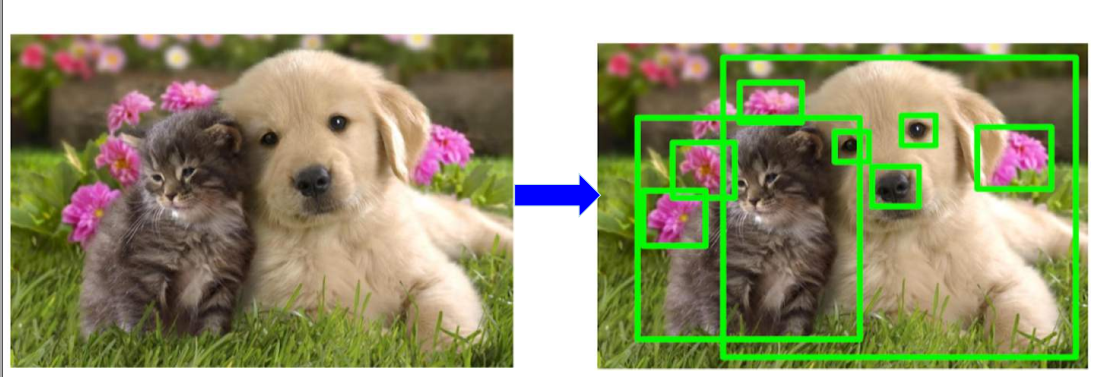

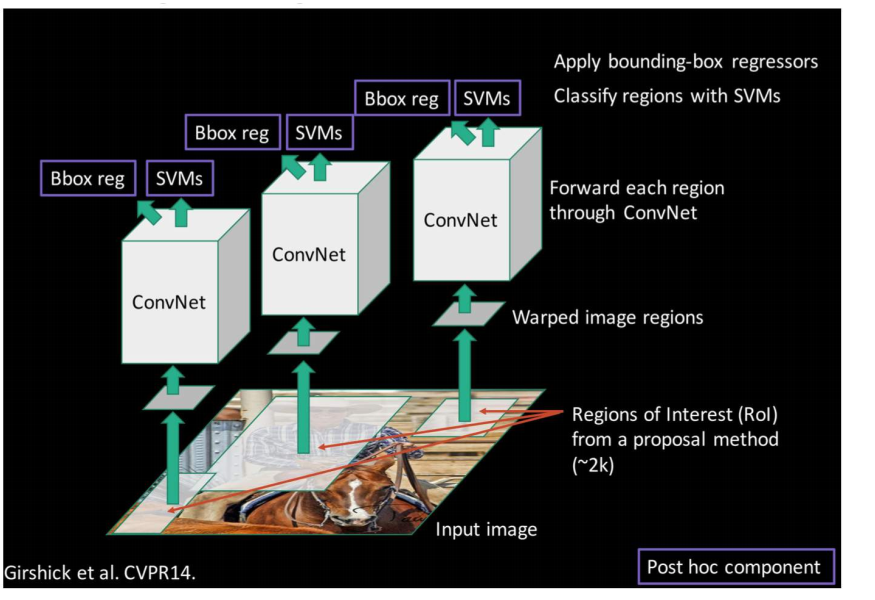

■ 物体检测

1.早期做法 2.RCNN/Fast-RCNN/Faster_RCNN 3.R-FCN

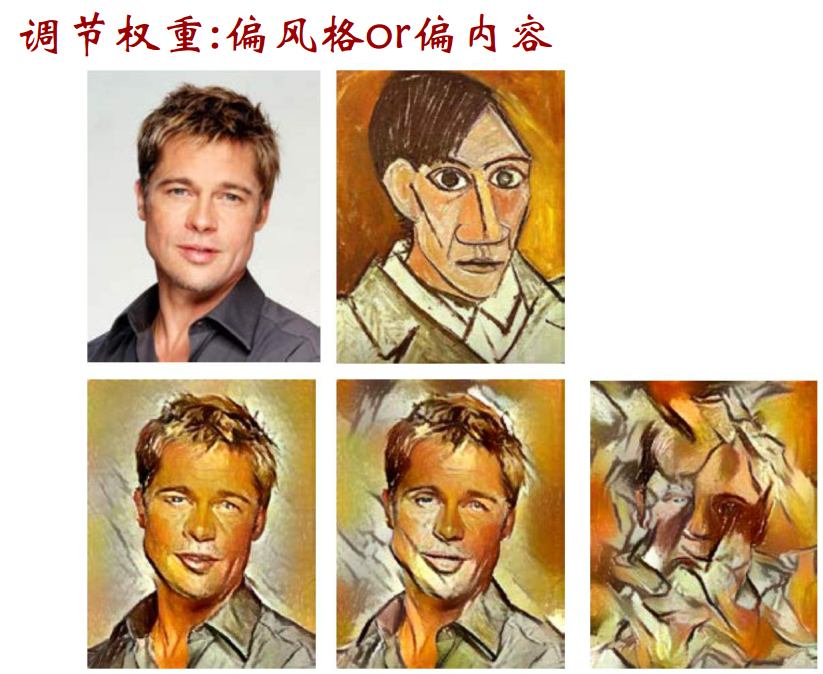

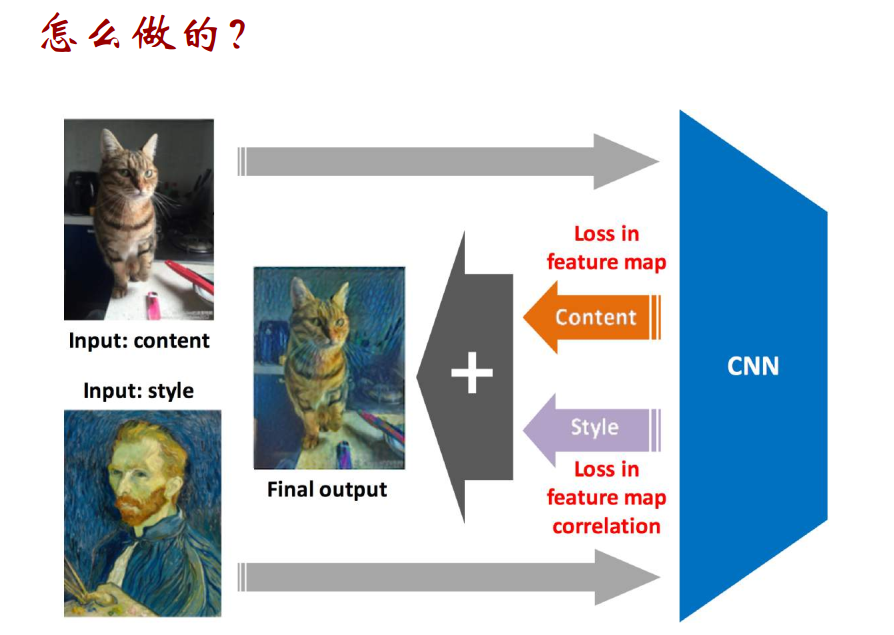

■ 文艺绘画与Neural Style

1.风格描述 2.主体对调与损失最小化

主要是以下层次:

□ 数据输入层/ Input layer

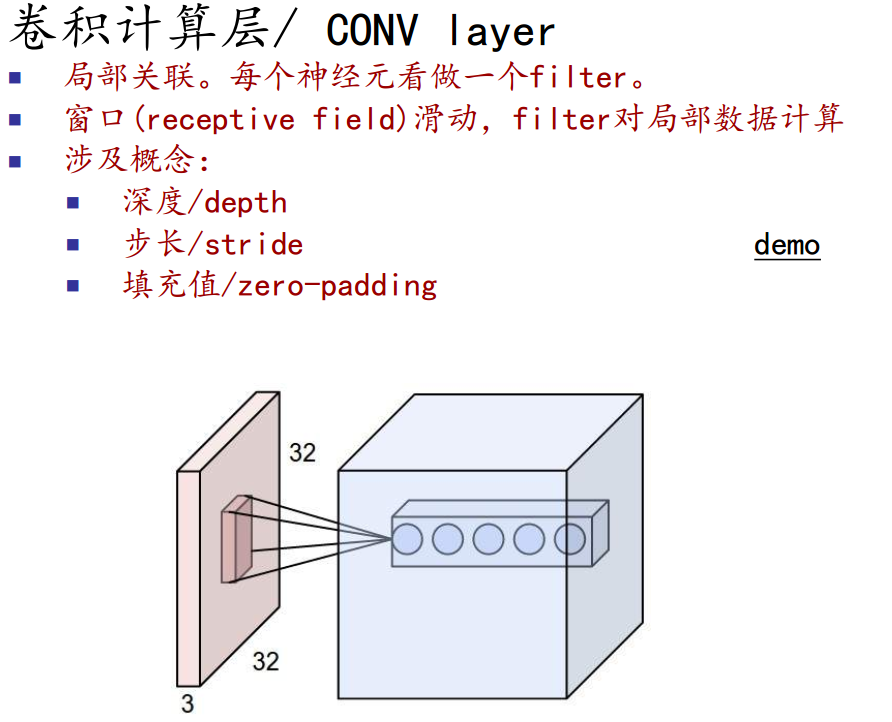

□ 卷积计算层/ CONV layer

□ ReLU激励层 / ReLU layer

□ 池化层 / Pooling layer

□ 全连接层 / FC layer

□ Batch Normalization层(可能有)

数据集输入层:

有3种常见的图像数据处理方式

□ 去均值

■ 把输入数据各个维度都中心化到0

□ 归一化

■ 幅度归一化到同样的范围

□ PCA/白化

■ 用PCA降维

■ 白化是对数据每个特征轴上的幅度归一化

卷积计算层:

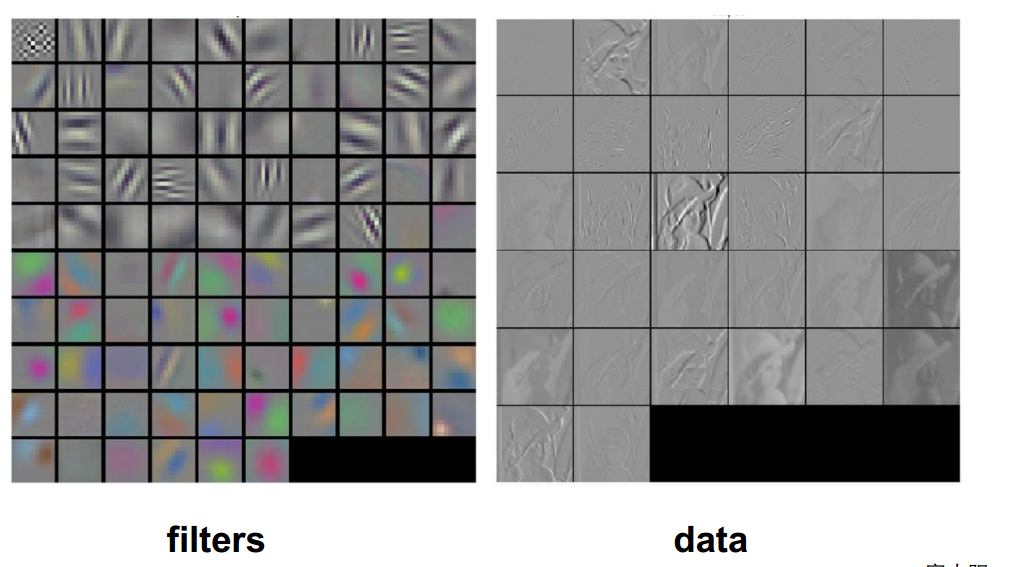

参数共享机制

假设每个神经元连接数据窗的权重是固定的

固定每个神经元连接权重,可以看做模板

每个神经元值关注一个特性

需要估算的权重个数减小: AlexNet 1亿=>3.5W

一组固定的权重和不同窗口内数据做内积:卷积

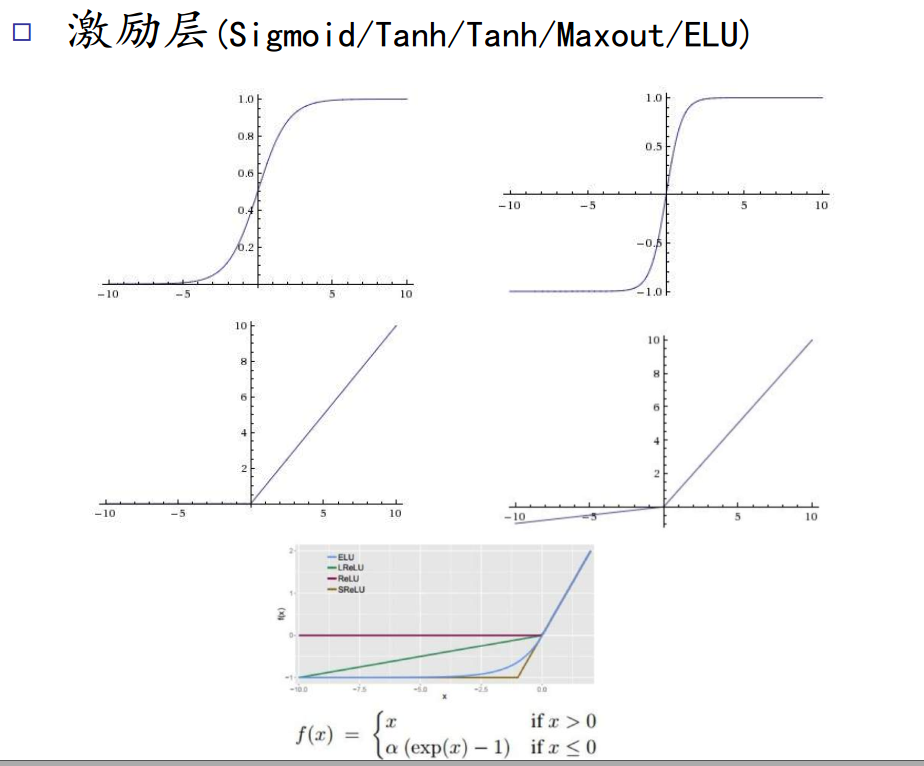

激励层(ReLU)

■ 把卷积层输出结果做非线性映射

□ Sigmoid

□ Tanh(双曲正切)

□ ReLU

□ Leaky ReLU

□ ELU

□ Maxout

□ 全连接层 / FC layer

■ 两层之间所有神经元都有权重连接

■ 通常全连接层在卷积神经网络尾部

□ 一般CNN结构依次为

■ INPUT

■ [[CONV -> RELU]*N -> POOL?]*M

■ [FC -> RELU]*K

■ FC

二。对卷积层的理解

第一个卷积层

□ 优点

■ 共享卷积核,对高维数据处理无压力

■ 无需手动选取特征,训练好权重,即得特征

■ 分类效果好

□ 缺点

■ 需要调参,需要大样本量,训练最好要GPU

■ 物理含义不明确

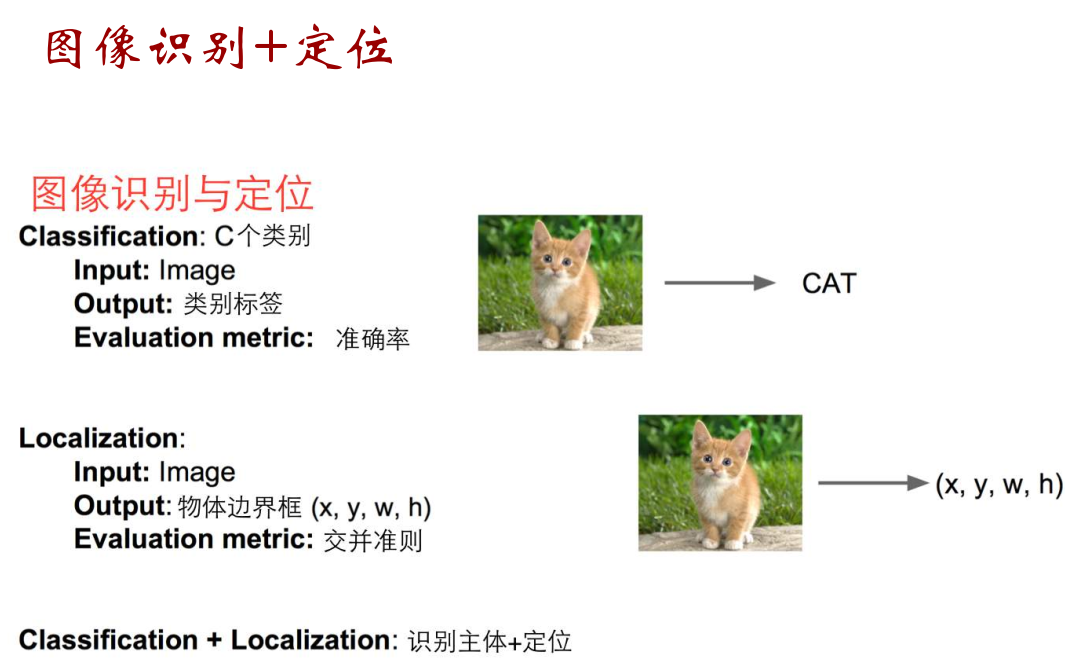

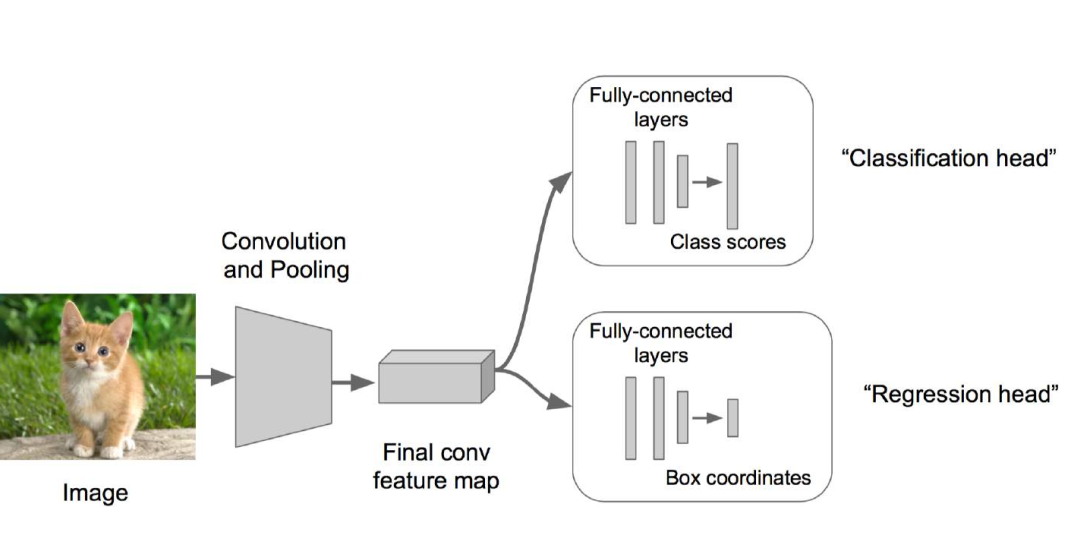

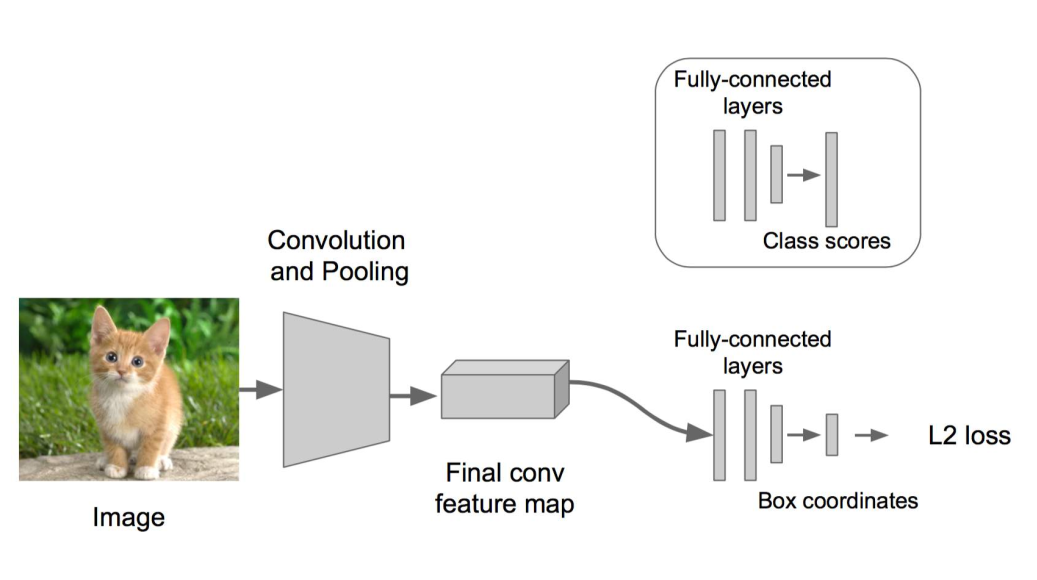

图像识别与定位:

三。物体识别

1. 随机去框,进行向右滑动,判断框内动物类别

2. 边缘策略

3. R-CNN

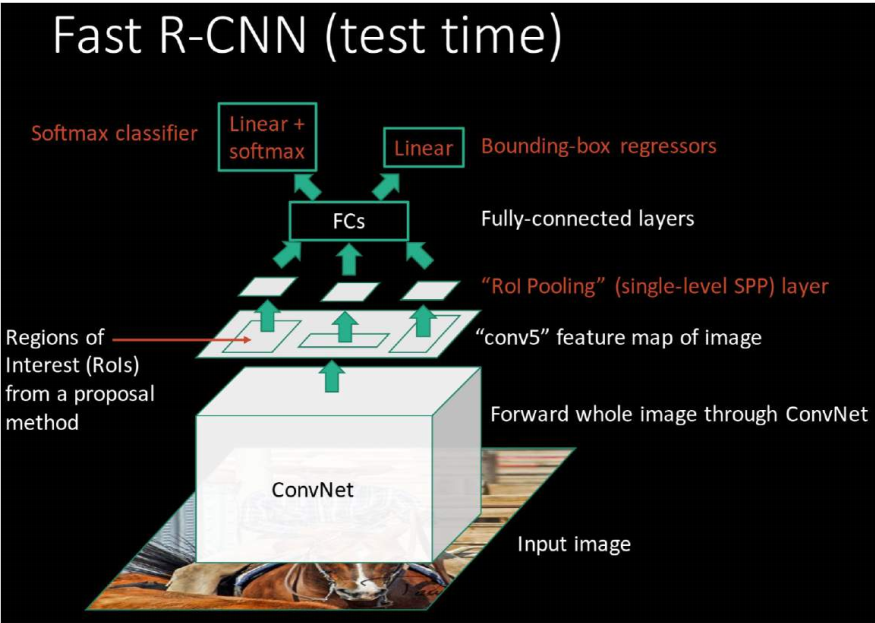

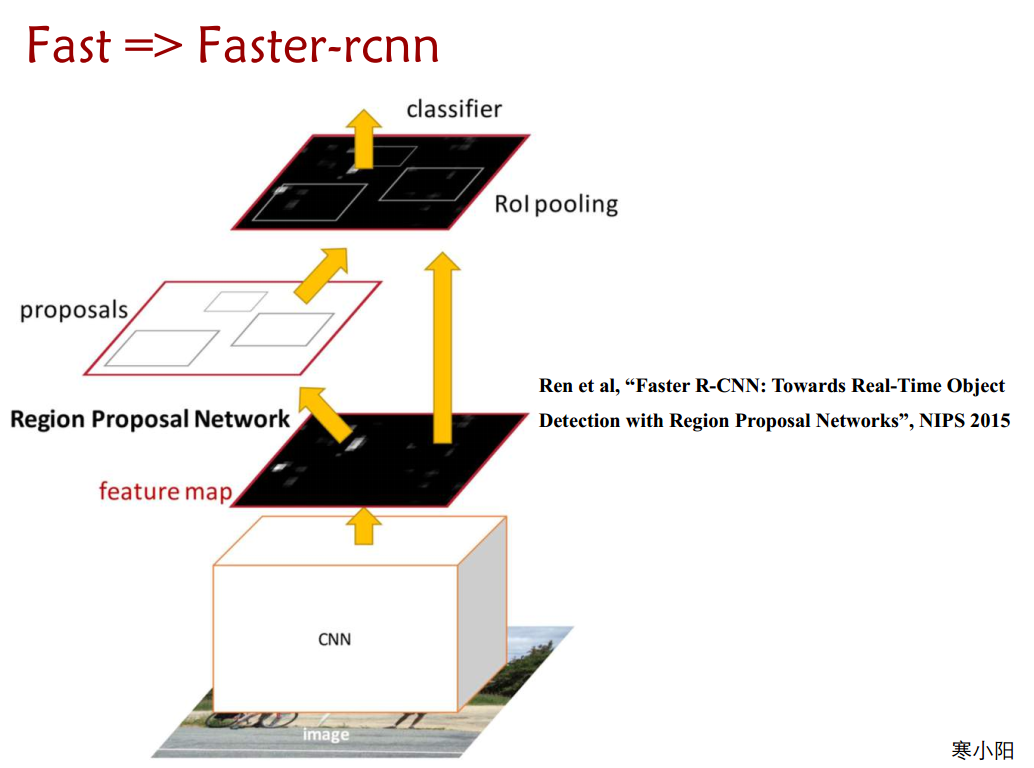

两个改变:

1. 采用有效的方法将感兴趣的区域选取来

2.后面不用SVM直接加上全连接层,进行分类和回归

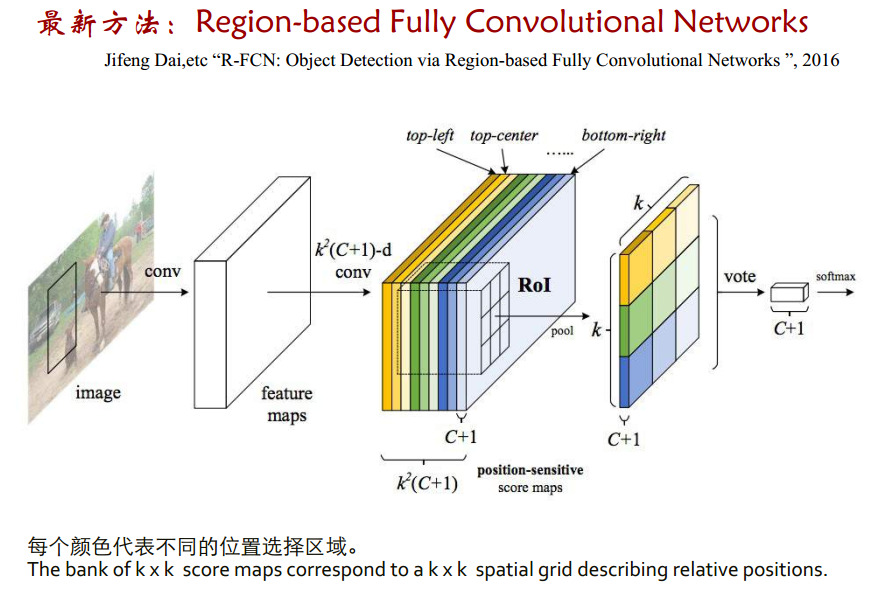

3. 相对于R-CNN关键用了一个ROI polling

4. RFCN 速度与质量都超过Faster-RCNN

应用:

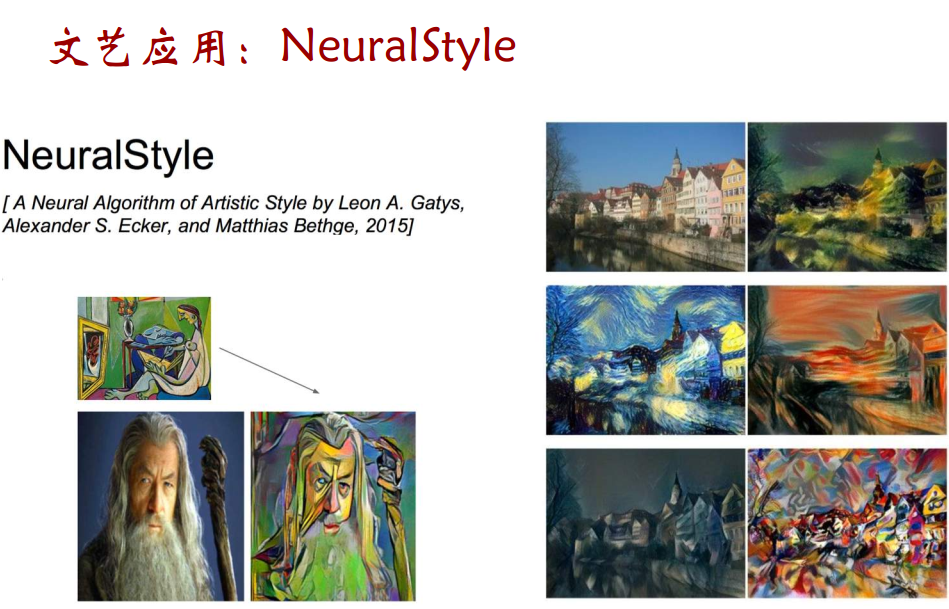

文艺应用:NeuralSyle

可以调整阿尔法和贝塔的值,调整风格和内容