用hdfsSink往hadoop写日志过程中,如果设置了lzo的压缩方式,则总提示以下错误:

Unsupported compression codec lzo. Please choose from: [None, BZip2Codec, DefaultCodec, DeflateCodec, GzipCodec, Lz4Codec, SnappyCodec]

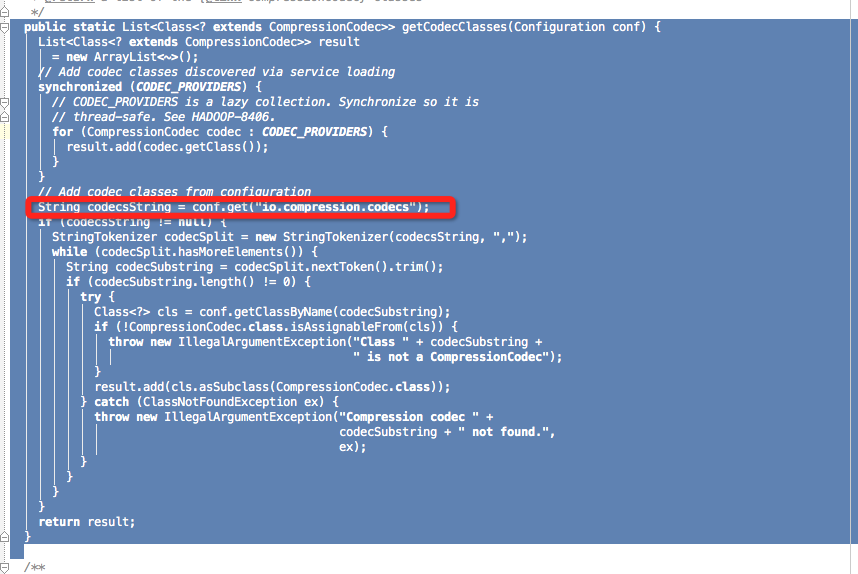

可是明明已经把hadoop-lzo的jar包添加了呀,为啥不行呢,仔细看了下flume的源码

原来flume需要读取hadoop的配置文件才能加载需要的编码类,因此将hadoop的core-silte.xml 复制到 flume的 conf 目录下,此问题得到解决。

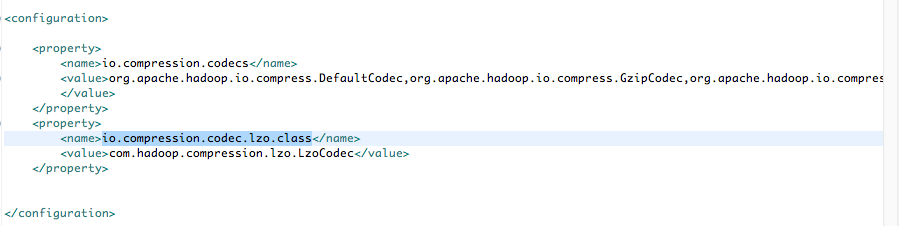

实际只需要core-site.xml里面的

io.compression.codecs 和 io.compression.codec.lzo.class 即可。