一、设置HDFS不进行权限检查

默认的HDFS上的文件类似于Linux中的文件,是有权限的。例如test用户创建的文件,root用户如果没有写权限,则不能进行删除。

有2种办法进行修改,修改文件的权限。或者设置不进行HDFS的权限检查,在hdfs-site.xml中添加:

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

二、启动HDFS和YARN的几种方式

方式一:逐一启动/sbin/hadoop-deamon.sh /sbin/yarn-deamon.sh

方式二:分开启动/sbin/start-dfs.sh /sbin/start-yarn.sh

方式三:一起启动/sbin/start-all.sh

第三种方式不建议使用,因为要分别启动dfs和yarn,要求namenode和resourcemanager在同一个节点上,且在该节点上运行start-all.sh命令。

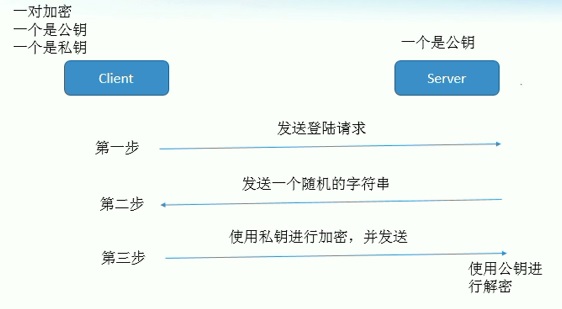

三、SSH登录过程

四、SSH免密码登录过程

客户端会先将自己的公钥保存在服务器端中,以供解密使用。

建立SSH免密码登录的过程如下:

1.ssh -keygen -t -rsa连续回车生成公钥和私钥,分别存储在/home/user/.ssh/id_rsa.pub和/home/user/.ssh/id_rsa下。

2.将公钥放到远程主机上,scp ~/.ssh/id_rsa.pub node2:/.ssh/authorized_keys。

这里是将客户端公钥放到服务器端,如果希望服务器也能免密码登录客户端,需要将服务器的公钥也在客户端放一份。

四、默认的配置文件

Hadoop自定义的配置文件在etc目录下。默认的配置文件在/share/hadoop各文件夹的jar包中。

默认的配置文件包括core-default.xml,hdfs-default.xml,yarn-default.xml,mapred-default.xml。

自定义配置文件中的配置将会覆盖默认配置文件中的配置。

从默认配置文件中拷贝配置项,修改后加入到自定义配置文件。不要修改默认配置文件中的内容。

五、默认使用本地文件系统还是HDFS文件系统

core-site.xml中的fs.defaultFS属性,默认的值是file:///,就是本地文件系统。配置为hdfs://hadoop-cloudy.com:8020时用的就是HDFS文件系统。

六、删除HDFS文件时,保留到回收站中的时间

core-site.xml中的fs.trash.interval属性,单位为分钟。默认为0,将直接删除。

HDFS默认的文件副本数为3.

七、MapReduce运行在本地还是yarn上

mapred-site.xml的属性mapreduce.framework.name默认为local,运行在本地。配置为yarn,运行在yarn上。

八、决定各进程所在主机的配置文件

namenode所在主机: core-site.xml中的fs.defaultFS属性

datanode所在主机:slaves文件指定

secondarynamenode所在主机:hdfs-site.xml中没有指定,就在默认的配置文件hdfs-default.xml

resourcemanager所在主机:yarn-site.xml中没有指定,就在默认的配置文件yarn-default.xml

nodemanager所在主机:slaves文件指定

jobhistoryserver所在主机:mapred-site.xml中没有指定,就在默认的配置文件mapred-default.xml