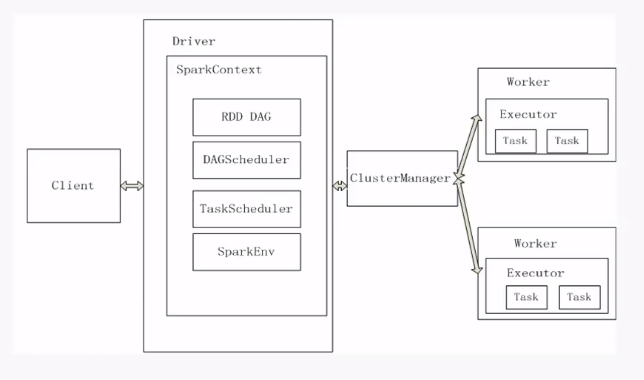

master为主节点

一个集群中可能运行多个application,因此也可能会有多个driver

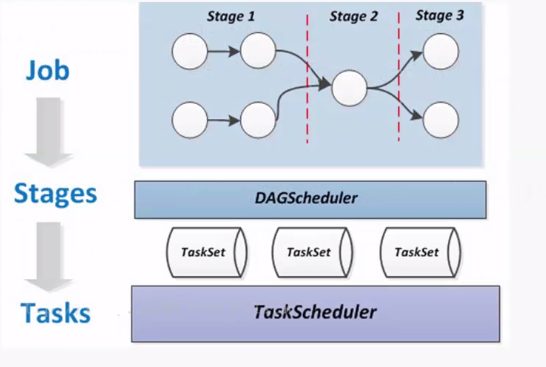

DAG Scheduler就是讲RDD Graph拆分成一个个stage

一个Task对应一个SparkEnv

客户端提交请求,然后master生成driver,生成对应的SparkContext,然后将任务拆分为多个RDD,对应上述流程

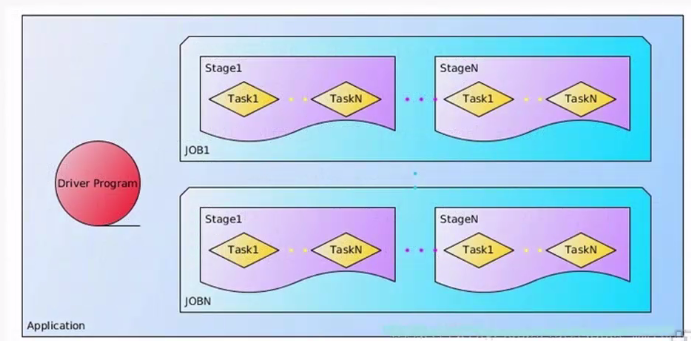

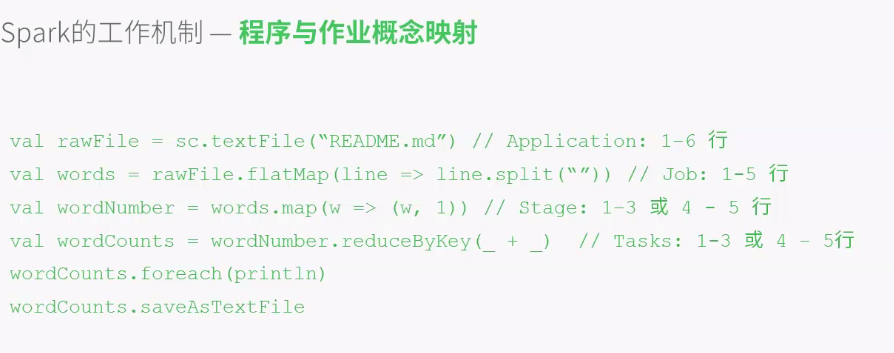

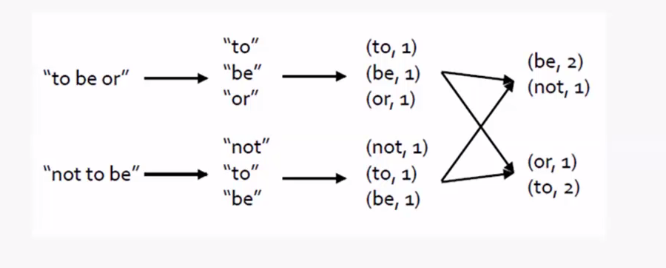

用户自定义Spark程序并且提交后,生成Driver Program,然后生成多个Job,每个JOB根据RDD的宽依赖关系来生成多个stage,一个stage对应一个taskset,taskset只一个stage下所有的task,每个task对应一个block数据块,执行并运算

一个block块就有128,如果频繁的IO读取数据将造成大量的网络延时