Conversational Recommender System

《Conversational Recommender System》(《对话推荐系统》)发表于2018年ACM,作者及机构:Yueming Sun, Yi Zhang,University of California。

本篇论文主要是将对话系统和推荐系统的研究整合到一个新颖统一的深度强化学习框架中,构建一个个性化的会话推荐代理,优化每个会话的效用函数。

对话推荐系统主要分为三类:

(1) 聊天型(chit-chat):专注于信息社交聊天,并尝试与类似人类的合理或有趣的回应进行互动;

(2) 信息聊天机器人(Informational chatbots):试图帮助用户查找信息或直接回答用户的问题;

(3) 任务型(task oriented chatbots):试图帮助用户完成特定的任务,如预订航班或取消旅行。

本系统主要有三个部分组成:

(1)natural language understanding (NLU) model:分析每个用户的话语,跟踪用户的对话历史,不断更新用户的意图。

(2) dialogue management (DM) model:决定在给定当前状态下采取何种操作。

(3)natural language generation model:生成对用户的响应。

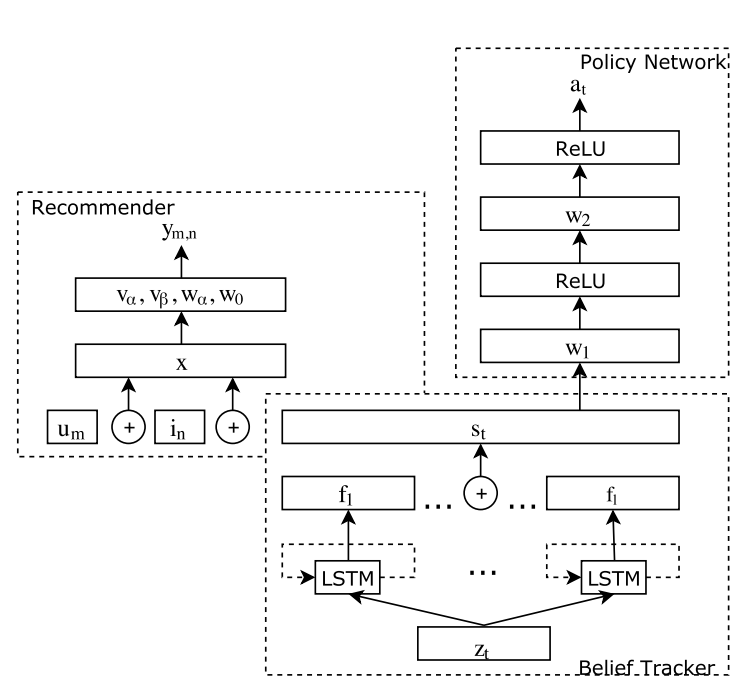

模型框架:

1、Belief Tracker

2、Recommender System

3、Deep Policy Network

相关技术:

1、Faceted Search(分面搜索)

分面是指事物的多维度属性。例如一本书包含主题、作者、年代等分面。而分面搜索是指通过事物的这些属性不断筛选、过滤搜索结果的方法。可以将分面搜索看成搜索和浏览的结合。

参考资料:

https://cdc.tencent.com/2009/07/30/%e5%88%86%e9%9d%a2%e6%90%9c%e7%b4%a2%ef%bc%88faceted-search%ef%bc%89/

https://wenku.baidu.com/view/cebfe42a0a4c2e3f5727a5e9856a561252d321ed.html

2、Deep Reinforcement Learning(深度强化学习)

在机器学习中,我们经常会分类为有监督学习和无监督学习,但是尝尝会忽略一个重要的分支,强化学习。有监督学习和无监督学习非常好去区分,学习的目标,有无标签等都是区分标准。如果说监督学习的目标是预测,那么强化学习就是决策,它通过对周围的环境不断的更新状态,给出奖励或者惩罚的措施,来不断调整并给出新的策略。2013年DeepMind发表了一篇Playing Atari with Deep Reinforcement Learning 文章之后,深度强化学习便慢慢走入人们的视野。后来,在2015年,DeepMind又发表了一篇Human Level Control through Deep Reinforcement Learning,使得深度强化学习得到了广泛的关注,当年涌现了很多学术成果。

参考资料:

https://zhuanlan.zhihu.com/p/25239682

https://blog.csdn.net/songrotek/article/details/50580904

该框架使我们能够构建一个会话搜索和推荐系统,该系统可以决定何时以及如何从用户那里收集信息,并根据用户过去的购买历史和当前会话中的上下文信息进行推荐。

参考:

https://blog.csdn.net/qq_37959202/article/details/105281961