总结:

安装使用IDEA还有一些知识如下:

1,列举linux常用命令

shutdown now

reboot

mkdir

mkdir -p

touch filename

rm -r filename

rm -rf filename

vi filename

i--->可编辑状态

esc --> : --->wq 保存退出

q!

wq!

cat

grep

find

ifconfig

ping

useradd

chmod 777 filename

more

cp srcfile destfile

mv

tar -zxvf filename -C destpath

ls

ls -a

pwd 查看当前目录的绝对路径

filewall:

service iptables start/stop/status/restart

centos7 : systemctl stop frewalld.service

systemctl -cmd --state

修改网络配置文件:

/etc/sysconfig/network-scripts/ifcfg-eth1

配置环境变量

/etc/profile

~/.bash_profile

/etc/profild.d/x.sh

JAVA

export JAVA_HOME=/root/app/jdk1.8.0_161

export PATH=$JAVA_HOME/bin:$PATH

配置文件生效:

source ~/.bash_priofile

查看java安装目录

echo $JAVA_HOME

2,hash函数特点是什么

字符串----->固定位数的Hash值。

1,确定性

str1--->hash1值

str2---->hash1值

2,单向性

str----hash()----->hash值

3,防篡改

str1--->bit--->hash()--->hash值

4,防碰撞

str1 ---> hash1

str2---->hash1

mapreduce分区默认实现:

hash(key)%reduce task

Hash实现:

SHA

MD5

区块链:不可篡改

链表+hash(key)

3,hdfs如何实现文件的存储

NameNode:

处理客户端的请求

操作元数据(修改文件名打开文件、关闭文件、DataNode

info)

DataNode

存储文件数据block,blocksize=128MB

发送心跳信息,将自身所有存储的block信息,健康状况发

送给 NameNode。

SecondNameNode:hadoop2.x可有可无

130MB--> 128MB block + 2MB block

4,hdfs副本存放机制?

block 默认3份。

5,hdfs主要进程、yarn的主要进程分别是?

hdfs:

NameNode

DataNode

SecondNameNode

yarn:资源调度框架

ResourceManager

NodeManager

6,搭建伪分布式步骤

cents6.5

1,前置准备

java配置环境

tar -zxvf

配置环境变量

ssh

1,安装ssh服务器

openserver-ssh

2, ssh-keygen -t rsa

cd ~/.ssh

id_rsa id_rsa.pub

cp id_rsa.pub authorized_keys

3,ssh-copy-id

2,安装hadoop

2.1解压hadoop tar -zxvf hadoop-xx.tar.gz

2.2 配置文件

$HADOOP_HOME/etc/hadoop

hadoop-env.sh

JAVA_HOME

core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://Master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/root/hadoop/app/tmp</value>

</property>

hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

HDFS Shell操作:

1,查看Hdfs上的文件

hdfs dfs -ls /

hadoop fs -ls /

2,将本地文件上传到hdfs

hdfs dfs -put hello.txt /

3,查看hdfs文件内容

hdfs dfs -cat /hello.txt

hdfs dfs -text /hello.txt

4,在hdfs创建目录

hdfs dfs -mkdir /hello

5,hdfs递归创建目录

hdfs dfs -mkdir -p /test/a/b

6,递归查询目录

hdfs dfs -ls -p /test

7,将hdfs上的文件下载到本地

hdfs dfs -get /hello.txt

8,将本地文件拷贝到hdfs上 /test/a/b

hdfs dfs -copyFromLocal hello.txt /test/a/b/h.txt

9,删除hdfs上目录

hdfs dfs -rm -R /hello

10,删除hdfs上的文件

hdfs dfs -rm /hello.txt

遇到的问题:在使用IDEA创建web项目的时候,出现了错误,是因为网络原因下载jar中断导致,最后删除所有的库文件,重新下载后成功可以使用。

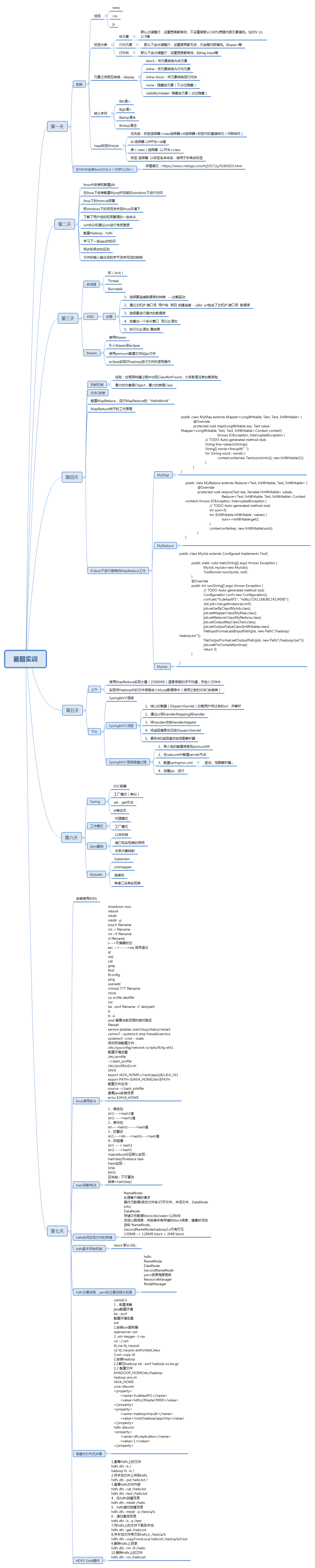

思维导图: