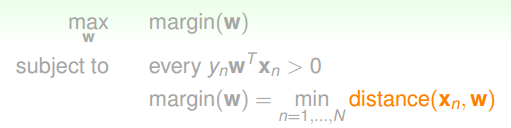

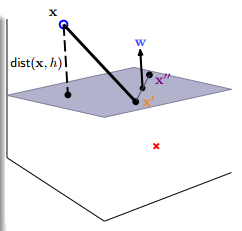

标准最大margin问题

假设data是linear seperable的

优化目标

希望 margin(w),i.e, 最小的点到直线的距离 最大

即是要得到最右的线,它对噪声的鲁棒性最好

得到的分类器很简单,线一侧为x,另一侧为o

![]()

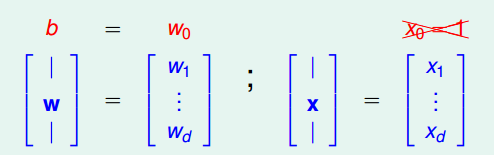

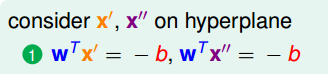

预备知识:点到直线的距离

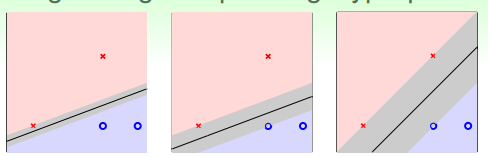

为了推导方便,不再将截距 bias b并入向量w中

点到直线的距离推导

假设 平面方程是

![]()

平面方程怎么来的?参考:

http://netedu.xauat.edu.cn/jpkc/netedu/jpkc/gdsx/homepage/5jxsd/51/513/5307/530705.htm

如果不想打开链接,看这个就行了

平面法向量是 w

那么对于

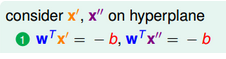

因为x'和x''在平面上,所以有

也自然得到

如何算distance呢

x到平面的距离:将x与平面上的点x'相连,然后计算(x-x')在w方向上的投影就可以了

上面最右一步化简是因为

上面已经写了,x'在直线上,所以有

代入即可。

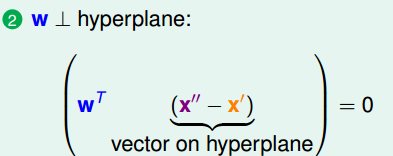

好,现在得到了点到直线的距离

在高维上说就是 distance to seperating hyperplane

![]()

应该不陌生

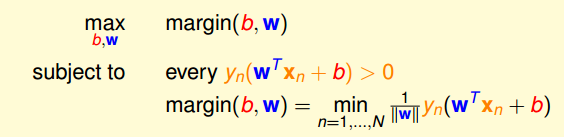

回到我们的优化目标,橘红色的部分已经OK了

将b从w中拆出来(上面已经说了)

优化目标可以写成

0

0

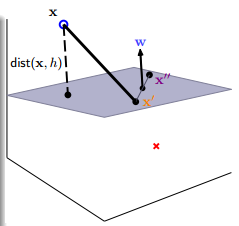

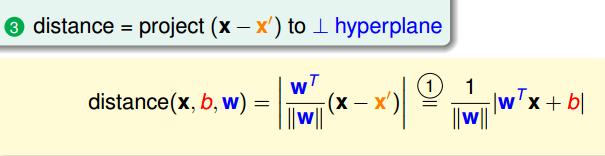

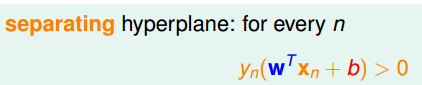

根据约束1:分割面可以正确划分每个点,即

也就是 上面相乘的两项总是同号的

所以点到直线的距离

![]()

可以写成

![]()

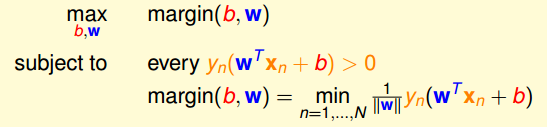

优化目标可以写成

对于直线方程,scaling是没关系的

![]()

那么我们可以假设

![]()

因为上面是更强的条件,那么优化目标的第一个约束条件可以解除

![]()

另外,

![]()

目标函数变为

![]()

还是一个max min优化

下面采用反证法证明 约束条件 等价于

![]()

toy example