激活函数的选择:

西格玛只在二元分类的输出层还可以用,但在二元分类中,其效果不如tanh,效果不好的原因是当Z大时,斜率变化很小,会导致学习效率很差,从而很影响运算的速度。绝大多数情况下用的激活函数是ReLu,带泄露的ReLu效果更好,但并不常用。

使用非线性激活函数的原因:如果用线性激活函数,那么隐藏层就会失去作用。

西格玛激活函数 的斜率:

的斜率:

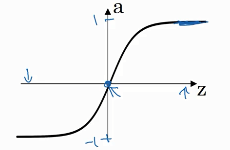

tanh激活函数:

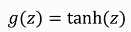

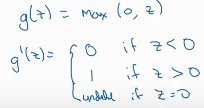

ReLU:

Leaky ReLU:

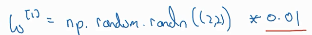

权值w初始化的值不能全为0,因为如果全为0,那么隐藏层的每个单元都是对称的了,即每个单元都做相同的运算,这会使多个隐藏单元失去意义。

权值W的随机初始化: 一般初始w是很小的数,因为如果很大的话,会使结果很大,从而使斜率很小,从而使梯度下降的很慢,影响运算速度。

一般初始w是很小的数,因为如果很大的话,会使结果很大,从而使斜率很小,从而使梯度下降的很慢,影响运算速度。