Author

一作: Ian Goodfellow 三作: Christian Szegedy

Abstract

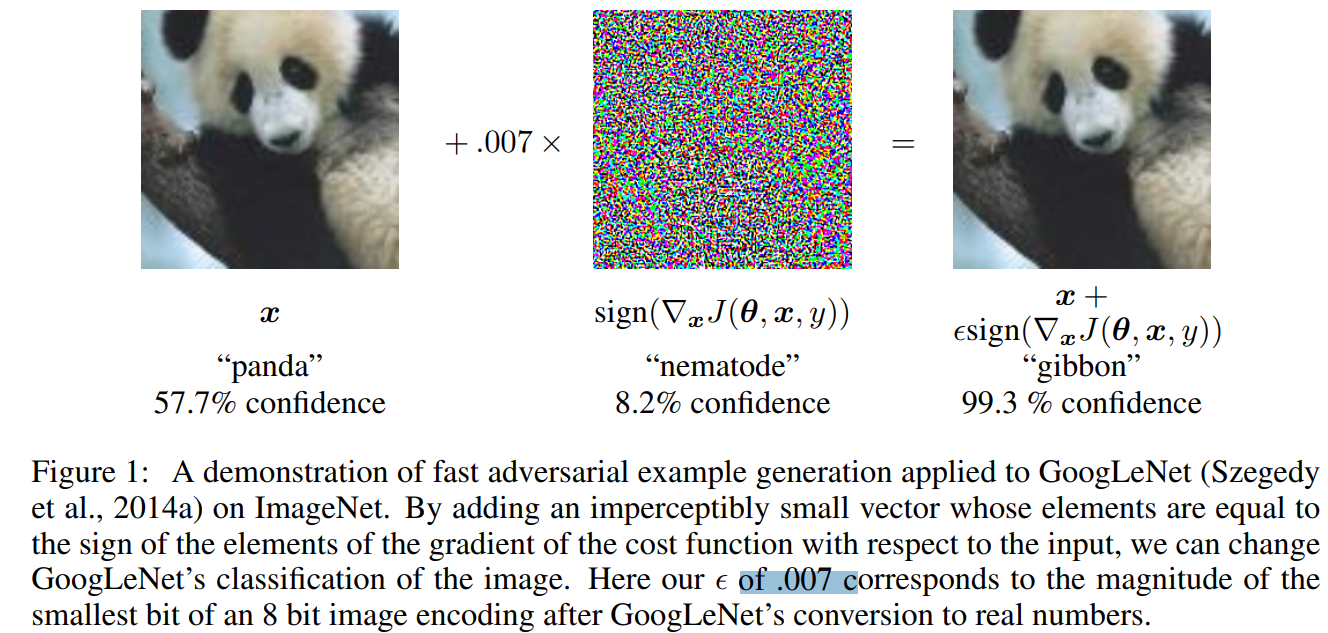

之前认为对抗样本对模型的欺骗性是因为模型的高度非线性和过拟合,本文证明了模型的易损性主要是因为模型的线性本质。而且本文提供了一个简单且快速的方法产生对抗样本,将产生的样本用于对抗训练可以提升模型的测试性能。

Introduction

在高维空间的线性行为已经足够产生对抗样本,这种观点可以是我们设计一种简单且快速的方法用以生成对抗样本使得对抗训练实用化(FGSM, Fast Gradient Sign Method)

我们发现对抗训练可以提供额外的正则化。

非线性才能抵抗对抗干扰,长远来看,我们设计更加强大的优化方法用以训练更加非线性的模型来提高模型的对对抗样本的抗性

Related Work

现在已经有人开始设计抵抗模型,但是还没有任何一个模型保持在clean inputs上的高准确率的同时具有抵抗力

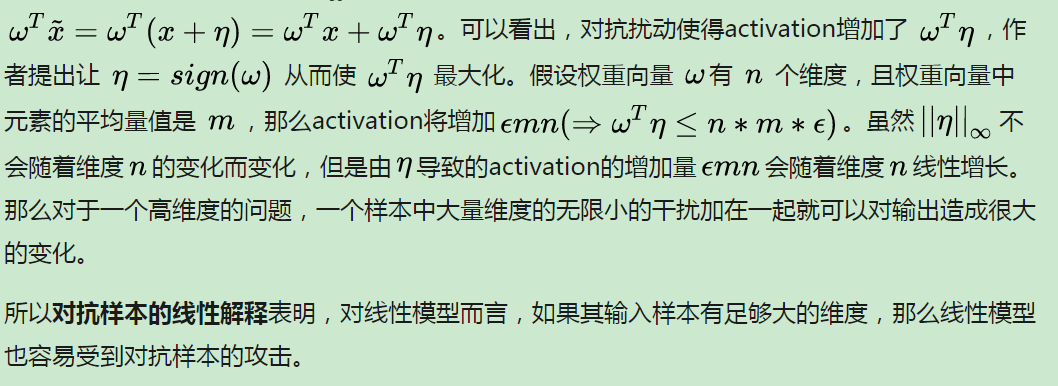

Linear explanation

the precision of an individual input feature is limited. 输入的精度是有限的,比如说rgb图像,每个像素是8bit, 精度就是1/255

所以分类器不可能对输入x和 对抗样本 x+delta 做出不同的相应,如果delta比精度还小

一个简单的线性模型可以有对应的对抗样本如果它的输入有足够多的维度

Linear Perturbation of Non-linear Models

0.07 = 1/128

Szegedy发现用对抗样本和clean样本混合进行训练可以有正则的效果,这是不同于数据增广的,数据增广是产生的数据是有可能出现在测试集里的,而对抗样本是不可能出现在测试集中的

这个方法提升的效果是比不上droupout的,

The generalization of adversarial examples across different models can be explained as a result of adversarial perturbations being highly aligned with the weight vectors of a model, and different models learning similar functions when trained to perform the same task.

另外,为了解释为什么不同的分类器将对抗样本误分类到同一个类,作者假设目前的方法训练神经网络都类似于在同一个训练集上学习的线性分类器。由于机器学习算法的泛化能力,所以线性分类器可以在训练集的不同子集上训练出大致相同的分类权重。底层分类权重的稳定性反过来又会导致对抗样本中的稳定性。

模型融合对于对抗样本的防御能力非常有限

RBF networks are resistant to adversarial examples

知乎: https://zhuanlan.zhihu.com/p/32784766

之后又有论文证明

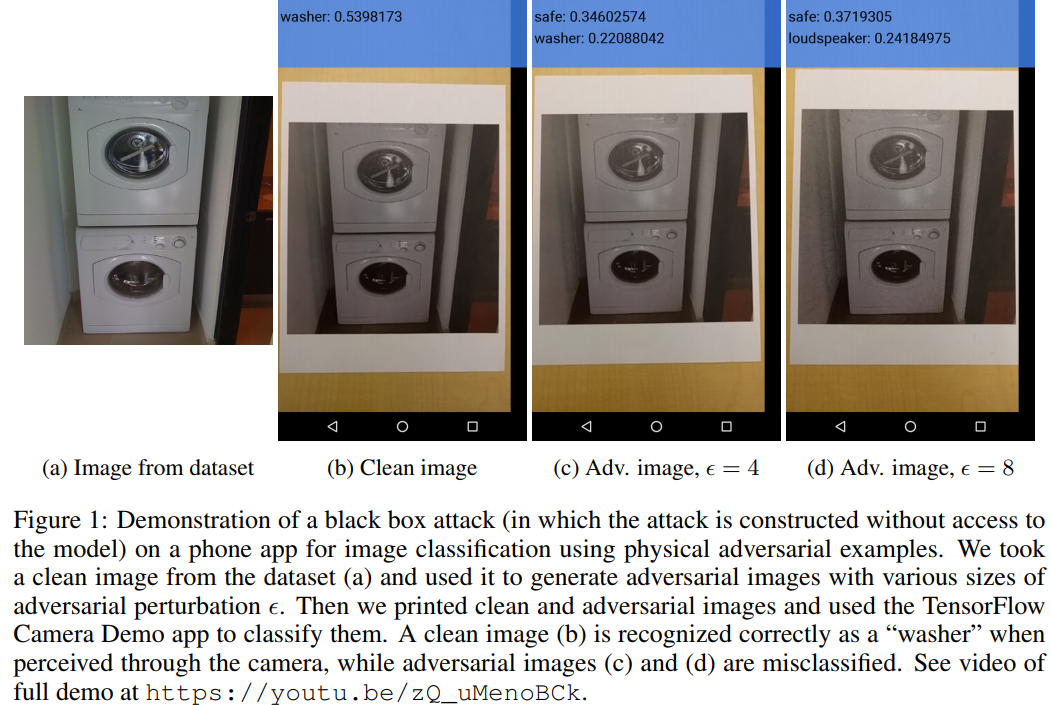

Adversarial examples in the physical world Alexey Kurakin, Ian Goodfellow, Samy Bengio ICLR2017 workshop 证明真实数据在物理世界是存在的

未来的工作,就是希望不只是用打印的图片作为对抗样本,而是真是的物理世界中的object,已经希望研发出有效的防御系统