基本信息

**1. 博客开头给出自己的基本信息,格式建议如下:**

学号:2017*****7239;

姓名:王和旋;

码云项目仓库:[https://gitee.com/KONG520/word_frequency/tree/SE7239/](https://gitee.com/KONG520/word_frequency/tree/SE7239/)

程序分析

**2. 程序分析,对程序中的四个函数做简要说明。要求附上每一段代码及对应的说明。**

首先声明编码方式和导入string模块中的punctuation方法

```

# -*- coding: UTF-8 -*-

from string import punctuation

```

1.读取文件函数--打开文件读入缓冲区并关闭文件

```

def process_file(dst): # 读文件到缓冲区

try: # 打开文件

txt = open(dst, "r")

except IOError, s:

print s

return None

try: # 读文件到缓冲区

bvffer=txt.read()

except:

print "Read File Error!"

return None

txt.close()

return bvffer

```

2.数据处理--去除字符串中的符号将单词分割并读入字典。

```

def process_buffer(bvffer):

if bvffer:

word_freq = {}

# 下面添加处理缓冲区 bvffer代码,统计每个单词的频率,存放在字典word_freq

for item in bvffer.strip().split():

word = item.strip(punctuation + ' ')

if word in word_freq.keys():

word_freq[word] += 1

else:

word_freq[word] = 1

return word_freq

```

3.输出Top10结果--遍历字典并输出Top10的单词

```

def output_result(word_freq):

if word_freq:

sorted_word_freq = sorted(word_freq.items(), key=lambda v: v[1], reverse=True)

for item in sorted_word_freq[:10]: # 输出 Top 10 的单词

print(item)

```

4.导入argparse库用于解析命令行数据,依次执行函数

```

if __name__ == "__main__":

import argparse

parser = argparse.ArgumentParser()

parser.add_argument('dst')

args = parser.parse_args()

dst = args.dst

bvffer = process_file(dst)

word_freq = process_buffer(bvffer)

output_result(word_freq)

```

在命令中输入```python word_freq.py Gone_with_the_wind.txt```运行代码

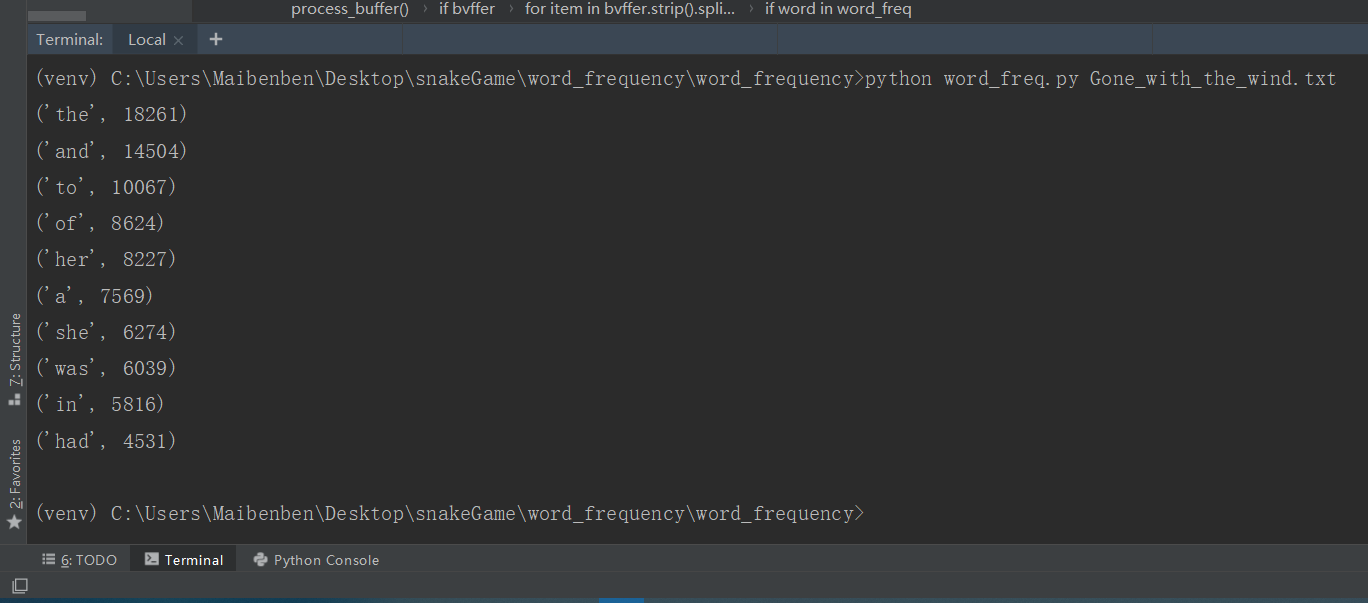

结果如下,输出了词频Top10的单词和次数:

性能分析与改进

**3. 简单性能分析并改进、提交代码**

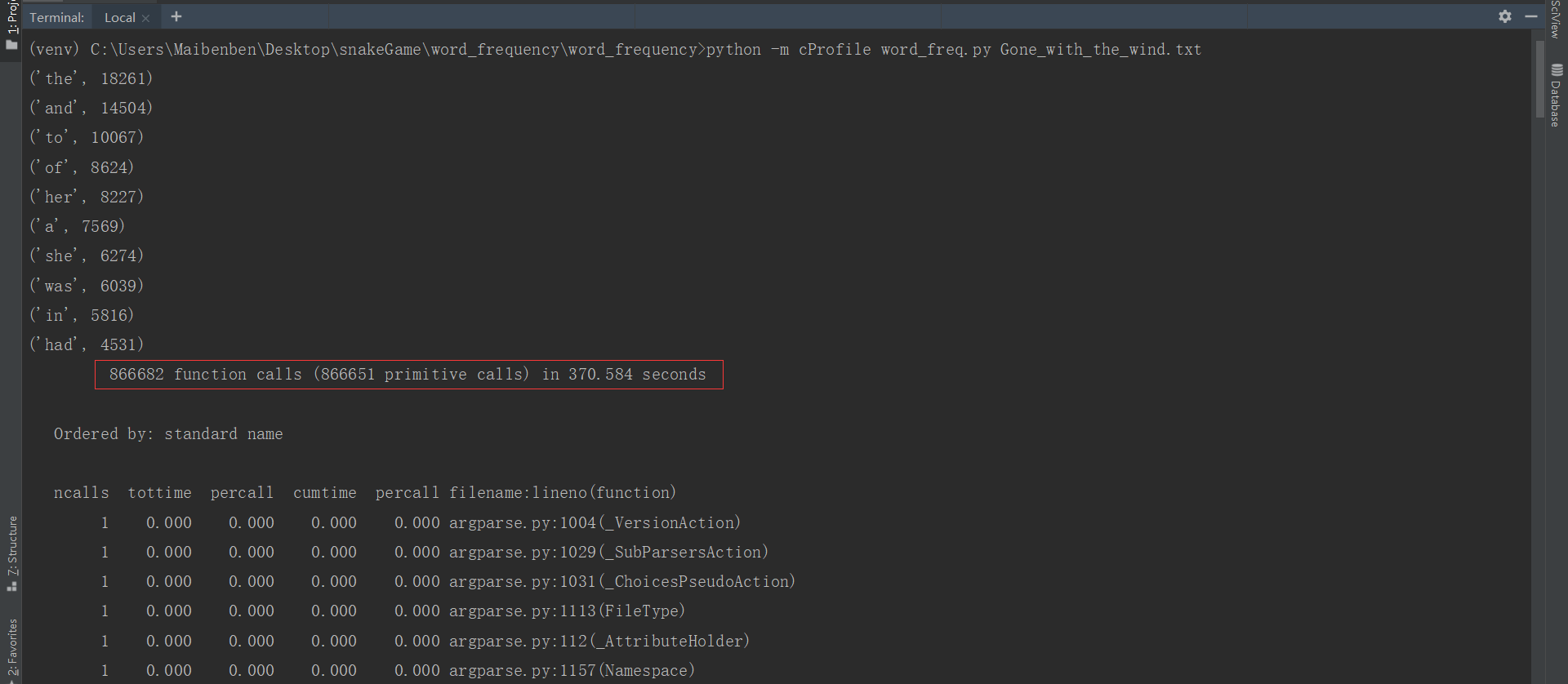

使用cProfile进行性能分析

```python -m cProfile word_freq.py Gone_with_the_wind.txt```

测试结果如下图(由于测试数据太多,只列举截图了关键信息,耗时最长,调用最多次数的函数):

上图显示有866682次函数调用,程序总共耗时370.584秒

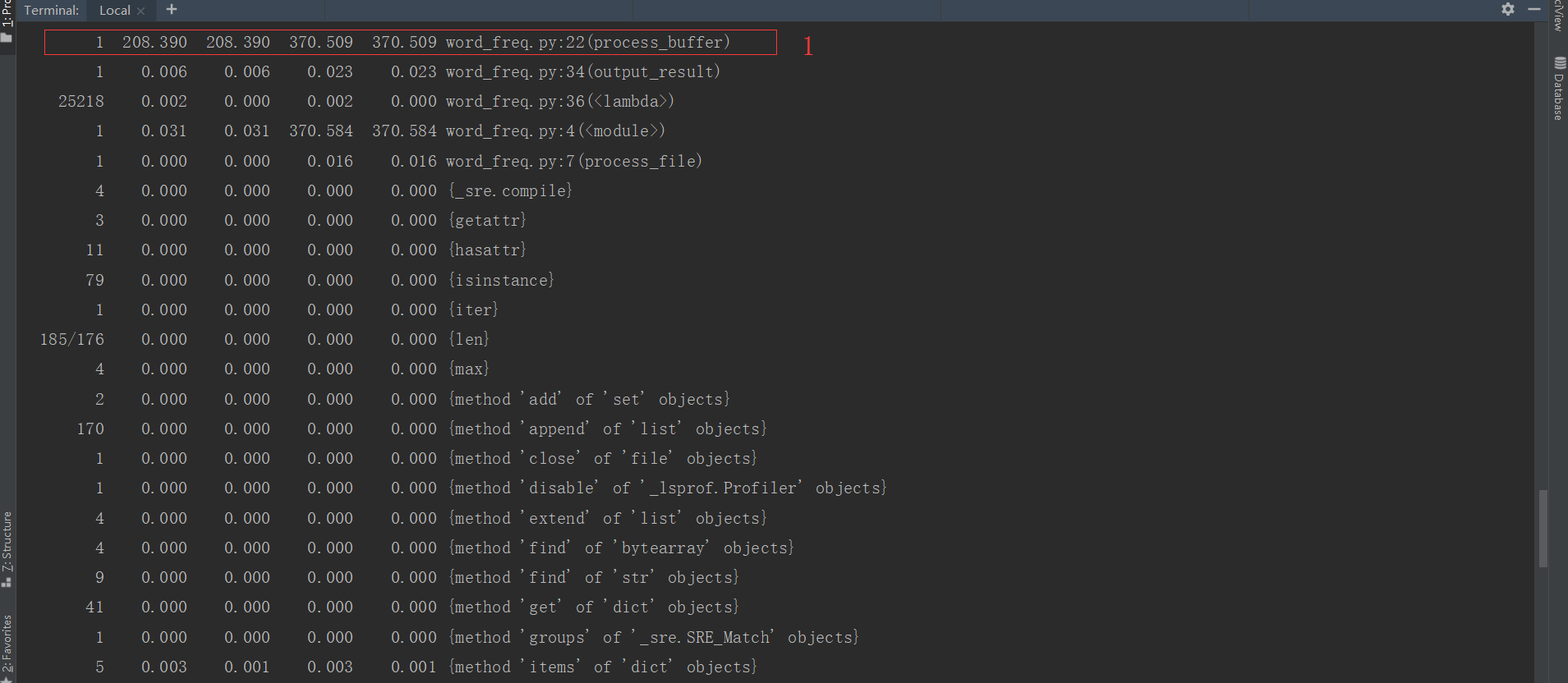

上图中标记的第3点字符串的strip函数被调用的次数最多--420147次,但花费总时间只用了0.603秒,暂不需要优化

而第1点函数process_buffer只被调用了1次却用的208.390秒,第3点字典中的key方法被调用了420146次,用时161.473秒

回到代码中发现process_buffer函数中的for循环内有一句if word in word_freq.keys():

而遍历字典循环中每执行一次就要调用字典word_freq的keys()方法,但实际不需要再提取字典中的值(keys),直接判断word在字典word_freq中是否存在就可以了,所以去掉keys()方法,将代码修改为if word in word_freq:

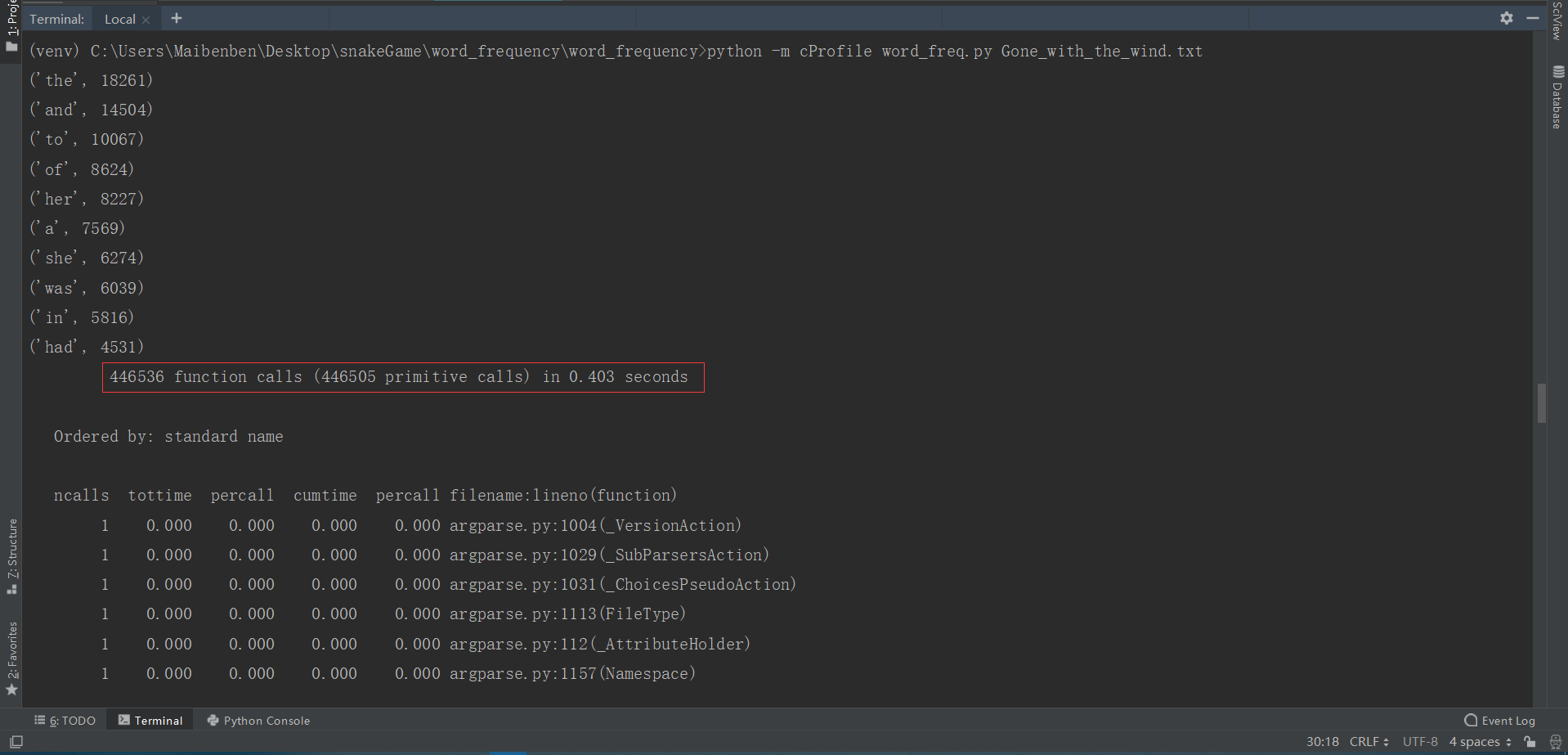

再次进行性能分析,结果如下:

显示446536次函数调用共用了0.403秒,程序的函数调用次数和总运行时间明显减少.

总结反思

**4. 总结反思**

性能分析的意义:找到代码的性能瓶颈,将执行次数多和耗时长的代码优化,使得变换后的代码运行结果与变换前的代码运行结果相同,但执行速度加快或存储开销减少。

引用一段网上找到的话:

二八法则适合很多事物:最重要的只占其中一小部分,约20%,其余80%的尽管是多数,却是次要的。在程序代码中也是一样,决定应用性能的就那20%的代码(甚至更少)。因此优化实践中,我们将精力集中优化那20%最耗时的代码上,这那20%的代码就是程序的性能瓶颈,主要针对这部分代码进行优化。

个性签名:夜空中最亮的星, 请指引我前行!

如果觉得这篇文章对你有帮助的话, 记得在下面点个"推荐"哦~, 博主在此感谢!!!

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利.