Hadoop 配置与运行 wordcount示例,也是个MapReduce示例

前面Hadoop安装分两部份,一是虚机的安装与配置, 二是Hadoop集群安装与配置

这里我们运行下hadoop 自带示例wordcount,当然在做这个示例前提是Hadoop已配置好,且已启动运行

Wordcount(单词计数)是最简单最直观看到MapReduce思想,可以这么认为是MapReduce版”Hello World”

单词计数主要功能是:统计一系列文本文件中每个单词出现的次数,比如 hello world,hello,统计结果就是hello 2,world 1

具体我们看一下如下步骤:

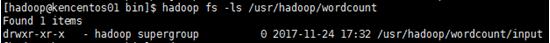

一、创建input目录

[hadoop@kencentos01 bin]$ hdfs dfs -mkdir -p /usr/hadoop/wordcount/input

这里是一次创建多级目录

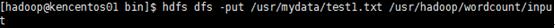

二、上传自定义的文件到input目录

如创建文件 /usr/mydata/test1.txt,里面自行输入一些词组

上传到hadoop目录中

[hadoop@kencentos01 bin]$ hdfs dfs -put /usr/mydata/test1.txt /usr/hadoop/wordcount/input

如果创建多个文件可以用通配符来表示

Hdfs dfs –put /usr/mydata/test*.txt /usr/hadoop/worcount/input

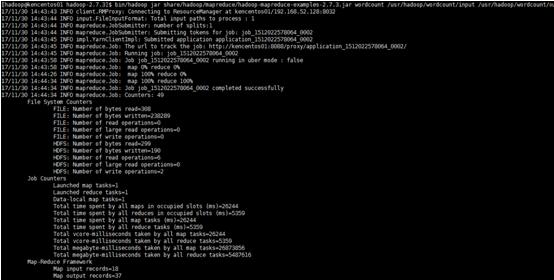

三、运行示例

[hadoop@kencentos01 hadoop-2.7.3]$

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.3.jar wordcount /usr/hadoop/worcount/input /usr/hadoop/worcount/output

注: output文件夹为全新的,之前有的删除

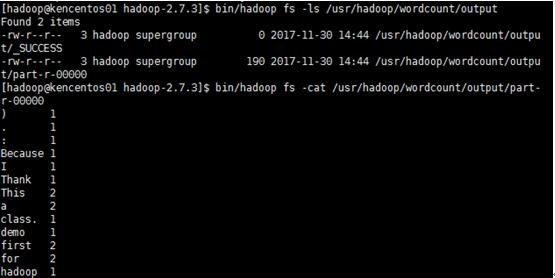

四、查看结果

查看output 目录看结果,查看对应生成文件part-r-0000内容

五、可能遇到的问题

在这期间运行示例时,有可能遇到mapreduce job 一直在运行,不停止的情况

因为正常运行不到1分钟结果就出来了,若出现这种情况一般,说明遇到问题了

可以查看下对应的log, (hadoop安装目录下logs),比如 yarn 相关日志

常见可能的问题原因有:

1、hostname配置有误,即检查hosts文件中配置,注释掉无关的host行

2、检查防火墙,开放所有hadoop用到的端口,若为了简单,可直接关掉防火墙

3、检查节点是否正常运行,如slave机子上datanode

4、hadoop用户权限不够

5、应权限导致默认目录不可用,可自指定 input目录,便于发现问题

6、yarn env中环境变量配置,尤其是java home路径配置

7、yarn -site.xml中配置有误,比如配置内存或虚拟机分配的内存过小