1.整体规模

2台(Namenode HA,Resourcemanager HA,Hmaster HA)

10台(Datanode,nodemanager,journalnode,Regionserver)

1台(hive,sqoop,oozie,hue)

3台(zookeeper)

2.内存以及cpu

cpu:

32-64核

内存:

64-128G

3.具体分配

Namenode:16G以上

Resourcemanager:一般2G,默认1G

Hmaster:2G

----------------------------------------------20G

Datanode:1G

nodemanager:1G

journalnode:1G

Regionserver:一般是16G

----------------------------------------------20G

hive,sqoop,oozie,hue:1G

-----------------------------------------------1G

ZK:1G

要求磁盘读写更快

-----------------------------------------------3G

yarn:

)yarn.nodemanager.resource.memory-mb:8192

默认是8G。

给定的是每个NM节点,任务运行允许分配的内存大小,工作中一般都会改大, 16*1024 或 24*1024

)yarn.nodemanager.resource.cpu-vcores:8

给定的是每个NM节点,任务运行允许分配的CPU大小,必须和memory-mb转换为GB一样的值一样,工作中一般都会改大, 16 或 24

4.网络

万兆

千兆:这时,瓶颈出现在网络上

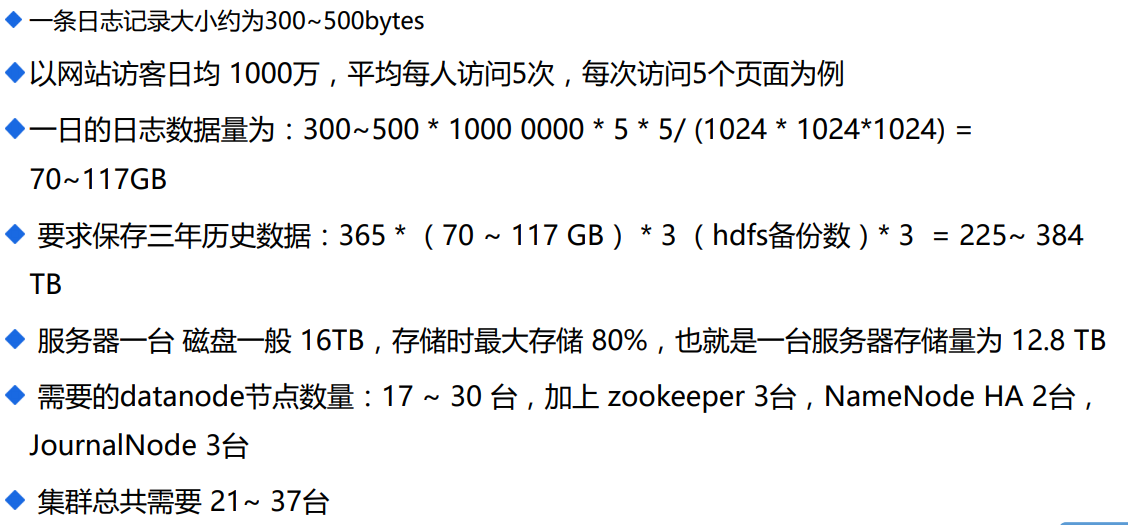

5.数据量

1~3千万的数据量,大约400W

需要磁盘50G。

6.job数据

总数量在40个左右,mr程序30个左右,hive不到10个

7.案例