1 卷积神经网络:输入层

之前提到多层感知机的参数太多,导致训练耗时长并且对图像处理也不具有优势,因此大神们 就提出了多层神经网络,其中最经典的是卷积神经网络(Convolution Neural Network, CNN)。

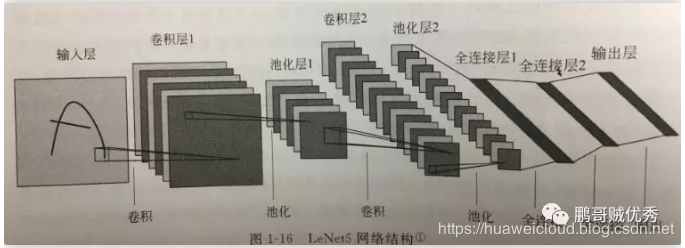

一般 CNN网络分为输入层、卷积层、池化层、全连接层及输出层。以CNN中最经典的LeNet5网络结构来说明。LeNet5的结构为“输入层--卷积层1--池化层1--卷积层2--池化层2--全连接层1--全连接层2--输出层”,如下图所示:

输入层:主要是对输入数据进行求均值处理,使得样本数据的中心尽量调整到坐标系原点,包括将数据输出成特定格式,通过主成分分析PCA进行降维。总的来说,就是把输入数据尽量弄的少点,但又能代替原数据。

2 卷积神经网络:卷积层

卷积层:通常采用二维卷积计算对图像进行卷积,从而提取输入数据的关键特征,达到增强特征信息,过滤无用信息的目标,并为下一层输出特征图。

1、首先,先讲下关于卷积层的2个概念,一个是卷积核(又叫过滤器),一个是感受野。

卷积核:通过卷积核是 三维矩阵,由宽度、高度、深度三个参数组成。主要用于卷积过程中的加权求和

不同的卷积核效果也不一样 ,有些对颜色信息敏感,有些对图形形状敏感,因此一个CNN网络通常有多个卷积核。

感受野:卷积核作用的卷积窗口对应于原输入特征图的部分

上图为感受野示意图

按我当前的理解,卷积层输出的特征图就是感受野经过卷积核处理后输出的结果。

最后,经过卷积核处理后的输出,还需要通过激活函数处理,类似上次提到的阶跃函数。但是阶跃函数是线性的,而神经元本身也是线性的,因此一般常用的激活函数是sigmoid函数、tanh函数等非线性函数,从而增强神经网络的非线性拟合能力。

2、接着,讲讲卷积层的特性。

(1)局部连接

多层感知机用的是全连接模式,CNN采用的是局部连接模式。怎么理解?就是说在多层感知机里,多一个神经元需要处理同一块感受野;CNN中,一块感受野可能只由一个神经元处理。如下图右边所示。

(2)权重共享

由于每个神经元都有对应的权重数据,导致网络参数太多,无法快速调优网络;因此CNN采用的是权重共享,即所有神经元使用同一份权重数据。如下图右边所示。

3、再讲下卷积层计算方法

一种是直接卷积,就是对特征图进行边缘填充0,进行与权重矩阵相同维数的矩阵进行矩阵乘法。以示例图为例,将特征图外围扩展了一圈0,然后以每次左移的步长为2的频率进行与权重数据矩阵相乘。

▲此为直接卷积

第二种是矩阵乘法实现卷积。通过Img2Col函数将特征图和权重矩阵都展开成可实现相乘的维度,如下图

▲此为矩阵乘法卷积

针对卷积层的计算加速,又有5层层次的并行性,我不太感兴趣,就不去了解了。

书中提到,昇腾AI处理器采用的是矩阵乘法卷积的方式。而卷积层的参数量和计算量一般是神经网络中的重头,因此卷积层的合理设计可以算是一个产品的核心算法。

3 卷积神经网络:池化层

池化层:为了防止过拟合,通过在相邻卷积层之间进入池化处理,减少每一层特征值数目,保留主特征。

一般 池化处理是对不同位置区域提取具有代表性的特征值,如最大值、平均值,对应的池化函数即为最大池化和平均池化。池化层综合了输入特征图周围全部特征信息的反馈和影响,又减少了输出数据量,从而提升了神经网络的计算效率。

(这块技术,好像不是什么核心算法,因为作者也只是简单地带过。)

4 全连接层输出

全连接层相当于一个多层感知机,对不同输入特征进行分类。

5 总结

看了第一章,只能说大致了解了神经网络的概貌,对其中很多的数学公式推导、一些优化处理并没有深入了解。感觉自己看了也会一知半解,容易遗忘,就不去仔细阅读了。

好啦,下次就进入《昇腾AI处理器》的第二单--行业背景,如芯片加速理论、深度学习框架等。

作者:华为云合作开发者 鹏哥贼优秀

HDC.Cloud 华为开发者大会2020 即将于2020年2月11日-12日在深圳举办,是一线开发者学习实践鲲鹏通用计算、昇腾AI计算、数据库、区块链、云原生、5G等ICT开放能力的最佳舞台。

欢迎报名参会(https://www.huaweicloud.com/HDC.Cloud.html?utm_source=&utm_medium=&utm_campaign=&utm_content=techcommunity)