一、简介

VGGNet是计算机视觉组(Visual Geometry Group)和Google DeepMind公司的研究员一起研究的深度卷积神经网络。VGGNet探索了卷积神经网络深度与性能之间的关系,通过反复堆叠3*3的小型卷积核和2*2的最大池化层,VGGNet成功地构筑了16~19层(这里指的是卷积层和全连接层)深度卷积神经网络。到目前为止,VGGNet主要用来进行提取图像特征。

二、特点

以常用的VGG16为例,VGGNet的特点是:

- 整个网络有5段卷积,每一段内有2~3个卷积层,且每一层的卷积核的数量一样。各段中每一层的卷积核数量依次为:64,128,256,512,512。记住有两层512

- 都使用了同样大小的卷积核尺寸(3*3)和最大池化尺寸(2*2),卷积过程使用"SAME"模式,所以不改变feature map的分辨率。网络通过2*2的池化核以及stride=2的步长,每一次可以分辨率降低到原来的1/4,即长宽变为原来的1/2。

- 网络的参数量主要消耗在全连接层上,不过训练比较耗时的依然是卷积层。

三、结构

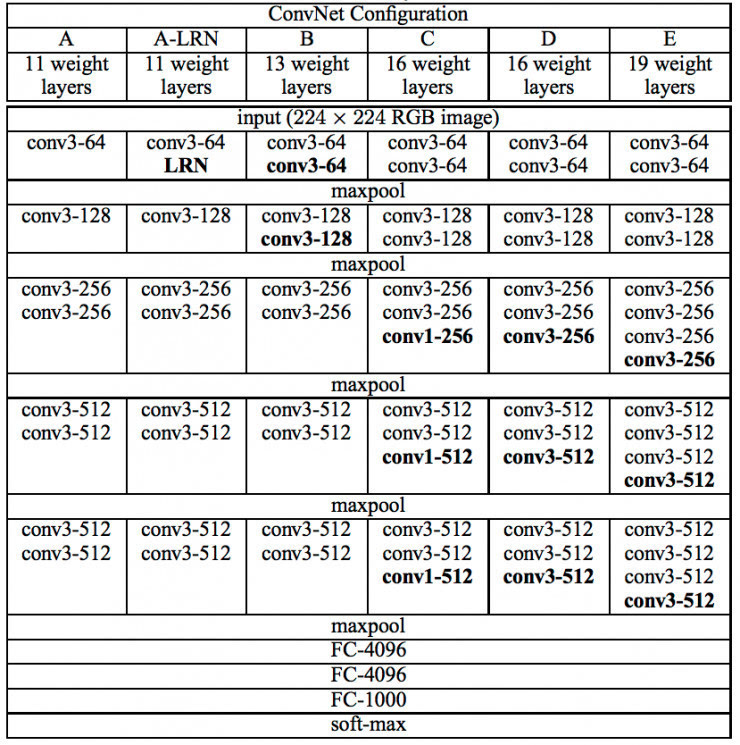

以下是VGGNet各级别的网络结构,总体上分为五段,各段中每一层的卷积核数量依次为:64,128,256,512,512,不一样的就是每一段中卷积层的数量。还有特别地地方就是A-LRN和C的第3,4,5层,不解释自己看图。

以下是VGGNet各级别网络参数量

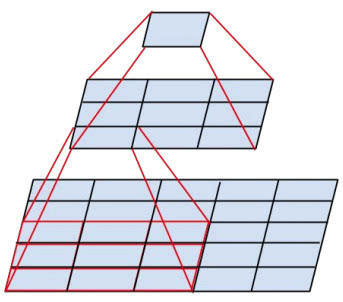

以下有一个特点就是:两个3´3的卷积层串联相当于1个5´5的卷积层,即一个像素会跟周围5´5的像素产生关联,可以说感受野大小为5´5。而3个3´3的卷积层串联的效果则相当于1个7´7的卷积层。除此之外,3个串联的3´3的卷积层,拥有比1个7´7的卷积层更少的参数量,只有后者的。最重要的是,3个3´3的卷积层拥有比1个7´7的卷积层更多的非线性变换(前者可以使用三次ReLU激活函数,而后者只有一次),使得CNN对特征的学习能力更强。如下图

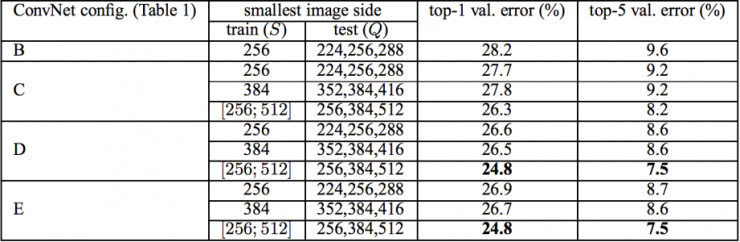

VGGNet在训练时有一个小技巧:先训练级别A的简单网络,再复用A网络的权重来初始化后面的几个复杂模型,这样训练收敛的速度更快。在预测时,VGG采用Multi-Scale的方法,将图像scale到一个尺寸Q,并将图片输入卷积网络计算。然后在最后一个卷积层使用滑窗的方式进行分类预测,将不同窗口的分类结果平均,再将不同尺寸Q的结果平均得到最后结果,这样可提高图片数据的利用率并提升预测准确率。同时在训练中,VGGNet还使用了Multi-Scale的方法做数据增强,将原始图像缩放到不同尺寸S,然后再随机裁切224´224的图片,这样能增加很多数据量,对于防止模型过拟合有很不错的效果。实践中,作者令S在[256,512]这个区间内取值,使用Multi-Scale获得多个版本的数据,并将多个版本的数据合在一起进行训练。图9所示为VGGNet使用Multi-Scale训练时得到的结果,可以看到D和E都可以达到7.5%的错误率。最终提交到ILSVRC 2014的版本是仅使用Single-Scale的6个不同等级的网络与Multi-Scale的D网络的融合,达到了7.3%的错误率。不过比赛结束后作者发现只融合Multi-Scale的D和E可以达到更好的效果,错误率达到7.0%,再使用其他优化策略最终错误率可达到6.8%左右,非常接近同年的冠军Google Inceptin Net。同时,作者在对比各级网络时总结出了以下几个观点。

(1)LRN层作用不大。

(2)越深的网络效果越好。

(3)1´1的卷积也是很有效的,但是没有3´3的卷积好,大一些的卷积核可以学习更大的空间特征。

四、参考

《Tensorlow实战》