降维(Dimensionality Reduction)

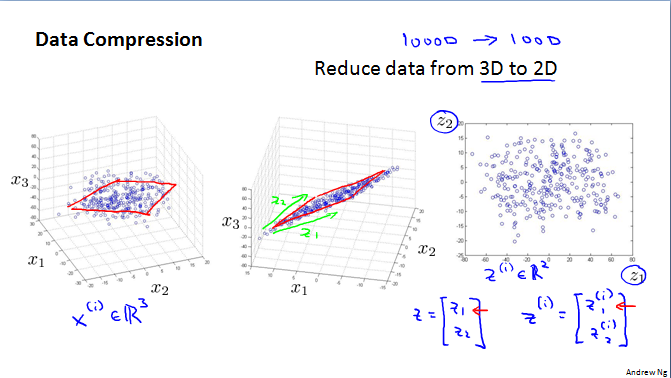

目标一:数据压缩(Motivation I:Data Compresstion)

降维——另一种无监督学习的方法。如,数据从三维降到二维(3D-2D)、从二维降到一维(2D-1D)。

数据压缩的目的:减少内存空间的占用;加快算法运行速度。

目标二:数据可视化(Motivation II:Data Visualization)

通过把数据从50维、100维甚至更高维度,降低到二维、三维等来进行数据可视化分析,从而更好地分析数据。

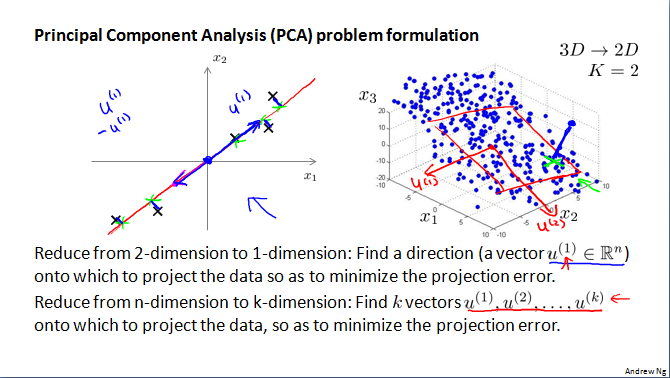

主成分分析问题规划(Principal Component Analysis probrem formulation)

对于降维问题,目前最流行的方法是一个叫主成分分析方法(PCA)的算法。

主成分分析方法:在PCA之前,一般需要对数据进行均值归一化、特征规范化。PCA方法,找到一个低维平面,对数据进行投影(90度投影或正交投影),以及最小化每个点与投影对应点之间的距离的平方值。

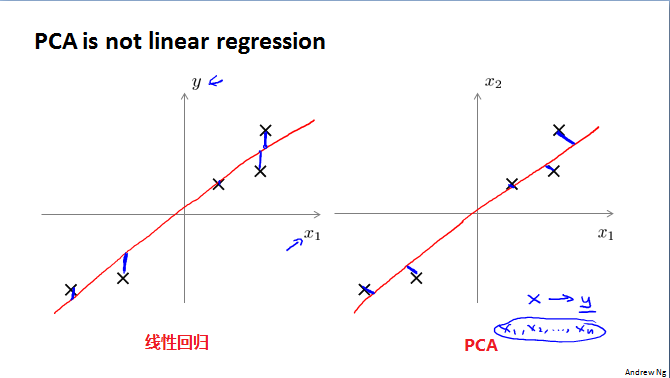

注意:PCA方法不是线性回归。

PCA方法:点与投影点之间的垂直距离

线性回归:点与直线的竖直距离(沿Y轴方向)

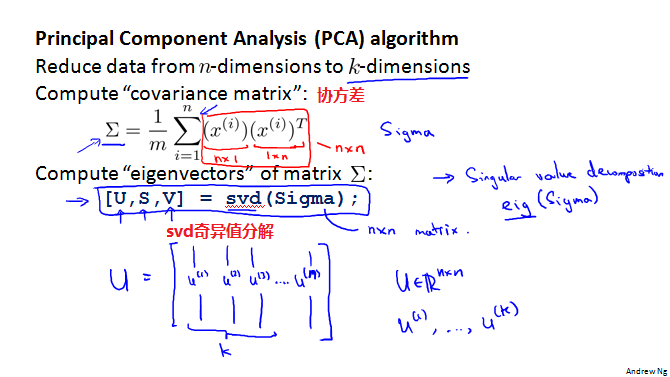

主成分分析算法(Principal Component Analysis algorithm)

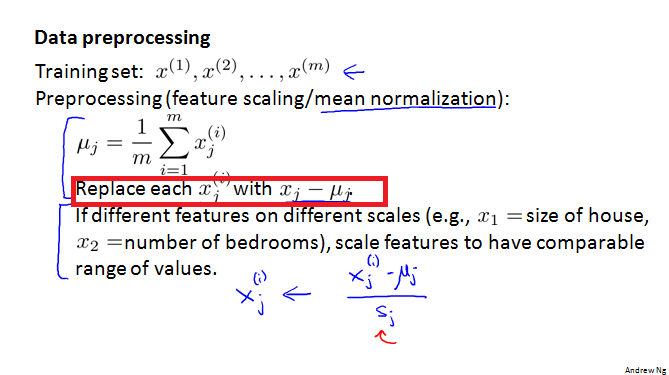

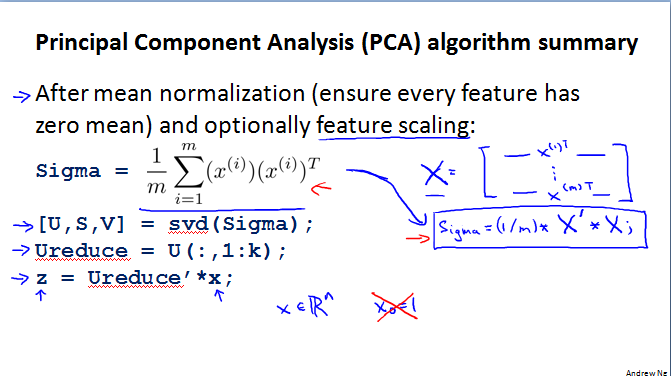

数据预处理——特征缩放/均值归一化

均值归一化:使得替换后的数据均值为0

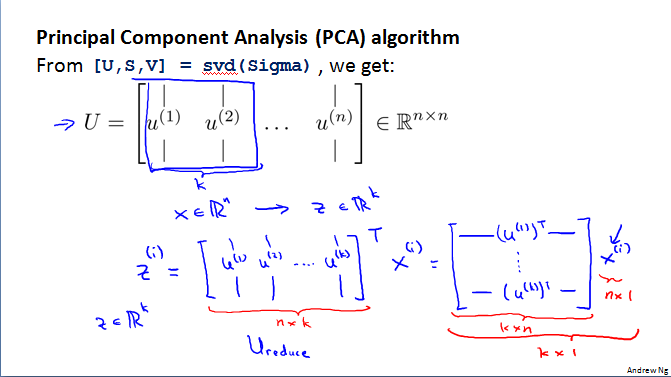

PCA算法

PCA算法——获取U中前k列

PCA算法总结

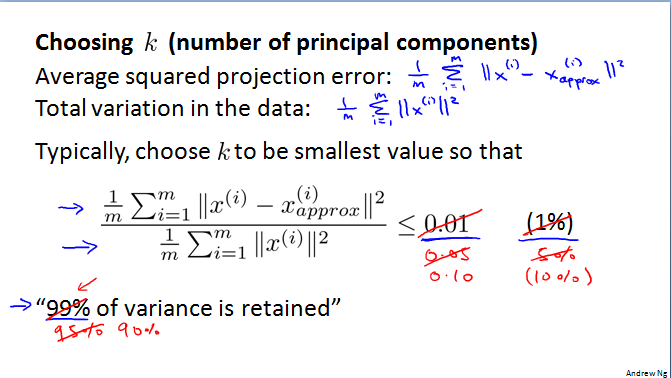

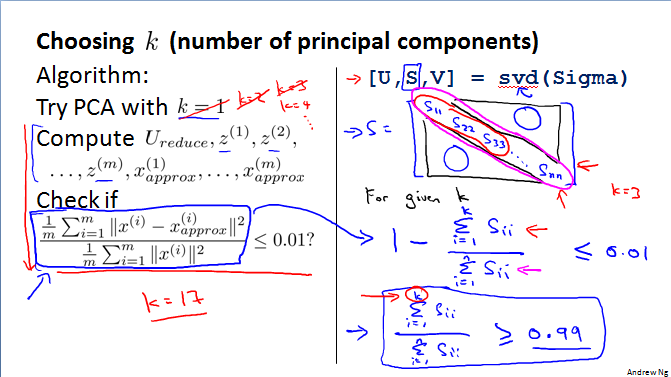

主成分参数的选择(Choosing the number of principal component)

计算预测误差平方和的均值

数据集的总变动

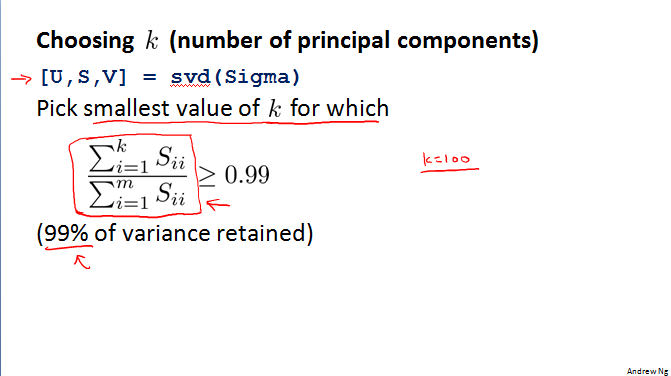

选择最小的k值以满足方差要求

另一种方法计算K值

以上总结

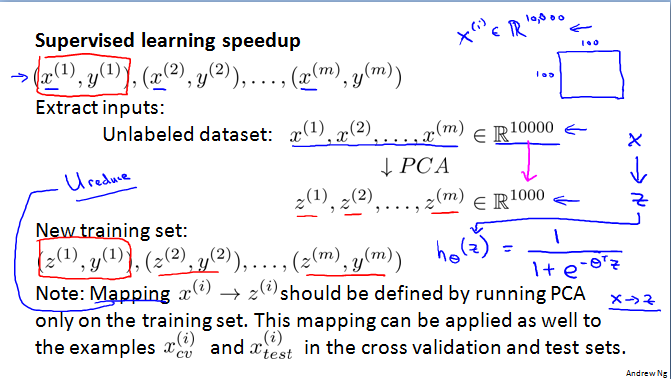

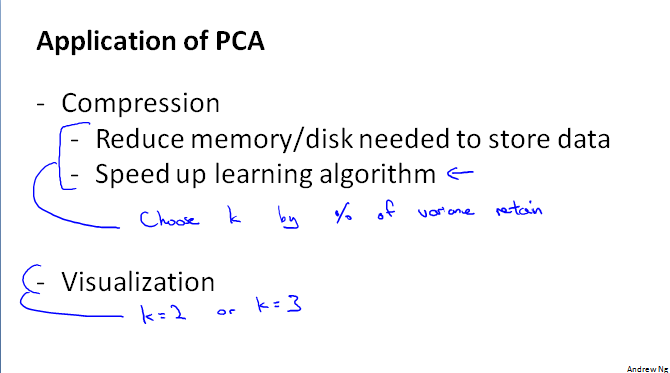

应用PCA的建议(Advice for applying PCA)

在监督学习中,用来提高速度。注意,数据只能在training set 时进行Mapping,但是可以用在交叉验证集和测试集上。

应用PCA来压缩数据或者可视化——提高算法效率以及降低硬盘内存的消耗

注意:不用尝试使用PCA来降低过拟合!降低过拟合应该使用正则化!

不要解决一个算法问题时,一上来就把PCA列在计划的首选中。而是,一开始就不应该考虑PCA,只有在需要提高算法运行速度或者减低内存时才应该考虑