1. linear regression algorithm 线性回归算法

2.cost function 代价函数

3. gradient descent algorithm 梯度下降法("Batch")

4. 奇异矩阵:没有逆矩阵的矩阵叫奇异矩阵(退化矩阵)

回归问题(Regression Problem)

2.1 符号表示(Notation)

- m 表示训练集的样本总数

- x(i)x(i)表示第i个输入/变量

- y(i)y(i)表示第i个输出/目标值

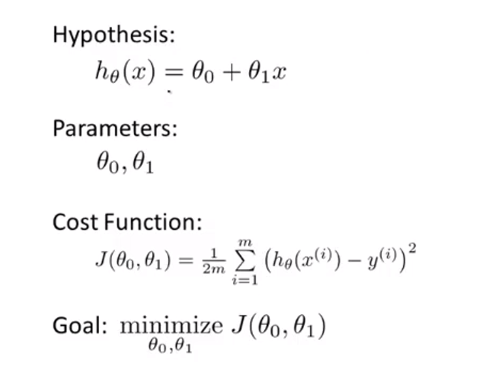

- hypothesis 假设,也就是我们的预测,预测函数hθ(x)hθ(x)

2.1单变量线性回归的代价函数(Cost Function)

单变量线性回归问题应该是最简单的一种模型,但是一步一步来,有助于更好地理解和掌握后面更复杂的回归模型以及分类模型。单变量线性回归的假设函数是,直观来看,这就是一个直线方程,解决的问题就是:训练集是平面上的一个点,然后利用预测函数表示的直线来拟合这些点,并且进行利用预测函数进行预测。那么问题就来了,如何得到这条直线呢,也就是说要如何确定参数θ0和θ1呢?所以就需要代价函数,在机器学习中,对于代价函数的理解可以使这样的:

代价函数就是我们对于学习算法的惩罚,代价函数越大,惩罚越严厉;代价函数越小,惩罚越小。我们要做的就是让代价函数越小越好,那么就需要最小化(Minimize)代价函数。

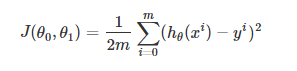

在单变量线性回归问题中,代价函数应该如何定义呢?我们知道,对于测试集(x,y),我们的预测是hθ(x)而实际的值是y,那么预测值与实际值之间的差异是|hθ(x)−y|,也就是可以利用(hθ(x)−y)2来表示,对于一共m个训练数据而言,代价函数应该是:

其中,自变量是θ0和θ1,也就是说通过选取合适的参数值来让代价函数取得最小值,拟合数据并作出合理预测。若是另θ=0,那么代价函数就是关于θ1的一元二次方程,求最小值问题也就变得很简单了,这对我们理解梯度下降法也是有帮助的。

求 min 最小化代价函数是解决回归问题的常用方法。

最小化代价函数是解决回归问题的常用方法。

总结: