采集数据到kafka,然后再通过flume将数据保存到hdfs上面。在这个过程当中出现了一堆的问题。

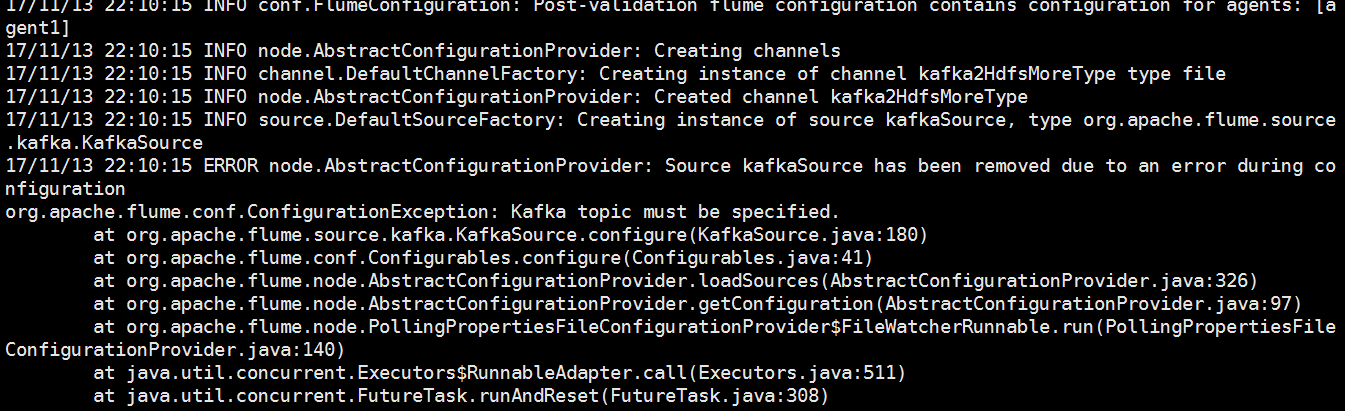

(1)一直是提醒说必须指定topic,然后发现我kafka用的是0.9.0.1,然而我的flume用的是1.6.然后将flume的版本调为1.7之后问题解决了。

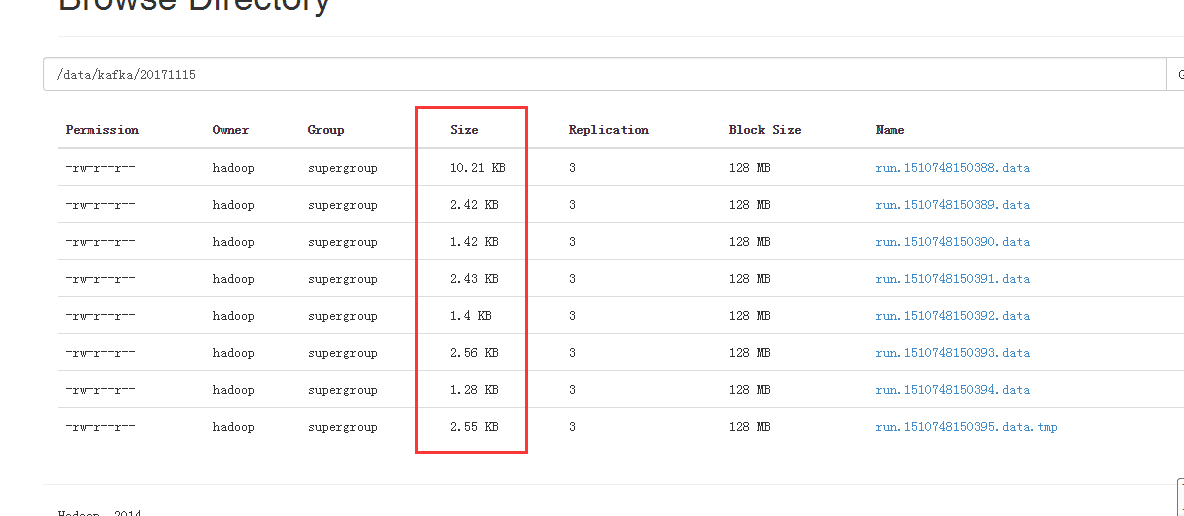

(2)flume能够正常启动。然而这个时候采集的文件是一堆小文件。

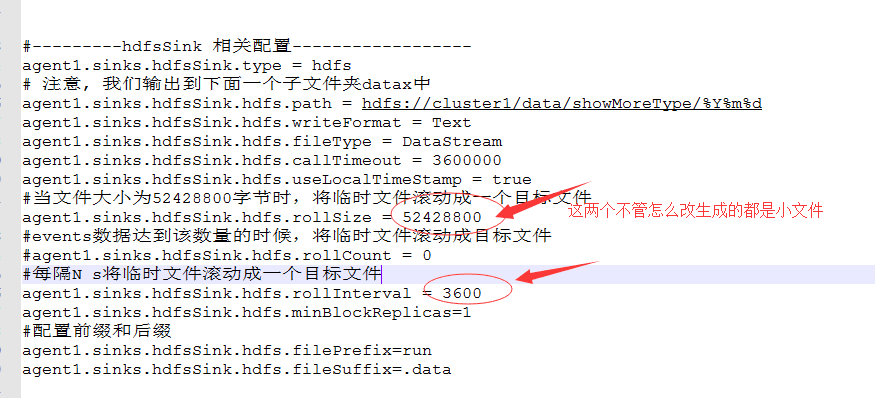

然后查看配置文件,修改配置文件。

依然是生成了一堆小文件。最终的解决方法是:

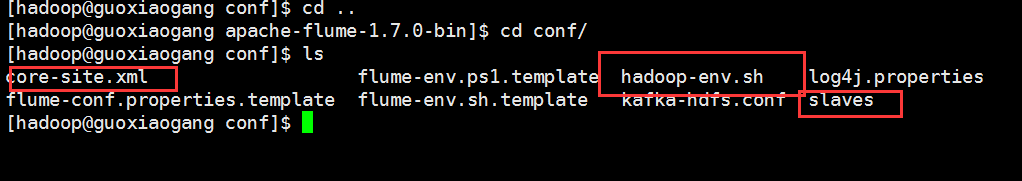

将Hadoop配置文件里面的相关文件加入到flume的conf目录下。使这个配置文件能够生效。识别这个当中的相关的配置文件。