作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363

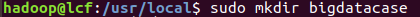

准备上传的文件夹,新建文件夹bigdatacase

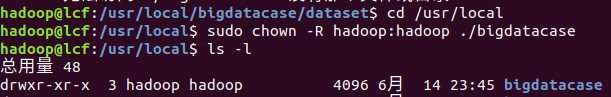

获取bigdatacase文件夹的权限 并再里面新建dataset文件夹

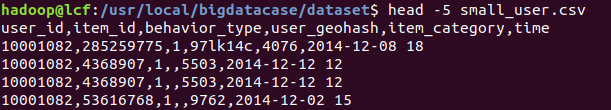

查看我爬取数据的前5条数据

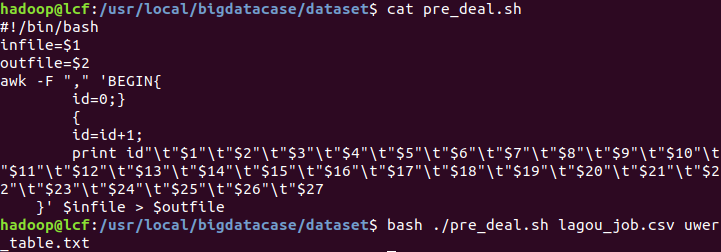

#!/bin/bash infile=$1 outfile=$2 awk -F "," 'BEGIN{ id=0;} {id=id+1; print id" "$1" "$2" "$3" "$4 "$5 "$6 "$7 "$8 "$9 "$10 "$11 "$12 "$13 "$14 "$15 "$16 "$17 "$18 "$19 "$20 "$21 "$22 "$23 "$24 "$25 "$26 "$27 }' $infile > $outfile

这是pre_deal.sh配置文件,因为我获取了27列的数据,所以打了那么多。

预处理成功,生成了user_table.txt文件

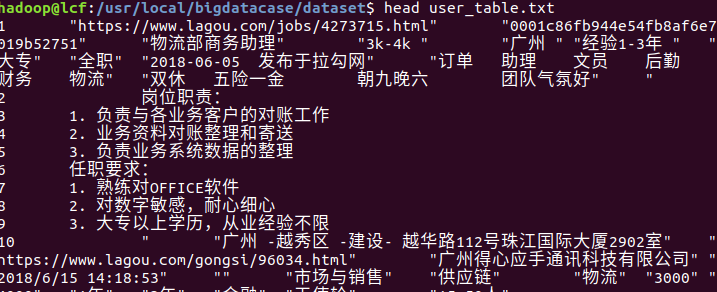

查看user_table.txt前面的数据

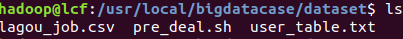

查看bigdatacase文件

HDFS上传文件夹/bigdatacase/dataset

查看HDFS上传的user_table.txt文件的前10条数据

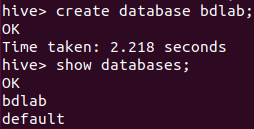

创建数据库bdlab

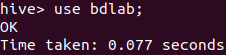

使用数据库bdlab

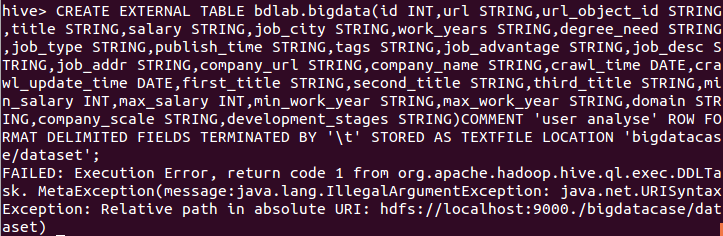

无法创建数据库表 不知道是什么原因,百度了很多遍,按照百度上的各种解决方法都解决不了。

总结:前面都很顺利,UTF-8也设置好了,但是在hive中无法创建数据库表,不知道什么原因,重新安装HIVE和MYSQL都无法成功,HIVE和MYSQL的安装配置都是正常的。