什么是爬虫

- 我们首先需要知道什么是爬虫。爬虫,即网络爬虫,大家可以理解为在网络上爬行的一只蜘蛛,互联网就比作一张大网,而爬虫便是在这张网上爬来爬去的蜘蛛,如果它遇到自己的猎物(所需要的资源),那么它就会将其抓取下来。比如它在抓取一个网页,在这个网中他发现了一条道路,其实就是指向网页的超链接,那么它就可以爬到另一张网上来获取数据。

- 因为python的脚本特性,python易于配置,对字符的处理也非常灵活,加上python有丰富的网络抓取模块,所以两者经常联系在一起。Python爬虫开发工程师,从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止。如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来。

- 爬虫可以抓取某个网站或者某个应用的内容,提取有用的价值。也可以模拟用户在浏览器或者App应用上的操作,实现自动化的程序。

哪些语言可以实现爬虫

-

php:可以实现爬虫。php被号称是全世界最优美的语言(,但是php在实现爬虫中支持多线程和多进程方面做的不好。

-

java:可以实现爬虫。java可以非常好的处理和实现爬虫,但是java实现爬虫代码较为臃肿,重构成本较大。

-

c、c++:可以实现爬虫。但是使用这种方式实现爬虫纯粹(大佬们)能力的体现,却不是明智和合理的选择。

-

python:可以实现爬虫。python实现和处理爬虫语法简单,代码优美,支持的模块繁多,学习成本低,具有非常强大的框架(scrapy等)。

爬虫的分类

- 通用爬虫:通用爬虫是搜索引擎(Baidu、Google、火狐等)“抓取系统”的重要组成部分。主要目的是将互联网上的网页下载到本地,形成一个互联网内容的镜像备份。 简单来讲就是尽可能的;把互联网上的所有的网页下载下来,放到本地服务器里形成备分,在对这些网页做相关处理(提取关键字、去掉广告),最后提供一个用户检索接口。

搜索引擎如何抓取互联网上的网站数据?

门户网站主动向搜索引擎公司提供其网站的url

搜索引擎公司与DNS服务商合作,获取网站的url

门户网站主动挂靠在一些知名网站的友情链接中 - 聚焦爬虫:聚焦爬虫是根据指定的需求抓取网络上指定的数据。例如:获取豆瓣上电影的名称和影评,而不是获取整张页面中所有的数据值。

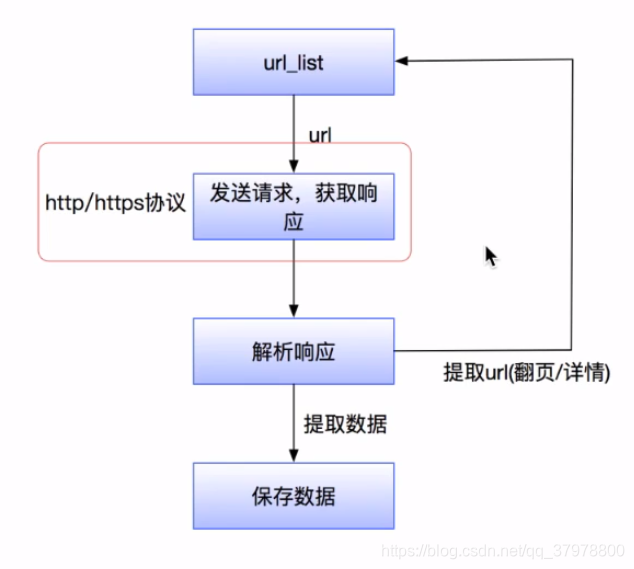

爬虫的流程

- 指定url

- 基于请求模块 如requests 模块发起请求

- 获取响应对象中的数据值

- 持久化存储

http与https的概念和区别

-

HTTP:是互联网上应用最为广泛的一种网络协议,是一个客户端和服务器端请求和应答的标准(TCP),用于从WWW服务器传输超文本到本地浏览器的传输协议,它可以使浏览器更加高效,使网络传输减少。

-

HTTPS:是以安全为目标的HTTP通道,简单讲是HTTP的安全版,即HTTP下加入SSL层,HTTPS的安全基础是SSL,因此加密的详细内容就需要SSL。

-

HTTPS和HTTP的区别主要如下:

- 1、https协议需要到ca申请证书,一般免费证书较少,因而需要一定费用。

- 2、http是超文本传输协议,信息是明文传输,https则是具有安全性的ssl加密传输协议。

- 3、http和https使用的是完全不同的连接方式,用的端口也不一样,前者是80,后者是443。

- 4、http的连接很简单,是无状态的;HTTPS协议是由SSL+HTTP协议构建的可进行加密传输、身份认证的网络协议,比http协议安全。

robots.txt协议

- 如果自己的门户网站中的指定页面中的数据不想让爬虫程序爬取到的话,那么则可以通过编写一个robots.txt的协议文件来约束爬虫程序的数据爬取。robots协议的编写格式可以观察淘宝网的robots(访问www.taobao.com/robots.txt即可)。但是需要注意的是,该协议只是相当于口头的协议,并没有使用相关技术进行强制管制,所以该协议是防君子不防小人。但是我们在学习爬虫阶段编写的爬虫程序可以先忽略robots协议。

反爬虫 - 门户网站通过相应的策略和技术手段,防止爬虫程序进行网站数据的爬取。

反反爬虫 - 爬虫程序通过相应的策略和技术手段,破解门户网站的反爬虫手段,从而爬取到相应的数据。