转载 https://blog.csdn.net/BigData_Mining/article/details/81279612

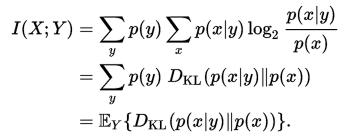

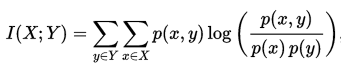

两个离散随机变量 X 和 Y 的互信息可以定义为:

其中 p(x,y) 是 X 和 Y 的联合概率分布函数,而p(x)和p(y)分别是 X 和 Y 的边缘概率分布函数。

(1)对称性

I(X;Y)= I(Y;X)

由Y提取到的关于X的信息量与从X中提取到的关于Y的信息量是一样的。 I(X;Y)和 I(Y;X)只是观察者的立足点不同

(2)非负性

I(X;Y)≥0

平均互信息量不是从两个具体消息出发, 而是从随机变量X和Y的整体角度出发, 并在平均意义上观察问题, 所以平均互信息量不会出现负值。或者说从一个事件提取关于另一个事件的信息, 最坏的情况是0, 不会由于知道了一个事件,反而使另一个事件的不确定度增加

(3)极值性

I(X;Y)≤H(X)

I(Y;X)≤H(Y)