1.接触过几种爬虫模块

urllib,requests

2.robots协议是什么?

requests模块没有使用硬性的语法对该协议进行生效

scrapy硬性的语法对该协议进行了生效

3、如何处理验证码:

云打码平台 打码兔

4、掌握几种数据解析的方式

正则,xpath,bs4

5、如何爬取动态加载的页面数据

1.selenium

2.ajax,抓包工具,抓取异步发情的请求(url)

6.接触过那些反爬机制?如何处理?

robots协议=false、UA、封ip、验证码、动态数据爬取、数据加密、token---随机字符串

7.在scrapy中接触过几种爬中的类

提问:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法?

方法一:基于Scrapy框架中的Spider的递归爬取进行实现(Request模块递归回调parse方法)。

方法二:基于CrawlSpider的自动爬取进行实现(更加简洁和高效)。

3.4 CrawlSpider整体爬取流程:

a)爬虫文件首先根据起始url,获取该url的网页内容

b)链接提取器会根据指定提取规则将步骤a中网页内容中的链接进行提取

c)规则解析器会根据指定解析规则将链接提取器中提取到的链接中的网页内容根据指定的规则进行解析

d)将解析数据封装到item中,然后提交给管道进行持久化存储

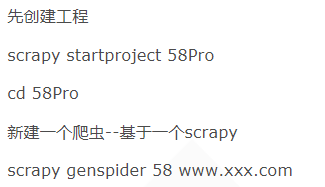

基于spider创建爬虫文件:

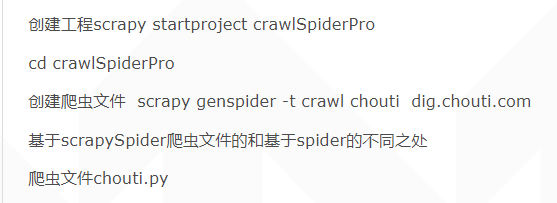

基于crwalSpider类的爬虫文件

Spider(父类),CrwalSpider,RedisCrawlSpider , RedisSpider

8.如何实现分布式流程:scrapy-redis

再上面两种基础上建立然后进行修改

RedisCrawlSpider , RedisSpider

-------------------------------------------------------------------------------------------------------------------------